Berta Sándor

Szabályozatlan az algoritmusok világa

Az algoritmusok szinte minden területen jelen vannak, meghatározzák az életünket, de kérdéses, hogy mennyire dolgoznak objektív módon. A döntéshozók szabályoznák a területet.

Egy a XX. század elején született ember valószínűleg egész életében sohasem látott algoritmusokat, pedig bármilyen foglalkozása volt is, szinte mindennap használt valamilyen formális szabályt. A betonkeveréstől kezdve a marhabőrrel dolgozó cipészig mindenki előre meghatározott eljárásokkal végzi a dolgát, tudása és korábbi tapasztalatai határozzák meg tevékenységét. Ma pedig már algoritmusok befolyásolják az áram- és a vízellátást, az erőművek, a közlekedési lámpák, de még a zuhanyzóban elhelyezett termosztátok működését is. Az egyszerű mechanikus és elektronikus eszközöket szinte minden fontosabb területen programozott intelligenciával rendelkező megoldások váltották fel.

Míg nagyapánk autója tisztán mechanikus volt, addig a mai járművek már digitális rendszerekkel működnek, több mint 100 vezérlőeszközük és szenzoruk van. A mérnökök tudását és a tesztutak eredményeit programozók szabályokká és parancssorokká konvertálják, a számítógépek az érzékelők adatait pillanatok alatt elemzik és vezérlőjelekké alakítják. De az algoritmusok nem pusztán kiszolgáló rendszerek és háttérmegoldások, hanem befolyásolják a döntéseinket, a világnézetünket, az általunk fogyasztott tartalmakat, a Google keresési eredményeit, a Spotify zeneajánlásait, a banki hitelek odaítélését vagy a kérvények elutasítását.

Nagy-Britanniában és az Amerikai Egyesült Államokban az állásokra jelentkező személyek 70 százalékát először ismeretlen feltételek alapján, automatikusan pontozzák, és csak ezután jönnek a munkaügyi asszisztensek. A Facebook minden egyes felhasználó esetében 7000 különböző viselkedési mintát rögzít és ezekből alakít ki egy profilt. Historikus adatokon alapuló pénzügyi kockázati modellek próbálják előre jelezni a piaci katasztrófákat, és minden biztosító alkalmaz valamilyen pontozási módszert az ügyfelek osztályokba sorolására.

Az amerikai tőzsdéken a bevétel 70 százalékát gépek generálják, Európában ugyanez az arány 50 százalék. A sebesség itt létfontosságú, azok a rendszerek termelik a legtöbb nyereséget, amelyek az információkat a leggyorsabban dolgozzák fel és ültetik át megbízásokká. Az algoritmusok nem csupán gyorsabban, hatékonyabban és olcsóbban dolgoznak az embereknél, de okosabbak is náluk, például az adatok összehasonlításakor és a különböző minták felismerésekor. Számos hatóság használ elemzőszoftvereket a bűncselekmények előrejelzésére és több amerikai szövetségi államban alkalmaznak a bíróságok olyan programot, amellyel kiszámítható a bűnözők visszaesésének a valószínűsége.

De vajon mennyire objektív és semleges egy algoritmus? Ez még sokszor a készítők számára sem nyilvánvaló, és semelyik országban semmilyen kormányzati kontroll nincs felette, még a nagy melléfogások után sem szabályozták sehol ezt a területet. Különösen ott lehet érdekes a kérdés, ahol monopóliumszerű struktúrák vannak, mint például a Facebook és a Google világa. Sokféleképpen, több szinten lehet rossz egy algoritmus: például egy harvardi professzor, Latanya Sweeney azt találta, hogy egy többségében a színesbőrűek által használt névre keresve bűnözéssel kapcsolatos hirdetések jelentek meg a találati lista mellett. Szinte biztosan nem a Google mérnöke volt rasszista, hanem valószínűleg a korábbi keresések alapján tréningezték így a gépet. Hasonló eset a képek hibás felcímkézése, például az afroamerikaiak gorillaként való jelölése - kiadás előtt túl rövid volt a tesztidőszak.

Ott van még a piszkos algoritmusok esete: a legális, de erkölcsileg kifogásolható módszerek. Ilyen például amikor a Facebook az ausztrál reklámozók számára önbizalomhiányos tinédzsereket célzott be vagy amikor az Uber fizetési algoritmusa leszorította a béreket, egyben szélesítve a nők és férfiak közötti szakadékot. Jó példa a cég az illegális algoritmusra is, ilyen volt amikor megtippelték ki az ellenőr, és azok egyszerűen hamis Uber-autókat láttak az appjukban, de nem hiányozhat a felsorolásból a Volkswagen sem, akik a károsanyag-kibocsátási mérést csapták be a motorvezérlés módosításával, ha az autó tesztet érzékelt.

Az amerikaiaknál Google-Knowing annak a jelenségnek a neve, amelynél az úgynevezett féltudás a meghatározó. Mindez arra utal, hogy az emberek az információkat már nem vizsgálják meg, hanem a keresési eredményeket automatikusan helyesnek fogadják el. A mechanizmus mindig ugyanaz: az információkat kinyerő eszközök - például egy webes keresés - algoritmikus szabályokra épül. De utána jönnek bizonyos ismeretlen feltételek, amelyek alapján bizonyos oldalakat és tartalmakat előrébb sorolnak például annak alapján, hogy korábban mire kattintottak gyakran az emberek. Tehát nem a minőség számít, ráadásul az első hellyel ráerősítenek egy korábbi döntés-sorozatra. Az algoritmusok akár az igazságot is helyettesíthetik, egyes dolgokat kihagyhatnak a rendszerek.

Jelenleg semmilyen szervezet nem képes és szándékozik a veszélyes és illegális algoritmusok felderítésére. Minden országban van néhány hatóság, amely csak a saját ágazatát vagy területét felügyeli, például a Google Shopping esetével az EU legfelsőbb szinten foglalkozik, de eközben számtalan iparágban akár éveken át folyhatnak kétes tevékenységek. A felderítés nehézkes, mindenhol az üzleti titok vastag fala övezi a kérdést. Egy az ügyfeleket pontozó cég rendszerénél az emberek sokszor még saját maguk értékelését sem ismerhetik meg, így ha az méltánytalan is, panaszt sem tudnak tenni ellene.

De sokszor még a rossz vagy embereket veszélyeztető dolgok ellen sem lehet fellépni, mert nem mérhető dologról van szó. Például hiába ömlik a médiából, hogy az álhírek veszélyeztetik a demokráciát, hogyan lehet azok hatását megbecsülni? A tavaly ősszel lezajlott amerikai választási kampány fő témája a információk hitelessége volt, százezernyi bot befolyásolta a közösségi hálózatokban az emberek véleményét. A Twitter forgalmának ötödét automaták generálták, és a közvéleményre gyakorolt hatásuk tagadhatatlan. De a Google és a Facebook szerint csupán elég adatot és tényt kell eltárolni és az igazság birtokába jutunk, az alapító Mark Zuckerberg szerint pedig platformja teljesen semleges és objektív világnézetű.

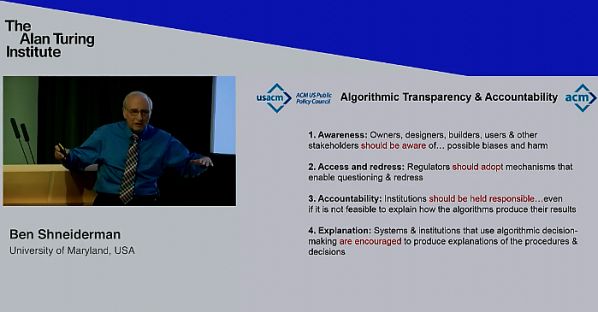

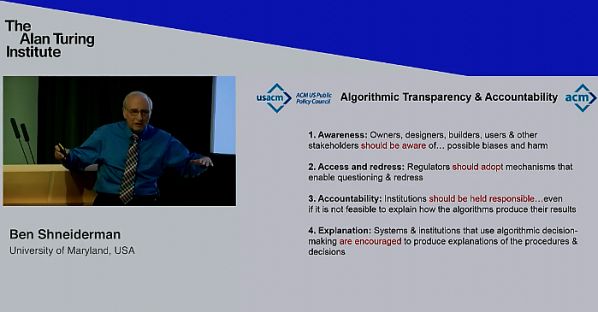

Tavaly októberben Angela Merkel német kancellár panaszkodott arról, hogy mindenki csak azokat a megosztásokat látja, amelyekkel egyetért. A politikus már akkor azt sürgette, hogy az algoritmusoknak átláthatóknak kell lenniük, hogy a polgárok tájékozódhassanak arról, hogy mi történik a médiaszokásaikkal kapcsolatos adatokkal. Heiko Maas német igazságügyi miniszter pedig július elején jelezte, hogy szabályozná az internetes óriáscégek működését, a tervek alapján egy külön hivatal ellenőrizné a használt algoritmusokat. Hasonlót vetett fel a Maryland Egyetem professzora, Ben Shneiderman, aki szerint az amerikai Nemzeti Szállítmányozás Biztonsági Tanács mintájára egy Algoritmus Biztonsági Tanácsot kellene létrehozni, és ugyanúgy, ahogy az előbbi minden földi és légibalesetet kivizsgál, ez hasonlóképp megállapítaná a felelősséget az algoritmusok okozta károkért.

De ez korántsem lesz olyan egyszerű, mint egy autópályán történt tömegkatasztrófánál, mert a problémák többsége az egyéneket érinti, és azok szinte láthatatlanok és felderíthetetlenek. Az IT-óriások külső szakértőket nem engednek be laboratóriumaikba, azaz mintha a Volkswagen nem engedné, hogy leteszteljék autói működését. Ez a tudás nem nevezhető demokratikusnak, olyan, mint a középkorban: míg ma láthatatlan szerverek, akkoriban a papság tárolta az információkat, és olyan formában bocsátotta a tudást az emberek rendelkezésére ahogy ők jónak látták. Ennek mindenképpen meg kell változnia, és olyan ágazatokat is kiemelten vizsgálni kellene mint a biztosítási szektor vagy olyan területeket, mint a munkaerő-felvétel. Ez egy technológiai küzdelem lesz, de előtte egy politikai harcot is meg kell nyerni. Hiba lenne konkrét megoldásokon vitatkozni, inkább a játékszabályokat kellene meghatározni és bizonyos határcölöpöket leverni.

Első körben a cégeknek bizonyítaniuk kellene, hogy rendszereik függetlenül, beavatkozásoktól mentesen működnek, bemutatni az adatkiválasztás és -feldolgozás módjait, és vitára bocsátani azok összekötésének kérdését. A potenciálisan veszélyes algoritmusokról be kell bizonyítaniuk hogy azok legálisak, működésük igazságos és konzisztens. Egyértelműsíteni kell a felelősségi köröket; az algoritmusok nem hoznak döntéseket és nem cselekszenek maguktól, nem az égből esnek le, valaki dönt azokról és implementálja azokat. A bírságoknak elrettentő mértékűeknek kell lenniük, hogy a cégeknek ne érje meg csalni. Ideje elvárni, hogy a gépek értünk dolgozzanak.

Egy a XX. század elején született ember valószínűleg egész életében sohasem látott algoritmusokat, pedig bármilyen foglalkozása volt is, szinte mindennap használt valamilyen formális szabályt. A betonkeveréstől kezdve a marhabőrrel dolgozó cipészig mindenki előre meghatározott eljárásokkal végzi a dolgát, tudása és korábbi tapasztalatai határozzák meg tevékenységét. Ma pedig már algoritmusok befolyásolják az áram- és a vízellátást, az erőművek, a közlekedési lámpák, de még a zuhanyzóban elhelyezett termosztátok működését is. Az egyszerű mechanikus és elektronikus eszközöket szinte minden fontosabb területen programozott intelligenciával rendelkező megoldások váltották fel.

Míg nagyapánk autója tisztán mechanikus volt, addig a mai járművek már digitális rendszerekkel működnek, több mint 100 vezérlőeszközük és szenzoruk van. A mérnökök tudását és a tesztutak eredményeit programozók szabályokká és parancssorokká konvertálják, a számítógépek az érzékelők adatait pillanatok alatt elemzik és vezérlőjelekké alakítják. De az algoritmusok nem pusztán kiszolgáló rendszerek és háttérmegoldások, hanem befolyásolják a döntéseinket, a világnézetünket, az általunk fogyasztott tartalmakat, a Google keresési eredményeit, a Spotify zeneajánlásait, a banki hitelek odaítélését vagy a kérvények elutasítását.

Nagy-Britanniában és az Amerikai Egyesült Államokban az állásokra jelentkező személyek 70 százalékát először ismeretlen feltételek alapján, automatikusan pontozzák, és csak ezután jönnek a munkaügyi asszisztensek. A Facebook minden egyes felhasználó esetében 7000 különböző viselkedési mintát rögzít és ezekből alakít ki egy profilt. Historikus adatokon alapuló pénzügyi kockázati modellek próbálják előre jelezni a piaci katasztrófákat, és minden biztosító alkalmaz valamilyen pontozási módszert az ügyfelek osztályokba sorolására.

Az amerikai tőzsdéken a bevétel 70 százalékát gépek generálják, Európában ugyanez az arány 50 százalék. A sebesség itt létfontosságú, azok a rendszerek termelik a legtöbb nyereséget, amelyek az információkat a leggyorsabban dolgozzák fel és ültetik át megbízásokká. Az algoritmusok nem csupán gyorsabban, hatékonyabban és olcsóbban dolgoznak az embereknél, de okosabbak is náluk, például az adatok összehasonlításakor és a különböző minták felismerésekor. Számos hatóság használ elemzőszoftvereket a bűncselekmények előrejelzésére és több amerikai szövetségi államban alkalmaznak a bíróságok olyan programot, amellyel kiszámítható a bűnözők visszaesésének a valószínűsége.

De vajon mennyire objektív és semleges egy algoritmus? Ez még sokszor a készítők számára sem nyilvánvaló, és semelyik országban semmilyen kormányzati kontroll nincs felette, még a nagy melléfogások után sem szabályozták sehol ezt a területet. Különösen ott lehet érdekes a kérdés, ahol monopóliumszerű struktúrák vannak, mint például a Facebook és a Google világa. Sokféleképpen, több szinten lehet rossz egy algoritmus: például egy harvardi professzor, Latanya Sweeney azt találta, hogy egy többségében a színesbőrűek által használt névre keresve bűnözéssel kapcsolatos hirdetések jelentek meg a találati lista mellett. Szinte biztosan nem a Google mérnöke volt rasszista, hanem valószínűleg a korábbi keresések alapján tréningezték így a gépet. Hasonló eset a képek hibás felcímkézése, például az afroamerikaiak gorillaként való jelölése - kiadás előtt túl rövid volt a tesztidőszak.

Ott van még a piszkos algoritmusok esete: a legális, de erkölcsileg kifogásolható módszerek. Ilyen például amikor a Facebook az ausztrál reklámozók számára önbizalomhiányos tinédzsereket célzott be vagy amikor az Uber fizetési algoritmusa leszorította a béreket, egyben szélesítve a nők és férfiak közötti szakadékot. Jó példa a cég az illegális algoritmusra is, ilyen volt amikor megtippelték ki az ellenőr, és azok egyszerűen hamis Uber-autókat láttak az appjukban, de nem hiányozhat a felsorolásból a Volkswagen sem, akik a károsanyag-kibocsátási mérést csapták be a motorvezérlés módosításával, ha az autó tesztet érzékelt.

Az amerikaiaknál Google-Knowing annak a jelenségnek a neve, amelynél az úgynevezett féltudás a meghatározó. Mindez arra utal, hogy az emberek az információkat már nem vizsgálják meg, hanem a keresési eredményeket automatikusan helyesnek fogadják el. A mechanizmus mindig ugyanaz: az információkat kinyerő eszközök - például egy webes keresés - algoritmikus szabályokra épül. De utána jönnek bizonyos ismeretlen feltételek, amelyek alapján bizonyos oldalakat és tartalmakat előrébb sorolnak például annak alapján, hogy korábban mire kattintottak gyakran az emberek. Tehát nem a minőség számít, ráadásul az első hellyel ráerősítenek egy korábbi döntés-sorozatra. Az algoritmusok akár az igazságot is helyettesíthetik, egyes dolgokat kihagyhatnak a rendszerek.

Jelenleg semmilyen szervezet nem képes és szándékozik a veszélyes és illegális algoritmusok felderítésére. Minden országban van néhány hatóság, amely csak a saját ágazatát vagy területét felügyeli, például a Google Shopping esetével az EU legfelsőbb szinten foglalkozik, de eközben számtalan iparágban akár éveken át folyhatnak kétes tevékenységek. A felderítés nehézkes, mindenhol az üzleti titok vastag fala övezi a kérdést. Egy az ügyfeleket pontozó cég rendszerénél az emberek sokszor még saját maguk értékelését sem ismerhetik meg, így ha az méltánytalan is, panaszt sem tudnak tenni ellene.

De sokszor még a rossz vagy embereket veszélyeztető dolgok ellen sem lehet fellépni, mert nem mérhető dologról van szó. Például hiába ömlik a médiából, hogy az álhírek veszélyeztetik a demokráciát, hogyan lehet azok hatását megbecsülni? A tavaly ősszel lezajlott amerikai választási kampány fő témája a információk hitelessége volt, százezernyi bot befolyásolta a közösségi hálózatokban az emberek véleményét. A Twitter forgalmának ötödét automaták generálták, és a közvéleményre gyakorolt hatásuk tagadhatatlan. De a Google és a Facebook szerint csupán elég adatot és tényt kell eltárolni és az igazság birtokába jutunk, az alapító Mark Zuckerberg szerint pedig platformja teljesen semleges és objektív világnézetű.

Tavaly októberben Angela Merkel német kancellár panaszkodott arról, hogy mindenki csak azokat a megosztásokat látja, amelyekkel egyetért. A politikus már akkor azt sürgette, hogy az algoritmusoknak átláthatóknak kell lenniük, hogy a polgárok tájékozódhassanak arról, hogy mi történik a médiaszokásaikkal kapcsolatos adatokkal. Heiko Maas német igazságügyi miniszter pedig július elején jelezte, hogy szabályozná az internetes óriáscégek működését, a tervek alapján egy külön hivatal ellenőrizné a használt algoritmusokat. Hasonlót vetett fel a Maryland Egyetem professzora, Ben Shneiderman, aki szerint az amerikai Nemzeti Szállítmányozás Biztonsági Tanács mintájára egy Algoritmus Biztonsági Tanácsot kellene létrehozni, és ugyanúgy, ahogy az előbbi minden földi és légibalesetet kivizsgál, ez hasonlóképp megállapítaná a felelősséget az algoritmusok okozta károkért.

De ez korántsem lesz olyan egyszerű, mint egy autópályán történt tömegkatasztrófánál, mert a problémák többsége az egyéneket érinti, és azok szinte láthatatlanok és felderíthetetlenek. Az IT-óriások külső szakértőket nem engednek be laboratóriumaikba, azaz mintha a Volkswagen nem engedné, hogy leteszteljék autói működését. Ez a tudás nem nevezhető demokratikusnak, olyan, mint a középkorban: míg ma láthatatlan szerverek, akkoriban a papság tárolta az információkat, és olyan formában bocsátotta a tudást az emberek rendelkezésére ahogy ők jónak látták. Ennek mindenképpen meg kell változnia, és olyan ágazatokat is kiemelten vizsgálni kellene mint a biztosítási szektor vagy olyan területeket, mint a munkaerő-felvétel. Ez egy technológiai küzdelem lesz, de előtte egy politikai harcot is meg kell nyerni. Hiba lenne konkrét megoldásokon vitatkozni, inkább a játékszabályokat kellene meghatározni és bizonyos határcölöpöket leverni.

Első körben a cégeknek bizonyítaniuk kellene, hogy rendszereik függetlenül, beavatkozásoktól mentesen működnek, bemutatni az adatkiválasztás és -feldolgozás módjait, és vitára bocsátani azok összekötésének kérdését. A potenciálisan veszélyes algoritmusokról be kell bizonyítaniuk hogy azok legálisak, működésük igazságos és konzisztens. Egyértelműsíteni kell a felelősségi köröket; az algoritmusok nem hoznak döntéseket és nem cselekszenek maguktól, nem az égből esnek le, valaki dönt azokról és implementálja azokat. A bírságoknak elrettentő mértékűeknek kell lenniük, hogy a cégeknek ne érje meg csalni. Ideje elvárni, hogy a gépek értünk dolgozzanak.