Gyurkity Péter

Részletek az nVidia új sorozatáról

Azt már tudtuk, hogy az nVidia egészen pontosan két új grafikus kártyával alapozná meg a GeForce 9 családot követő generációt. A GeForce GTX 280 és GTX 260 fontos részleteiről most érkeztek hírek.

Eszerint a GeForce GTX 280 a D10U-30 jelzésű chipre, a GTX 260 pedig annak D10U-20 jelzésű, némileg lebutított változatára épül. Előbbi a vezérlő minden funkcióját elérhetővé teszi majd a felhasználók számára, és összesen 240 egyesített stream processzorával a család zászlóshajójának szerepét tölti be. Az nVidia szerint ráadásul ezek a második generációs egységek csaknem 50 százalékkal jobban teljesítenek, mint egy sorozattal korábban megjelent elődeik.

A két variáns közötti fő különbséget természetesen itt találjuk majd, hiszen a GTX 260 esetében 48 stream processzort letiltanak, és míg a GTX 280-nál 512 bites interfész felel az 1 GB GDDR3 memória vezérléséért, a kisebb testvérnél 448 bites busz végzi ugyanezen feladatot, egészen pontosan 896 MB memóriával társulva. A két új fejlesztés minden más tekintetben megegyezik a GeForce 9800 GTX által kínáltakkal: PCI-Express 2.0, OpenGL 2.1, illetve PureVideoHD-támogatás, az SLI esetében pedig elérhetővé válik a háromutas megoldás, vagyis további két grafikus kártyával egészíthetjük ki az első példányt.

Érdekesség, hogy az AMD által tervezett Radeon HD 4000-es sorozat tagjaival ellentétben, az új GeForce erőművek nem támogatják majd a DirectX 10.1 technológiát, megmaradnak a 10-es verziónál. Ugyanígy a jól bevált GDDR3 memóriára támaszkodnak, miközben a rivális már a GDDR5 bevezetésének gondolatával kacérkodik, nyilván abban reménykedve, hogy ezzel számottevő előnyre tehet szert és a döntés előnyei a kártyák teljesítményén is meglátszanak majd. Megjelenik viszont a PhysX-támogatás, bár erről a cég egyelőre nem árult el részleteket, így a pontos adatokról és várható előnyökről a legtöbben csak találgatnak.

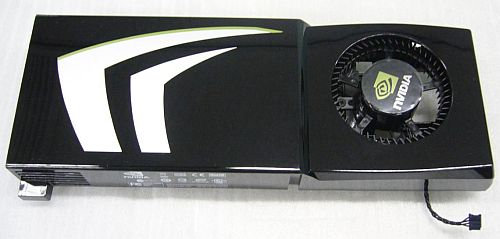

Időközben egyes kínai oldalakon néhány kép is megjelent az új kártyákról. A hivatalos megjelenési dátum június 18.

Eszerint a GeForce GTX 280 a D10U-30 jelzésű chipre, a GTX 260 pedig annak D10U-20 jelzésű, némileg lebutított változatára épül. Előbbi a vezérlő minden funkcióját elérhetővé teszi majd a felhasználók számára, és összesen 240 egyesített stream processzorával a család zászlóshajójának szerepét tölti be. Az nVidia szerint ráadásul ezek a második generációs egységek csaknem 50 százalékkal jobban teljesítenek, mint egy sorozattal korábban megjelent elődeik.

A két variáns közötti fő különbséget természetesen itt találjuk majd, hiszen a GTX 260 esetében 48 stream processzort letiltanak, és míg a GTX 280-nál 512 bites interfész felel az 1 GB GDDR3 memória vezérléséért, a kisebb testvérnél 448 bites busz végzi ugyanezen feladatot, egészen pontosan 896 MB memóriával társulva. A két új fejlesztés minden más tekintetben megegyezik a GeForce 9800 GTX által kínáltakkal: PCI-Express 2.0, OpenGL 2.1, illetve PureVideoHD-támogatás, az SLI esetében pedig elérhetővé válik a háromutas megoldás, vagyis további két grafikus kártyával egészíthetjük ki az első példányt.

Érdekesség, hogy az AMD által tervezett Radeon HD 4000-es sorozat tagjaival ellentétben, az új GeForce erőművek nem támogatják majd a DirectX 10.1 technológiát, megmaradnak a 10-es verziónál. Ugyanígy a jól bevált GDDR3 memóriára támaszkodnak, miközben a rivális már a GDDR5 bevezetésének gondolatával kacérkodik, nyilván abban reménykedve, hogy ezzel számottevő előnyre tehet szert és a döntés előnyei a kártyák teljesítményén is meglátszanak majd. Megjelenik viszont a PhysX-támogatás, bár erről a cég egyelőre nem árult el részleteket, így a pontos adatokról és várható előnyökről a legtöbben csak találgatnak.

Időközben egyes kínai oldalakon néhány kép is megjelent az új kártyákról. A hivatalos megjelenési dátum június 18.

Szerencsére ez Dx10 alatt nem fordulhat elő.

Szerencsére ez Dx10 alatt nem fordulhat elő.