Berta Sándor

Az előítéletes algoritmusok ellen küzd a Google

A cél a lehetséges problémák kiküszöbölése a fejlesztések elejétől kezdve.

A mesterséges intelligenciával kapcsolatban az egyik legnagyobb kockázatnak tartja számos kutató, hogy az arra épülő rendszerek reprodukálhatják az emberi előítéleteket és ez erősítheti a társadalmi egyenlőtlenségeket. A témával a Google szakemberei is foglalkoznak és Responsible AI gyűjtőnév alatt számos programot hívtak életre. A társaság mesterséges intelligenciával kapcsolatos fejlesztéseinél eleve az az egyik központi pont, hogy nem hozhat létre vagy nem erősíthet fel előítéleteket.

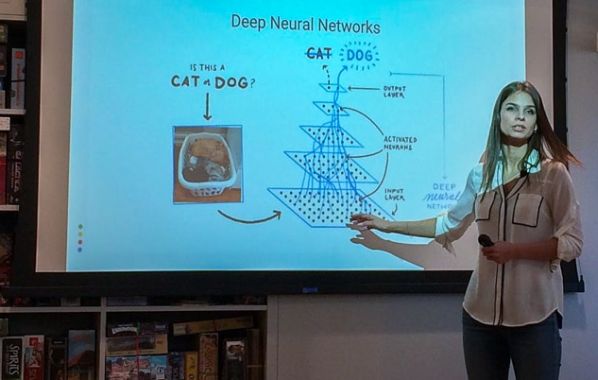

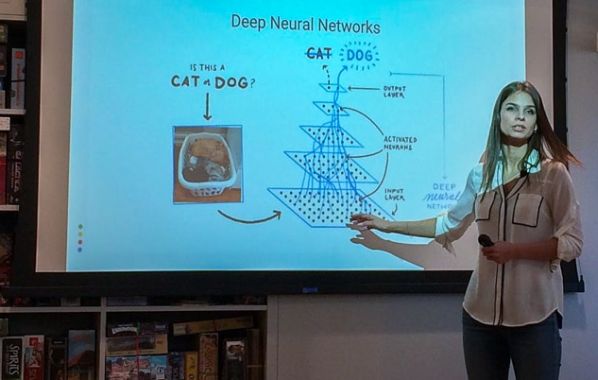

Anna Ukhanova egyike a Google kutatóinak, a szakterülete a gépi tanulás és a mesterséges intelligencia. A szakértő úgy véli, hogy a technológia sikere közvetlenül össze van kötve a felelősségteljes alkalmazásával. Ezzel arra utalt, hogy a múltban mindig voltak olyan műszaki fejlesztések, amelyeknek problémát okozott, hogy minden ember igényeit azonos módon kielégítsék. Ezért volt az, hogy például egy időben a közúti balesetekben a nők gyakrabban sérültek meg. Az ok egyszerű volt: az előzetes biztonsági tesztek során, például a biztonsági övek kialakításakor csak a férfiak testalkatát vették figyelembe. Ukhanova rámutatott, hogy a mesterséges intelligenciánál is bármikor megvalósulhatnak az egyenlőtlenségek, gyakran már a legalapvetőbb dolgok esetében is.

Fernanda Viegas, a Google másik kutatója hozzátette, hogy az előítéletek sokszor magukban az adatokban vannak. Ez azoknak a forrásoknak köszönhető, amelyekkel a gépi tanulást, illetve a mesterséges intelligenciát betanítják. Ezek a hatalmas adatbázisok nehezen ellenőrizhetők, hiszen az emberek nem úgy vannak megalkotva, hogy ilyen nagy információmennyiségekkel dolgozzanak, ezért szükségük van eszközökre, hogy kezelni tudják azokat és a különböző egyenlőtlenségeket már a folyamat elején kiszűrjék. Ők mindenesetre mindent elkövetnek azért, hogy egyre több hatékony eszközt fejlesszenek ki.

Anna Ukhanova

Ukhanova kiemelte, hogy az egyenlőtlenségek ellen a legjobb módszer az átláthatóság. Gyakran egyszerű dizájnmódosítások is nagy változásokat eredményezhetnek. Jó példa erre a Google Fordító, amelynél a különböző nem-semleges kifejezéseket úgy fordítják le, hogy azokat a célnyelvben mind női, mind férfi alakban megadják. Fontos az is, hogy a felhasználóknak megmutassák, hogy a technológiának is vannak korlátai és megpróbálják minél jobban elmagyarázni, hogy az adott rendszer miként jut el bizonyos eredményekhez.

Viegas végül leszögezte, hogy a helyzet azért nehéz, mert a mesterséges intelligenciát mindig szélsőséges nézőpontokból szemlélik: vagy mindent tudó technológiának látják, amely minden problémát megold, vagy olyasminek, amely a pusztulásba viszi az emberiséget. Ahhoz, hogy előre lehessen lépni, meg kellene találni a középutat. Beszélni kell azokról a nagyszerű dolgokról, amelyek lehetővé válnak a mesterséges intelligencia segítségével, például a rák felismeréséről vagy a földrengések előrejelzéséről. Ezzel párhuzamosan azonban azt is meg kell említeni, hogy melyik területeken mond csődöt a technológia, mik a problémái és hol vannak határai. Csak így lehet elérni, hogy az emberek megbízzanak a mesterséges intelligenciában.

Ismert tény, hogy ha a képfelismerő algoritmusok egy konyhát érzékelnek, akkor azt automatikusan a nőkkel hozzák kapcsolatba, és például a további ajánlásokkor így kezelik a felhasználót. A számítógépek és a szoftverek az emberek által létrehozott adatbázisokból és mintákból tanulnak, így az emberek előítéleteit is átveszik. Joy Buolamwini, az MIT Media Lab kutatója és az Algorithmic Justice League vezetője. Utóbbi szervezet a gépi tanuláson alapuló rendszerek előítéletei és sztereotípiái ellen harcol. Hasonlóképpen tesz az IBM programja is, amely azt vizsgálja, hogy a technológia által hozott döntések előítéletesek-e és ha igen, mennyire. A kérdés azért is fontos, mert egyre többször hoznak meg fontos döntéseket algoritmusok, amelyek különösen az oktatás, az igazságügy és egészségügy területén kapnak komoly szerepet.

A mesterséges intelligenciával kapcsolatban az egyik legnagyobb kockázatnak tartja számos kutató, hogy az arra épülő rendszerek reprodukálhatják az emberi előítéleteket és ez erősítheti a társadalmi egyenlőtlenségeket. A témával a Google szakemberei is foglalkoznak és Responsible AI gyűjtőnév alatt számos programot hívtak életre. A társaság mesterséges intelligenciával kapcsolatos fejlesztéseinél eleve az az egyik központi pont, hogy nem hozhat létre vagy nem erősíthet fel előítéleteket.

Anna Ukhanova egyike a Google kutatóinak, a szakterülete a gépi tanulás és a mesterséges intelligencia. A szakértő úgy véli, hogy a technológia sikere közvetlenül össze van kötve a felelősségteljes alkalmazásával. Ezzel arra utalt, hogy a múltban mindig voltak olyan műszaki fejlesztések, amelyeknek problémát okozott, hogy minden ember igényeit azonos módon kielégítsék. Ezért volt az, hogy például egy időben a közúti balesetekben a nők gyakrabban sérültek meg. Az ok egyszerű volt: az előzetes biztonsági tesztek során, például a biztonsági övek kialakításakor csak a férfiak testalkatát vették figyelembe. Ukhanova rámutatott, hogy a mesterséges intelligenciánál is bármikor megvalósulhatnak az egyenlőtlenségek, gyakran már a legalapvetőbb dolgok esetében is.

Fernanda Viegas, a Google másik kutatója hozzátette, hogy az előítéletek sokszor magukban az adatokban vannak. Ez azoknak a forrásoknak köszönhető, amelyekkel a gépi tanulást, illetve a mesterséges intelligenciát betanítják. Ezek a hatalmas adatbázisok nehezen ellenőrizhetők, hiszen az emberek nem úgy vannak megalkotva, hogy ilyen nagy információmennyiségekkel dolgozzanak, ezért szükségük van eszközökre, hogy kezelni tudják azokat és a különböző egyenlőtlenségeket már a folyamat elején kiszűrjék. Ők mindenesetre mindent elkövetnek azért, hogy egyre több hatékony eszközt fejlesszenek ki.

Anna Ukhanova

Ukhanova kiemelte, hogy az egyenlőtlenségek ellen a legjobb módszer az átláthatóság. Gyakran egyszerű dizájnmódosítások is nagy változásokat eredményezhetnek. Jó példa erre a Google Fordító, amelynél a különböző nem-semleges kifejezéseket úgy fordítják le, hogy azokat a célnyelvben mind női, mind férfi alakban megadják. Fontos az is, hogy a felhasználóknak megmutassák, hogy a technológiának is vannak korlátai és megpróbálják minél jobban elmagyarázni, hogy az adott rendszer miként jut el bizonyos eredményekhez.

Viegas végül leszögezte, hogy a helyzet azért nehéz, mert a mesterséges intelligenciát mindig szélsőséges nézőpontokból szemlélik: vagy mindent tudó technológiának látják, amely minden problémát megold, vagy olyasminek, amely a pusztulásba viszi az emberiséget. Ahhoz, hogy előre lehessen lépni, meg kellene találni a középutat. Beszélni kell azokról a nagyszerű dolgokról, amelyek lehetővé válnak a mesterséges intelligencia segítségével, például a rák felismeréséről vagy a földrengések előrejelzéséről. Ezzel párhuzamosan azonban azt is meg kell említeni, hogy melyik területeken mond csődöt a technológia, mik a problémái és hol vannak határai. Csak így lehet elérni, hogy az emberek megbízzanak a mesterséges intelligenciában.

Ismert tény, hogy ha a képfelismerő algoritmusok egy konyhát érzékelnek, akkor azt automatikusan a nőkkel hozzák kapcsolatba, és például a további ajánlásokkor így kezelik a felhasználót. A számítógépek és a szoftverek az emberek által létrehozott adatbázisokból és mintákból tanulnak, így az emberek előítéleteit is átveszik. Joy Buolamwini, az MIT Media Lab kutatója és az Algorithmic Justice League vezetője. Utóbbi szervezet a gépi tanuláson alapuló rendszerek előítéletei és sztereotípiái ellen harcol. Hasonlóképpen tesz az IBM programja is, amely azt vizsgálja, hogy a technológia által hozott döntések előítéletesek-e és ha igen, mennyire. A kérdés azért is fontos, mert egyre többször hoznak meg fontos döntéseket algoritmusok, amelyek különösen az oktatás, az igazságügy és egészségügy területén kapnak komoly szerepet.