Berta Sándor

Előítéletes algoritmusok

Napjaink legdivatosabb technológiája a gépi tanulás, de a számítógépek általunk létrehozott adatbázisokból és mintákból tanulnak, így a mi előítéleteinket is átveszik.

Joy Buolamwini, az MIT Media Lab kutatója és az Algorithmic Justice League vezetője. Utóbbi szervezet a gépi tanuláson alapuló rendszerek előítéletei és sztereotípiái ellen harcol. "Az identitásunk alakítja a világnézetünket. Az automatikus arcfelismerő rendszerekben alkalmazott algoritmusokat azok a személyek alakítják, akik megalkotják azokat. Amennyiben a programozócsapatból hiányzik azoknak az embereknek az élettapasztalata, akiket a technológia a leginkább érint, akkor a kódolt látásmód nagyon korlátozott, s ezáltal ez egy erősen korlátozott világnézet" - ecsetelte az afroamerikai szakember.

Joy Buolamwini kiemelte, hogy kutatásaik szerint a sötét bőrrel rendelkező emberek nincsenek megfelelően reprezentálva azokban az adatbázisokban, amelyekkel az automatikus arcfelismerő szoftvereket képezik. Az algoritmusokat nem tanítják meg megfelelően arra, hogy változatos arcokat ismerjenek fel és ez nagyon pontatlan eredményekhez vezet. Pedig fontos az, hogy a technológia megfelelően működjön - különösen akkor, ha olyan döntéseket hoz, amelyeknek komoly következményeik lehetnek.

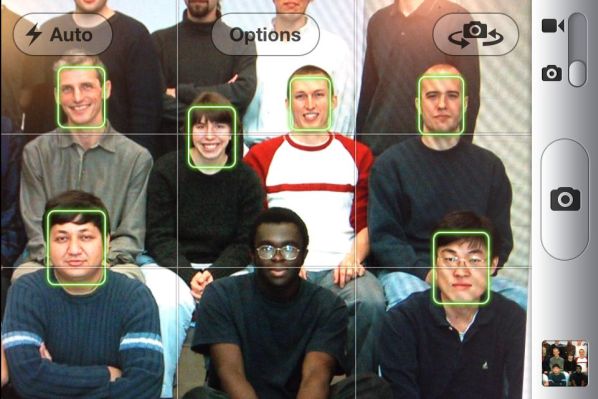

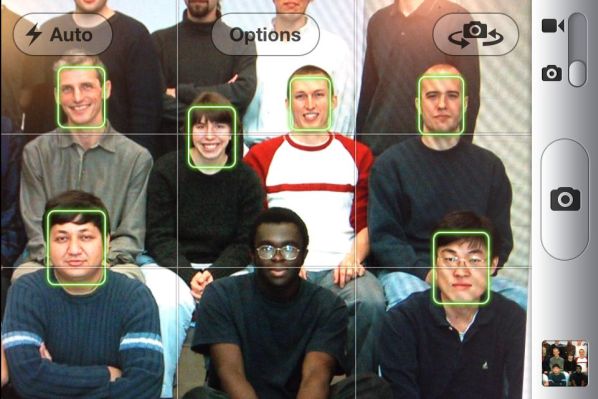

Viccesnek tűnik, de az ilyen hibáknak nagyon komoly következményei vannak

Az Amerikai Egyesült Államokban már most is szoftvereket használnak a hatóságok arra, hogy megbecsüljék a bűnözők visszaesési arányát. Az USA története során a sötét bőrrel rendelkezők mindig előszeretettel kerültek a rendőrség célkeresztjébe, akkor is őket gyanúsították először, ha egyébként semmit sem követtek el. Az algoritmusok ezeket az embereket - hasonló előítéletek miatt - tévesen bűnözőknek sorolhatják be. Amennyiben ehhez még hozzávesszük, hogy a jövőben egyre több biztonsági szolgáltatás épülne arcfelismerésre, akkor főleg tisztában kell lennünk azzal, hogy a technológiának sokkal precízebbé kell válnia.

Az MIT Media Lab kutatója kiemelte, hogy soha nem szabad elfelejtenünk, hogy az algoritmusok minket tükröznek vissza. A világnak előítéletekkel terhelt története van. Az algoritmusok tanulnak a történelmünkből és az algoritmusos előítéletek egyre erősödnek, mert az adatok egyre inkább hálózatba vannak kötve. Olyan gyorsan terjednek, amilyen gyorsan le lehet tölteni valakinek a kódját, és bemásolni egy új termék programsorai közé. De ezek az előítéletek a gépekből ugyanilyen gyorsan kigyomlálhatók, csak akarat és átláthatóság kell hozzá. "Gyakran teszünk úgy, mintha az algoritmusok emberi beavatkozás nélkül alakulnának ki. De egyre inkább szűrőszoftverek döntenek arról, hogy ki kap meg egy állást, milyen reklámok kerülnek a képernyőnkre és mennyit fizetünk bizonyos dolgokért. Amennyiben ezekről a hatásokról megfeledkezünk, akkor elfedjük az előítéleteket és elmulasztjuk azt az esélyt, hogy kijavíthassuk azokat."

Ilyen az, amikor a programozók nem gondolnak a színesbőrűekre

Úgy véli, az ágazatnak az algoritmusok átláthatóságával kapcsolatban változtatnia kell. A kutatók körében már több mint egy évtizede téma az algoritmusok előítélete, és már olyan jogszabály is van, amely pénzügyi és jogi következményekkel sújtja azokat az eseteket, amikor egy vállalat figyelmen kívül hagyja ezeket a dolgokat. De önmagában kevés azt követelni, hogy egy cég hozza nyilvánosságra az adott szoftvere mögötti logikát. Az algoritmuson túl ugyanis az is fontos, hogy miként fejlesztették ki és tervezték meg a programot, s főleg, hogyan alkalmazták azt" - jegyezte meg az Algorithmic Justice League vezetője.

Joy Buolamwini szerint az algoritmusok csak úgy lehetnek pontosabbak, ha a fejlesztési folyamatokba változatos perspektívákkal rendelkező embereket vonnak bele. A techtársaságok gyakran hangoztatják, hogy hagyni kell, hogy szolgálhassák a világot. Nos, aki szolgálni akarja a világot, annak a fejlesztéseknél - előítéletek nélkül - mindenkit figyelembe kell vennie.

Joy Buolamwini, az MIT Media Lab kutatója és az Algorithmic Justice League vezetője. Utóbbi szervezet a gépi tanuláson alapuló rendszerek előítéletei és sztereotípiái ellen harcol. "Az identitásunk alakítja a világnézetünket. Az automatikus arcfelismerő rendszerekben alkalmazott algoritmusokat azok a személyek alakítják, akik megalkotják azokat. Amennyiben a programozócsapatból hiányzik azoknak az embereknek az élettapasztalata, akiket a technológia a leginkább érint, akkor a kódolt látásmód nagyon korlátozott, s ezáltal ez egy erősen korlátozott világnézet" - ecsetelte az afroamerikai szakember.

Joy Buolamwini kiemelte, hogy kutatásaik szerint a sötét bőrrel rendelkező emberek nincsenek megfelelően reprezentálva azokban az adatbázisokban, amelyekkel az automatikus arcfelismerő szoftvereket képezik. Az algoritmusokat nem tanítják meg megfelelően arra, hogy változatos arcokat ismerjenek fel és ez nagyon pontatlan eredményekhez vezet. Pedig fontos az, hogy a technológia megfelelően működjön - különösen akkor, ha olyan döntéseket hoz, amelyeknek komoly következményeik lehetnek.

Viccesnek tűnik, de az ilyen hibáknak nagyon komoly következményei vannak

Az Amerikai Egyesült Államokban már most is szoftvereket használnak a hatóságok arra, hogy megbecsüljék a bűnözők visszaesési arányát. Az USA története során a sötét bőrrel rendelkezők mindig előszeretettel kerültek a rendőrség célkeresztjébe, akkor is őket gyanúsították először, ha egyébként semmit sem követtek el. Az algoritmusok ezeket az embereket - hasonló előítéletek miatt - tévesen bűnözőknek sorolhatják be. Amennyiben ehhez még hozzávesszük, hogy a jövőben egyre több biztonsági szolgáltatás épülne arcfelismerésre, akkor főleg tisztában kell lennünk azzal, hogy a technológiának sokkal precízebbé kell válnia.

Az MIT Media Lab kutatója kiemelte, hogy soha nem szabad elfelejtenünk, hogy az algoritmusok minket tükröznek vissza. A világnak előítéletekkel terhelt története van. Az algoritmusok tanulnak a történelmünkből és az algoritmusos előítéletek egyre erősödnek, mert az adatok egyre inkább hálózatba vannak kötve. Olyan gyorsan terjednek, amilyen gyorsan le lehet tölteni valakinek a kódját, és bemásolni egy új termék programsorai közé. De ezek az előítéletek a gépekből ugyanilyen gyorsan kigyomlálhatók, csak akarat és átláthatóság kell hozzá. "Gyakran teszünk úgy, mintha az algoritmusok emberi beavatkozás nélkül alakulnának ki. De egyre inkább szűrőszoftverek döntenek arról, hogy ki kap meg egy állást, milyen reklámok kerülnek a képernyőnkre és mennyit fizetünk bizonyos dolgokért. Amennyiben ezekről a hatásokról megfeledkezünk, akkor elfedjük az előítéleteket és elmulasztjuk azt az esélyt, hogy kijavíthassuk azokat."

Ilyen az, amikor a programozók nem gondolnak a színesbőrűekre

Úgy véli, az ágazatnak az algoritmusok átláthatóságával kapcsolatban változtatnia kell. A kutatók körében már több mint egy évtizede téma az algoritmusok előítélete, és már olyan jogszabály is van, amely pénzügyi és jogi következményekkel sújtja azokat az eseteket, amikor egy vállalat figyelmen kívül hagyja ezeket a dolgokat. De önmagában kevés azt követelni, hogy egy cég hozza nyilvánosságra az adott szoftvere mögötti logikát. Az algoritmuson túl ugyanis az is fontos, hogy miként fejlesztették ki és tervezték meg a programot, s főleg, hogyan alkalmazták azt" - jegyezte meg az Algorithmic Justice League vezetője.

Joy Buolamwini szerint az algoritmusok csak úgy lehetnek pontosabbak, ha a fejlesztési folyamatokba változatos perspektívákkal rendelkező embereket vonnak bele. A techtársaságok gyakran hangoztatják, hogy hagyni kell, hogy szolgálhassák a világot. Nos, aki szolgálni akarja a világot, annak a fejlesztéseknél - előítéletek nélkül - mindenkit figyelembe kell vennie.