90029

-

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #78383

#78383

Olvasd el azt, hogy működik. :)

Egy nagyobb felbontású képet a számítás végén (vagyis kész állapotban) méretezel le. Ott sokat "csalni" nem lehet. Csak éppen a számításigénye bődületes... -

#78382

#78382

Erről még nem hallottam. -

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #78381

#78381

SSAA esetén nem szabadna lennie eltérésnek. -

#78380

#78380

Max payne, 3-vagy 4 félét is hasnál.

Ez a nem mindegy "melyik játék" azért tut biztos mert van olyan játék, aminél 16x-os élsimitással is recésebb a játék mint máshol ahol mondjuk vagy csak simán nagy felbontásra rakom vagy 2x-es élsimításra. -

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #78379

#78379

Végül is jogos az öt pont. A játéktól (játékmotortól) függ az, hogy melyik AA eljárás a leghatékonyabb. -

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #78378

#78378

Zoli007 már megadta a tömör választ, de akkor ezt is fejtsük egy kicsit ki:

A "régi iskola" szerint a fények és az árnyékolás kezelése úgy működik, hogy lerendeled az objecteket, majd jönnek a fények/árnyékolás leképezése egymás után, de minden leképezésnél újra és újra kell rajzolni a teljes képet, a frame bufferbe betöltve, és újra számolva. A gond az, hogy ez számításigényes, eléggé.

A deferred rendering esetében egy "G-buffer"-be kerül, és csak azon a részen hajtódik végre a leképezés, amelyet láthatónak tekint a rendszer. A végső leképezés ezeknek a részeknek az elkészülte után hajtódik végre. Ennek a módszernek az előnye, hogy hatékonyabb számítás terén, hátránya, hogy minél többfelé osztjuk a részeket, azok mind-mind külön memóriát (G-buffert) igényelnek, szóval több videómemória kell az alkalmazásához. Ezzel együtt is manapság ez az elterjedt megoldás, az Unreal Engine 3, a CryEngine 3 és a többi modern motor mind ezt az eljárást használja.

A gond az, hogy ahogy sejthető, a Deferred Rendering üti az MSAA működését, mivel a frame bufferbe a már árnyékolt kép kerül, vagyis működés szempontjából ugyanott járunk, mint az SSAA esetében. Egy ellenpélda itt is van, a Crysis 2 esetében egy számítási trükkel alkalmazott MSAA verzió lett alapértelmezett. Ám ennek hatékonysága nem volt éppen acélos, ezért is volt az FXAA opció a játékban. -

#78377

#78377

Az a gáz hogy mindkettőtöknek igaza van.

Hiszen az élsimítás a játék függvényében változik!!!

Nem minndegy hogy melyik játékban kell élsímítani, vagy éppen melyik játékban kell FXAA vagy MLAA-t használni....

És hogy a fejlesztők miképpen tudják fejlesztésnél megoldani, ez nem olyan egyszerű dolog, hogy egyik 20fps a másik 30, azt utána kijön egy játék, abba meg teljessen más eredmények lesznek.

Ráadásul mint tudomásom van róla, az FXAA a GPU dolga, az MLAA meg a CPU-ra van hárítva.

FXAA

MSAA 1x vs MLAA

-

#78376

#78376

Ugyanolyan élsimított!

Csak ne feledd hogy régebben egyszerű textúrák és effektek voltak....

Emlékszel megvettem a Bulletstorm-ot.

Ez nem elég élsimításnak? :)

Simítsd hozzá a régiekhez.....

-

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #78375

#78375

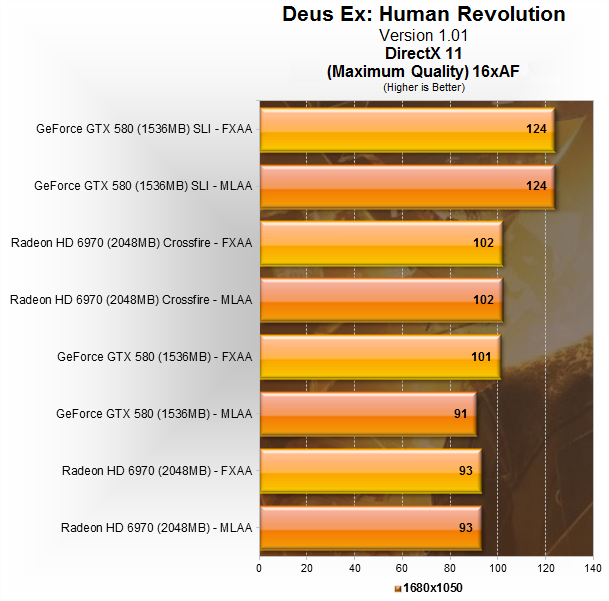

Akkor nézzük végig. A [H] teszt (amit amúgy korábban én is olvastam, és részben onnan származnak az infok) szerint az MLAA csak az AMD kártyákon működik, hiszen driverből kell bekapcsolni. Nem is szerepel az MLAA tesztnél nVidia kártya. A [H]-s teszt eredménye:

Hát ez bizony 41%-os teljesítménykülönbség az FXAA javára...

A Deus Ex egy kivétel a játékok között, mert a játékmotorba lett az MLAA bele építve, ezért lehet nVidia kártyákon is bekapcsolni. Itt kerül elő a probléma a beépített kódnál, feltehetően a Deus Ex kódja egy nagy rakás ****, a teljesítményt ugyanis nem a befolyásolja számottevően az AA beállítás (érdemes megnézni, hogy 100 feletti FPS-ekről beszélünk!)... :P -

#78374

#78374

A remek posztjaid hatasara vegeztem egy gyorskutatast kivancsisagbol: link1, link2

arty: meg is van -

#78373

#78373

Az új játékok java része deferred renderinges, ahol az MSAA semmire nem jó. -

#78372

ha nem teszem be a pipát a morphological négyzetbe, nem látom h AA kerülne a képre :/ szerintem gta4 alatt ez nem működik...

---

Solten! Volt egy kis upgrade a htpc-ben (amig nem volt pécém, azon játszogattam, kellett egy erősebb kis apu)

HD 6410D -> HD 6530D

javítod? köszi!

(egyébként meglepően "erős" a kis cpu-gpu hibrid az A6-3620, 13 ezerért 720p-ben kompromisszummal mindennel tudtam játszani, amivel akartam) -

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #78371

#78371

A CCC-ben most is be lehet állítani az SSAA-t, Gaming -> 3D Application Setting -> Anti-Aliasing Mode -> húzd a csúszkát teljesen jobbra. :)

Csak bika videokártya kell mellé, neked meg az van, úgyhogy ne sírj. :)

Tényleg, miért nem SSAA-t állítasz be a GTA4-nél? Azért az már nem mai játék, csak elvinné a kártyesz SSAA-ban is, nem? -

#78370

AA szempontból visszasírom a korai dx9es játékokat, mamár semmi nem olyan szépen élsimított, mindegy milyen megoldást használnak :(

a CCC-s mlaa arra jó, hogy pl a gta4-re rátegyem... (1-2 fps-t ha lassul tőle)

-

#78369

#78369

Fú köszönöm a részletes leírást! Tényleg gyorsabb az FXAA! Kipróbáltam először az MSAA-t utána pedig az FXAA-t és azt kell, hogy mondjam ég és föld! -

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #78368

#78368

A gond az, hogy az MSAA az effektezés előtt csinálja az elmosást, míg az FXAA és az MLAA (ami az AMD "drivebe épített" FXAA-ja végül is, de annyira nem vált be, mert ahogy lent is említve volt, a HUD és egyéb elemeknél, ahol az élekre "vigyázni" kellene, nem feltétlen ismeri) meg utána. Szóval a probléma az, hogy ez a "szebb" fogalom kérdőjeles - a mai játékok iszonyatosan sok effektet pakolnak egy-egy pixelre, szóval bizonyos szempontból igenis az FXAA előnyben van az MSAA-hoz képest (az AMD is ezért nyomatta az MLAA-t). Erre jön a durva sebességelőny is (és ez az, ahol az MLAA még ráadásul kap egy pofont, mert az MLAA a legtöbb esetben sebességelőnyt nem tud felmutatni az MSAA-hoz képest). Innentől kezdve nem vitás, minek van létjogosultsága. Eredmény / teljesítményigény terén az FXAA egyszerűen üti az opcionális lehetőségeket.

Ha meg a szépségnél tartunk, az SSAA-nál nincs jobb megoldás... csak nem sokan engedhetik maguknak, hogy lazán félredobják az FPS kétharmadát miatta. -

#78367

szerintem az msaa SOKKAL szebb, mint ezek a trükkös AA-k (majdnem összekevertem az MLAA-val, amire NEM tértél ki és amit berczely a CCC-ből még az msaa+fxaa-ra is rá tudna erőltetni MP3 alatt :D) -

#78366

#78366

Igazi CIFU-s, informatív hozzászólás :)

-

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #78365

#78365

Szépen sorban:

SSAA: Super-Sample Anti-Aliasing - ő az ős, ami még a 3Dfx-től származtatott. Fogod a képet, és a kijelzőre kerülő felbontás többszörösében (2x, 4x, ...) rendelereled le a képkockát. Aztán fogod, és lekicsinyíted a megfelelő szűrővel. Az eredmény nagyon jó, de mivel a valóban használt felbontáshoz képest sokkal nagyobban dolgozol, ezért nagy számítás- és memóriaigénye van.

MSAA: Multi-Sampling Anti-Aliasing - manapság leginkább ezt használják, gyakorlatilag itt is nagyobb felbontásban készül a kép, de még effektezés (pixel shader) előtt, így az effektezés maga már a kevesebb pixelmennyiségen zajlik le. Gyorsabb, viszont az eredmény nem annyira szép, lévén az effekteknél néha észrevehető a "szőrösödés".

CSAA: Coverage-Sample Anti-Aliasing - ez az NVIDIA neve a saját fejlesztett megoldására. A lényeg, hogy vége (shaderek) továbbra is csak 1x méretben vannak kiszámolva, de a frame buffer 4x, míg maga a képszámolás 16x. Szebb eredményt nyújt, mint az MSAA, de ugyanúgy kompromisszumos eljárás.

FXAA: Fast Approximate Anti-Aliasing - ez az új császár, a lényege, hogy magába a játék motorjába kell beépíteni. A lényege, hogy egy eljárás megvizsgálja azt, hogy az adott pixel egy mesterséges él része-e vagy sem. Ha úgy véli igen (Approximate ~ Hozzávetőleg), akkor elmossa a pixelt. Az eredmény sok előnnyel rendelkezik, először is már a shaderek után kerül számolásra, így az MSAA és CSAA eljáráshoz képest a már kész pixel lesz elmosva. A másik előnye a sebessége, mivel nem kell nagyobb méretben számolni a képet, ezért iszonyú gyors. Hátránya is van: mivel a motorba kell az alapjait meghatározni (pl. hogy ne mossa el a HUD elemeit), ezért a régi játékokhoz nem lehet igazából használni. Ezért jelent meg az FXAA csak az új játékokban, mint a Skyrim vagy Max Payne 3. A másik hátránya, hogy bizonyos esetekben olyan pixeleket is elmos, amit nem kellene.

Hogy az arányokról beszéljünk egy kép számolásánál az SSAA esetében a sebesség a szorzó arányában nőtt. Vagyis 4x FSAA esetében az FPS bizony negyedelődhetett is akár (különböző trükkök miatt inkább "csak" feleződik-harmadalódik). Az MSAA és CSAA esetében a veszteség már sokkal kisebb, mintegy 25-33% körüli a sebességvesztés. Az FXAA viszont beéri 10-12%-al.

Még jobban szemléltetve:

AA nélkül: 60 fps

SSAA: 20-30 fps

MSAA/CSAA: 35-40fps

FXAA: 50-54 fps

Hogy mit kapcsolja be? Értelemszerűen elég csak az FXAA-t... -

#78364

#78364

Hát érdekes! Én be tudom állítani mindkettőt egyszerre :D De akkor csak az FXAA-t kapcsolom be! Köszönöm a segítséget! -

#78363

#78363

A kettő együtt mission impossible, úgy rémlik hogy az FXAA a kevésbé sebességgyilkos eljárás, így azt... :) -

#78362

#78362

Szevasztok!

Nemrégiben tértem vissza a játékos világba mikor kb. ölembe hullott egy Sapphire HD6670 -es videókártya. Ami meglepő módon (olcsóság) nagyon jól végzi a dolgát és remekül megbirkózik a mai csúcsjátékokkal is.

Feltelepítettem a Max Payne 3-at és egy újdonságra (számomra újdonságra) lettem figyelmes!

FXAA és MSAA. AA betűkből tudom, hogy mindkettő élsimítási technológia. Na, de nekem melyiket kell használnom? FXAA? MSAA? Vagy együtt a kettőt? Kis felvilágosítást kérnék szépen! -

#78361

#78361

Tudja! -

Bábjátékos #78360 Bármi belefér ha barbár módon beleszögelem.

Engem az érdekel hogy ha veszek egy 6850-est akkor az alaplap tudja gond nélkül kezelni? -

Puhos #78359 Hali!

Ha a kérdésed az volt, hogy bele megy-e az alaplapba, akkor igen! -

Bábjátékos #78358 Helló.

A Radeon 6850 kompatibilis egy Gigabyte p55-ud3 alaplappal? -

#78357

nem emiatt, de kb 30 cmos rezeten vagyok túl és baromira unom :))) szerintem megvárom az asrock support reakcióját inkább, mert a vga-ra alig pár beállítás vonatkozik (dgpu-ra meg kb 2)... -

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #78356

#78356

Az Intel Smart Response nincs még a 75-ösön, illetve max. 2 kártyás rendszert támogat (Z77: 3 PCI-Express kártya) de ez aligha vág földhöz.

Ha tudod a bios-t editálni, akkor végig lehet játszani mi az a beállítás, ami nem tetszik neki... Csak elég időtrabló dolog... -

#78355

(bár szvsz a z75/77esek közt bios/uefi/firmware különbségen túl aligha van más) -

#78354

egen, de pár ezressel mindig van eggyel fentebb... én kb a legolcsóbb, normális elrendezésű, z7x deszkát kerestem, amiben lehet tuningolni is a cpu-m

pl a z77-es asrock kb egy ezressel lett volna drágább, csak nem nagyon találtam különbséget ez és aközött, akkor meg minek? ennyi erővel el is égethettem volna egy ezrest... na, inkább nem :) most utólag persze bánhatom :D -

#78353

#78353

28k-ért van már z77-es Giga.. :/ Hát remélem lesz nálad pozitív előrelépés, mer ez így szopacs.. -

#78352

25k (asrock z75pro3)

nagyon fájt! én lapra a felét szoktam költeni (új/használt, mindegy) :D

csak most egy használtal megjártam, meg hardverapron se volt semmi jó, jó áron, rendes garival...

régesrégen, a 486/pentium érában amugy csak asus lapjaim voltak, csak éppen míg más gyártóknál olcsóbban jobb tuning/jobb cpu támogatás volt, így egy idő után elegem lett és váltottam abitra és chaintech-re. mindkettő csődbement :D néha szoktam gigát venni, de általában asrock/ecs, baromira beváltak, sokszor a régi cuccaim mennek a rokonságba, évek óta soha sehol semmi gond egyikkel se...

... erre most ez :( először be se indult (cpu ventit tul lassunak érzékelte), majd bios frissités után a ramok nem akartak működni. az cmos rezettel és cpu/ramok ki/be-vel megoldódtak, maradt ez :( irok supportnak és várok uj bios-ra, hátha. -

#78351

#78351

Gondolom tul vagy mar egy BIOS frissitesen... -

#78350

#78350

nanana... Gonosz vagy :(

nanana... Gonosz vagy :(

Apropó, mennyibe fájt ? Ha nem titok.. -

#78349

#78349

:) -

#78348

ezért találták ki a drágább asus-t, hogy a hívők is megtalálják a maguk kis márkáját ;)) -

#78347

#78347

AsRock .. :/ Nem kéne .. :D Ezé se vettem sosem olyat :D:D:D -

#78346

igen, első post után azonnal :D -

#78345

táp 550es seasonic és előző lapoknál is ugyan ez adta a kraftot :)

asrock deszkám volt am3-as és most van egy fm1-es, nomeg volt egy ecs is - ez a lap több mint duplájába fájt, mint az előzőek, a slotja pcie 3.0, azaz még több áramot kéne tudnia pumpálni a kártyába, de nem :( (korábbi lapjaim csak pcie2.0-sak voltak, nem 2.1esek) -

#78344

#78344

Köszönöm a hozzászólásokat DVI-D - D-SUB kérdésben!