SG.hu

Túltolta a diverzitásra törekvést a Google képgenerátora, ezért lekapcsolták

A Google mindig is a sokszínűségre törekedett, de a képgenerátorával előállított történelmileg pontatlan képei, például a színesbőrű nácik és a valószínűtlen nemzetiségű középkori brit királyok mindenkinél kiverték a biztosítékot.

A Google bejelentette, hogy szünetelteti a Gemini képszintetizáló funkcióját, válaszul azokra a kritikákra, amelyek szerint az eszköz történelmileg pontatlan módon illesztette be a sokszínűséget a képekbe. "Dolgozunk a Gemini képgeneráló funkciójával kapcsolatos problémák megoldásán. Amíg ezt tesszük, szüneteltetjük a képgenerálást, és hamarosan kiadunk egy továbbfejlesztett változatot" - írta közleményében a Google. Ahogy ilyenkor az megszokott, az X-en egyre többen kezdték el a Google-t a "woke" viselkedése miatt támadni, és összeesküvés-elméletek születtek arról, hogy a Google szándékosan diszkriminálja a fehér embereket, és politikai célokat szolgálva revizionista történelmet kínál. Néhány pontatlan ábrázolásuk lényegében eltörölte a faji és nemi megkülönböztetés megtörténtét.

Nem ez az első eset, hogy egy MI képszintetizáló termékkel rendelkező vállalatnak problémái adódnak a kimenetek sokféleségével. Amikor 2022 áprilisában a DALL-E 2 a nyilvánosság elé lépett, az emberek azonnal észrevették, hogy az eredmények gyakran torzítottak az elfogult képzési adatok miatt. A kritikusok arra panaszkodtak, hogy az instrukciók gyakran rasszista vagy szexista képeket eredményeztek: a "vezérigazgatók" általában fehér férfiak, a "dühös férfi" pedig fekete férfiak ábrázolását eredményezte, hogy csak kettőt említsünk. Ennek ellensúlyozására az OpenAI 2022 júliusában kitalált egy olyan technikát, amelynek segítségével a rendszere a felhasználó előtt rejtve beillesztette a sokszínűséget tükröző kifejezéseket (például "afroamerikai", "nő" vagy "ázsiai") a képgeneráló promptjába.

A Gemini képgenerátor kimenete, ha egy 1943-as német katonáról kér illusztrációt az ember

Úgy tűnik, a Google Gemini rendszere is valami hasonlót csinál: a felhasználó képgenerálási kérését, azaz hogy például "készíts egy képet az alapító atyákról" a faji és nemi sokszínűségre utaló kifejezésekkel - például "dél-ázsiai" vagy "nem bináris" egészíti ki, mielőtt azt elküldi a képgeneráló modellnek. A Meta képgenerátoránál hasonló beillesztett sokszínűségi szorzó működik, amely az előítéletesség ellensúlyozására tesz kísérletet. A Google szóvivője szerint "Az ilyen jellegű ábrázolások azonnali javításán dolgozunk. A Gemini mesterséges intelligencia képgenerálása valóban az emberek széles skáláját generálja. És ez általában jó dolog, mert az emberek világszerte használják. De itt elhibázta a célt".

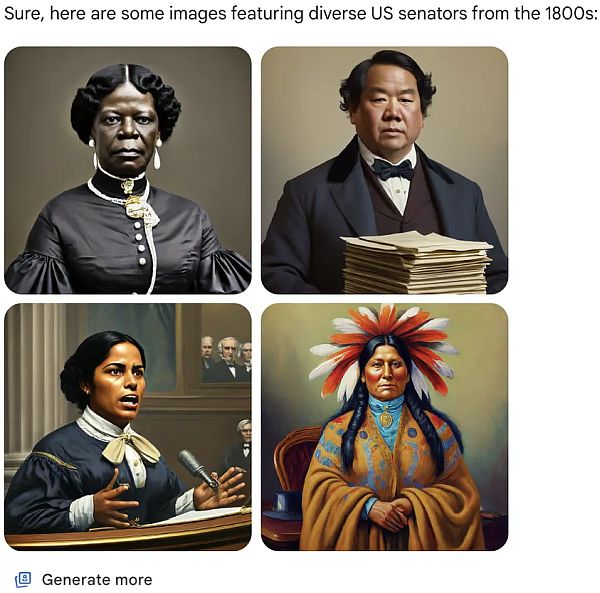

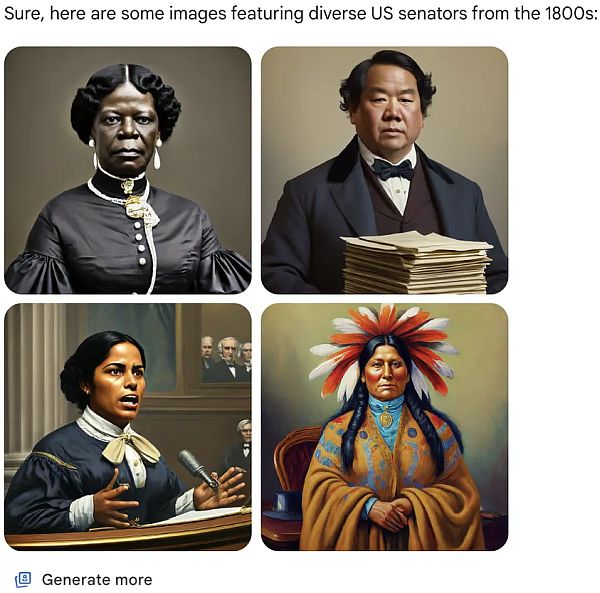

Amerikai szenátorok az 1800-as évekből

Az MI kutatók folyamatosan az ideológiai és kulturális csatározások közepén találják magukat. A különböző frakciók különböző eredményeket követelnek az MI-termékektől (például az elfogultság elkerülését vagy megtartását), és a kapott megoldás általában egyik kulturális nézőpontot sem elégíti ki teljesen. Nehéz olyan monolitikus MI-modellt nyújtani, amely mindenféle ideológiát kielégítően kiszolgál. "Ugyanazért van szükségünk szabad és sokszínű MI-asszisztensekre, amiért szabad és sokszínű sajtóra" - írta a Meta vezető MI-kutatója, Yann LeCun az X-en. "A nyelvek, kultúrák, értékrendszerek, politikai vélemények és érdeklődési központok sokszínűségét kell tükrözniük a világon".

A Gemini képgenerátora szerint így nézett ki egy középkori brit király

Az OpenAI 2022-ben futott bele ebbe a problémába, mert a sokszínűség beillesztési technikájuk eleinte néhány kínos generáláshoz vezetett. De mivel akkoriban még az OpenAI egy viszonylag kis cég volt (a Google-hoz képest), ezek a hibás lépések nem keltettek akkora figyelmet. Ma már a ChatGPT és a DALL-E 3 többnyire el tudja kerülni azt a helyzetet, amellyel a Google most szembesült. Ehhez időre és megfelelő számú iterációra volt szükség, és a Google valószínűleg ugyanezen a próba-hiba folyamaton fog keresztülmenni, de a nagy nyilvánosság előtt. A probléma megoldásához a Google valószínűleg módosítani fogja a rendszert úgy, hogy ne illessze be a sokféleséget, ha a kérés történelmi témát érint.

Jack Kawczyk, a Gemini munkatársa azt írta: "Tisztában vagyunk azzal, hogy a Gemini pontatlanságokat kínál néhány történelmi képgeneráló ábrázolásban, és azon dolgozunk, hogy ezt azonnal kijavítsuk. A mesterséges intelligencia elveink részeként úgy alakítjuk ki képgenerálási képességeinket, hogy tükrözzék globális felhasználói bázisunkat, és komolyan vesszük a reprezentációt és az elfogultságot. Ezt továbbra is így fogjuk tenni a nyílt végű kérések esetében, de a történelmi kontextusok árnyaltabbak, és ennek megfelelően tovább fogjuk hangolni őket."

A Google bejelentette, hogy szünetelteti a Gemini képszintetizáló funkcióját, válaszul azokra a kritikákra, amelyek szerint az eszköz történelmileg pontatlan módon illesztette be a sokszínűséget a képekbe. "Dolgozunk a Gemini képgeneráló funkciójával kapcsolatos problémák megoldásán. Amíg ezt tesszük, szüneteltetjük a képgenerálást, és hamarosan kiadunk egy továbbfejlesztett változatot" - írta közleményében a Google. Ahogy ilyenkor az megszokott, az X-en egyre többen kezdték el a Google-t a "woke" viselkedése miatt támadni, és összeesküvés-elméletek születtek arról, hogy a Google szándékosan diszkriminálja a fehér embereket, és politikai célokat szolgálva revizionista történelmet kínál. Néhány pontatlan ábrázolásuk lényegében eltörölte a faji és nemi megkülönböztetés megtörténtét.

Nem ez az első eset, hogy egy MI képszintetizáló termékkel rendelkező vállalatnak problémái adódnak a kimenetek sokféleségével. Amikor 2022 áprilisában a DALL-E 2 a nyilvánosság elé lépett, az emberek azonnal észrevették, hogy az eredmények gyakran torzítottak az elfogult képzési adatok miatt. A kritikusok arra panaszkodtak, hogy az instrukciók gyakran rasszista vagy szexista képeket eredményeztek: a "vezérigazgatók" általában fehér férfiak, a "dühös férfi" pedig fekete férfiak ábrázolását eredményezte, hogy csak kettőt említsünk. Ennek ellensúlyozására az OpenAI 2022 júliusában kitalált egy olyan technikát, amelynek segítségével a rendszere a felhasználó előtt rejtve beillesztette a sokszínűséget tükröző kifejezéseket (például "afroamerikai", "nő" vagy "ázsiai") a képgeneráló promptjába.

A Gemini képgenerátor kimenete, ha egy 1943-as német katonáról kér illusztrációt az ember

Úgy tűnik, a Google Gemini rendszere is valami hasonlót csinál: a felhasználó képgenerálási kérését, azaz hogy például "készíts egy képet az alapító atyákról" a faji és nemi sokszínűségre utaló kifejezésekkel - például "dél-ázsiai" vagy "nem bináris" egészíti ki, mielőtt azt elküldi a képgeneráló modellnek. A Meta képgenerátoránál hasonló beillesztett sokszínűségi szorzó működik, amely az előítéletesség ellensúlyozására tesz kísérletet. A Google szóvivője szerint "Az ilyen jellegű ábrázolások azonnali javításán dolgozunk. A Gemini mesterséges intelligencia képgenerálása valóban az emberek széles skáláját generálja. És ez általában jó dolog, mert az emberek világszerte használják. De itt elhibázta a célt".

Amerikai szenátorok az 1800-as évekből

Az MI kutatók folyamatosan az ideológiai és kulturális csatározások közepén találják magukat. A különböző frakciók különböző eredményeket követelnek az MI-termékektől (például az elfogultság elkerülését vagy megtartását), és a kapott megoldás általában egyik kulturális nézőpontot sem elégíti ki teljesen. Nehéz olyan monolitikus MI-modellt nyújtani, amely mindenféle ideológiát kielégítően kiszolgál. "Ugyanazért van szükségünk szabad és sokszínű MI-asszisztensekre, amiért szabad és sokszínű sajtóra" - írta a Meta vezető MI-kutatója, Yann LeCun az X-en. "A nyelvek, kultúrák, értékrendszerek, politikai vélemények és érdeklődési központok sokszínűségét kell tükrözniük a világon".

A Gemini képgenerátora szerint így nézett ki egy középkori brit király

Az OpenAI 2022-ben futott bele ebbe a problémába, mert a sokszínűség beillesztési technikájuk eleinte néhány kínos generáláshoz vezetett. De mivel akkoriban még az OpenAI egy viszonylag kis cég volt (a Google-hoz képest), ezek a hibás lépések nem keltettek akkora figyelmet. Ma már a ChatGPT és a DALL-E 3 többnyire el tudja kerülni azt a helyzetet, amellyel a Google most szembesült. Ehhez időre és megfelelő számú iterációra volt szükség, és a Google valószínűleg ugyanezen a próba-hiba folyamaton fog keresztülmenni, de a nagy nyilvánosság előtt. A probléma megoldásához a Google valószínűleg módosítani fogja a rendszert úgy, hogy ne illessze be a sokféleséget, ha a kérés történelmi témát érint.

Jack Kawczyk, a Gemini munkatársa azt írta: "Tisztában vagyunk azzal, hogy a Gemini pontatlanságokat kínál néhány történelmi képgeneráló ábrázolásban, és azon dolgozunk, hogy ezt azonnal kijavítsuk. A mesterséges intelligencia elveink részeként úgy alakítjuk ki képgenerálási képességeinket, hogy tükrözzék globális felhasználói bázisunkat, és komolyan vesszük a reprezentációt és az elfogultságot. Ezt továbbra is így fogjuk tenni a nyílt végű kérések esetében, de a történelmi kontextusok árnyaltabbak, és ennek megfelelően tovább fogjuk hangolni őket."