2319

-

Abu85 #478 A Beyond3D-n írta az egyik srác, hogy az G200-ban 300millió tranyóba került a Geometry Shader sebességének a megtöbbszörözése. Az nV már vélhetőleg tudja, hogy év végére szükség lesz erre a teljesítményre, különben nem pazarolt volne annyi tranyót egy olyan eljárásra ami nem lesz kihasználva. -

#477

#477

"Év végére már komolyabb DX10-es programokat ígérnek"

Hát ha a nagy 0-ról elővarázsolnak ilyet akkor lehetséges de mivel semmi info ilyenekről teljeséggel kizárt. -

Abu85 #476 Persze az sem lehetetlen, hogy az nV-nek a G200 az utsó High-End chipje a Desktop PC piacon. -

Abu85 #475 Az 55nm-es G200 Novemberre reálisan kihozható. Az a fő probléma, hogy egy RV770 is megvalósítható az év végére 40nm-en. Elvileg az RV730 is jönni fog amivel az alsó kategória is le lesz rendezve az AMD-nek. Ezzel a chippel viszont semmi esélye az nV-nek, mert az 55nm-es G92 csak átmenetileg jó, hiszen év végére, már komolyabb DX10-es programokat ígérnek amik már jobban futnak egy HD3850-en is, mint bármelyik GF8-9-en.

Annyi a parti, hogy jövő ilyenkorra ki kell hozni egy új architektúrát, mert a G80 alapjai nagyon tranzisztor pazarlóak lettek. -

#474

#474

Hát a 260-as a tudásához képest árcsökkenéssel is valóban drága dehát ez van atit kell venni azt jóvan. -

#473

#473

-

Abu85 #472 Ez nudli...

A kis GTX260-ból legalább még 50 dolcsit kell engedni, a nagyból meg még vagy 150-et...

-

![[HUN]FaTaL [HUN]FaTaL](https://media.sg.hu/forum/avatars/10557508481320070594.gif) #471

#471

Még így is rohadt drága:D Továbbra sem éri meg az árát. -

zoolee #470 majdnem 15k - az árból? Az szép :) -

#469

#469

GTX 260 és GTX 280 árcsökkenés -

#468

#468

Nem inkább fordítva? HPC-nek lett kiadva. Valahogy el kell adni...

-

#467

#467

Valoszinu ... azert gyart monsterseket. Miert van akkor a 200-as szeria ??? Biztos elterelo hadmuvelet ....

Viccet felre teve valamit nagyon elneztek szerintem nVidia-ek ........... -

Abu85 #466 Főleg HPC-be.

A Physx és a Ray-Scale is ezért lett megvásárolva. A CUDA Folding támogatása is a G200 megjelenésére lett kész.

Az ilyen nagy monolitikus chipekkel a PC gaming piacon nincs esélye az nV-nek, de azt sokan elfelejtik, hogy nem is nagyon akar már itt sikereket. -

#465

#465

ÚÚÚÚÚÚ ember te nagyon el vagy tévedve:)

1. ha nemérdemas a PC-ket játékokhoz igazítani akkor megmondanád ki fogja a Drága konzolotkba kitalálni az ujjab és ujjab trchnológiát stb ha ne lenne PC-s játékk nem lennének ekkora teljesítményű gépek nem lenének ijen VGA-k és akkor ki fejleszt?? ja hohy a sony?? na az meg fejleszt ha el is kezdenek fejleszteni a a konzolgyártók akkkor vehetsz havonta uj konzolt mert nem oylan jók benne hogy rögtön menyen nekik ezért szedik a PC-iparból a cucoat most is. Sóvalvehesz havonta konzolt de ők nem aarják hogy havonta vagyél mert nem vennél és ezért ugy csinálják hogy bővíthető legyen aztán egyre jobban bővítheő és viszaérünk a PC-hez:):) -

#464

#464

Mire is keszult ?? -

Abu85 #463 Egy dolgot a G200 kapcsán elfelejtetek ez a chip nem a deskpot PC-re készült, csak ki lett adva oda is. -

#462

#462

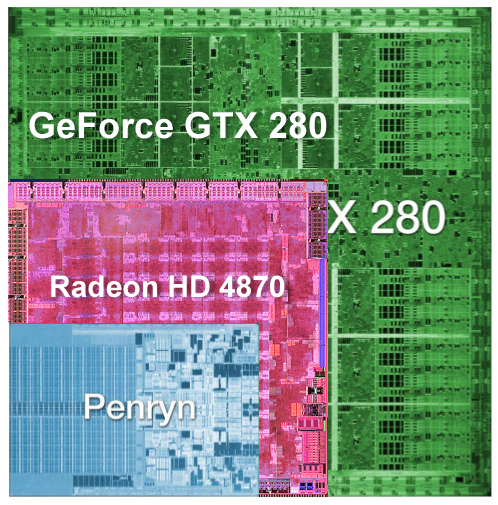

Árban az nvidia nem fog tudni lejjebb menni, ugyanis így is nagy veszteséggel tudja gyártatni a TSMC-vel ezt az őskövület, bazinagy GPU-t:

Max. kiszórja a maradék G92 készleteit haszon nélkül, de a 4k Ati széria fényében épeszű ember nem veszi meg őket, talán csak a hozzád hasonló nvidia-csőlátásúak. -

#461

#461

Oregem te remenytelen vagy. Miert kell alandoan ez a konzol dolgot meglovagolni ??? Minden konzolos kiadasban ugyan ott van mit az aki PC-t hasznal. Mar csak azert is mert minden haztartasban ott figyel egy PC , laptop etc. vagy egy camcorder , fenykepezogep had ne soroljam . Mit csinal a konzoljaval amikor egy DV TYPE-rol le kell szedni a cuccot ... nyalogatja ???? Hadjuk mar ezt az informatikus melle szovegelest es olyan szavak hasznalatat amt 1000 emberbol 5 ert. Beszeljunk a tenyekrol ... a PC multifunkcionalis , mig a konzol csak jatszani valo es kesz. -

Ender Wiggin #460 "Sajnos fogalmad sincs az architektúrák működéséről, így nagyon rosszul látod a dolgokat..."

Valamennyi fogalmam van, de nem ragad el az AMDs ömlengési hév, mert az elmúlt 10 év bőségesen bebizonyította, hogy a maradi technológia sokkal sikeresebb és eladhatóbb, mert egyszerűen a forradalom nem jut el a megfelelő helyre, a programozói környeztbe (minimális támogatás, driverek rosszul optimalizálva).

"Ha érdekel ez a vonal akkor olvass sokat ebben a témakörben és idővel megérted, miért mondta ezt."

Én érdeklődve olvastam azt is, amit te írtál, nem is akarok vitatkozni. De felesleges egy olyan jövőképre alapozni az AMD sikerességének a megjóslását, ami nem is biztos, hogy bekövetkezik (ráadásul azok puffognak nekem elég alpári stílusban, akik végtelenül elfogultak, tehát az objektivitásuk az AMD legendás Thunderbirdjeinek olvadáspontja alatt van mélyen).

Sok olyan grafikai motor volt már, ami nagyon jó, még sem licenszelte senki, mert az nvidia lobbi más irányba terelte a technikát. Ha szigorúan a játékokat nézzük, akkor a PC-k úgy ahogy vannak vesztésre állnak, mert szánalmas teljesítményt nyújtanak, és jóval többe kerülnek, mint egy konzol (és ebből kiderül az is, hogy tök fölösleges a grafikus gyorsítók architektúráján pörögni, mikor a siker kulcsa - csak - nem abban van). Egyelőre.

Más. Hivatalos, hogy az nVidia is csökkenteni fogja a GTX2xx árakat, és ezzel megint veszít az AMD a feltételezett potenciáljából... -

Abu85 #459 Sajnos fogalmad sincs az architektúrák működéséről, így nagyon rosszul látod a dolgokat...

Ha érdekel ez a vonal akkor olvass sokat ebben a témakörben és idővel megérted, miért mondta ezt.

-

Ender Wiggin #458 "De nincs is ATI kártyád akkor mit pofázol hülyeségeket?"

Korábban írtam, hogy 3 PC van a családban, és az egyikben ATi kártya. Sőt korábban is volt ATi-m.

"Ne égesd már magad tovább. 4850 meg a 4870 az mi? Hulladék?"

Szerintem te égeted magad ezzel a stílussal. Az ATi is kb ugyan azt a teljesítményt tudja, mint az nVidia, és azonos fogyasztás mellett (és a Crysis mindkettővel játszhatalan full HD-ban, ha minden sehr hoch). Sok teszt van, én most mondjuk az Anadtechből indulok ki. Idleban sokkal rosszabb a 4870, mint a GTX280. És akkor még nem beszéltünk az X2-es verzióról. Szóval nekem ez semmi pénzt nem ér meg, legyen ATi 60-ért vagy nVidia 100-ért (mondjuk én eddig szinte mindent az usa-ból rendeltem, ahol azért jóval olcsóbb, de még így sem gondolok most PC vásárlásra).

Ha lesz olyan ATi,.ami egyértelmű győztesnek minősíthető, én nem fogok habozni, azt veszem meg az új PC-be, de ez egyelőre nem pálya (inkább egy SLi-s laptop). Amúgy ha ezeket a komolyabb grafikájú játékokat akarja az ember nagyon nagy felbontásban élvezni, akkor sajnos egyelőre a konzol a megfelelő választás (ízlés szerint PS3 vagy X360). A PC-s fejlesztések amúgy is háttérbe szorulnak lassan, mert a többség utál a winfos miatt szívni, meg gondolkodni, csak beteszi a lemezt és már nyomná is...Mi meg a PC-n kapjuk a sok portolt szart, vagy a játszhatalanul magas hardverigényű darabokat (DX9-ben leprogramozva a DX10-es tartalmat, csak kár, hogy ehhez a konzolokban van hardver is, a PC-ken még évekig nem lesz). -

Abu85 #457 Az ID Tech 4 nagyon messze van a mostani motoroktól... Hiába Carmack zsenialítása a Doom 3 alapja elég nehezen kezelhető motor, nem is nagy utána az érdeklődés.

A Frostbite-ot sokan figyelik, mert ez az első csak DX10-re készített motor. Ráadásul iszonyat komoly újításokat vezet be. Az xBox360-as Battlifield: Bad Companyt már ez működteti. -

#456

#456

240W -

#455

#455

Talan 2 ATI annyit fogyaszt mint a GTX280.

Nekem a CF-es konfigom eszik tobbet 20W-al mint a GTX280. Suletlensegeket ne beszelj. -

#454

Engine az U3 és az IDtech.

Valószinűleg nagyon sok JÓ játék jön majd frostbite enginnel.

:))) -

#453

#453

ATI-t kell venned.. Az hülye aki geforce-ot vesz. Az nvidia hülyíti a népet hogy faszán teljesítenek a kártyái oszt egy rakás sz@rt se érnek. -

#452

#452

Szerintem ezt el kellene olvasnod #448. -

AmadeusHU #451 Nem tudja valaki, hogy idén vagy a közeljövőben tervez az nvidia még egy csúcskártyát kiadni? Nem merem még megvenni a gtx280at mert lehet hogy pár hónap múlva kiad annál sokkalta jobbat, erre példa a karácsonykor megjelent 8800gt -

#450

#450

ufffffff .... igy kell ezt csinalni. -

#449

#449

-

Abu85 #448 Elég rossz dolog, hogy nem használjuk a DX10 és DX10.1-es eljárásokat. Alapvetően Crysis-t ostromló gépigényekre lehet így számítani. Az a baj, hogy egy helyben toporgunk, és hasonló eljárásokat használunk most is, mint 2 éve. Ezen a jelenlegi G80 alapú és feltételezhetően a G200 architektúra elve sem fog változtatni. Azért alakítják ki a DX10 és főleg a DX10.1-ben az új eljárásokat, hogy alkalmazkodjanak a grafika fejlődésének írányához. Ezt úgy kell értelmezni, hogy a háromdimenziós grafika fejlődése meglehetősen kötött. Alapvetően ismertek azok a technikák amik a közeljövőben és a távolabbi jövőben használni fognak, de az alkalmazott eljárások addig megváltozhatnak, mert lehet, hogy valaki talált gyorsabb algoritmust ugyanarra a feladatra.

Mondok egy példát, hátha úgy egyszerűbb megérteni. Manapság vagy a nagyon közeli jövőben elterjedt lesz a Parallax Occlusion Mapping (ilyen van a Crysis-ba, az új 3Dmark Vantage-ban) alapú technikák. Alapvetően a technika leképzésére már a DX9 is kínált megoldást, de az akkori karik lassúak voltak hozzá. Ugyan még a mostani VGA-ak sem szerepelnek valami fényesen ennél az effektnél, de már érdemes erőltetni a POM leképzéséhez, így terjed a technika (SLI, CF tulajok örülnek). A csavar ott jön be, hogy a DX10.1 tálal a POM leképzésére egy, az eddigieknél, jóval gyorsabb megvalósítást a LOD utasítások segítségével. Ha az nV támogatná a DX10.1-et akkor a POM vélhetőleg mindenhol LOD utasításokkal lenne létrehozva a jövőben. Ezzel jól járnának a fejlesztők, mert a LOD utasításokkal egyénileg definiált szűréseket lehet alkotni, így a POM nem akasztja majd össze a bajszát az AF szűrésekkel, jó lenne a felhasználóknak, mert a látvány gyakorlatilag ugyanaz, de a sebesség az ésszerű és átgondolt algoritmusnak hála gyorsabb.

Hogy ne csak egy példa legyen ott van még a leképzési fázisok esete. Például a Quake 3-nél úgy volt a renderelés, hogy volt egy fényszámítási fázis, majd egy árnyaló és utána még egy fényszámítási. Nem meglepő a dolog, hogy ez eléggé erőforráspazarló, hiszen kétszer végzünk minden modellen fényszámítást. Ez a példa a Quake 3 utáni években még bonyolultabb lett. Ám a Shader modell segítségével van megoldás a problémára: Deferred Rendering, ez is elterjedt lesz nagyon. A lényege egyszerű, üssük ki a felesleges munkavégzést. Le kell számolni a képet megvilágítás és árnyalás nélkül, majd a kimaradt munkát utólagosan feldolozni több Render Target-be. A Shader Modell elég komplex ahhoz, hogy jó eredményeket lehessen elérni. A probléma az AA-val és a Deferred Rendering fázisokkal van. Az AA már sokszor volt tárgyalva ez az MS sara bele kellett volna tenni a megoldást a DX10-be. A Deferred fázisoknál viszont továbbra is gáz, hogy a GPU nem dolgozhat rajtuk párhuzamosan. A DX10.1-ben ezt emgoldották, így a Deferred Rendering technika leképzéséhez redukálva lett a fázis igények száma, így nőtt a sebesség. Megint jó a fejlesztőnek és a felhasználónak a dolog, mert a programozónak egyszerűbb dolga lesz az optimalizálással és az AA gondok megoldásával, míg a felhasználó örülhet, hogy gyorsabba megkapja ugyanazt az eredményt.

Persze az elméletet folytathatnánk tovább a Cube Map tömbökre is. Egész érdekes dolgokat lehet a technikával leképezni. Természetesen itt is előnyt élvez a DX10.1-es megvalósítás, mert a DX10-ben minden Cube MAP tömböt külön fázisban keleltt számolni, mí a DX10.1-ben párhuzamosan is elvégezhető a feladat a GPU erőforrás kapacítására optimalizálva. Az eredmény ugye megint jó a fejlesztőnek és a felhasználónak, az okok hasonlóak a fentiekhez.

Az, hogy az nV nem támogatja a DX10.1-et és akadályozza az új algoritmusok terjedését csak rossz a fejlesztőknek és a felhasználóknak is. A fejlesztő továbbra is eszeveszetten fog optimalizálni... De minek ugye? Ki jön a program (Crysis) és mindenki leszarozza, hogy egy optimalizálatlan szutyok, a kor szégyene. Pedig jól van optimalizálva, mert amit ki lehetet, kihozták belőle. A felhasználó extra rosszul jár, mert minden évben VGA-t kell vennie.

Egy valaki jár jól, az nV. El tudja adni az új cuccait, az egyre gyengébb PC-s játékipart látva is.

A DX10.1 támogatásra az nv-től nem számíthatunk soha. Egy korszerű DX10.1-es megvalósítás gyökeresen más elvű architektúrát igényelne (kb. olyat, mint az R600-ra építkező rendszerek). Persze nem korszerűen is meg lehet oldani, ezesetben az nV TPC féle felépítése is jó. Alapvetően szükség lenne a Gather 4 támogatásra, ehhez a chipben előforduló mintavételezők számát meg kellene négyszerezni (ez elég sok plusz tranyó). Kisebb változások kellenének a ROP blokk-ok terén, a Blending hatékonyabb hassználatához. Plusz a Multisample Buffer használata mellett nem árt egy optimalizált vezérlés a hatékony AA-hoz.

A G200 igazából egyetlen dolgot épít be, a GPGPU-nál hasznos double-precision-t amit a G200 elméletben 1/8-ad sebességgel végez. Ez tulajdonképpen elég lassú, mert az RV670 1/2-ed sebeséggel csinálja ami jóval hatékonyabb. Itt jön ki az a tervezési irány ami az RV670 alapú chipeket nagyon magas precizítású számításnál iszonyat hatékonnyá teszi.

Üzletileg sem érné meg a DX10.1 támogatás az nV-nek. Egyrészt nem egy esetben olyan face-to-face összehasonlítást eredményezne az új API támogatása a HD Radeonokkal ami kihozná a GF architektúrák gyengeségeit. Nagy adatmennyiséggel dolgozó GS feladatok esetén még az HD3650 is szépen elpicsázzná a régi G80/G92-re épülő chipeket. Másrészt a DX10.1 számtalan helyen egyszerűbb és gyorsabb algoritmusokra ad lehetőséget a fejlesztőknek. Nyilván ezzel a módszerrel csökkenne a játékok gépigénye és az nem tesz jót a jelenleg jól tejelő üzletnek.

Azt már régebben megmondtam, hogy a GF architektúrája nem tudja hosszú távon tartani a lépést a HD Radeonnal. Most jönnek azok a programok ahol magasabb ALU:Tex arányt használnak a fejlesztők, mert a memóriasávszélesség nem elég a Fill-Rate értékek kielégítésére, így elmennek az ALU teljesítmény használata felé. Ezek után lesznek használva masszívan a PipeGS eljárások ahol az nV technikája le van maradva. Bár a G200 ezen sokat javult, nyilván látta az nV is, hogy pár fejlesztőt nem hat meg a G80/G92 képessége, így meg kellett növelni a teljesítményt, még akkor is ha az eléggé pazarló a chip tranzisztorszámára nézve. Jelenleg Emil Persson GI demójában alig teljesít 5 FPS-t a teljes GF8-9 paletta, míg a HD Radeonokból még a 2600 széria is hozza a 20-25FPS-t. Látható, hogy a Frostbite engine-ben is mérföldekkel van lemaradva a 8800GT és a 9600GT a HD3870 mögött a PipeGS teljesítményben. A G200 ezen a területen nagyon sokat javult, a GI demóban 35-40FPS-re képes, ami már R600 szint. -

#447

#447

"A jelen helyzetben sem az ATi sem az nVidia nem készít értékelhető videokártyát."

Ne égesd már magad tovább. 4850 meg a 4870 az mi? Hulladék?

Olcsón van jó teljesítmény. -

#446

#446

"és valljuk meg a 8800GT/GTS árban is jobb, mint a csudaratyi 38xx széria"

De nincs is ATI kártyád akkor mit pofázol hülyeségeket? Nem rosszabb lényegesen a 3870 a 8800GT-nél. Főleg 8.6-os driverrel sokat gyorsult minden. -

Ender Wiggin #445 abu, a dologgal csak az a baj, hogy lassan kiderül, minek a DX10, ha meg lehet oldani mindent DX9-cel is (lásd pl konzolok) és látványos különbség nincs is (ezidáig nem volt olyan játék, ami szebb vagy gyorsabb lett). Mire esetleg elterjed (főként ha nem, hanem mondjuk jön a DX11), addigra a mostani kártyák is megfizethetőek, amik gyorsabbak, mint a 38xx...szóval igazán semmi sem szól a HD3800 mellett. :-D -

Ender Wiggin #444 test drive, igen de sajnos az elmúlt 6-7 év alatt ez a két momentum igen rövid fellángolás volt csak az AMD részéről. De egyébként a korábbi hsz-em egyikében már írtam az FX kontra ATi 9800-széria viszonyáról, úgyhogy nem mondasz ellent bármennyire is szeretnél...:-D

A jelen helyzetben sem az ATi sem az nVidia nem készít értékelhető videokártyát. Szerintem az AMD is sokat fogyaszt, nézzétek meg, idleban majd 40W-tal többet, mint a GTX280. És ez az igazán fontos, mert a nap leghosszabb szakaszát idle-ban tölti a gép, ha netezel, vagy ott hagyod letölteni. Illetve a mai napig ez meg lehetett csinálni, de ilyen fogyasztási értékek mellett jobb venni egy régebbi laptopot és azzal torrentezni (halk és nem fogyaszt)...:-) -

Abu85 #443 frostbite teljesítmény

Nemrég lett licencelhető a frostbite engine, ez az első full DX10-es motor. Nem hivatalos eredmények kiszivárgásával lehet azért látni, hogy nem is olyan ratyi az a HD3800 széria. Persze aki nem nézi át a neten terjengő architektúra elemzéseket annak ez váratlan eredmény.

Erősen hasonlít a dolog a HL2 féle FX eredmények szivárgásához. -

#442

#442

jaja anno egymagosoknál fasza volt hogy a 3200+ az 3200+ volt AMDnél x))

de az az idő elmúlt :S

AMD hozza az új (és jó) architektúrákat, aztán mikor Intel vagy nVidia már gyenge a régiek "tuningjával" akkor majd átveszi tőlük. -

![[HUN]FaTaL [HUN]FaTaL](https://media.sg.hu/forum/avatars/10557508481320070594.gif) #441

#441

A mindiggel vitatkoznék. Az FX széria idejében bizony az ATi szétpicsázta az nvidiat, ugyanez vonatkozik az intelre a P4 korszak elején. -

Ender Wiggin #440 Felesleges azzal érvelni, "ez lesz, meg az lesz", fingunk sincs mi lesz akár 1 v 2 hónap múlva.

Az AMD mindig is brilliáns architektúrájú dolgokat készített, az ATi-s korszakában sincs ez másként. De az Intel és az nVidia erővel (órajellel) mindig le tudta verni. És ez meglátszik a piaci szereposztáson is. Hiába volt mindig is kedvezőbb áron ATi, a többség akkor is az nVidiát vette, mert gyorsabb volt (és valljuk meg a 8800GT/GTS árban is jobb, mint a csudaratyi 38xx széria). Év vége felé talán már kiderül egy két piaci jelentésből, hogy az AMD aggresszív árpolitikája képes-e kompnezálni a teljesítmény/driver problémákat.

Én személy szerint egyik cég új gen kártyáiban sem látom a megváltást, ezért noha új PC-t akartam venni, inkább kivárok, és laptopot veszek, amivel persze nem fogok Crysis-ozni (de úszintén, azt egy csúcs PC-vel sem tudnék). -

![[HUN]FaTaL [HUN]FaTaL](https://media.sg.hu/forum/avatars/10557508481320070594.gif) #439

#439

Tessék egy bolti ár

34284 Ft

Miről is beszélsz?:)