Balázs Richárd

Robotok az etika csapdájában

Alan Winfield, a Bristoli Robot Laboratórium kutatója etikai csapdát épített egy robotnak. Az eredmény őt is megdöbbentette.

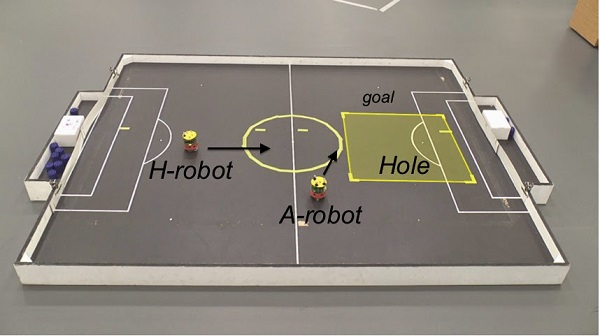

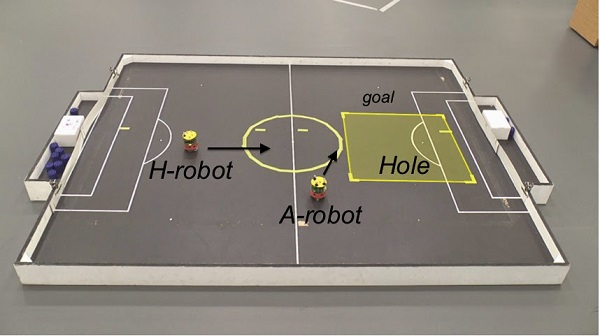

A kísérletben Winfield és munkatársai arra programoztak egy robotot, hogy megóvjon más, az embereket helyettesítő automatákat egy balesettől. Ez gyakorlatilag az Isaac Asimov által megalkotott robotika első törvényének leegyszerűsített változata, mely szerint egy robotnak nem szabad kárt okoznia emberi lényben, vagy tétlenül tűrnie, hogy emberi lény bármilyen kárt szenvedjen.

Eleinte a robot sikerrel teljesítette feladatát, ahogy az embert megszemélyesítő eszköz a baleset helyszínéül szolgáló lyuk felé tartott, a robot odasietett és meglökve letérítette a másik gépet az útvonaláról, ami így nem esett bele a lyukba. Azonban amikor a kutatók beállítottak egy másik automatát, ami az elsővel egyszerre gördült ugyanazon lyuk felé, a robotnak döntenie kellett. Volt, amikor sikerült megmentenie az egyik „embert", miközben a másik a lyukban végezte, sőt néha mindkettőt eltérítette, a kísérletek közel felénél azonban annyi időt töltött a döntéshozatallal, hogy mindkét „ember” elpusztult.

Winfield „etikai zombinak" titulálta robotját, aminek nincs igazi választása. Bár megmenthet másokat egy beprogramozott magatartási kódex szerint, nem érti a tettei mögötti indítékot. Winfield elismerte, míg egykor úgy gondolta, egy robot képtelen az erkölcsi döntésekre, ma ott tart, hogy egyáltalán nem tud választ adni erre a kérdésre, pedig ahogy a robotok egyre jobban beépülnek mindennapi életünkbe, egyre nagyobb szükség van a válaszra.

Egy önmagát vezető autónak például egy napon mérlegelnie kell saját utasainak biztonságát egy velük szembe robogó motoroséval, vagy a kitérési útvonalon haladó gyalogoséval szemben. A megoldás a hadviselésre tervezett robotoktól indulhat ki. Ronald Arkin, az atlantai Georgia Műszaki Egyetem számítógéptudósának algoritmus-sorozata, az "erkölcsi vezér" segít okos döntéseket hozni a harcmezőn. A rendszert szimulált csatákban tesztelte, bizonyítva, hogy a programot futtató drónok képesek eldönteni, hogy lőjenek, vagy ne lőjenek, illetve a régi erkölcsi szabálynak eleget téve megpróbálják minimalizálni az áldozatokat egy iskola, vagy egy kórház közelében.

Arkin szerint a katonai robotok esetében ez sokkal könnyebb, mivel a szabályok is egyértelműek. "A háború törvényei több ezer éve ismertek és egyezményekbe vannak foglalva" - mondta, hozzátéve, hogy az emberi katonákkal ellentétben a gépeket nem befolyásolja az érzelem és nem szegik meg ezeket a szabályokat.

"Amikor a robotok erkölcseiről beszélünk, az nagyban azokról a robotokról szól, amik kellően megszabott keretek közötti cselekvésre fejlesztettek ki" - mondta Wendell Wallach, a Morális gépek című könyv szerzője, aki szerint a Winfield-éhez hasonló kísérletek segíthetnek lefektetni az összetettebb etikai viselkedés alapjait. "Ha sikerül működővé tenni olyan környezetekben is, ahol nem ismerjük pontosan az összes körülményt, amikkel találkozhatnak, az elképesztő távlatokat nyithat az alkalmazásukban" - összegzett.

A kísérletben Winfield és munkatársai arra programoztak egy robotot, hogy megóvjon más, az embereket helyettesítő automatákat egy balesettől. Ez gyakorlatilag az Isaac Asimov által megalkotott robotika első törvényének leegyszerűsített változata, mely szerint egy robotnak nem szabad kárt okoznia emberi lényben, vagy tétlenül tűrnie, hogy emberi lény bármilyen kárt szenvedjen.

Eleinte a robot sikerrel teljesítette feladatát, ahogy az embert megszemélyesítő eszköz a baleset helyszínéül szolgáló lyuk felé tartott, a robot odasietett és meglökve letérítette a másik gépet az útvonaláról, ami így nem esett bele a lyukba. Azonban amikor a kutatók beállítottak egy másik automatát, ami az elsővel egyszerre gördült ugyanazon lyuk felé, a robotnak döntenie kellett. Volt, amikor sikerült megmentenie az egyik „embert", miközben a másik a lyukban végezte, sőt néha mindkettőt eltérítette, a kísérletek közel felénél azonban annyi időt töltött a döntéshozatallal, hogy mindkét „ember” elpusztult.

Winfield „etikai zombinak" titulálta robotját, aminek nincs igazi választása. Bár megmenthet másokat egy beprogramozott magatartási kódex szerint, nem érti a tettei mögötti indítékot. Winfield elismerte, míg egykor úgy gondolta, egy robot képtelen az erkölcsi döntésekre, ma ott tart, hogy egyáltalán nem tud választ adni erre a kérdésre, pedig ahogy a robotok egyre jobban beépülnek mindennapi életünkbe, egyre nagyobb szükség van a válaszra.

Egy önmagát vezető autónak például egy napon mérlegelnie kell saját utasainak biztonságát egy velük szembe robogó motoroséval, vagy a kitérési útvonalon haladó gyalogoséval szemben. A megoldás a hadviselésre tervezett robotoktól indulhat ki. Ronald Arkin, az atlantai Georgia Műszaki Egyetem számítógéptudósának algoritmus-sorozata, az "erkölcsi vezér" segít okos döntéseket hozni a harcmezőn. A rendszert szimulált csatákban tesztelte, bizonyítva, hogy a programot futtató drónok képesek eldönteni, hogy lőjenek, vagy ne lőjenek, illetve a régi erkölcsi szabálynak eleget téve megpróbálják minimalizálni az áldozatokat egy iskola, vagy egy kórház közelében.

Arkin szerint a katonai robotok esetében ez sokkal könnyebb, mivel a szabályok is egyértelműek. "A háború törvényei több ezer éve ismertek és egyezményekbe vannak foglalva" - mondta, hozzátéve, hogy az emberi katonákkal ellentétben a gépeket nem befolyásolja az érzelem és nem szegik meg ezeket a szabályokat.

"Amikor a robotok erkölcseiről beszélünk, az nagyban azokról a robotokról szól, amik kellően megszabott keretek közötti cselekvésre fejlesztettek ki" - mondta Wendell Wallach, a Morális gépek című könyv szerzője, aki szerint a Winfield-éhez hasonló kísérletek segíthetnek lefektetni az összetettebb etikai viselkedés alapjait. "Ha sikerül működővé tenni olyan környezetekben is, ahol nem ismerjük pontosan az összes körülményt, amikkel találkozhatnak, az elképesztő távlatokat nyithat az alkalmazásukban" - összegzett.