Gyurkity Péter

Intel: 32 magos lesz az első Larrabee

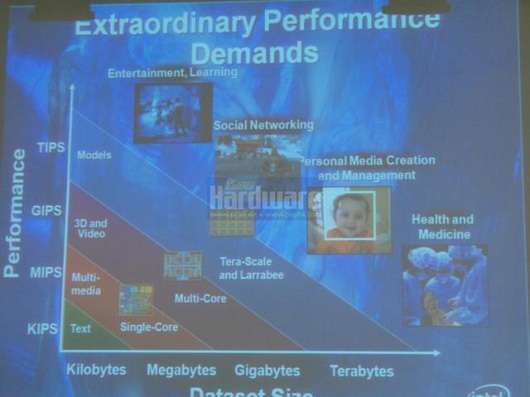

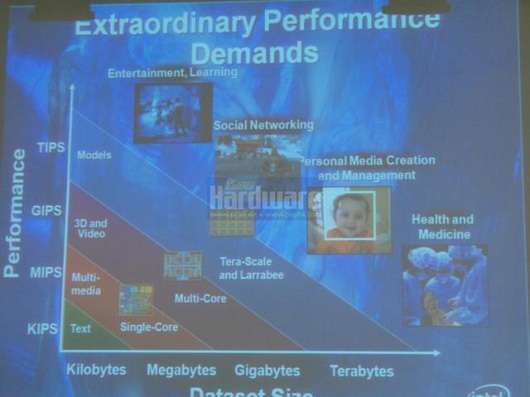

A processzorgyártó megtörte a csendet, és egy rendezvényen bemutatta az első képet a készülő sokmagos fejlesztéséről, amely az nVidia és az AMD grafikus vezérlőivel veszi majd fel a versenyt.

A németországi rendezvényen megjelent lapoknak köszönhetően az interneten is felbukkant a bemutatott kép (valamint további illusztrációk), amely az első változatot ábrázolja. Szakértők megvizsgálták a képet, és több fontos megállapítást tettek azzal kapcsolatban. Ebből megtudhatjuk, hogy nagyjából mire is számíthatunk a hivatalos rajt pillanatában.

A cég mindössze annyit árult el, hogy a debütálásra idén nem kerül majd sor, ehelyett 2010 elején dobják piacra az első elkészült példányokat. A képek alapján a külső szakértők szerint ez egy 32 magos változat lesz, amely kizárólag x86 chipekre épül (amelyeket úgynevezett vector processing egységekkel párosítanak). A Larrabee emellett megosztott gyorsítótárra támaszkodhat majd, a kapcsolódó memória kezeléséért pedig a széleken elhelyezett vezérlők lesznek majd felelősek. Arról pedig már korábban megjelentek hírek, hogy május végén érkezik a Parallel Studio névre keresztelt grafikai fejlesztői eszköztár, erről azonban most nem beszéltek.

Az Intel saját hivatalos oldalán már idejekorán elérhetővé tette a Larrabee részletes dokumentációját, amelyből jól látható, hogy akár 64 magos felépítéssel is számolhatunk - a magok száma tehát széles skálán mozoghat, ez a különböző változatokon lehet majd 8, 16, 32, 48, illetve 64. A cég arra tett ígéretet, hogy a programozhatóság terén a kényelemre és a rugalmasságra építenek, itt szerintük sikerül majd a jelenleg használt dedikált grafikus vezérlőkhöz képest jobb szintet elérni.

Az első generáció a High-K 45 nanométeres gyártástechnológiával készül, 32 nanométerre (és nyilván több magra) később váltanak majd.

A németországi rendezvényen megjelent lapoknak köszönhetően az interneten is felbukkant a bemutatott kép (valamint további illusztrációk), amely az első változatot ábrázolja. Szakértők megvizsgálták a képet, és több fontos megállapítást tettek azzal kapcsolatban. Ebből megtudhatjuk, hogy nagyjából mire is számíthatunk a hivatalos rajt pillanatában.

A cég mindössze annyit árult el, hogy a debütálásra idén nem kerül majd sor, ehelyett 2010 elején dobják piacra az első elkészült példányokat. A képek alapján a külső szakértők szerint ez egy 32 magos változat lesz, amely kizárólag x86 chipekre épül (amelyeket úgynevezett vector processing egységekkel párosítanak). A Larrabee emellett megosztott gyorsítótárra támaszkodhat majd, a kapcsolódó memória kezeléséért pedig a széleken elhelyezett vezérlők lesznek majd felelősek. Arról pedig már korábban megjelentek hírek, hogy május végén érkezik a Parallel Studio névre keresztelt grafikai fejlesztői eszköztár, erről azonban most nem beszéltek.

Az Intel saját hivatalos oldalán már idejekorán elérhetővé tette a Larrabee részletes dokumentációját, amelyből jól látható, hogy akár 64 magos felépítéssel is számolhatunk - a magok száma tehát széles skálán mozoghat, ez a különböző változatokon lehet majd 8, 16, 32, 48, illetve 64. A cég arra tett ígéretet, hogy a programozhatóság terén a kényelemre és a rugalmasságra építenek, itt szerintük sikerül majd a jelenleg használt dedikált grafikus vezérlőkhöz képest jobb szintet elérni.

Az első generáció a High-K 45 nanométeres gyártástechnológiával készül, 32 nanométerre (és nyilván több magra) később váltanak majd.