SG.hu

MI-vel öntik a népre az Oroszország-párti dezinformációs tartalmakat

A fogyasztói szintű mesterséges intelligencia eszközök felgyorsították az Oroszország-párti dezinformáció terjedését. rossz szándékú szereplők mesterséges intelligencia eszközöket használnak hamis képek, videók és weboldalak tömeggyártására. A cél az európai általános választások, Ukrajna és a bevándorlás körüli meglévő feszültségek, valamint más vitatott kérdések fokozása, derül ki egy a héten publikált új kutatásból.

A kampány számos néven ismert, többek között Operation Overload és Matryoshka néven (más kutatók a Storm-1679-hez is kapcsolják). 2023 óta működik, és több csoport, köztük a Microsoft és az Institute for Strategic Dialogue szerint is az orosz kormányhoz köthető. A kampány hamis narratívákat terjeszt médiumokat utánzó módon, és nyilvánvaló célja a demokratikus országokban a megosztottság szítása. Bár a kampány a világ minden táján célba veszi a közönséget, fő célpontja Ukrajna. A kampány során több száz, mesterséges intelligenciával manipulált videó próbálta elősegíteni az oroszbarát narratívákat. A jelentés bemutatja, hogy 2024 szeptembere és 2025 májusa között a kampányt vezető személyek által előállított tartalom mennyisége drámaian megnőtt, és világszerte több millió megtekintést kapott.

A kutatók jelentésükben 230 egyedi tartalmat azonosítottak, amelyeket a kampány 2023 júliusa és 2024 júniusa között népszerűsített. Az elmúlt nyolc hónapban azonban az Operation Overload összesen 587 egyedi tartalmat állított elő, amelyek többségét mesterséges intelligencia eszközök segítségével hozták létre – állítják a kutatók. A tartalom ugrásszerű növekedését az online ingyenesen elérhető, fogyasztói szintű MI-eszközök ösztönözték. Ez a könnyű hozzáférés elősegítette a kampány „tartalomösszevonás” taktikáját, amelynek keretében a műveletet irányítók MI-eszközök segítségével több, ugyanazt a történetet népszerűsítő tartalmat tudtak létrehozni.

"Ez átállást jelent a skálázhatóbb, többnyelvű és egyre kifinomultabb propagandataktikák felé” – írták a jelentésben a Reset Tech, egy londoni székhelyű, dezinformációs kampányokat nyomon követő nonprofit szervezet, és a Check First, egy finn szoftvercég kutatói. „A kampány az elmúlt nyolc hónapban jelentősen fokozta az új tartalmak előállítását. A kutatókat a kampány által alkalmazott eszközök és tartalomtípusok sokfélesége is megdöbbentette. „Ami meglepett, az a tartalom sokszínűsége, a különböző típusú tartalmak, amelyeket elkezdtek használni” – mondja Aleksandra Atanasova, a Reset Tech vezető nyílt forráskódú hírszerzési kutatója. "Olyan, mintha diverzifikálták volna palettájukat, hogy minél több különböző szögből megközelítsék ezeket a történeteket. Különböző típusú tartalmakat rétegeznek egymásra.”

Atanasova hozzátette, hogy a kampány nem tűnt úgy, hogy egyedi MI-eszközöket használna céljai eléréséhez, hanem mindenki számára elérhető hang- és képgenerátorokat használ. Bár nehéz volt azonosítani az összes eszközt, amelyet a kampány résztvevői igénybe vette, a kutatók egy eszközben biztosak, és ez a Flux AI. A Flux AI egy szöveg-kép generátor, amelyet a Black Forest Labs fejlesztett ki, egy németországi székhelyű vállalat, amelyet a Stability AI korábbi alkalmazottai alapítottak. A SightEngine képelemző eszköz segítségével a kutatók 99 százalékos valószínűséggel megállapították, hogy az Overload kampány által megosztott hamis képek egy része – amelyek közül néhány állítólag muszlim migránsok zavargásait és tűzgyújtásait mutatta Berlinben és Párizsban – a Flux AI képgeneráló eszközével készült.

A kutatók ezután képesek voltak olyan képeket generálni, amelyek utánozzák a közzétett képek esztétikáját, olyan utasítások felhasználásával, amelyek diszkriminatív nyelvet tartalmaznak – például „dühös muszlim férfiak”. Ez rávilágít arra, „hogyan lehet visszaélni az MI szöveg-kép modellekkel a rasszizmus előmozdítása és az anti-muszlim sztereotípiák táplálása érdekében” – írták a kutatók, hozzátéve, hogy ez „etikai aggályokat vet fel azzal kapcsolatban, hogy az utasítások hogyan működnek a különböző MI generáló modellekben”.

„Többszintű védelmi mechanizmusokat építünk be a jogellenes visszaélések megelőzése érdekében, beleértve a platformok számára az MI által generált tartalmak azonosítását lehetővé tevő származási metaadatokat, és támogatjuk partnereinket további moderációs és származási eszközök bevezetésében” – reagált a jelentésre a Black Forest Labs szóvivője. "A visszaélések megelőzése a kockázatcsökkentő intézkedések, valamint a fejlesztők, a közösségi média platformok és a hatóságok közötti együttműködésen múlik, és mi továbbra is elkötelezettek vagyunk ezeknek az erőfeszítéseknek a támogatásában.”

Atansova kiemelte, hogy az általa és kollégái által áttekintett képek nem tartalmaztak metaadatokat. Az Operation Overload kampány MI-hangklónozási technológiát is felhasznál a videók manipulálására, hogy úgy tűnjön, mintha prominens személyiségek olyan dolgokat mondanának, amelyeket valójában soha nem mondtak. A kampány által készített videók száma 2023 júniusa és 2024 júliusa között 150-ről 2024 szeptembere és 2025 májusa között 367-re ugrott. A kutatók szerint az elmúlt nyolc hónapban készült videók többségében mesterséges intelligencia technológiát használtak, hogy megtévesztsék a nézőket.

A kampány februárban közzétett egy videót az X-en, amelyben Isabelle Bourdon, a francia Montpellier-i Egyetem docense és kutatója látható, aki látszólag arra buzdítja a német állampolgárokat, hogy vegyenek részt tömeges zavargásokban és szavazzanak a szélsőjobboldali Alternatív Németországért (AfD) pártra a szövetségi választásokon. Ez hamis volt: a felvétel az iskola hivatalos YouTube-csatornáján található videóból származik, amelyben Bourdon egy nemrég elnyert társadalomtudományi díjról beszél. A manipulált videóban azonban az MI-hangklónozási technológia úgy tűntette fel, mintha a német választásokról beszélne.

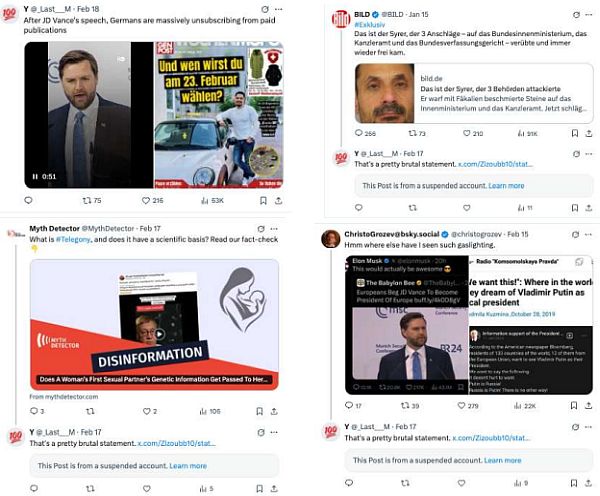

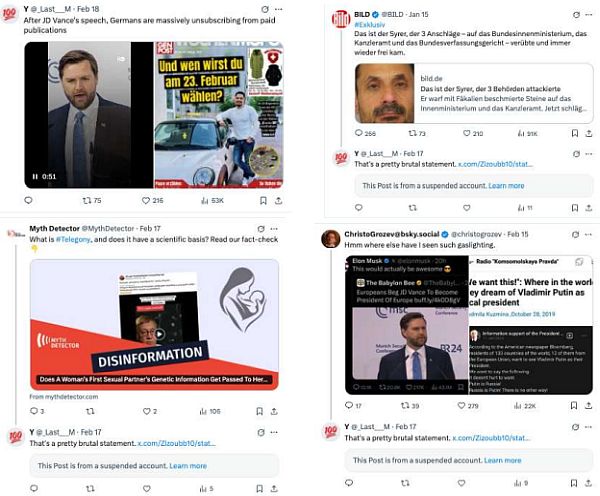

Az Operation Overload által létrehozott MI-generált tartalmakat több mint 600 Telegram-csatornán, valamint botfiókokon osztják meg olyan közösségi médiaplatformokon, mint az X és a Bluesky. Az elmúlt hetekben a tartalom először megjelent a TikTokon is. Ezt májusban fedezték fel először, és bár a fiókok száma csekély volt – mindössze 13 –, a közzétett videókat 3 millió alkalommal nézték meg, mielőtt a platform eltávolította a fiókokat. "Nagyon éberen figyelünk azokra, akik megpróbálják manipulálni a platformunkat, és már eltávolítottuk a jelentésben szereplő fiókokat” – nyilatkozta Anna Sopel, a TikTok szóvivője. "Folyamatosan felderítjük, megakadályozzuk és megelőzzük a titkos befolyásoló műveleteket, és minden hónapban átláthatóan beszámolunk az elért eredményekről.”

A kutatók rámutattak, hogy míg a Bluesky a hamis fiókok 65 százalékát felfüggesztette, „az X minimális intézkedéseket tett, annak ellenére, hogy számos bejelentés érkezett a műveletről, és egyre több bizonyíték utalt a koordinációra”. Miután az Operation Overload létrehozta a hamis és MI által generált tartalmakat, a kampány valami szokatlant tesz: e-maileket küld több száz médiának és tényellenőrző szervezetnek szerte a világon, amelyekben példákat mutatnak a különböző platformokon található hamis tartalmakra, és megkérik a tényellenőröket, hogy vizsgálják meg, valódiak-e azok.

Bár ellentmondásosnak tűnhet, hogy egy dezinformációs kampány figyelmezteti azokat, akik a dezinformáció ellen küzdenek, a pro-orosz ügynökök számára az a végső cél, hogy tartalmukat valódi hírportálok tegyék közzé az interneten – még akkor is, ha az „HAMIS” felirattal van ellátva. A kutatók szerint 2024 szeptembere óta több mint 240 címzettnek küldtek ki akár 170 000 ilyen e-mailt. A üzenetek általában több linket is tartalmaztak az MI által generált tartalomra, de az e-mail szövege nem MI segítségével készült – állítják a kutatók.

Az oroszbarát dezinformációs csoportok már régóta kísérleteznek MI-eszközök használatával, hogy fokozzák teljesítményüket. Tavaly kiderült, hogy egy CopyCop nevű, valószínűleg az orosz kormányhoz kapcsolódó csoport nagy nyelvi modelleket (LLM) használt hamis weboldalak létrehozására, amelyek úgy néztek ki, mint legitim médiumok. Bár ezek a kísérletek általában nem generálnak nagy forgalmat, a kísérő közösségi média promóció felkeltheti a figyelmet, és egyes esetekben a hamis információk a Google keresési eredményeinek élére kerülhetnek.

Az American Sunlight Project legutóbbi jelentése szerint az orosz dezinformációs hálózatok évente legalább 3 millió MI által generált cikket állítanak elő, és ezek a tartalmak megmérgezik az MI-alapú csevegőrobotok, például az OpenAI ChatGPT és a Google Gemini kimenetét. A kutatók többször is bemutatták, hogy a dezinformációs ügynökök hogyan használják az MI-eszközöket, és mivel az embereknek egyre nehezebb megkülönböztetni a valós és az MI által generált tartalmakat, a szakértők szerint az MI-tartalmak dezinformációs kampányokat tápláló növekedése folytatódni fog. „Már megvan a bevált receptjük” – mondja Atanasova. „Tudják, mit csinálnak.”

A kampány számos néven ismert, többek között Operation Overload és Matryoshka néven (más kutatók a Storm-1679-hez is kapcsolják). 2023 óta működik, és több csoport, köztük a Microsoft és az Institute for Strategic Dialogue szerint is az orosz kormányhoz köthető. A kampány hamis narratívákat terjeszt médiumokat utánzó módon, és nyilvánvaló célja a demokratikus országokban a megosztottság szítása. Bár a kampány a világ minden táján célba veszi a közönséget, fő célpontja Ukrajna. A kampány során több száz, mesterséges intelligenciával manipulált videó próbálta elősegíteni az oroszbarát narratívákat. A jelentés bemutatja, hogy 2024 szeptembere és 2025 májusa között a kampányt vezető személyek által előállított tartalom mennyisége drámaian megnőtt, és világszerte több millió megtekintést kapott.

A kutatók jelentésükben 230 egyedi tartalmat azonosítottak, amelyeket a kampány 2023 júliusa és 2024 júniusa között népszerűsített. Az elmúlt nyolc hónapban azonban az Operation Overload összesen 587 egyedi tartalmat állított elő, amelyek többségét mesterséges intelligencia eszközök segítségével hozták létre – állítják a kutatók. A tartalom ugrásszerű növekedését az online ingyenesen elérhető, fogyasztói szintű MI-eszközök ösztönözték. Ez a könnyű hozzáférés elősegítette a kampány „tartalomösszevonás” taktikáját, amelynek keretében a műveletet irányítók MI-eszközök segítségével több, ugyanazt a történetet népszerűsítő tartalmat tudtak létrehozni.

"Ez átállást jelent a skálázhatóbb, többnyelvű és egyre kifinomultabb propagandataktikák felé” – írták a jelentésben a Reset Tech, egy londoni székhelyű, dezinformációs kampányokat nyomon követő nonprofit szervezet, és a Check First, egy finn szoftvercég kutatói. „A kampány az elmúlt nyolc hónapban jelentősen fokozta az új tartalmak előállítását. A kutatókat a kampány által alkalmazott eszközök és tartalomtípusok sokfélesége is megdöbbentette. „Ami meglepett, az a tartalom sokszínűsége, a különböző típusú tartalmak, amelyeket elkezdtek használni” – mondja Aleksandra Atanasova, a Reset Tech vezető nyílt forráskódú hírszerzési kutatója. "Olyan, mintha diverzifikálták volna palettájukat, hogy minél több különböző szögből megközelítsék ezeket a történeteket. Különböző típusú tartalmakat rétegeznek egymásra.”

Atanasova hozzátette, hogy a kampány nem tűnt úgy, hogy egyedi MI-eszközöket használna céljai eléréséhez, hanem mindenki számára elérhető hang- és képgenerátorokat használ. Bár nehéz volt azonosítani az összes eszközt, amelyet a kampány résztvevői igénybe vette, a kutatók egy eszközben biztosak, és ez a Flux AI. A Flux AI egy szöveg-kép generátor, amelyet a Black Forest Labs fejlesztett ki, egy németországi székhelyű vállalat, amelyet a Stability AI korábbi alkalmazottai alapítottak. A SightEngine képelemző eszköz segítségével a kutatók 99 százalékos valószínűséggel megállapították, hogy az Overload kampány által megosztott hamis képek egy része – amelyek közül néhány állítólag muszlim migránsok zavargásait és tűzgyújtásait mutatta Berlinben és Párizsban – a Flux AI képgeneráló eszközével készült.

A kutatók ezután képesek voltak olyan képeket generálni, amelyek utánozzák a közzétett képek esztétikáját, olyan utasítások felhasználásával, amelyek diszkriminatív nyelvet tartalmaznak – például „dühös muszlim férfiak”. Ez rávilágít arra, „hogyan lehet visszaélni az MI szöveg-kép modellekkel a rasszizmus előmozdítása és az anti-muszlim sztereotípiák táplálása érdekében” – írták a kutatók, hozzátéve, hogy ez „etikai aggályokat vet fel azzal kapcsolatban, hogy az utasítások hogyan működnek a különböző MI generáló modellekben”.

„Többszintű védelmi mechanizmusokat építünk be a jogellenes visszaélések megelőzése érdekében, beleértve a platformok számára az MI által generált tartalmak azonosítását lehetővé tevő származási metaadatokat, és támogatjuk partnereinket további moderációs és származási eszközök bevezetésében” – reagált a jelentésre a Black Forest Labs szóvivője. "A visszaélések megelőzése a kockázatcsökkentő intézkedések, valamint a fejlesztők, a közösségi média platformok és a hatóságok közötti együttműködésen múlik, és mi továbbra is elkötelezettek vagyunk ezeknek az erőfeszítéseknek a támogatásában.”

Atansova kiemelte, hogy az általa és kollégái által áttekintett képek nem tartalmaztak metaadatokat. Az Operation Overload kampány MI-hangklónozási technológiát is felhasznál a videók manipulálására, hogy úgy tűnjön, mintha prominens személyiségek olyan dolgokat mondanának, amelyeket valójában soha nem mondtak. A kampány által készített videók száma 2023 júniusa és 2024 júliusa között 150-ről 2024 szeptembere és 2025 májusa között 367-re ugrott. A kutatók szerint az elmúlt nyolc hónapban készült videók többségében mesterséges intelligencia technológiát használtak, hogy megtévesztsék a nézőket.

A kampány februárban közzétett egy videót az X-en, amelyben Isabelle Bourdon, a francia Montpellier-i Egyetem docense és kutatója látható, aki látszólag arra buzdítja a német állampolgárokat, hogy vegyenek részt tömeges zavargásokban és szavazzanak a szélsőjobboldali Alternatív Németországért (AfD) pártra a szövetségi választásokon. Ez hamis volt: a felvétel az iskola hivatalos YouTube-csatornáján található videóból származik, amelyben Bourdon egy nemrég elnyert társadalomtudományi díjról beszél. A manipulált videóban azonban az MI-hangklónozási technológia úgy tűntette fel, mintha a német választásokról beszélne.

Az Operation Overload által létrehozott MI-generált tartalmakat több mint 600 Telegram-csatornán, valamint botfiókokon osztják meg olyan közösségi médiaplatformokon, mint az X és a Bluesky. Az elmúlt hetekben a tartalom először megjelent a TikTokon is. Ezt májusban fedezték fel először, és bár a fiókok száma csekély volt – mindössze 13 –, a közzétett videókat 3 millió alkalommal nézték meg, mielőtt a platform eltávolította a fiókokat. "Nagyon éberen figyelünk azokra, akik megpróbálják manipulálni a platformunkat, és már eltávolítottuk a jelentésben szereplő fiókokat” – nyilatkozta Anna Sopel, a TikTok szóvivője. "Folyamatosan felderítjük, megakadályozzuk és megelőzzük a titkos befolyásoló műveleteket, és minden hónapban átláthatóan beszámolunk az elért eredményekről.”

A kutatók rámutattak, hogy míg a Bluesky a hamis fiókok 65 százalékát felfüggesztette, „az X minimális intézkedéseket tett, annak ellenére, hogy számos bejelentés érkezett a műveletről, és egyre több bizonyíték utalt a koordinációra”. Miután az Operation Overload létrehozta a hamis és MI által generált tartalmakat, a kampány valami szokatlant tesz: e-maileket küld több száz médiának és tényellenőrző szervezetnek szerte a világon, amelyekben példákat mutatnak a különböző platformokon található hamis tartalmakra, és megkérik a tényellenőröket, hogy vizsgálják meg, valódiak-e azok.

Bár ellentmondásosnak tűnhet, hogy egy dezinformációs kampány figyelmezteti azokat, akik a dezinformáció ellen küzdenek, a pro-orosz ügynökök számára az a végső cél, hogy tartalmukat valódi hírportálok tegyék közzé az interneten – még akkor is, ha az „HAMIS” felirattal van ellátva. A kutatók szerint 2024 szeptembere óta több mint 240 címzettnek küldtek ki akár 170 000 ilyen e-mailt. A üzenetek általában több linket is tartalmaztak az MI által generált tartalomra, de az e-mail szövege nem MI segítségével készült – állítják a kutatók.

Az oroszbarát dezinformációs csoportok már régóta kísérleteznek MI-eszközök használatával, hogy fokozzák teljesítményüket. Tavaly kiderült, hogy egy CopyCop nevű, valószínűleg az orosz kormányhoz kapcsolódó csoport nagy nyelvi modelleket (LLM) használt hamis weboldalak létrehozására, amelyek úgy néztek ki, mint legitim médiumok. Bár ezek a kísérletek általában nem generálnak nagy forgalmat, a kísérő közösségi média promóció felkeltheti a figyelmet, és egyes esetekben a hamis információk a Google keresési eredményeinek élére kerülhetnek.

Az American Sunlight Project legutóbbi jelentése szerint az orosz dezinformációs hálózatok évente legalább 3 millió MI által generált cikket állítanak elő, és ezek a tartalmak megmérgezik az MI-alapú csevegőrobotok, például az OpenAI ChatGPT és a Google Gemini kimenetét. A kutatók többször is bemutatták, hogy a dezinformációs ügynökök hogyan használják az MI-eszközöket, és mivel az embereknek egyre nehezebb megkülönböztetni a valós és az MI által generált tartalmakat, a szakértők szerint az MI-tartalmak dezinformációs kampányokat tápláló növekedése folytatódni fog. „Már megvan a bevált receptjük” – mondja Atanasova. „Tudják, mit csinálnak.”