SG.hu

Meghamisította a BBC hírét az Apple MI-összefoglalója

A sajtószabadság védelmezői felszólították az Apple-t, hogy dobja ki "éretlen” generatív MI-rendszerét, amely helytelenül foglalta össze a BBC egyik hírközlését. Az Apple rendszere tévesen azt állította, hogy a UnitedHealthcare vezérigazgatója, Luigi Mangione öngyilkos lett.

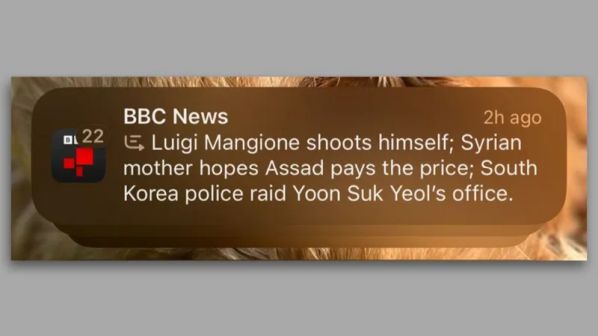

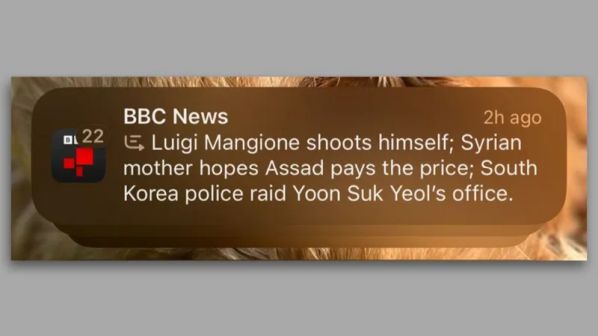

Mint arról december elején beszámoltunk, merényletet követtek el a United Healthcare vezérigazgatója. Brian Thompson ellen, a gyilkossággal pedig egy 26 éves férfit, Luigi Mangione-t vádolja az ügyészség. Erről a BBC is beszámolt, és a brit közszolgálati média hírét az Apple mesterséges intelligenciájának sikerült úgy összefoglalnia, hogy "Luigi Mangione lelőtte magát". A Riporterek Határok Nélkül (RSF) civil szervezet szerint mindez újabb bizonyíték arra, hogy a mesterséges intelligencia nem képes megbízhatóan információt előállítani a nyilvánosság számára. Az Egyesült Királyságban december 11-én indult szolgáltatásnak kevesebb mint 48 órára volt szüksége a nagy nyilvánosság előtt elkövetett hibához.

„Ez a baleset rávilágít arra, hogy az MI-rendszerek képtelenek minőségi információkat közzétenni, még akkor is, ha azok újságírói forrásokon alapulnak” - közölte az RSF. „A mesterséges intelligenciával működő rendszerek valószínűségi működése automatikusan kizárja őket, mint a hírmédia megbízható technológiája, amelyet a nagyközönségnek szánt megoldásokban lehet használni.” Mivel nem megbízhatóan pontos, az RSF szerint a mesterséges intelligencia nem használható ilyen célokra, és arra kérte az Apple-t, hogy vegye ki a funkciót az operációs rendszereiből. "A tényeket nem lehet kockadobással eldönteni” - mondta Vincent Berthier, az RSF technológiai és újságírói osztályának vezetője. „Az RSF felszólítja az Apple-t, hogy felelősségteljesen járjon el, és távolítsa el ezt a funkciót. A médiának tulajdonított hamis információk automatizált előállítása csapást mér a lapok hitelességére, és veszélyezteti a nyilvánosságnak az aktuális ügyekről való megbízható tájékoztatáshoz való jogát” - tette hozzá Berthier.

Nem tudni, hogy az Apple hogyan tervezi kezelni a problémát. A BBC saját panaszt nyújtott be, de az Apple nem volt hajlandó nyilvánosan nyilatkozni a brit műsorszolgáltatónak az ügyben. A BBC szerint ráadásul nem ez az első eset, hogy az Apple mesterséges intelligenciával készített összefoglalói tévesen közöltek híreket. Egy novemberi Apple MI összefoglaló - amelyet a ProPublica riportere osztott meg - a Benjamin Netanjahu izraeli miniszterelnök letartóztatásáról szóló hírt (ami nem történt meg) a New York Timesnak tulajdonított, ami arra utal, hogy az Apple Intelligence sorozatosan félreolvashatja a lapok szalagcímeit. A Google mesterséges intelligencia keresési eredményeit is becsapták már, hogy csaló linkeket jelenítsenek meg, az arra ösztönözte a felhasználókat, hogy ragasszanak sajtot a pizzára és egyenek köveket.

Berthier kijelentette: „Az európai mesterséges intelligenciáról szóló törvény - annak ellenére, hogy a világon a legfejlettebb jogszabály ezen a területen - nem minősítette az információt generáló mesterséges intelligenciákat magas kockázatú rendszereknek, így egy kritikus jogi vákuum jött létre. Ezt a joghézagot azonnal be kell tölteni”.

Mint arról december elején beszámoltunk, merényletet követtek el a United Healthcare vezérigazgatója. Brian Thompson ellen, a gyilkossággal pedig egy 26 éves férfit, Luigi Mangione-t vádolja az ügyészség. Erről a BBC is beszámolt, és a brit közszolgálati média hírét az Apple mesterséges intelligenciájának sikerült úgy összefoglalnia, hogy "Luigi Mangione lelőtte magát". A Riporterek Határok Nélkül (RSF) civil szervezet szerint mindez újabb bizonyíték arra, hogy a mesterséges intelligencia nem képes megbízhatóan információt előállítani a nyilvánosság számára. Az Egyesült Királyságban december 11-én indult szolgáltatásnak kevesebb mint 48 órára volt szüksége a nagy nyilvánosság előtt elkövetett hibához.

„Ez a baleset rávilágít arra, hogy az MI-rendszerek képtelenek minőségi információkat közzétenni, még akkor is, ha azok újságírói forrásokon alapulnak” - közölte az RSF. „A mesterséges intelligenciával működő rendszerek valószínűségi működése automatikusan kizárja őket, mint a hírmédia megbízható technológiája, amelyet a nagyközönségnek szánt megoldásokban lehet használni.” Mivel nem megbízhatóan pontos, az RSF szerint a mesterséges intelligencia nem használható ilyen célokra, és arra kérte az Apple-t, hogy vegye ki a funkciót az operációs rendszereiből. "A tényeket nem lehet kockadobással eldönteni” - mondta Vincent Berthier, az RSF technológiai és újságírói osztályának vezetője. „Az RSF felszólítja az Apple-t, hogy felelősségteljesen járjon el, és távolítsa el ezt a funkciót. A médiának tulajdonított hamis információk automatizált előállítása csapást mér a lapok hitelességére, és veszélyezteti a nyilvánosságnak az aktuális ügyekről való megbízható tájékoztatáshoz való jogát” - tette hozzá Berthier.

Nem tudni, hogy az Apple hogyan tervezi kezelni a problémát. A BBC saját panaszt nyújtott be, de az Apple nem volt hajlandó nyilvánosan nyilatkozni a brit műsorszolgáltatónak az ügyben. A BBC szerint ráadásul nem ez az első eset, hogy az Apple mesterséges intelligenciával készített összefoglalói tévesen közöltek híreket. Egy novemberi Apple MI összefoglaló - amelyet a ProPublica riportere osztott meg - a Benjamin Netanjahu izraeli miniszterelnök letartóztatásáról szóló hírt (ami nem történt meg) a New York Timesnak tulajdonított, ami arra utal, hogy az Apple Intelligence sorozatosan félreolvashatja a lapok szalagcímeit. A Google mesterséges intelligencia keresési eredményeit is becsapták már, hogy csaló linkeket jelenítsenek meg, az arra ösztönözte a felhasználókat, hogy ragasszanak sajtot a pizzára és egyenek köveket.

Berthier kijelentette: „Az európai mesterséges intelligenciáról szóló törvény - annak ellenére, hogy a világon a legfejlettebb jogszabály ezen a területen - nem minősítette az információt generáló mesterséges intelligenciákat magas kockázatú rendszereknek, így egy kritikus jogi vákuum jött létre. Ezt a joghézagot azonnal be kell tölteni”.