Berta Sándor

"A mesterséges intelligencia jobb a természetes butaságnál"

Félni nem kell a mesterséges intelligenciától, de nem árt tisztában lenni a kockázataival. Az emberrel együtt való cselekvés a lényeg.

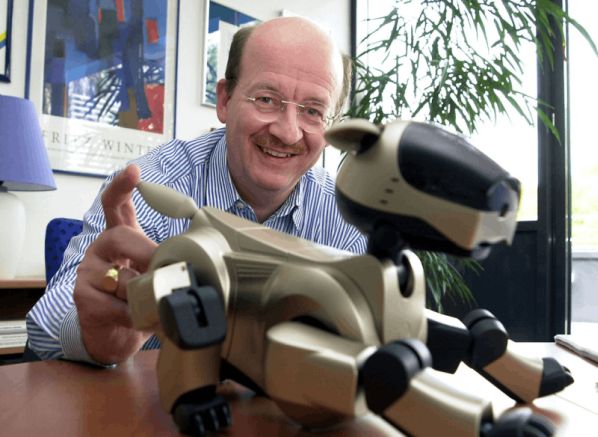

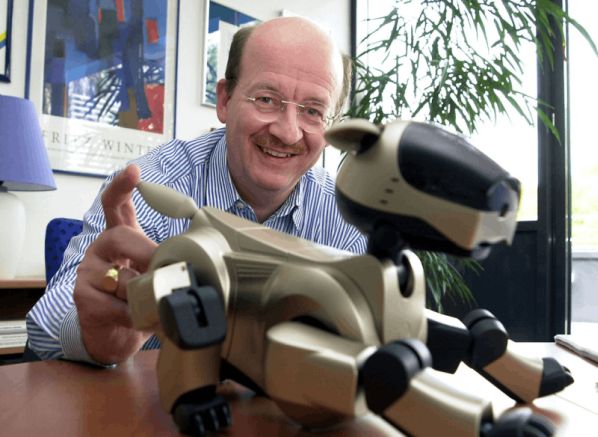

Wolfgang Wahlster professzor, a Német Mesterséges Intelligencia Kutató Központ (DFKI) vezetője és tudományos igazgatója nem osztja a humanoid, öntanuló rendszerek fejlesztésével kapcsolatos félelmeket, ugyanakkor úgy véli, tökéletesen tisztában van a lehetséges kockázatokkal. A DFKI jelenleg a német szövetségi kutatási minisztérium által támogatott Hysociatea projekt keretében azt vizsgálja, hogy a jövőben miként lehet szoftverrendszerek segítségével koordinálni a hibrid, vagyis emberekből és különböző robotokból álló csoportok munkáját. A fő kérdés az, hogy egy ilyen hibrid csapat hogyan osztja fel az eltérő részfeladatokat.

"Több mint 30 éve kutatom a mesterséges intelligenciát. Amennyiben valaki ilyen hosszú ideig foglalkozik a témával, akkor az összes kutatási siker ellenére egyre jobban tiszteli az emberi intelligenciát. A mesterséges intelligencia minden tudományos áttörése ellenére tudományos-fantasztikum azt hangoztatni, hogy ezek a rendszerek képesek lennének önállósulni és az emberiséget fenyegetni. Mindez azért nem következhet be, mert a gépi tanulás alapvetően különbözik az emberi tanulástól." - jelentette ki Wolfgang Wahlster.

"A mesterséges intelligenciánál semmiképpen sem arról van szó, hogy az emberi viselkedést - az erősségeivel és a gyengeségeivel együtt - tökéletes módon lemásoljuk, hanem azt szeretnénk, hogy a mesterséges intelligencia asszisztáljon az embereknek ott, ahol ez ésszerű. Miután az internetes cégek erősen preferálják a befektetéseket ezen a területen, ezért gyorsan kialakul egy lufi, ez a már többször megtörtént. E ciklusok során gyakran olyan populista gondolatokat terjesztő személyek is megszólalnak, akiket a nemzetközi kutatóközösség nem ismer el. Ezek az emberek elérik, hogy túlzott elvárások legyenek bizonyos technológiákkal szemben. Most is egy hasonló lufit akarnak felfújni."

"Pedig a mesterséges intelligencia akár "jövőbeli informatikaként" is felfogható, amely az informatika avantgárd része. A mesterséges intelligencia a számos részterületén elért előrelépések ellenére még nagyon messze van egy ember mindennapos teljesítményétől, miközben különleges területeken viszont megelőzi az embert. Én azt vallom, hogy a mesterséges intelligencia jobb a természetes butaságnál. Miután a bizonytalanság, a szociális és az érzelmi tényezők komoly szerepet játszanak a problémák megoldásában, ezért a mai mesterséges intelligencia rendszereknek alig van esélyük. Így például a mai rendszerek nem tudnának megtanítani egy gyereket kerékpározni. Mindezektől függetlenül nagyon komolyan kell venni az öntanuló rendszerekkel kapcsolatos kockázatokat."

A professzor közölte, hogy a kockázatokat elsősorban azzal lehet lecsökkenteni, ha a kutatók gőzerővel növelik a mesterséges intelligencia rendszerek megbízhatóságát, biztonságát és rugalmasságát, főleg, ha ezeket a megoldásokat kritikus vezérlésekhez vagy döntésekhez használják. Ezért veszélyesek a kibertámadások, mert e szoftverrendszerek rendkívüli összetettsége miatt az anomáliák nem tűnnek fel azonnal. Másrészt ezek a mesterséges intelligencia megoldások is majdnem mindig tartalmaznak hibákat, így 100 százalékig sosem lehet megbízni bennük.

Az elmúlt években a kutatások során sikerült olyan nagy teljesítményű rendszereket kifejleszteni, amelyek legalább a kis, de biztonsági szempontból kritikus moduloknak segítenek a programozói hibák kiszűrésében. Sosem lehet azonban kizárni a mesterséges intelligencia technológiákkal való visszaélés veszélyét. "A jövő gyáraiban az ember és a gép kiegészíti egymást. A munkások az intelligens gyárakban az együttműködésre képes könnyű építési robotok új generációjával fognak együtt dolgozni. A folyamat során szükség lesz a szerepek világos felosztására: az ember asszisztensként fogja használni a robotot."

Az ABB cég emberrel együttműködésre képes robotja

"Amíg az eddigi robotok nehéz munkát végeztek, addig az új modellek az emberekkel való közvetlen kapcsolattartásra vannak kifejlesztve, de nem árthatnak nekik, sőt, még ki is térnek az útjukból a közös munka során. Fontos, hogy az ember értse, hogy egy gép mit és miért csinál, de ez ellentétesen is igaz. Egy Watson szuperszámítógép bizonyos kezelési módszereket javasolhat egy orvosnak és tanácsot adhat egy veszélyes műtét elvégzésére, de egy ilyen esetben a rendszernek el kell tudnia magyaráznia az orvosnak, hogy miként jutott erre az álláspontra. Kollégaként kell viselkednie és nem elég csupán azt mondania, hogy 10 millió adatot elemzett ki. Sokkal inkább érthető formában kell ismertetnie a javaslatait, hogy az orvos megbízzon azokban."

"Az ilyen rendszereket, mint a Watson nem szabad orákulumokként kezelnünk, hanem csak fontos információforrásokként, amelyekkel szemben meg kell tartanunk a szükséges kritikus távolságot. A rendszernek meg kell győznie az orvost, ami egy komoly műszaki kihívás" - szögezte le a DFKI vezetője.

Wolfgang Wahlster professzor, a Német Mesterséges Intelligencia Kutató Központ (DFKI) vezetője és tudományos igazgatója nem osztja a humanoid, öntanuló rendszerek fejlesztésével kapcsolatos félelmeket, ugyanakkor úgy véli, tökéletesen tisztában van a lehetséges kockázatokkal. A DFKI jelenleg a német szövetségi kutatási minisztérium által támogatott Hysociatea projekt keretében azt vizsgálja, hogy a jövőben miként lehet szoftverrendszerek segítségével koordinálni a hibrid, vagyis emberekből és különböző robotokból álló csoportok munkáját. A fő kérdés az, hogy egy ilyen hibrid csapat hogyan osztja fel az eltérő részfeladatokat.

"Több mint 30 éve kutatom a mesterséges intelligenciát. Amennyiben valaki ilyen hosszú ideig foglalkozik a témával, akkor az összes kutatási siker ellenére egyre jobban tiszteli az emberi intelligenciát. A mesterséges intelligencia minden tudományos áttörése ellenére tudományos-fantasztikum azt hangoztatni, hogy ezek a rendszerek képesek lennének önállósulni és az emberiséget fenyegetni. Mindez azért nem következhet be, mert a gépi tanulás alapvetően különbözik az emberi tanulástól." - jelentette ki Wolfgang Wahlster.

"A mesterséges intelligenciánál semmiképpen sem arról van szó, hogy az emberi viselkedést - az erősségeivel és a gyengeségeivel együtt - tökéletes módon lemásoljuk, hanem azt szeretnénk, hogy a mesterséges intelligencia asszisztáljon az embereknek ott, ahol ez ésszerű. Miután az internetes cégek erősen preferálják a befektetéseket ezen a területen, ezért gyorsan kialakul egy lufi, ez a már többször megtörtént. E ciklusok során gyakran olyan populista gondolatokat terjesztő személyek is megszólalnak, akiket a nemzetközi kutatóközösség nem ismer el. Ezek az emberek elérik, hogy túlzott elvárások legyenek bizonyos technológiákkal szemben. Most is egy hasonló lufit akarnak felfújni."

"Pedig a mesterséges intelligencia akár "jövőbeli informatikaként" is felfogható, amely az informatika avantgárd része. A mesterséges intelligencia a számos részterületén elért előrelépések ellenére még nagyon messze van egy ember mindennapos teljesítményétől, miközben különleges területeken viszont megelőzi az embert. Én azt vallom, hogy a mesterséges intelligencia jobb a természetes butaságnál. Miután a bizonytalanság, a szociális és az érzelmi tényezők komoly szerepet játszanak a problémák megoldásában, ezért a mai mesterséges intelligencia rendszereknek alig van esélyük. Így például a mai rendszerek nem tudnának megtanítani egy gyereket kerékpározni. Mindezektől függetlenül nagyon komolyan kell venni az öntanuló rendszerekkel kapcsolatos kockázatokat."

A professzor közölte, hogy a kockázatokat elsősorban azzal lehet lecsökkenteni, ha a kutatók gőzerővel növelik a mesterséges intelligencia rendszerek megbízhatóságát, biztonságát és rugalmasságát, főleg, ha ezeket a megoldásokat kritikus vezérlésekhez vagy döntésekhez használják. Ezért veszélyesek a kibertámadások, mert e szoftverrendszerek rendkívüli összetettsége miatt az anomáliák nem tűnnek fel azonnal. Másrészt ezek a mesterséges intelligencia megoldások is majdnem mindig tartalmaznak hibákat, így 100 százalékig sosem lehet megbízni bennük.

Az elmúlt években a kutatások során sikerült olyan nagy teljesítményű rendszereket kifejleszteni, amelyek legalább a kis, de biztonsági szempontból kritikus moduloknak segítenek a programozói hibák kiszűrésében. Sosem lehet azonban kizárni a mesterséges intelligencia technológiákkal való visszaélés veszélyét. "A jövő gyáraiban az ember és a gép kiegészíti egymást. A munkások az intelligens gyárakban az együttműködésre képes könnyű építési robotok új generációjával fognak együtt dolgozni. A folyamat során szükség lesz a szerepek világos felosztására: az ember asszisztensként fogja használni a robotot."

Az ABB cég emberrel együttműködésre képes robotja

"Amíg az eddigi robotok nehéz munkát végeztek, addig az új modellek az emberekkel való közvetlen kapcsolattartásra vannak kifejlesztve, de nem árthatnak nekik, sőt, még ki is térnek az útjukból a közös munka során. Fontos, hogy az ember értse, hogy egy gép mit és miért csinál, de ez ellentétesen is igaz. Egy Watson szuperszámítógép bizonyos kezelési módszereket javasolhat egy orvosnak és tanácsot adhat egy veszélyes műtét elvégzésére, de egy ilyen esetben a rendszernek el kell tudnia magyaráznia az orvosnak, hogy miként jutott erre az álláspontra. Kollégaként kell viselkednie és nem elég csupán azt mondania, hogy 10 millió adatot elemzett ki. Sokkal inkább érthető formában kell ismertetnie a javaslatait, hogy az orvos megbízzon azokban."

"Az ilyen rendszereket, mint a Watson nem szabad orákulumokként kezelnünk, hanem csak fontos információforrásokként, amelyekkel szemben meg kell tartanunk a szükséges kritikus távolságot. A rendszernek meg kell győznie az orvost, ami egy komoly műszaki kihívás" - szögezte le a DFKI vezetője.