SG.hu

Saját chipeket fejlesztett a Microsoft

A Microsoft saját, egyedi MI-chipet épített, amely nagyméretű nyelvi modellek betanítására használható, és potenciálisan elkerülhetővé teszi a költséges Nvidia-függőséget. A Microsoft saját Arm-alapú CPU-t is épített a felhőalapú munkaterhelésekhez. Mindkét egyedi szilíciumchipet az Azure adatközpontok működtetésére tervezték, és felkészítik a vállalatot és céges ügyfeleit az MI-ban gazdag jövőre.

A Microsoft Azure Maia MI chipje és az Arm-alapú Azure Cobalt CPU 2024-ben érkezik. Idén megugrott a kereslet az Nvidia H100 GPU-jai iránt, amelyeket széles körben használnak generatív képi eszközök és nagyméretű nyelvi modellek képzésére és működtetésére. Olyan nagy a kereslet ezek iránt a GPU-k iránt, hogy egyes példányokért már több mint 40 000 dollárt is elkértek az eBay-en. Mindkét lapka házon belül készül, a teljes felhőszerver stack mélyreható átdolgozásával kombinálva a teljesítmény, az energiafelhasználás és a költségek optimalizálása érdekében. "Újragondoljuk a felhőinfrastruktúrát az MI korszakára, és szó szerint minden rétegét optimalizáljuk" - magyarázta Rani Borkar, a Microsoft Azure hardverrendszerek és infrastruktúra részlegének vezetője.

"A Microsoftnak valójában hosszú múltja van a szilíciumfejlesztésben" - mondja Borkar. A Microsoft több mint 20 évvel ezelőtt instruálta az Xbox lapkájának fejlesztését és a Surface készülékekhez is partnerségben fejlesztett chipeket. "Ezek az erőfeszítések erre a tapasztalatra épülnek. 2017-ben kezdtük el a felhő hardver stack architektúráját kialakítani, és ezen az úton haladtunk tovább új, egyedi chipjeink megépítéséhez."

Az Azure Cobalt CPU nevét a kék pigmentről kapta. A 128 magos chip az Arm Neoverse CSS dizájnra épül, és a Microsoft számára lett testre szabva. Az Azure általános felhőszolgáltatásainak működtetésére tervezték. "Sokat foglalkoztunk azzal, hogy ne csak nagy teljesítményű legyen, hanem az energiagazdálkodásra is odafigyeljünk" - magyarázza Borkar. "Nagyon tudatos tervezési döntéseket hoztunk, beleértve a teljesítmény és az energiafogyasztás magonkénti és minden egyes virtuális gépen történő szabályozásának lehetőségét."

A Microsoft jelenleg olyan folyamatokon teszteli a Cobalt CPU-t, mint a Microsoft Teams és az SQL szerver, és a tervek szerint jövőre virtuális gépeket bocsát az ügyfelek rendelkezésére különböző feladatokhoz. Bár Borkar nem akart közvetlen összehasonlítást tenni az Amazon AWS-en elérhető Graviton 3 szervereivel, de szerinte a Microsoft által az Azure-hoz jelenleg használt Arm-alapú szerverekhez képest érezhető teljesítménynövekedés várható. "A kezdeti tesztjeink azt mutatják, hogy a teljesítmény akár 40 százalékkal jobb, mint a jelenleg kereskedelmi Arm szervereket használó adatközpontjainkban" - mondta Borkar. A Microsoft egyelőre nem osztotta meg a teljes rendszerspecifikációt és a benchmarkokat.

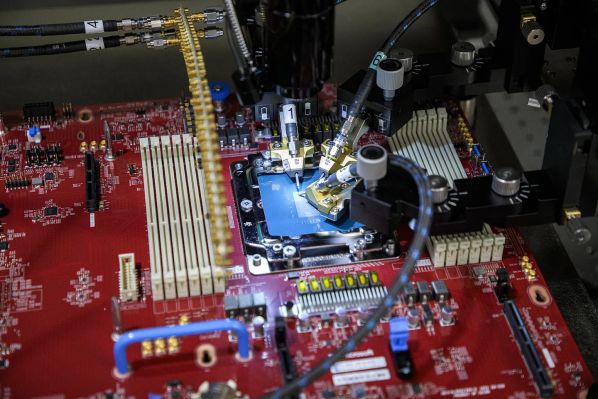

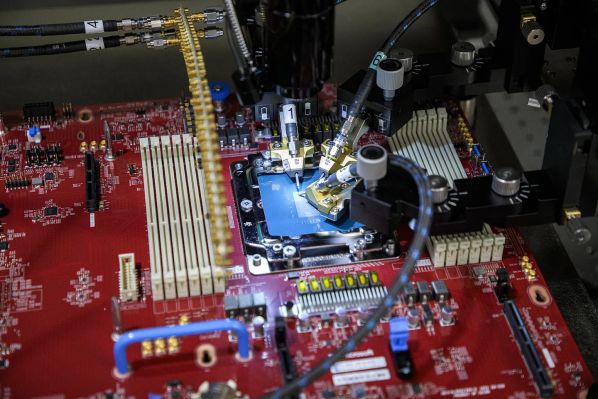

A Microsoft Azure Cobalt rendszerének tesztelése

A Microsoft Maia 100 MI-gyorsítója egy fényes kék csillagról kapta a nevét. Felhőalapú MI-feladatok végrehajtására tervezték, például nagyméretű nyelvi modellek képzésére és következtetésre. Ezt fogják használni a vállalat legnagyobb MI-munkáinál az Azure-on, beleértve az OpenAI-val kötött több milliárd dolláros partnerség egyes részeit, ahol a Microsoft az OpenAI összes terhelését működteti. A szoftveróriás együttműködött az OpenAI-val a Maia tervezési és tesztelési fázisában. "Izgatottak voltunk, amikor a Microsoft először megosztotta a Maia chip terveit, és együtt dolgoztunk a finomításon és a modelljeinkkel való tesztelésen" - mondta Sam Altman, az OpenAI vezérigazgatója. "Az Azure végponttól végpontig tartó MI-architektúrája, amelyet most a Maia segítségével a szilíciumig optimalizáltunk, megnyitja az utat a még alkalmasabb modellek képzése előtt, és olcsóbbá teszi ezeket a modelleket ügyfeleink számára."

A Microsoft tagja annak a csoportnak, amelyben az AMD, az Arm, az Intel, a Meta, az Nvidia és a Qualcomm is részt vesz, és amely az MI-modellek adatformátumainak következő generációját szabványosítja. A Microsoft az Open Compute Project (OCP) együttműködő és nyílt munkájára épít, hogy teljes rendszereket igazítson a mesterséges intelligencia igényeihez.

A TSMC által 5 nanométeres technológiával gyártott Maia 105 milliárd tranzisztort tartalmaz - ez mintegy 30 százalékkal kevesebb, mint az AMD MI300X AI GPU-ban található 153 milliárd. "A Maia támogatja a 8 bitesnél kisebb adattípusok, az MX adattípusok első implementációját, a hardver és a szoftver közös tervezése érdekében" - mondta Borkar. "Ez segít nekünk a gyorsabb modellképzési és következtetési idők támogatásában. A Maia az első folyadékhűtéses szerverprocesszor, amelyet a Microsoft épített" - árulta el Borkar. "A cél az volt, hogy nagyobb sűrűségű szervereket tegyünk lehetővé nagyobb hatékonyság mellett. Mivel a teljes stacket újragondoljuk, minden réteget újra elővettünk, így ezek a rendszerek elférnek a jelenlegi adatközpontjaink alapterületén."

Ez kulcsfontosságú a Microsoft számára, mert az MI-kiszolgálókat anélkül akarja feljavítani, hogy azok a világ különböző pontjain lévő adatközpontokban több helyet igényelnének. A Microsoft egy egyedi racket épített a Maia szerverlapok elhelyezésére, kiegészítve egy "segéd" folyadékhűtővel, amely úgy működik, mint egy puccos játék PC-ben található hűtőborda. Az MX adattípusok megosztása mellett a Microsoft a rack dizájnját is megosztja partnereivel, hogy azok más rendszerekben is használhassák. A Maia chipek dizájnjait azonban nem osztják meg szélesebb körben, azokat a Microsoft házon belül tartja.

A Maia 100 jelenleg a GPT 3.5 Turbón tesztelés alatt áll, amely ugyanaz a modell, amely a ChatGPT-t, a Bing AI munkaterheléseket és a GitHub Copilotot is működteti. A Microsoft a telepítés korai fázisában van, és a Cobalthoz hasonlóan egyelőre nem hajlandó pontos Maia specifikációkat vagy teljesítmény-összehasonlító teszteket közzétenni. Ez megnehezíti annak megfejtését, hogy a Maia pontosan hogyan viszonyul majd az Nvidia népszerű H100 GPU-jához, a nemrég bejelentett H200-hoz, vagy akár az AMD legújabb MI300X-éhez. Borkar nem akart összehasonlításokról beszélni, ehelyett megismételte, hogy az Nvidia-val és az AMD-vel való partnerségek továbbra is kulcsfontosságúak az Azure MI-felhő jövője szempontjából. "Abban a léptékben, amelyben a felhő működik, nagyon fontos, hogy a rendszer minden rétegét optimalizáljuk és integráljuk, hogy maximalizáljuk a teljesítményt, hogy diverzifikáljuk az ellátási láncot, és őszintén szólva, hogy az ügyfeleinknek infrastrukturális választási lehetőséget adjunk" - mondta Borkar.

A Maia 100 szerverszekrénye és hűtése

Az ellátási láncok diverzifikációja fontos a Microsoft számára, különösen akkor, amikor az Nvidia jelenleg az MI szerverchipek legfontosabb beszállítója, és a vállalatok versenyben vannak azért, hogy megvehessék ezeket a chipeket. Becslések szerint az OpenAI-nak több mint 30 000 régebbi Nvidia A100 GPU-ra volt szüksége a ChatGPT kereskedelmi forgalomba hozatalához, így a Microsoft saját chipjei segíthetnek csökkenteni az MI költségeit ügyfelei számára. A Microsoft ezeket a chipeket a saját Azure felhőalapú munkaterheléséhez fejlesztette ki, nem pedig azért, hogy másoknak eladja, mint az Nvidia, az AMD, az Intel és a Qualcomm. "Én ezt inkább kiegészítőnek tekintem, nem pedig versenytársnak velük" - szögezte le Borkar. "Ma már az Intel és az AMD is jelen van a felhőalapú számítási rendszerünkben. Ezek a partnerek nagyon fontosak az infrastruktúránk szempontjából, és csak választási lehetőséget akarunk biztosítani ügyfeleinknek."

A Maia 100 és a Cobalt 100 elnevezés arra utal, hogy a Microsoft már tervezi ezeknek a chipeknek a második generációs változatait. "Ez egy sorozat, nem csak 100 és kész. De nem fogjuk közzétenni az útiterveinket" - mondja Borkar. Egyelőre nem világos, hogy a Microsoft milyen ütemezéssel fogja szállítani a Maia és a Cobalt új verzióit, de az MI fejlődési sebességét tekintve nem lennék meglepve, ha a Maia 100 utódja az Nvidia H200-as bejelentéséhez hasonló ütemben (kb. 20 hónap) érkezne. A kulcs most az lesz, hogy a Microsoft milyen gyorsan lépteti működésbe a Maia-t és hogy ezek a chipek hogyan befolyásolják majd az MI-felhőszolgáltatások használatának árazását. A Microsoft egyelőre nem hajlandó beszélni az új szerverárképzésről, de a vállalat már csendben elindította a Microsoft 365 Copilot szolgáltatását, amely 30 dolláros havi prémiumot jelent felhasználónként. A Copilot for Microsoft 365 egyelőre csak a Microsoft legnagyobb ügyfeleire korlátozódik, a vállalati felhasználóknak legalább 300 felhasználót kell vállalniuk ahhoz, hogy felkerüljenek az új, mesterséges intelligenciával működő Office-asszisztens várólistájára.

A Microsoft Azure Maia MI chipje és az Arm-alapú Azure Cobalt CPU 2024-ben érkezik. Idén megugrott a kereslet az Nvidia H100 GPU-jai iránt, amelyeket széles körben használnak generatív képi eszközök és nagyméretű nyelvi modellek képzésére és működtetésére. Olyan nagy a kereslet ezek iránt a GPU-k iránt, hogy egyes példányokért már több mint 40 000 dollárt is elkértek az eBay-en. Mindkét lapka házon belül készül, a teljes felhőszerver stack mélyreható átdolgozásával kombinálva a teljesítmény, az energiafelhasználás és a költségek optimalizálása érdekében. "Újragondoljuk a felhőinfrastruktúrát az MI korszakára, és szó szerint minden rétegét optimalizáljuk" - magyarázta Rani Borkar, a Microsoft Azure hardverrendszerek és infrastruktúra részlegének vezetője.

"A Microsoftnak valójában hosszú múltja van a szilíciumfejlesztésben" - mondja Borkar. A Microsoft több mint 20 évvel ezelőtt instruálta az Xbox lapkájának fejlesztését és a Surface készülékekhez is partnerségben fejlesztett chipeket. "Ezek az erőfeszítések erre a tapasztalatra épülnek. 2017-ben kezdtük el a felhő hardver stack architektúráját kialakítani, és ezen az úton haladtunk tovább új, egyedi chipjeink megépítéséhez."

Az Azure Cobalt CPU nevét a kék pigmentről kapta. A 128 magos chip az Arm Neoverse CSS dizájnra épül, és a Microsoft számára lett testre szabva. Az Azure általános felhőszolgáltatásainak működtetésére tervezték. "Sokat foglalkoztunk azzal, hogy ne csak nagy teljesítményű legyen, hanem az energiagazdálkodásra is odafigyeljünk" - magyarázza Borkar. "Nagyon tudatos tervezési döntéseket hoztunk, beleértve a teljesítmény és az energiafogyasztás magonkénti és minden egyes virtuális gépen történő szabályozásának lehetőségét."

A Microsoft jelenleg olyan folyamatokon teszteli a Cobalt CPU-t, mint a Microsoft Teams és az SQL szerver, és a tervek szerint jövőre virtuális gépeket bocsát az ügyfelek rendelkezésére különböző feladatokhoz. Bár Borkar nem akart közvetlen összehasonlítást tenni az Amazon AWS-en elérhető Graviton 3 szervereivel, de szerinte a Microsoft által az Azure-hoz jelenleg használt Arm-alapú szerverekhez képest érezhető teljesítménynövekedés várható. "A kezdeti tesztjeink azt mutatják, hogy a teljesítmény akár 40 százalékkal jobb, mint a jelenleg kereskedelmi Arm szervereket használó adatközpontjainkban" - mondta Borkar. A Microsoft egyelőre nem osztotta meg a teljes rendszerspecifikációt és a benchmarkokat.

A Microsoft Azure Cobalt rendszerének tesztelése

A Microsoft Maia 100 MI-gyorsítója egy fényes kék csillagról kapta a nevét. Felhőalapú MI-feladatok végrehajtására tervezték, például nagyméretű nyelvi modellek képzésére és következtetésre. Ezt fogják használni a vállalat legnagyobb MI-munkáinál az Azure-on, beleértve az OpenAI-val kötött több milliárd dolláros partnerség egyes részeit, ahol a Microsoft az OpenAI összes terhelését működteti. A szoftveróriás együttműködött az OpenAI-val a Maia tervezési és tesztelési fázisában. "Izgatottak voltunk, amikor a Microsoft először megosztotta a Maia chip terveit, és együtt dolgoztunk a finomításon és a modelljeinkkel való tesztelésen" - mondta Sam Altman, az OpenAI vezérigazgatója. "Az Azure végponttól végpontig tartó MI-architektúrája, amelyet most a Maia segítségével a szilíciumig optimalizáltunk, megnyitja az utat a még alkalmasabb modellek képzése előtt, és olcsóbbá teszi ezeket a modelleket ügyfeleink számára."

A Microsoft tagja annak a csoportnak, amelyben az AMD, az Arm, az Intel, a Meta, az Nvidia és a Qualcomm is részt vesz, és amely az MI-modellek adatformátumainak következő generációját szabványosítja. A Microsoft az Open Compute Project (OCP) együttműködő és nyílt munkájára épít, hogy teljes rendszereket igazítson a mesterséges intelligencia igényeihez.

A TSMC által 5 nanométeres technológiával gyártott Maia 105 milliárd tranzisztort tartalmaz - ez mintegy 30 százalékkal kevesebb, mint az AMD MI300X AI GPU-ban található 153 milliárd. "A Maia támogatja a 8 bitesnél kisebb adattípusok, az MX adattípusok első implementációját, a hardver és a szoftver közös tervezése érdekében" - mondta Borkar. "Ez segít nekünk a gyorsabb modellképzési és következtetési idők támogatásában. A Maia az első folyadékhűtéses szerverprocesszor, amelyet a Microsoft épített" - árulta el Borkar. "A cél az volt, hogy nagyobb sűrűségű szervereket tegyünk lehetővé nagyobb hatékonyság mellett. Mivel a teljes stacket újragondoljuk, minden réteget újra elővettünk, így ezek a rendszerek elférnek a jelenlegi adatközpontjaink alapterületén."

Ez kulcsfontosságú a Microsoft számára, mert az MI-kiszolgálókat anélkül akarja feljavítani, hogy azok a világ különböző pontjain lévő adatközpontokban több helyet igényelnének. A Microsoft egy egyedi racket épített a Maia szerverlapok elhelyezésére, kiegészítve egy "segéd" folyadékhűtővel, amely úgy működik, mint egy puccos játék PC-ben található hűtőborda. Az MX adattípusok megosztása mellett a Microsoft a rack dizájnját is megosztja partnereivel, hogy azok más rendszerekben is használhassák. A Maia chipek dizájnjait azonban nem osztják meg szélesebb körben, azokat a Microsoft házon belül tartja.

A Maia 100 jelenleg a GPT 3.5 Turbón tesztelés alatt áll, amely ugyanaz a modell, amely a ChatGPT-t, a Bing AI munkaterheléseket és a GitHub Copilotot is működteti. A Microsoft a telepítés korai fázisában van, és a Cobalthoz hasonlóan egyelőre nem hajlandó pontos Maia specifikációkat vagy teljesítmény-összehasonlító teszteket közzétenni. Ez megnehezíti annak megfejtését, hogy a Maia pontosan hogyan viszonyul majd az Nvidia népszerű H100 GPU-jához, a nemrég bejelentett H200-hoz, vagy akár az AMD legújabb MI300X-éhez. Borkar nem akart összehasonlításokról beszélni, ehelyett megismételte, hogy az Nvidia-val és az AMD-vel való partnerségek továbbra is kulcsfontosságúak az Azure MI-felhő jövője szempontjából. "Abban a léptékben, amelyben a felhő működik, nagyon fontos, hogy a rendszer minden rétegét optimalizáljuk és integráljuk, hogy maximalizáljuk a teljesítményt, hogy diverzifikáljuk az ellátási láncot, és őszintén szólva, hogy az ügyfeleinknek infrastrukturális választási lehetőséget adjunk" - mondta Borkar.

A Maia 100 szerverszekrénye és hűtése

Az ellátási láncok diverzifikációja fontos a Microsoft számára, különösen akkor, amikor az Nvidia jelenleg az MI szerverchipek legfontosabb beszállítója, és a vállalatok versenyben vannak azért, hogy megvehessék ezeket a chipeket. Becslések szerint az OpenAI-nak több mint 30 000 régebbi Nvidia A100 GPU-ra volt szüksége a ChatGPT kereskedelmi forgalomba hozatalához, így a Microsoft saját chipjei segíthetnek csökkenteni az MI költségeit ügyfelei számára. A Microsoft ezeket a chipeket a saját Azure felhőalapú munkaterheléséhez fejlesztette ki, nem pedig azért, hogy másoknak eladja, mint az Nvidia, az AMD, az Intel és a Qualcomm. "Én ezt inkább kiegészítőnek tekintem, nem pedig versenytársnak velük" - szögezte le Borkar. "Ma már az Intel és az AMD is jelen van a felhőalapú számítási rendszerünkben. Ezek a partnerek nagyon fontosak az infrastruktúránk szempontjából, és csak választási lehetőséget akarunk biztosítani ügyfeleinknek."

A Maia 100 és a Cobalt 100 elnevezés arra utal, hogy a Microsoft már tervezi ezeknek a chipeknek a második generációs változatait. "Ez egy sorozat, nem csak 100 és kész. De nem fogjuk közzétenni az útiterveinket" - mondja Borkar. Egyelőre nem világos, hogy a Microsoft milyen ütemezéssel fogja szállítani a Maia és a Cobalt új verzióit, de az MI fejlődési sebességét tekintve nem lennék meglepve, ha a Maia 100 utódja az Nvidia H200-as bejelentéséhez hasonló ütemben (kb. 20 hónap) érkezne. A kulcs most az lesz, hogy a Microsoft milyen gyorsan lépteti működésbe a Maia-t és hogy ezek a chipek hogyan befolyásolják majd az MI-felhőszolgáltatások használatának árazását. A Microsoft egyelőre nem hajlandó beszélni az új szerverárképzésről, de a vállalat már csendben elindította a Microsoft 365 Copilot szolgáltatását, amely 30 dolláros havi prémiumot jelent felhasználónként. A Copilot for Microsoft 365 egyelőre csak a Microsoft legnagyobb ügyfeleire korlátozódik, a vállalati felhasználóknak legalább 300 felhasználót kell vállalniuk ahhoz, hogy felkerüljenek az új, mesterséges intelligenciával működő Office-asszisztens várólistájára.