SG.hu

Elképesztően sokba kerül a chatbotok üzemeltetése

Olyan drága az üzemeltetésük, hogy a vállalatok nyilvános használatra nem a legjobb verziót rakják ki.

Az MI-chatbotoknak van egy nagy problémájuk: minden egyes válaszuk rengeteg pénzbe kerül. Az olyan eszközök, mint a ChatGPT és a Bard alapjául szolgáló mai nagyméretű nyelvi modellek működtetésének hatalmas költségei korlátozzák minőségüket, és lehetséges, hogy mindez megfojtja az általuk kiváltott globális technológiai robbanást. A költségek és a szükséges számítógépes chipek korlátozott elérhetősége nagyban leszűkíti, hogy mely vállalatok engedhetik meg maguknak a futtatásukat, és még a világ leggazdagabb vállalataira is nyomást gyakorol, hogy a chatbotokat a lehető leggyorsabban befogják pénztermelésre, még azelőtt, hogy azok arra készen állnának.

Az IT-óriások, amelyek a jövőjüket a mesterséges intelligenciára tették fel ritkán beszélnek a technológia költségeiről. Sem az OpenAI (a ChatGPT gyártója), sem a Microsoft, sem a Google nem árulta el mennyibe került nekik a chatbotok létrehozása, szakértők szerint azonban a tőkeigény olyan hatalmas, hogy ez a legnagyobb akadálya az IT-cégek azon víziójának, amely szerint a generatív MI minden iparágban elterjed majd, csökkentve az emberi munka mennyiségét és növelve a hatékonyságot. A mesterséges intelligencia intenzív számítási igénye az oka annak, hogy az OpenAI visszatartotta új, nagy teljesítményű nyelvi modelljét, a GPT-4-et, és az ingyenes verzióban még mindig a gyengébb GPT-3.5 modellt futtatja. A ChatGPT alapjául szolgáló adathalmazt utoljára 2021 szeptemberében frissítették, így a közelmúlt eseményeinek megvitatására használhatatlan. Annyira drága a futtatása, hogy még azok is, akik havi 20 dollárt fizetnek a GPT-4-ért, csak 25 üzenetet tudnak küldeni háromóránként, ráadásul a válaszadás is sokkal lassabb.

Ez lehet az egyik oka annak, hogy a Google még nem épített be mesterséges intelligenciával működő chatbotot a keresőmotorjába, amely naponta több milliárd lekérdezést indít. Amikor a Google márciusban kiadta Bard chatbotját, úgy döntött, hogy nem a legnagyobb nyelvi modelljét használja. Egyetlen csevegés a ChatGPT-vel akár 1000-szer annyiba is kerülhet, mint egy egyszerű Google-keresés.

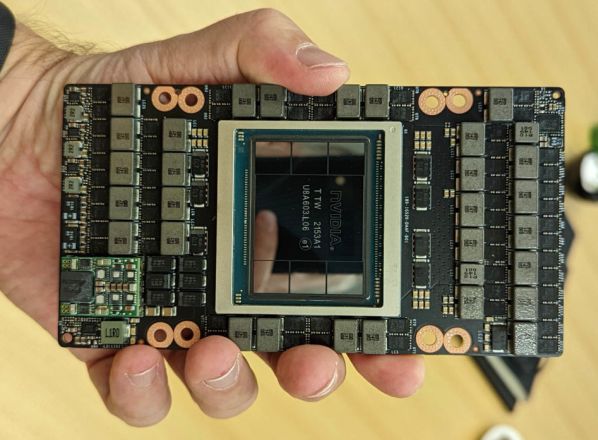

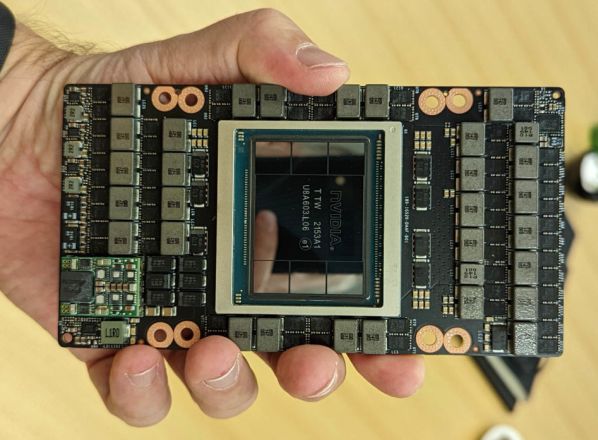

A Biden-kormányzat mesterséges intelligenciáról szóló jelentése a generatív mesterséges intelligencia számítási költségeit sorskérdésként jelölte meg. A Fehér Ház azt írta, hogy a technológia várhatóan "drámaian megnöveli a számítási igényeket és a kapcsolódó környezeti hatásokat", és hogy "sürgősen szükség van" fenntarthatóbb rendszerek kialakítására. A gépi tanulás más formáinál is nagyobb mértékben igényel szédítő mennyiségű számítási teljesítményt és olyan speciális chipeket, amelyeket csak a leggazdagabb vállalatok engedhetnek meg maguknak. A szükséges Nvidia lapkák ára a 40 ezer dollárt súrolja, és sok ezer kell belőlük. Árcsökkenés nem várható, sőt, a chipekhez való hozzáférésért egyre élesedik a harc. Ez hozzájárult ahhoz, hogy az Nvidia saját jogon ezer milliárd dollárt érő technológiai óriássá vált, mert az IT-ágazat legértékesebb eszközének kulcsát tartja a kezében.

Nvidia H100, darabja 15 millió forint

A Szilícium-völgy részben azzal vált az internetgazdaság urává, hogy a szolgáltatásokat - mint az online keresés, az e-mail vagy a közösségi média - ingyen kínálta a világnak. Az informatikai startupok üzleti modellje, hogy kezdetben jellemzően veszteségesek, de végül a személyre szabott reklámokkal komoly nyereséget termelnek. És a hirdetések valószínűleg az MI chatbotokat sem kerülik el. Elemzők szerint azonban a hirdetések önmagukban valószínűleg nem lesznek elegendőek ahhoz, hogy a legmodernebb MI-eszközök egyhamar nyereségessé váljanak. Addig is a fogyasztók számára MI-modelleket kínáló vállalatoknak egyensúlyt kell teremteniük a piaci részesedés megszerzésére irányuló vágyuk és a pénzügyi veszteségek között.

A rivalizálás elsőként valószínűleg elsősorban a chipgyártók és a felhőalapú számítástechnikai óriások profitját fogja növelni, amelyek már most is a digitális tér nagy részét uralják - a chipgyártókkal együtt, amelyek hardverére szükség van a modellek futtatásához. Nem véletlen, hogy a vezető MI-nyelvi modelleket építő vállalatok vagy a legnagyobb felhőalapú számítástechnikai szolgáltatók között vannak, mint a Google és a Microsoft, vagy szoros partnerségben állnak velük, mint az OpenAI a Microsofttal. Azok a vállalatok, amelyek megvásárolják ezeknek a cégeknek az MI-eszközeit nem tudják, hogy egy olyan erősen támogatott szolgáltatáshoz kötődnek, amely sokkal többe kerül, mint amennyit jelenleg fizetnek.

Az OpenAI vezérigazgatója, Sam Altman közvetve elismerte a problémát a múlt havi szenátusi meghallgatáson, amikor Jon Ossoff szenátor arra figyelmeztetett, hogy ha az OpenAI megpróbálná a ChatGPT-t olyan módon addiktívvá tenni, hogy az károsítsa a gyerekeket, a kongresszus "nagyon szigorúan fel fog lépni". Altman szerint Ossoffnak nem kell aggódnia: "Igyekszünk olyan rendszereket tervezni, amelyek nem maximalizálják az elkötelezettséget. Valójában annyira szerény a számítási kapacitás, hogy minél kevesebben használják a termékeinket, annál jobb".

A mesterséges intelligencia nyelvi modelljeinek költségei a fejlesztésükkel és a képzésükkel kezdődnek, a nyelvi minták azonosításához gigantikus mennyiségű adatra és szoftverre van szükség. Az MI-cégek jellemzően olyan sztárkutatókat alkalmaznak, akiknek a fizetése vetekedhet a profi sportolókéval. Ez magas belépési küszöböt jelent minden olyan vállalat számára, amely saját modellt szeretne építeni, bár néhány jól finanszírozott startupnak sikerült - köztük az Anthropic AI-nak, amelyet az OpenAI kilépett munkatársai alapítottak a Google pénzügyi támogatásával. A ChatGPT-hez, a Microsoft Binghez vagy az Anthropic Claude-hoz hasonló chatbotokhoz intézett minden egyes lekérdezés az adatközpontokba kerül, ahol a szuperszámítógépek azokat összedolgozzák a modellekkel, és egyszerre rengeteg számítást végeznek. Először értelmezik a felhasználó kérését, majd a legvalószínűbb válasz előrejelzésén dolgoznak.

Ehhez a fajta számításokhoz GPU-kra, azaz grafikus feldolgozóegységekre van szükség, amelyeket először ugyan videojátékokhoz készítettek, de kiderült, hogy ezek a chipek különösen jól képesek olyan számítási feladatokat kezelni, amiket a nagyméretű nyelvi modellek igényelnek. Jelenleg az Nvidia árulja ezek közül a legjobbakat, és a gyártásért felelős tajvani székhelyű vállalat, a TSMC szintén részesedik a dicsfényből. "A GPU-kat jelenleg lényegesen nehezebb beszerezni, mint a gyógyszereket" - mondta a Wall Street Journal május végi csúcstalálkozóján Elon Musk, aki nemrégiben mintegy 10 000 GPU-t vásárolt saját MI startupja számára.

Ezek a számítási követelmények azt is megmagyarázzák, hogy az OpenAI már miért nem az a nonprofit szervezet, amelynek alapították. 2015-ben azzal a céllal indult, hogy a mesterséges intelligenciát "olyan módon fejlessze, amely a legnagyobb valószínűséggel az emberiség egészének javát szolgálja, és amelyet nem korlátoz a pénzügyi megtérülés igénye". 2019-re azonban profitorientált modellre váltott, hogy befektetőket vonzzon. A Microsoft 1 milliárd dollárt pumpált bele, és az OpenAI kizárólagos számítási szolgáltatója lett. A Microsoft azóta további 10 milliárd dollárt öntött bele, és integrálta az OpenAI technológiáját a Bingbe, a Windowsba és más termékekbe.

Az, hogy pontosan mennyibe kerül a ChatGPT-hez hasonló chatbotok üzemeltetése, gyorsan változik, mivel a vállalatok azon dolgoznak, hogy hatékonyabbá tegyék őket. Decemberben, nem sokkal az indulás után Altman a ChatGPT költségeit "egyszámjegyű centekre becsülte csevegésenként". Ez nem hangzik soknak, amíg meg nem szorozzuk a napi 10 millió felhasználóval, ahogyan azt az elemzők is becsülték. Februárban a SemiAnalysis kiszámolta, hogy a ChatGPT csak a GPT-3.5, az akkori alapértelmezett modell futtatásához szükséges feldolgozás alapján az OpenAI-nak naponta mintegy 700 000 dollárjába került csak a számítási költségek miatt. Szorozzuk meg ezeket a számítási költségeket azzal a napi 100 millió emberrel, amennyi a Microsoft Bing keresőmotorját használja, vagy azzal a több mint 1 milliárd emberrel, aki a Google-t használja, és máris érthetővé válik, hogy a technológiai óriások miért vonakodnak a legjobb MI-modelleket a nyilvánosság számára elérhetővé tenni.

Ez nem fenntartható egyenlet: vagy a generatív MI demokratizálása élvez előnyt, vagy a széles körű hozzáférhetőség, vagy az egész gazdasági bukás, és persze eközben az egészet a környezet sínyli meg. A Google a Bard februári bejelentésekor azt mondta, hogy a Bard kezdetben a vállalat LaMDA nyelvi modelljének egy "könnyített" változatán fog futni, mivel az "lényegesen kisebb számítási teljesítményt igényel, ami lehetővé teszi számunkra, hogy több felhasználóra skálázódjunk". Más szóval, még egy olyan gazdag vállalat, mint a Google sem volt hajlandó állni a számlát, hogy a legerősebb MI-technológiáját egy ingyenes chatbotba helyezze. A költségcsökkentésnek ára volt, a Bard alapvető tényeket hibázott el induláskor, és ez a Google részvények árfolyamának 100 milliárd dolláros zuhanását okozta.

A Bing a maga részéről már jóval korábban csütörtököt mondott, ami arra késztette a Microsoftot, hogy korlátozza a felhasználók által egy adott beszélgetés során feltehető kérdések számát. Az ilyen hibák - amelyeket néha "hallucinációknak" is neveznek - komoly aggodalomra adnak okot a nyelvi modellekkel kapcsolatban, mivel mind a magánszemélyek, mind a vállalatok egyre nagyobb mértékben támaszkodnak rájuk. Szakértők szerint ezek a modellek alapvető felépítéséből adódnak, mert csak egymás után következő szavak sorozatát generálják, nem pedig igaz állításokat. A Google egy másik chatbotját, a Sparrow-t a vállalat DeepMind nevű leányvállalata tervezte az interneten való keresésre és a források idézésére, azzal a céllal, hogy csökkentse a valótlanságokat. A Google azonban ezt egyelőre nem adta ki.

Eközben a nagy szereplők mindegyike azon versenyzik, hogy miként tudnák olcsóbbá tenni a mesterséges intelligencia nyelvi modelljeit. Egy lekérdezés futtatása az OpenAI új, könnyű GPT-3.5 Turbo modelljén kevesebb mint tizedannyiba kerül, mint a GPT-4 csúcsmodelljén. A Google saját MI-chipeket tervez, amelyek állítása szerint hatékonyabbak, mint az Nvidia chipjei, számos startup pedig nyílt forráskódú nyelvi modellekre épít, mint például a Meta LLaMA-ja, hogy ne kelljen fizetniük az OpenAI-nak vagy a Google-nek a saját modelljeik használatáért - még akkor is, ha ezek a modellek még nem teljesítenek olyan jól.

A kisebb, olcsóbb modellek erőltetése 180 fokos kanyart jelent az iparágban. "Az elmúlt négy évet azzal töltöttük, hogy a lehető legnagyobb modelleket próbáltuk elkészíteni" - mondta Matt Goldstein MI-szakértő. "De akkoriban még a kutatási cikkek publikálása volt a cél, nem pedig a chatbotok nyilvánosságra hozatala. Most, az elmúlt néhány hónapban teljes fordulat állt be a közösségben, és hirtelen mindenki a lehető legkisebb modellt próbálja megépíteni, hogy kordában tartsa a költségeket". A fogyasztók számára ez azt jelentheti, hogy a nagy teljesítményű, általános célú mesterséges intelligenciamodellekhez való korlátlan hozzáférés napjai meg vannak számlálva.

A Microsoft már kísérletezik azzal, hogy hirdetéseket építsen be az MI-alapú Bing találatokba. A szenátusi meghallgatáson Altman, az OpenAI munkatársa nem zárta ki, hogy ugyanezt tegye, bár elmondta, hogy ő a fizetős előfizetési modellt részesíti előnyben. Mindkét vállalat azt állítja, hogy bízik abban, hogy a befektetés végül megtérül. Altman februárban a Stratechery technológiai blognak azt mondta: "Olyan sok érték van itt, hogy elképzelhetetlen számomra, hogy ne tudnánk kitalálni, hogyan lehetne a pénztárgépet csengésre bírni."

A kritikusok azonban megjegyzik, hogy a generatív mesterséges intelligencia a társadalom számára költségekkel is jár. "A számítógépek csúcsra járatása hatással van az üvegházhatású gázok kibocsátására" - mondta Bhaskar Chakravorti, a Tufts Egyetem dékánja. Az igényelt energiát egyéb célokra is fel lehetne használni, beleértve más, a nyelvi modelleknél kevésbé divatos számítástechnikai feladatokat. Ez "akár lassíthatja is a mesterséges intelligencia fejlesztését és alkalmazását más, értelmesebb felhasználási célokra, például az egészségügyben, a gyógyszerkutatásban, a rák felismerésében stb." - mondta Chakravorti. A ChatGPT használatára és számítási igényeire vonatkozó becslések alapján Kasper Groes Albin Ludvigsen adatkutató úgy becsüli, hogy az januárban annyi áramot használhatott, mint 175 000 ember - ami egy közepes méretű városnak felel meg.

Goldstein szerint a technológiai óriások egyelőre hajlandóak pénzt veszíteni, hogy a chatbotjaikkal piaci részesedést szerezzenek. De ha nem tudják nyereségessé tenni őket? "Végül eljutsz a hype-görbe végére, és akkor a befektetők már csak az eredményekre lesznek kiváncsiak". Goldstein jóslata szerint sok ember és vállalat nehezen fog tudni ellenállni a generatív mesterséges intelligencia eszközöknek, még ha azoknak hibáik is vannak. "Még ha drága is" - mondta - "még mindig sokkal olcsóbb, mint az emberi munkaerő".

Az MI-chatbotoknak van egy nagy problémájuk: minden egyes válaszuk rengeteg pénzbe kerül. Az olyan eszközök, mint a ChatGPT és a Bard alapjául szolgáló mai nagyméretű nyelvi modellek működtetésének hatalmas költségei korlátozzák minőségüket, és lehetséges, hogy mindez megfojtja az általuk kiváltott globális technológiai robbanást. A költségek és a szükséges számítógépes chipek korlátozott elérhetősége nagyban leszűkíti, hogy mely vállalatok engedhetik meg maguknak a futtatásukat, és még a világ leggazdagabb vállalataira is nyomást gyakorol, hogy a chatbotokat a lehető leggyorsabban befogják pénztermelésre, még azelőtt, hogy azok arra készen állnának.

Az IT-óriások, amelyek a jövőjüket a mesterséges intelligenciára tették fel ritkán beszélnek a technológia költségeiről. Sem az OpenAI (a ChatGPT gyártója), sem a Microsoft, sem a Google nem árulta el mennyibe került nekik a chatbotok létrehozása, szakértők szerint azonban a tőkeigény olyan hatalmas, hogy ez a legnagyobb akadálya az IT-cégek azon víziójának, amely szerint a generatív MI minden iparágban elterjed majd, csökkentve az emberi munka mennyiségét és növelve a hatékonyságot. A mesterséges intelligencia intenzív számítási igénye az oka annak, hogy az OpenAI visszatartotta új, nagy teljesítményű nyelvi modelljét, a GPT-4-et, és az ingyenes verzióban még mindig a gyengébb GPT-3.5 modellt futtatja. A ChatGPT alapjául szolgáló adathalmazt utoljára 2021 szeptemberében frissítették, így a közelmúlt eseményeinek megvitatására használhatatlan. Annyira drága a futtatása, hogy még azok is, akik havi 20 dollárt fizetnek a GPT-4-ért, csak 25 üzenetet tudnak küldeni háromóránként, ráadásul a válaszadás is sokkal lassabb.

Ez lehet az egyik oka annak, hogy a Google még nem épített be mesterséges intelligenciával működő chatbotot a keresőmotorjába, amely naponta több milliárd lekérdezést indít. Amikor a Google márciusban kiadta Bard chatbotját, úgy döntött, hogy nem a legnagyobb nyelvi modelljét használja. Egyetlen csevegés a ChatGPT-vel akár 1000-szer annyiba is kerülhet, mint egy egyszerű Google-keresés.

A Biden-kormányzat mesterséges intelligenciáról szóló jelentése a generatív mesterséges intelligencia számítási költségeit sorskérdésként jelölte meg. A Fehér Ház azt írta, hogy a technológia várhatóan "drámaian megnöveli a számítási igényeket és a kapcsolódó környezeti hatásokat", és hogy "sürgősen szükség van" fenntarthatóbb rendszerek kialakítására. A gépi tanulás más formáinál is nagyobb mértékben igényel szédítő mennyiségű számítási teljesítményt és olyan speciális chipeket, amelyeket csak a leggazdagabb vállalatok engedhetnek meg maguknak. A szükséges Nvidia lapkák ára a 40 ezer dollárt súrolja, és sok ezer kell belőlük. Árcsökkenés nem várható, sőt, a chipekhez való hozzáférésért egyre élesedik a harc. Ez hozzájárult ahhoz, hogy az Nvidia saját jogon ezer milliárd dollárt érő technológiai óriássá vált, mert az IT-ágazat legértékesebb eszközének kulcsát tartja a kezében.

Nvidia H100, darabja 15 millió forint

A Szilícium-völgy részben azzal vált az internetgazdaság urává, hogy a szolgáltatásokat - mint az online keresés, az e-mail vagy a közösségi média - ingyen kínálta a világnak. Az informatikai startupok üzleti modellje, hogy kezdetben jellemzően veszteségesek, de végül a személyre szabott reklámokkal komoly nyereséget termelnek. És a hirdetések valószínűleg az MI chatbotokat sem kerülik el. Elemzők szerint azonban a hirdetések önmagukban valószínűleg nem lesznek elegendőek ahhoz, hogy a legmodernebb MI-eszközök egyhamar nyereségessé váljanak. Addig is a fogyasztók számára MI-modelleket kínáló vállalatoknak egyensúlyt kell teremteniük a piaci részesedés megszerzésére irányuló vágyuk és a pénzügyi veszteségek között.

A rivalizálás elsőként valószínűleg elsősorban a chipgyártók és a felhőalapú számítástechnikai óriások profitját fogja növelni, amelyek már most is a digitális tér nagy részét uralják - a chipgyártókkal együtt, amelyek hardverére szükség van a modellek futtatásához. Nem véletlen, hogy a vezető MI-nyelvi modelleket építő vállalatok vagy a legnagyobb felhőalapú számítástechnikai szolgáltatók között vannak, mint a Google és a Microsoft, vagy szoros partnerségben állnak velük, mint az OpenAI a Microsofttal. Azok a vállalatok, amelyek megvásárolják ezeknek a cégeknek az MI-eszközeit nem tudják, hogy egy olyan erősen támogatott szolgáltatáshoz kötődnek, amely sokkal többe kerül, mint amennyit jelenleg fizetnek.

Az OpenAI vezérigazgatója, Sam Altman közvetve elismerte a problémát a múlt havi szenátusi meghallgatáson, amikor Jon Ossoff szenátor arra figyelmeztetett, hogy ha az OpenAI megpróbálná a ChatGPT-t olyan módon addiktívvá tenni, hogy az károsítsa a gyerekeket, a kongresszus "nagyon szigorúan fel fog lépni". Altman szerint Ossoffnak nem kell aggódnia: "Igyekszünk olyan rendszereket tervezni, amelyek nem maximalizálják az elkötelezettséget. Valójában annyira szerény a számítási kapacitás, hogy minél kevesebben használják a termékeinket, annál jobb".

A mesterséges intelligencia nyelvi modelljeinek költségei a fejlesztésükkel és a képzésükkel kezdődnek, a nyelvi minták azonosításához gigantikus mennyiségű adatra és szoftverre van szükség. Az MI-cégek jellemzően olyan sztárkutatókat alkalmaznak, akiknek a fizetése vetekedhet a profi sportolókéval. Ez magas belépési küszöböt jelent minden olyan vállalat számára, amely saját modellt szeretne építeni, bár néhány jól finanszírozott startupnak sikerült - köztük az Anthropic AI-nak, amelyet az OpenAI kilépett munkatársai alapítottak a Google pénzügyi támogatásával. A ChatGPT-hez, a Microsoft Binghez vagy az Anthropic Claude-hoz hasonló chatbotokhoz intézett minden egyes lekérdezés az adatközpontokba kerül, ahol a szuperszámítógépek azokat összedolgozzák a modellekkel, és egyszerre rengeteg számítást végeznek. Először értelmezik a felhasználó kérését, majd a legvalószínűbb válasz előrejelzésén dolgoznak.

Ehhez a fajta számításokhoz GPU-kra, azaz grafikus feldolgozóegységekre van szükség, amelyeket először ugyan videojátékokhoz készítettek, de kiderült, hogy ezek a chipek különösen jól képesek olyan számítási feladatokat kezelni, amiket a nagyméretű nyelvi modellek igényelnek. Jelenleg az Nvidia árulja ezek közül a legjobbakat, és a gyártásért felelős tajvani székhelyű vállalat, a TSMC szintén részesedik a dicsfényből. "A GPU-kat jelenleg lényegesen nehezebb beszerezni, mint a gyógyszereket" - mondta a Wall Street Journal május végi csúcstalálkozóján Elon Musk, aki nemrégiben mintegy 10 000 GPU-t vásárolt saját MI startupja számára.

Ezek a számítási követelmények azt is megmagyarázzák, hogy az OpenAI már miért nem az a nonprofit szervezet, amelynek alapították. 2015-ben azzal a céllal indult, hogy a mesterséges intelligenciát "olyan módon fejlessze, amely a legnagyobb valószínűséggel az emberiség egészének javát szolgálja, és amelyet nem korlátoz a pénzügyi megtérülés igénye". 2019-re azonban profitorientált modellre váltott, hogy befektetőket vonzzon. A Microsoft 1 milliárd dollárt pumpált bele, és az OpenAI kizárólagos számítási szolgáltatója lett. A Microsoft azóta további 10 milliárd dollárt öntött bele, és integrálta az OpenAI technológiáját a Bingbe, a Windowsba és más termékekbe.

Az, hogy pontosan mennyibe kerül a ChatGPT-hez hasonló chatbotok üzemeltetése, gyorsan változik, mivel a vállalatok azon dolgoznak, hogy hatékonyabbá tegyék őket. Decemberben, nem sokkal az indulás után Altman a ChatGPT költségeit "egyszámjegyű centekre becsülte csevegésenként". Ez nem hangzik soknak, amíg meg nem szorozzuk a napi 10 millió felhasználóval, ahogyan azt az elemzők is becsülték. Februárban a SemiAnalysis kiszámolta, hogy a ChatGPT csak a GPT-3.5, az akkori alapértelmezett modell futtatásához szükséges feldolgozás alapján az OpenAI-nak naponta mintegy 700 000 dollárjába került csak a számítási költségek miatt. Szorozzuk meg ezeket a számítási költségeket azzal a napi 100 millió emberrel, amennyi a Microsoft Bing keresőmotorját használja, vagy azzal a több mint 1 milliárd emberrel, aki a Google-t használja, és máris érthetővé válik, hogy a technológiai óriások miért vonakodnak a legjobb MI-modelleket a nyilvánosság számára elérhetővé tenni.

Ez nem fenntartható egyenlet: vagy a generatív MI demokratizálása élvez előnyt, vagy a széles körű hozzáférhetőség, vagy az egész gazdasági bukás, és persze eközben az egészet a környezet sínyli meg. A Google a Bard februári bejelentésekor azt mondta, hogy a Bard kezdetben a vállalat LaMDA nyelvi modelljének egy "könnyített" változatán fog futni, mivel az "lényegesen kisebb számítási teljesítményt igényel, ami lehetővé teszi számunkra, hogy több felhasználóra skálázódjunk". Más szóval, még egy olyan gazdag vállalat, mint a Google sem volt hajlandó állni a számlát, hogy a legerősebb MI-technológiáját egy ingyenes chatbotba helyezze. A költségcsökkentésnek ára volt, a Bard alapvető tényeket hibázott el induláskor, és ez a Google részvények árfolyamának 100 milliárd dolláros zuhanását okozta.

A Bing a maga részéről már jóval korábban csütörtököt mondott, ami arra késztette a Microsoftot, hogy korlátozza a felhasználók által egy adott beszélgetés során feltehető kérdések számát. Az ilyen hibák - amelyeket néha "hallucinációknak" is neveznek - komoly aggodalomra adnak okot a nyelvi modellekkel kapcsolatban, mivel mind a magánszemélyek, mind a vállalatok egyre nagyobb mértékben támaszkodnak rájuk. Szakértők szerint ezek a modellek alapvető felépítéséből adódnak, mert csak egymás után következő szavak sorozatát generálják, nem pedig igaz állításokat. A Google egy másik chatbotját, a Sparrow-t a vállalat DeepMind nevű leányvállalata tervezte az interneten való keresésre és a források idézésére, azzal a céllal, hogy csökkentse a valótlanságokat. A Google azonban ezt egyelőre nem adta ki.

Eközben a nagy szereplők mindegyike azon versenyzik, hogy miként tudnák olcsóbbá tenni a mesterséges intelligencia nyelvi modelljeit. Egy lekérdezés futtatása az OpenAI új, könnyű GPT-3.5 Turbo modelljén kevesebb mint tizedannyiba kerül, mint a GPT-4 csúcsmodelljén. A Google saját MI-chipeket tervez, amelyek állítása szerint hatékonyabbak, mint az Nvidia chipjei, számos startup pedig nyílt forráskódú nyelvi modellekre épít, mint például a Meta LLaMA-ja, hogy ne kelljen fizetniük az OpenAI-nak vagy a Google-nek a saját modelljeik használatáért - még akkor is, ha ezek a modellek még nem teljesítenek olyan jól.

A kisebb, olcsóbb modellek erőltetése 180 fokos kanyart jelent az iparágban. "Az elmúlt négy évet azzal töltöttük, hogy a lehető legnagyobb modelleket próbáltuk elkészíteni" - mondta Matt Goldstein MI-szakértő. "De akkoriban még a kutatási cikkek publikálása volt a cél, nem pedig a chatbotok nyilvánosságra hozatala. Most, az elmúlt néhány hónapban teljes fordulat állt be a közösségben, és hirtelen mindenki a lehető legkisebb modellt próbálja megépíteni, hogy kordában tartsa a költségeket". A fogyasztók számára ez azt jelentheti, hogy a nagy teljesítményű, általános célú mesterséges intelligenciamodellekhez való korlátlan hozzáférés napjai meg vannak számlálva.

A Microsoft már kísérletezik azzal, hogy hirdetéseket építsen be az MI-alapú Bing találatokba. A szenátusi meghallgatáson Altman, az OpenAI munkatársa nem zárta ki, hogy ugyanezt tegye, bár elmondta, hogy ő a fizetős előfizetési modellt részesíti előnyben. Mindkét vállalat azt állítja, hogy bízik abban, hogy a befektetés végül megtérül. Altman februárban a Stratechery technológiai blognak azt mondta: "Olyan sok érték van itt, hogy elképzelhetetlen számomra, hogy ne tudnánk kitalálni, hogyan lehetne a pénztárgépet csengésre bírni."

A kritikusok azonban megjegyzik, hogy a generatív mesterséges intelligencia a társadalom számára költségekkel is jár. "A számítógépek csúcsra járatása hatással van az üvegházhatású gázok kibocsátására" - mondta Bhaskar Chakravorti, a Tufts Egyetem dékánja. Az igényelt energiát egyéb célokra is fel lehetne használni, beleértve más, a nyelvi modelleknél kevésbé divatos számítástechnikai feladatokat. Ez "akár lassíthatja is a mesterséges intelligencia fejlesztését és alkalmazását más, értelmesebb felhasználási célokra, például az egészségügyben, a gyógyszerkutatásban, a rák felismerésében stb." - mondta Chakravorti. A ChatGPT használatára és számítási igényeire vonatkozó becslések alapján Kasper Groes Albin Ludvigsen adatkutató úgy becsüli, hogy az januárban annyi áramot használhatott, mint 175 000 ember - ami egy közepes méretű városnak felel meg.

Goldstein szerint a technológiai óriások egyelőre hajlandóak pénzt veszíteni, hogy a chatbotjaikkal piaci részesedést szerezzenek. De ha nem tudják nyereségessé tenni őket? "Végül eljutsz a hype-görbe végére, és akkor a befektetők már csak az eredményekre lesznek kiváncsiak". Goldstein jóslata szerint sok ember és vállalat nehezen fog tudni ellenállni a generatív mesterséges intelligencia eszközöknek, még ha azoknak hibáik is vannak. "Még ha drága is" - mondta - "még mindig sokkal olcsóbb, mint az emberi munkaerő".