Berta Sándor

Intel: akár 1000 magos processzorok is jöhetnek

A gyártó olyan modelleken dolgozik, amelyek a jelenlegi termékeknél sokkal több processzormagot tartalmaznak, ugyanakkor a munka igazi kihívást jelent a mérnökök számára.

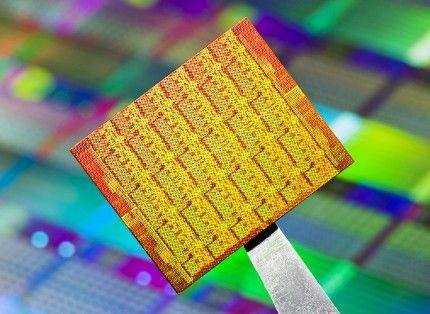

A New Orleansban rendezett Supercomputer 2010 nevű szakmai konferencián Timothy Mattson, az Intel egyik kutatója mutatta be a társaság Single Chip Cloud Computer (SCC) nevű chipjét, amelyben sikerült 48 processzormagot elhelyezni. A szakember szerint ez az architektúra lehetővé teszi, hogy akár 1000 magot is használhassanak egyetlen chipben. Az egyre több processzormag integrálása viszonylag egyszerű, azonban komoly kihívást jelent a folyamatosan növekvő számú CPU-magok közötti összeköttetés megteremtése és biztosítása. Mattson szerint ez a feladat annyira bonyolult, hogy hiába lenne a chipben egyre több processzormag, annak a teljesítménye végül nem nőne, sőt mivel átlépné a teljesítményhatárt inkább egyre jobban csökkenne. Az Intel kutatói így most ennek a problémának a megoldásán dolgoznak, azonban ez némi időbe telik.

A Single Chip Cloud Computer a Polaris program utódjának számít. A gyártó már 2007-ben azt ígérte, hogy képes lesz egyetlen chipen 80 processzormagot elhelyezni. Az ígéretét sikerült is tartania, igaz, végül a prototípusba CPU-magok helyett egyszerű FPU-egységeket integráltak. A bemutatott modellt a TeraScale Research Program keretében fejlesztették ki és még nem került be a vállalat termék-ütemtervébe. Az Intel a kutatóprojekttel azt szeretné bebizonyítani, hogy igenis át lehet lépni a jelenlegi teljesítményhatárokat és le lehet küzdeni a fejlesztés során felmerülő nehézségeket.

A már korábban bemutatott 48 magos SCC-nél az egyes processzormagok közötti kommunikációra egy úgynevezett Mesh-hálózat szolgál, amely egy saját RCCE nevű protokollt használ. Az eddigi tesztek azt bizonyították, hogy az RCCE legalább annyira hatékonyan dolgozik, mint egy Linux-cluster, de 1000 mag integrálása és használata esetén már elérnék a szinkronizációs lehetőségek felső határát, így a rendszer összteljesítménye csökkenni kezdene.

A cég szerint ugyanakkor az SCC esetében nem a teljesítmény a fontos, ehelyett inkább a jövőbeli asztali alkalmazások többmagos processzorokra optimalizálására helyezik a fő hangsúlyt. A 45 nanométeres gyártási eljárással készülő és üresjáratban 25 Wattot, míg maximálisan 125 Wattot fogyasztó SCC teljesítménye akár 2 Teraflops is lehet. A CPU prototípusait világszerte 100 kiválasztott intézmény teszteli idén ősz óta.

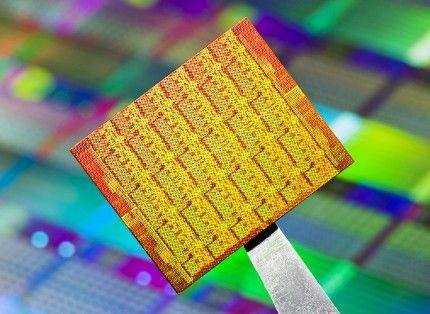

A New Orleansban rendezett Supercomputer 2010 nevű szakmai konferencián Timothy Mattson, az Intel egyik kutatója mutatta be a társaság Single Chip Cloud Computer (SCC) nevű chipjét, amelyben sikerült 48 processzormagot elhelyezni. A szakember szerint ez az architektúra lehetővé teszi, hogy akár 1000 magot is használhassanak egyetlen chipben. Az egyre több processzormag integrálása viszonylag egyszerű, azonban komoly kihívást jelent a folyamatosan növekvő számú CPU-magok közötti összeköttetés megteremtése és biztosítása. Mattson szerint ez a feladat annyira bonyolult, hogy hiába lenne a chipben egyre több processzormag, annak a teljesítménye végül nem nőne, sőt mivel átlépné a teljesítményhatárt inkább egyre jobban csökkenne. Az Intel kutatói így most ennek a problémának a megoldásán dolgoznak, azonban ez némi időbe telik.

A Single Chip Cloud Computer a Polaris program utódjának számít. A gyártó már 2007-ben azt ígérte, hogy képes lesz egyetlen chipen 80 processzormagot elhelyezni. Az ígéretét sikerült is tartania, igaz, végül a prototípusba CPU-magok helyett egyszerű FPU-egységeket integráltak. A bemutatott modellt a TeraScale Research Program keretében fejlesztették ki és még nem került be a vállalat termék-ütemtervébe. Az Intel a kutatóprojekttel azt szeretné bebizonyítani, hogy igenis át lehet lépni a jelenlegi teljesítményhatárokat és le lehet küzdeni a fejlesztés során felmerülő nehézségeket.

A már korábban bemutatott 48 magos SCC-nél az egyes processzormagok közötti kommunikációra egy úgynevezett Mesh-hálózat szolgál, amely egy saját RCCE nevű protokollt használ. Az eddigi tesztek azt bizonyították, hogy az RCCE legalább annyira hatékonyan dolgozik, mint egy Linux-cluster, de 1000 mag integrálása és használata esetén már elérnék a szinkronizációs lehetőségek felső határát, így a rendszer összteljesítménye csökkenni kezdene.

A cég szerint ugyanakkor az SCC esetében nem a teljesítmény a fontos, ehelyett inkább a jövőbeli asztali alkalmazások többmagos processzorokra optimalizálására helyezik a fő hangsúlyt. A 45 nanométeres gyártási eljárással készülő és üresjáratban 25 Wattot, míg maximálisan 125 Wattot fogyasztó SCC teljesítménye akár 2 Teraflops is lehet. A CPU prototípusait világszerte 100 kiválasztott intézmény teszteli idén ősz óta.