SG.hu

Hülyeségeket válaszol a Google kereső találatai feletti MI-áttekintés

A Google a keresőben az elmúlt napokban bevezette a vállalat új AI Overviews (AI áttekintések) szolgáltatását, amely összefoglaló válaszokat ad egyes kérdésekre. Ezek az áttekintések viccesek, de néha hamisak, félrevezetőek, vagy akár veszélyesek is lehetnek.

Ténybeli hibák természetesen a meglévő LLM chatbotokban is felbukkanhatnak. De az MI pontatlansága által okozott potenciális károk megsokszorozódnak, amikor ezek a hibák a Google keresési találati oldalának rendkívül értékes tetején jelennek meg. A Google mesterséges intelligencia-áttekintéseinek legviccesebb hibái akkor fordulnak elő, amikor a rendszer nem veszi észre, hogy egy online forrás vicces akart lenni. Egy MI-válasz például azt javasolta, hogy „Negyed csésze nem mérgező ragasztót” használjunk, hogy a sajt ne csússzon le a pizzáról - ez visszavezethető egy felhasználóra, aki egy fórumban akart trollkodni. Egy másik válasz „villogó folyadékot” ajánl az autók indexelési hangjához; ez egy tanácsadási fórum másik trolljához vezethető vissza, amely fórumot a Google nyilvánvalóan megbízható forrásként tart számon.

"Az általunk látott példák általában nagyon szokatlan lekérdezések, és nem reprezentálják a legtöbb ember tapasztalatait” - mondta az esetekkel kapcsolatban a Google szóvivője. „A mesterséges intelligencia áttekintések túlnyomó többsége kiváló minőségű információt nyújt, olyan linkekkel, amelyek segítségével mélyebbre lehet ásni a weben”. A szokásos Google-keresések során az internetfelhasználók ilyen tréfás bejegyzései valószínűleg nem lennének az első válaszok között, amelyeket valaki látna, amikor rákattint a weblinkek listájára. De az AI Overviews segítségével ezek a trollok bekerültek a hitelesnek tűnő adatösszefoglalóba, amely közvetlenül a találati oldal tetején jelenik meg. Ráadásul a Google MI-összefoglalója alatti apró „forráslink” dobozokban semmi sem utal arra, hogy ezek a fórumtrollok ne lennének jó információforrások.

Előfordul, hogy a Google mesterséges intelligencia áttekintése egy nem viccnek szánt forrás pontos összefoglalóját kínálja, amely történetesen téves. Amikor például arról kérdezzük, hogy a Függetlenségi Nyilatkozat aláírói közül hánynak volt rabszolgája, a Google AI Overview pontosan összefoglalja a Washington University of St. Louis könyvtárának oldalát, amely szerint egyharmaduk rabszolgatartó volt. A válasz azonban figyelmen kívül hagyja az egymásnak ellentmondó forrásokat, például a Chicago Sun-Times cikkét, amely szerint a valós válasz inkább háromnegyed.

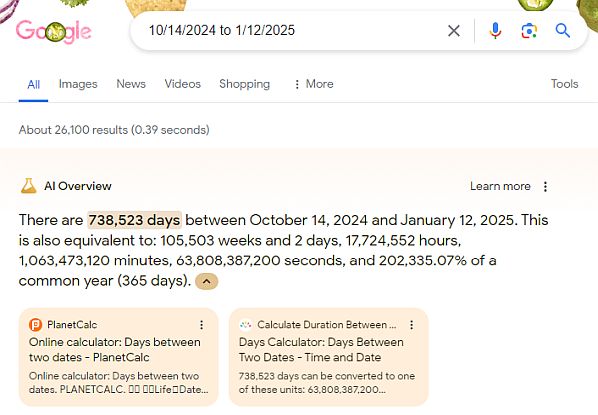

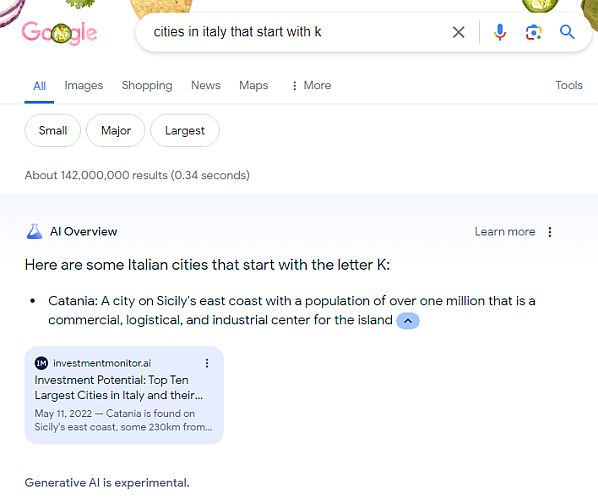

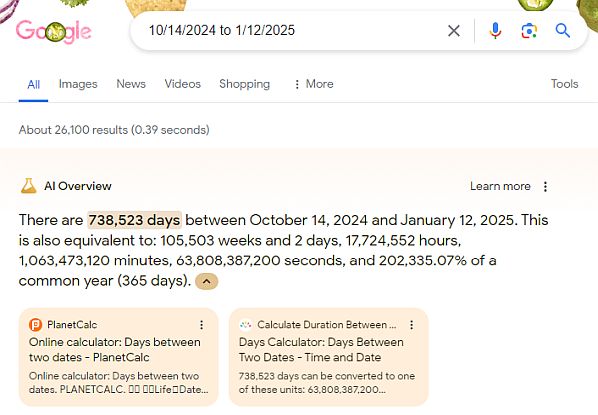

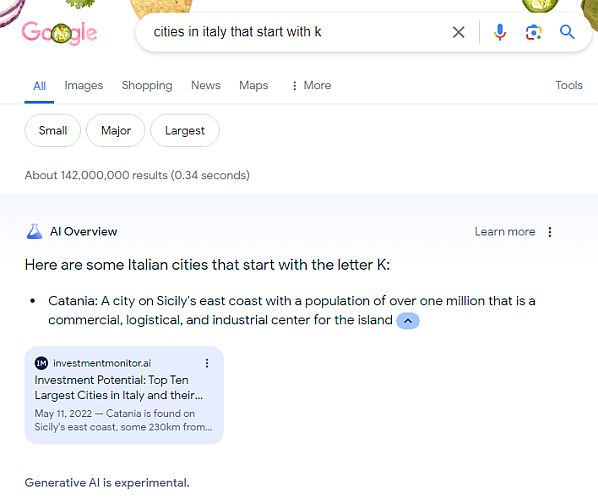

A Google mesterséges intelligencia-áttekintésekben az egyik legfrusztrálóbb hibatípus az, amikor a rendszer egy kissé eltérő kérdésre ad némileg helyes választ. Az alaszkai szárazföld legdélebbi pontját keresve például az Aleut-szigetlánc legdélebbi részével kapcsolatos választ kapunk. Egy sziget definíció szerint nem része a szárazföldnek, de aki vakon megbízik a Google mesterséges intelligenciájában, az talán nem lesz ilyen óvatos. A szavakat alkotó betűkkel kapcsolatos kérdések is megzavarhatják a Google mesterséges intelligenciáját, például a rendszer szerint Catania egy olasz város, amely K-val kezdődik. Egy másik példában a mesterséges intelligencia zavarba ejtően azt mondta, hogy 2024 októbere és 2025 januárja között 738 523 nap van.

Rengeteg egyéb példa is kering a közösségi médiában, és a Google nagyon dolgozik ezek megoldásán (akár emberi felülvizsgálat, akár automatikus hangolás révén), amit az mutat, hogy most már nem mindegyiket lehet reprodukálni. Pár napja még az áttekintés azt írta, hogy a Sony PlayStation és a Sega Saturn 1993-ban volt megvásárolható (félreértelmezve a Wikipedia oldalát, amely egy 1993 és 1998 közötti konzolgenerációt ír le), de most már az AI Overview helyesen jelzi, az Atari Jaguar 1993-ban jelent meg, a Sony és a Sega konkurenciája pedig később.

"Kiterjedt tesztelést végeztünk az új élmény bevezetése előtt, és ezeket az elszigetelt példákat használjuk rendszereink további finomítására." - közölte a cég szóvivője. A Google azt is elmondta, hogy ellentesztelés segítségével a tényszerűség és a biztonság szempontjából egyaránt javítja a találatokat, és hogy a vállalat nem tervezi, hogy bizonyos explicit vagy veszélyes témák esetében MI-összefoglalókat jelenítsen meg. És bár az ilyen hibák tömkelegének látványa szembetűnő lehet, érdemes megjegyezni, hogy a közösségi médiában nem jelennek meg azok a gyakori példák, ahol a Google MI áttekintése a szándéknak megfelelően működött, tömör és pontos információkat szolgáltatva a világhálóról összeszedve. Mégis, amikor egy új rendszer azt tűzi ki célul, hogy megváltoztat valamit, ami olyan alapvető az interneten, mint a Google-keresés, érdemes megvizsgálni, hogy a rendszer hol is hibázik.

Ténybeli hibák természetesen a meglévő LLM chatbotokban is felbukkanhatnak. De az MI pontatlansága által okozott potenciális károk megsokszorozódnak, amikor ezek a hibák a Google keresési találati oldalának rendkívül értékes tetején jelennek meg. A Google mesterséges intelligencia-áttekintéseinek legviccesebb hibái akkor fordulnak elő, amikor a rendszer nem veszi észre, hogy egy online forrás vicces akart lenni. Egy MI-válasz például azt javasolta, hogy „Negyed csésze nem mérgező ragasztót” használjunk, hogy a sajt ne csússzon le a pizzáról - ez visszavezethető egy felhasználóra, aki egy fórumban akart trollkodni. Egy másik válasz „villogó folyadékot” ajánl az autók indexelési hangjához; ez egy tanácsadási fórum másik trolljához vezethető vissza, amely fórumot a Google nyilvánvalóan megbízható forrásként tart számon.

"Az általunk látott példák általában nagyon szokatlan lekérdezések, és nem reprezentálják a legtöbb ember tapasztalatait” - mondta az esetekkel kapcsolatban a Google szóvivője. „A mesterséges intelligencia áttekintések túlnyomó többsége kiváló minőségű információt nyújt, olyan linkekkel, amelyek segítségével mélyebbre lehet ásni a weben”. A szokásos Google-keresések során az internetfelhasználók ilyen tréfás bejegyzései valószínűleg nem lennének az első válaszok között, amelyeket valaki látna, amikor rákattint a weblinkek listájára. De az AI Overviews segítségével ezek a trollok bekerültek a hitelesnek tűnő adatösszefoglalóba, amely közvetlenül a találati oldal tetején jelenik meg. Ráadásul a Google MI-összefoglalója alatti apró „forráslink” dobozokban semmi sem utal arra, hogy ezek a fórumtrollok ne lennének jó információforrások.

Előfordul, hogy a Google mesterséges intelligencia áttekintése egy nem viccnek szánt forrás pontos összefoglalóját kínálja, amely történetesen téves. Amikor például arról kérdezzük, hogy a Függetlenségi Nyilatkozat aláírói közül hánynak volt rabszolgája, a Google AI Overview pontosan összefoglalja a Washington University of St. Louis könyvtárának oldalát, amely szerint egyharmaduk rabszolgatartó volt. A válasz azonban figyelmen kívül hagyja az egymásnak ellentmondó forrásokat, például a Chicago Sun-Times cikkét, amely szerint a valós válasz inkább háromnegyed.

A Google mesterséges intelligencia-áttekintésekben az egyik legfrusztrálóbb hibatípus az, amikor a rendszer egy kissé eltérő kérdésre ad némileg helyes választ. Az alaszkai szárazföld legdélebbi pontját keresve például az Aleut-szigetlánc legdélebbi részével kapcsolatos választ kapunk. Egy sziget definíció szerint nem része a szárazföldnek, de aki vakon megbízik a Google mesterséges intelligenciájában, az talán nem lesz ilyen óvatos. A szavakat alkotó betűkkel kapcsolatos kérdések is megzavarhatják a Google mesterséges intelligenciáját, például a rendszer szerint Catania egy olasz város, amely K-val kezdődik. Egy másik példában a mesterséges intelligencia zavarba ejtően azt mondta, hogy 2024 októbere és 2025 januárja között 738 523 nap van.

Rengeteg egyéb példa is kering a közösségi médiában, és a Google nagyon dolgozik ezek megoldásán (akár emberi felülvizsgálat, akár automatikus hangolás révén), amit az mutat, hogy most már nem mindegyiket lehet reprodukálni. Pár napja még az áttekintés azt írta, hogy a Sony PlayStation és a Sega Saturn 1993-ban volt megvásárolható (félreértelmezve a Wikipedia oldalát, amely egy 1993 és 1998 közötti konzolgenerációt ír le), de most már az AI Overview helyesen jelzi, az Atari Jaguar 1993-ban jelent meg, a Sony és a Sega konkurenciája pedig később.

"Kiterjedt tesztelést végeztünk az új élmény bevezetése előtt, és ezeket az elszigetelt példákat használjuk rendszereink további finomítására." - közölte a cég szóvivője. A Google azt is elmondta, hogy ellentesztelés segítségével a tényszerűség és a biztonság szempontjából egyaránt javítja a találatokat, és hogy a vállalat nem tervezi, hogy bizonyos explicit vagy veszélyes témák esetében MI-összefoglalókat jelenítsen meg. És bár az ilyen hibák tömkelegének látványa szembetűnő lehet, érdemes megjegyezni, hogy a közösségi médiában nem jelennek meg azok a gyakori példák, ahol a Google MI áttekintése a szándéknak megfelelően működött, tömör és pontos információkat szolgáltatva a világhálóról összeszedve. Mégis, amikor egy új rendszer azt tűzi ki célul, hogy megváltoztat valamit, ami olyan alapvető az interneten, mint a Google-keresés, érdemes megvizsgálni, hogy a rendszer hol is hibázik.