SG.hu

Az európai adatközpontok áramfogyasztása az évtized végére megháromszorozódik

Ha ez valóban beigazolódik, a szerverfarmok a kontinens elektromos energiaellátásának akár öt százalékát is elszívhatják.

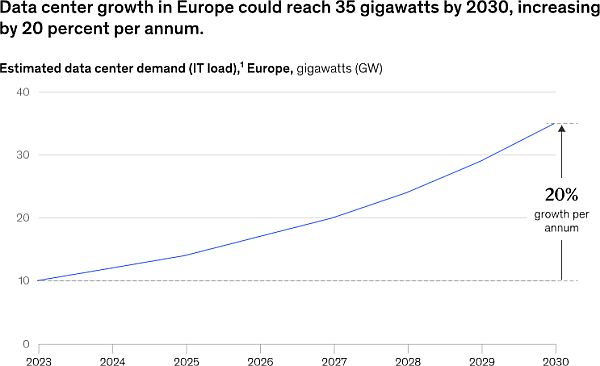

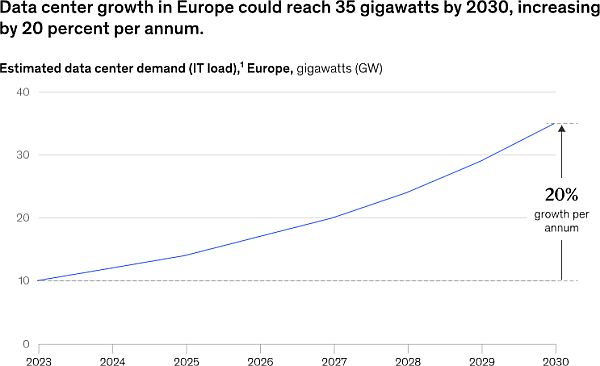

"Az elmúlt két évtizedben egyetlen technológia sem ösztönözte annyira az energiainfrastruktúra-fejlesztés szükségességét Európában, mint a mesterséges intelligencia” - írták az elemzők a McKinsey most közzétett jelentésében. A tanácsadó cég becslései szerint az európai adatközpontok áramfogyasztása az elterjedés jelenlegi üteme mellett 2030-ra eléri a 150 terawattórát (TWh) a mai 62 TWh-ról. A McKinsey becslése szerint az európai közműszolgáltatóknak körülbelül 25 gigawattnyi termelési kapacitást kell majd építeniük ahhoz, hogy az összes energiaéhes GPU-t - amelyet a generatív mesterséges intelligencia modellek és szolgáltatások képzésére és futtatására használnak majd - működtetni lehessen, és ennek nagy része a "zöld” fajtából kell, hogy származzon.

A McKinsey elemzői megjegyzik, hogy ez utóbbi részlet némi problémát jelent. "Az adatközpont-iparág nagy kihívás előtt áll, hogy dekarbonizálja a lábnyomát és elérje a nettó nullás célokat 2030-40-es évekre. Egyesek - köztük a Google korábbi vezérigazgatója, Eric Schmidt - azzal érvelnek, hogy nem kellene aggódnunk a mesterséges intelligencia energiaéhsége miatt, mert maga a technológia a legjobb esélyünk arra, hogy kezeljük az üvegházhatású gázok növekvő elterjedtségét. "Úgysem fogjuk elérni az éghajlati célokat, mert úgy vagyunk megszervezve, hogy ezt megtegyük” - ismerte el Schmidt egy nemrégiben Washingtonban tartott MI-csúcstalálkozón tartott előadásában.

Hacsak nem jön létre a mesterséges intelligencia éghajlati ígérete, a McKinsey szerint továbbra is a megújuló energiák a legnépszerűbb megoldások a felhő- és adatközpont-üzemeltetők számára a létesítményeik által termelt kibocsátások ellensúlyozására. A tanácsadó cég azonban úgy véli, hogy az ilyen rendszerek „ minimális hatással vannak az energiarendszerek hosszú távú kibocsátására, és ritkán ösztönzik új projektek fejlesztését vagy a tiszta energia előállítását”.

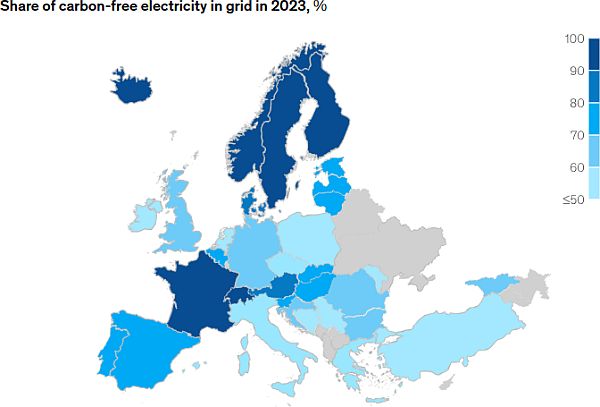

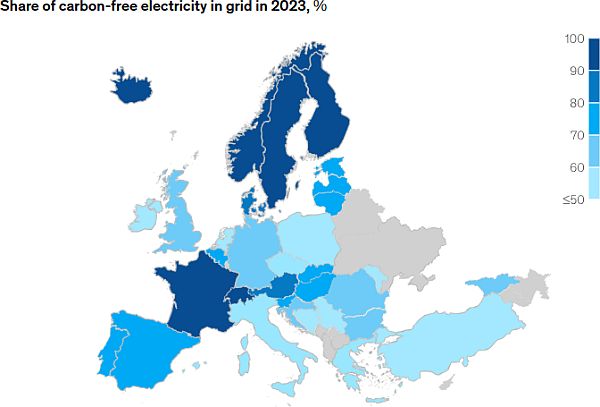

A mesterséges intelligencia hatásának csökkentésének egyik módja, ha az adatközpontokat olyan helyek közelébe helyezik, amelyek tiszta energiát termelnek. Ez a megközelítés akkor működhet a legjobban, ha ezekben a létesítményekben a modellek betanításához használt hardverek találhatók - ez a folyamat óriási mennyiségű számítási teljesítményt igényel, de nem kell fizikailag közel lennie a lakossági központokhoz. Ahogy azonban a mesterséges intelligencia munkaterhelésének összetétele a következtetés - a modellek tényleges futtatása - felé tolódik el, ez megváltozik, és a késleltetési követelmények azt fogják diktálni, hogy a létesítményeket városok közelében építsék meg.

Hosszú távon a McKinsey számos lehetséges megoldást vizsgált a szén-dioxid-leválasztástól kezdve a kis moduláris reaktorok segítségével történő helyszíni energiatermelésig. Az ilyen reaktorok az elmúlt hónapokban nagy figyelmet kaptak a felhőszolgáltatók részéről, annak ellenére, hogy kereskedelmi felhasználásra még egyet sem telepítettek. De a nukleáris energia nem az egyetlen lehetőség a helyszíni energiatermelésre, csak az egyik tisztább és energiatakarékosabb tétel. A dízelgenerátorok, üzemanyagcellák és a létesítményméretű akkumulátorok általában kiegészítő energiát biztosítanak, és kiegyenlítik a hálózati áramellátás ingadozásait.

Bár az adatközpontok energiafogyasztása várhatóan növekedni fog, a McKinsey egy másik friss jelentése szerint az európai energiaigény összességében elmaradhat a korábbi előrejelzésektől. A cég úgy véli, hogy az előrejelzett 460 TWh-s növekedés akár 40 százaléka sem kellhet. A McKinsey szerint a növekvő népesség és a bruttó hazai nyereség 2030-ig várhatóan hét százalékkal feljebb tornázza az energiafogyasztást az egész kontinensen. E tendenciák ellenére az elemzők megfigyelése szerint a kereslet valójában lelassult - nagyrészt az energiahatékonyság javulása, a szolgáltatásorientált gazdaságra való áttérés, az enyhébb telek és a magas energiaköltségek miatt, amelyek az iparosodás leépülésének tendenciájához vezettek.

"Az elmúlt két évtizedben egyetlen technológia sem ösztönözte annyira az energiainfrastruktúra-fejlesztés szükségességét Európában, mint a mesterséges intelligencia” - írták az elemzők a McKinsey most közzétett jelentésében. A tanácsadó cég becslései szerint az európai adatközpontok áramfogyasztása az elterjedés jelenlegi üteme mellett 2030-ra eléri a 150 terawattórát (TWh) a mai 62 TWh-ról. A McKinsey becslése szerint az európai közműszolgáltatóknak körülbelül 25 gigawattnyi termelési kapacitást kell majd építeniük ahhoz, hogy az összes energiaéhes GPU-t - amelyet a generatív mesterséges intelligencia modellek és szolgáltatások képzésére és futtatására használnak majd - működtetni lehessen, és ennek nagy része a "zöld” fajtából kell, hogy származzon.

A McKinsey elemzői megjegyzik, hogy ez utóbbi részlet némi problémát jelent. "Az adatközpont-iparág nagy kihívás előtt áll, hogy dekarbonizálja a lábnyomát és elérje a nettó nullás célokat 2030-40-es évekre. Egyesek - köztük a Google korábbi vezérigazgatója, Eric Schmidt - azzal érvelnek, hogy nem kellene aggódnunk a mesterséges intelligencia energiaéhsége miatt, mert maga a technológia a legjobb esélyünk arra, hogy kezeljük az üvegházhatású gázok növekvő elterjedtségét. "Úgysem fogjuk elérni az éghajlati célokat, mert úgy vagyunk megszervezve, hogy ezt megtegyük” - ismerte el Schmidt egy nemrégiben Washingtonban tartott MI-csúcstalálkozón tartott előadásában.

Hacsak nem jön létre a mesterséges intelligencia éghajlati ígérete, a McKinsey szerint továbbra is a megújuló energiák a legnépszerűbb megoldások a felhő- és adatközpont-üzemeltetők számára a létesítményeik által termelt kibocsátások ellensúlyozására. A tanácsadó cég azonban úgy véli, hogy az ilyen rendszerek „ minimális hatással vannak az energiarendszerek hosszú távú kibocsátására, és ritkán ösztönzik új projektek fejlesztését vagy a tiszta energia előállítását”.

A mesterséges intelligencia hatásának csökkentésének egyik módja, ha az adatközpontokat olyan helyek közelébe helyezik, amelyek tiszta energiát termelnek. Ez a megközelítés akkor működhet a legjobban, ha ezekben a létesítményekben a modellek betanításához használt hardverek találhatók - ez a folyamat óriási mennyiségű számítási teljesítményt igényel, de nem kell fizikailag közel lennie a lakossági központokhoz. Ahogy azonban a mesterséges intelligencia munkaterhelésének összetétele a következtetés - a modellek tényleges futtatása - felé tolódik el, ez megváltozik, és a késleltetési követelmények azt fogják diktálni, hogy a létesítményeket városok közelében építsék meg.

Hosszú távon a McKinsey számos lehetséges megoldást vizsgált a szén-dioxid-leválasztástól kezdve a kis moduláris reaktorok segítségével történő helyszíni energiatermelésig. Az ilyen reaktorok az elmúlt hónapokban nagy figyelmet kaptak a felhőszolgáltatók részéről, annak ellenére, hogy kereskedelmi felhasználásra még egyet sem telepítettek. De a nukleáris energia nem az egyetlen lehetőség a helyszíni energiatermelésre, csak az egyik tisztább és energiatakarékosabb tétel. A dízelgenerátorok, üzemanyagcellák és a létesítményméretű akkumulátorok általában kiegészítő energiát biztosítanak, és kiegyenlítik a hálózati áramellátás ingadozásait.

Bár az adatközpontok energiafogyasztása várhatóan növekedni fog, a McKinsey egy másik friss jelentése szerint az európai energiaigény összességében elmaradhat a korábbi előrejelzésektől. A cég úgy véli, hogy az előrejelzett 460 TWh-s növekedés akár 40 százaléka sem kellhet. A McKinsey szerint a növekvő népesség és a bruttó hazai nyereség 2030-ig várhatóan hét százalékkal feljebb tornázza az energiafogyasztást az egész kontinensen. E tendenciák ellenére az elemzők megfigyelése szerint a kereslet valójában lelassult - nagyrészt az energiahatékonyság javulása, a szolgáltatásorientált gazdaságra való áttérés, az enyhébb telek és a magas energiaköltségek miatt, amelyek az iparosodás leépülésének tendenciájához vezettek.