SG.hu

A Google meghamisította a Gemini MI képességeit bemutató videót

A Google Gemini MI-t bemutató videója hamisítvány: a GPT-4 versenytársáról készült anyag promóciója látszólag azt mutatja, hogy az új MI-modell felismeri a vizuális jeleket és valós időben hangilag interakcióba lép egy emberrel. Ezzel szemben viták után a Google is beismerte, hogy ez nem így volt: a kutatók állóképeket tápláltak a modellbe és a sikeres válaszokat összevágták, részben félrevezetve az embereket a modell képességeit illetően.

"A demót felvételek rögzítésével hoztuk létre, hogy a Gemini képességeit a kihívások széles skáláján teszteljük" - mondta a szóvivő. "Ezután a Geminit a felvételek állóképkockáinak felhasználásával és szöveges felszólítással ösztökéltük." Tehát a Google lefilmezett egy pár emberi kezet, amint valamilyen tevékenységet végez, majd ezekből állóképeket vágtak ki, és ezeket mutatták meg a Gemini Ultrának. A Google kutatói nem az MI-hez beszélve, hanem szövegesen léptek interakcióba a modellel, majd a válaszokból kiválasztották a legjobban sikerülteket és hangszintézissel együtt szerkesztették össze őket a videó elkészítéséhez.

Jelenleg az állóképek és szövegek hatalmas, nagyméretű nyelvi modelleken való futtatása rendkívül számításigényes, ami a valós idejű videointerpretációt nagyrészt kivitelezhetetlenné teszi. Ez volt az egyik olyan dolog, ami miatt a mesterséges intelligencia szakértői azonnal felvetették, hogy a videó félrevezető. "A Google videója úgy állította be, mintha a Gemini Ultrának valós időben lehetne különböző dolgokat mutatni és beszélgetni vele. Nem lehet" - írta Parmy Olson egy tweetben. A Google szóvivője azt mondta, hogy "a felhasználó hangja egy részlete a Gemini következő kimenetének előállításához használt tényleges felszólításoknak".

Az elmúlt évben a feltörekvő OpenAI zavarba hozta a Google-t azzal, hogy előretört a generatív MI-technológiában, amelynek egy része a Google kutatólaboratóriumának áttöréseire vezethető vissza. A keresőóriás az év eleje óta igyekszik felzárkózni, nagy erőfeszítéseket téve a ChatGPT versenytárs Bard és az olyan nagy nyelvi modellek, mint a PaLM 2 létrehozásával. A Google a Geminit az OpenAI GPT-4 első igazi riválisának állította be, amelyet még mindig széles körben a nagy nyelvi modellek piacvezetőjének tekintenek.

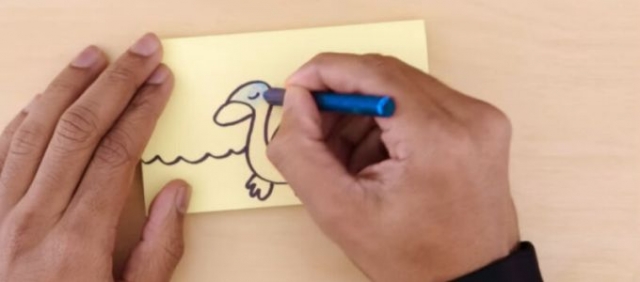

Eleinte úgy tűnt, hogy minden a terv szerint halad. A Google Gemini múlt heti bejelentése után a vállalat részvényei 5 százalékkal emelkedtek. De az MI-szakértők hamarosan elkezdték szétszedni a Google "kifinomult gondolkodási képességekről" szóló túlzó állításait, beleértve a nem sokat jelentő benchmarkokat, végül a Gemini promóciós videójára összpontosítottak, amelyet mi is beágyaztunk a hírünkbe, és amely meghamisított eredményeket tartalmazott. A vitatott videóban - amelynek címe "Hands-on with Gemini: Interacting with multimodal AI" - egy nézetet látunk arról, amit az MI-modell látszólag lát, azt pedig a képernyő jobb oldalán az MI-modell válaszai kísérik. A kutató szaggatott vonalakat és kacsákat rajzol, és megkérdezi Geminit, hogy mit lát. A néző egy hangot hall, nyilvánvalóan Gemini Ultra hangját, amely válaszol a kérdésekre.

A videóból az sem derül ki, hogy a felismerési demó valószínűleg a Gemini Ultra-t használja, amely még nem elérhető. "Az ilyen részletek elhallgatása a szélesebb körű marketingtevékenységre utal: A Google azt akarja, hogy arra emlékezzünk, hogy neki van a világ egyik legnagyobb MI-kutatói csapata, és több adathoz fér hozzá, mint bárki más" - írta Olson. Ki kell emelni, hogy a Gemini képfelismerő képessége remek, és úgy tűnik, nagyjából egy szinten vannak az OpenAI multimodális GPT-4V (a látással kiegészített GPT-4 ) mesterséges intelligenciamodelljének képességeivel, amely az állóképek tartalmát is képes felismerni. De reklámcélokra összevágva a Google Gemini modellje többet állít magáról, mint amennyire képes, és ez sokaknak nem tetszik.

"Nem tudok nem gondolkodni ennek a demónak a következményein" - tweetelte a TED szervezője, Chris Anderson. "Biztos nem őrültség arra gondolni, hogy valamikor jövőre egy kezdő Gemini 2.0 részt vehet egy igazgatósági ülésen, elolvashatja a tájékoztató dokumentumokat, megnézheti a diákat, meghallgathatja mindenki szavait, és intelligens módon hozzájárulhat a megvitatott kérdésekhez? Most mondja meg nekem. Ez nem számítana AGI-nek?" Grady Booch szoftvermérnök válaszolt neki: "Azt a demót úgy szerkesztették meg, hogy azt sugallja, hogy a Gemini sokkal többre képes, mint amennyire valójában. Becsaptak téged, Chris. És szégyelljék magukat ezért."

"A demót felvételek rögzítésével hoztuk létre, hogy a Gemini képességeit a kihívások széles skáláján teszteljük" - mondta a szóvivő. "Ezután a Geminit a felvételek állóképkockáinak felhasználásával és szöveges felszólítással ösztökéltük." Tehát a Google lefilmezett egy pár emberi kezet, amint valamilyen tevékenységet végez, majd ezekből állóképeket vágtak ki, és ezeket mutatták meg a Gemini Ultrának. A Google kutatói nem az MI-hez beszélve, hanem szövegesen léptek interakcióba a modellel, majd a válaszokból kiválasztották a legjobban sikerülteket és hangszintézissel együtt szerkesztették össze őket a videó elkészítéséhez.

Jelenleg az állóképek és szövegek hatalmas, nagyméretű nyelvi modelleken való futtatása rendkívül számításigényes, ami a valós idejű videointerpretációt nagyrészt kivitelezhetetlenné teszi. Ez volt az egyik olyan dolog, ami miatt a mesterséges intelligencia szakértői azonnal felvetették, hogy a videó félrevezető. "A Google videója úgy állította be, mintha a Gemini Ultrának valós időben lehetne különböző dolgokat mutatni és beszélgetni vele. Nem lehet" - írta Parmy Olson egy tweetben. A Google szóvivője azt mondta, hogy "a felhasználó hangja egy részlete a Gemini következő kimenetének előállításához használt tényleges felszólításoknak".

Az elmúlt évben a feltörekvő OpenAI zavarba hozta a Google-t azzal, hogy előretört a generatív MI-technológiában, amelynek egy része a Google kutatólaboratóriumának áttöréseire vezethető vissza. A keresőóriás az év eleje óta igyekszik felzárkózni, nagy erőfeszítéseket téve a ChatGPT versenytárs Bard és az olyan nagy nyelvi modellek, mint a PaLM 2 létrehozásával. A Google a Geminit az OpenAI GPT-4 első igazi riválisának állította be, amelyet még mindig széles körben a nagy nyelvi modellek piacvezetőjének tekintenek.

Eleinte úgy tűnt, hogy minden a terv szerint halad. A Google Gemini múlt heti bejelentése után a vállalat részvényei 5 százalékkal emelkedtek. De az MI-szakértők hamarosan elkezdték szétszedni a Google "kifinomult gondolkodási képességekről" szóló túlzó állításait, beleértve a nem sokat jelentő benchmarkokat, végül a Gemini promóciós videójára összpontosítottak, amelyet mi is beágyaztunk a hírünkbe, és amely meghamisított eredményeket tartalmazott. A vitatott videóban - amelynek címe "Hands-on with Gemini: Interacting with multimodal AI" - egy nézetet látunk arról, amit az MI-modell látszólag lát, azt pedig a képernyő jobb oldalán az MI-modell válaszai kísérik. A kutató szaggatott vonalakat és kacsákat rajzol, és megkérdezi Geminit, hogy mit lát. A néző egy hangot hall, nyilvánvalóan Gemini Ultra hangját, amely válaszol a kérdésekre.

A videóból az sem derül ki, hogy a felismerési demó valószínűleg a Gemini Ultra-t használja, amely még nem elérhető. "Az ilyen részletek elhallgatása a szélesebb körű marketingtevékenységre utal: A Google azt akarja, hogy arra emlékezzünk, hogy neki van a világ egyik legnagyobb MI-kutatói csapata, és több adathoz fér hozzá, mint bárki más" - írta Olson. Ki kell emelni, hogy a Gemini képfelismerő képessége remek, és úgy tűnik, nagyjából egy szinten vannak az OpenAI multimodális GPT-4V (a látással kiegészített GPT-4 ) mesterséges intelligenciamodelljének képességeivel, amely az állóképek tartalmát is képes felismerni. De reklámcélokra összevágva a Google Gemini modellje többet állít magáról, mint amennyire képes, és ez sokaknak nem tetszik.

That demo was incredibly edited to suggest that Gemini is far more capable that it is.

— Grady Booch (@Grady_Booch) December 7, 2023

You’ve been deceived, Chris. And shame on them for so doing.

"Nem tudok nem gondolkodni ennek a demónak a következményein" - tweetelte a TED szervezője, Chris Anderson. "Biztos nem őrültség arra gondolni, hogy valamikor jövőre egy kezdő Gemini 2.0 részt vehet egy igazgatósági ülésen, elolvashatja a tájékoztató dokumentumokat, megnézheti a diákat, meghallgathatja mindenki szavait, és intelligens módon hozzájárulhat a megvitatott kérdésekhez? Most mondja meg nekem. Ez nem számítana AGI-nek?" Grady Booch szoftvermérnök válaszolt neki: "Azt a demót úgy szerkesztették meg, hogy azt sugallja, hogy a Gemini sokkal többre képes, mint amennyire valójában. Becsaptak téged, Chris. És szégyelljék magukat ezért."