158

-

Borg #96 Egyébként nézzen be mindenki a fórum megfelelő topicjaiba is. Ott több az infó.

Már aki ugye nem csak unreg vállalja a véleményét... -

#94

#94

Nem, az csak kb. 1/1,5 órás megingás volt mikor valós hínek tűnt az hogy 20%-al leveri, de már magamhoztértem. (vagy gépezni kéne kevesebbet, vagy inni pár órával előtte) -

#93

#93

Azt hogy hasonló módon jár el az ATI, vagyis csak később reklámozza be a PS/VS3.0-t mire elfelejtik hogy ezzel az NV újjított be ha nem is túl nagyot. De akkor más senki nem mondja: "Minek a PS3..., mi?" hanem megalapozott döntés lessz az ATI részéről hogy 3 hónapot várt vele, mert ennyi idő kellett a kifutásához. -

Borg #92 Teljesen igazad van azzal amit irsz.

Egyébként a D3 nem DX8.1 lesz, legalább olyan jó motort kap mint a HL2. Csak éppen a D3 az NV40, a HL2 meg az R420 (3Dc) tudását fogja jobban kihasználni.

Másrészt Linux driver van az ATI-khoz is már régóta.

RpPRO-val pedig egyetértek, egyik kártya sem rossz. Viszont felhasználói szemszögből, ha ma kártyát kellene vennem ennyi pénzért, minden elfogultság nélkül az ATI-t választanám, pusztán azért, mert átlagosan ugyanolyan teljesítményt nyújt, és nem kell hozzá új tápot, és fülvédőket vennem. Ennyi. -

Borg #90 Úgyérted úgy, ahogy az nVIDIA most az adaptív anizotróp szűrést, és a HDM-et is újként harangozta be, holott az R300 már 2 éve tudja?:)) psszt... -

RpPRO #89 En Ati parti vagyok, megis feleslegesnek velem ezt a veszekedest. Tegyuk fel, h. veszunk egy 6800-at vagy egy x800-at. Es akkor mi van? Ezek a kereszok joval meghaladjak a korukat, nem nagyon izzadnak meg egy jatek alatt sem. Plane nem akkor, ha egy 'atlagos' 2.6 gigas proci hajtja meg oket. A procik sokkal lassabban fejlodnek, a mai csucs nem kepes kiszolgalni ezeket. En 5 gigas procit tennek alajuk, akkor mar nem lenne bottleneck :) -

#87

#87

Ja, majd a következő kártyán ÚJJÍTÁSként reklámozzák be a PS/VS3.0-t, ezért "nem nevezik nevén" mire elfelejtik az emberek hogy a 6800U-n van és azon már értelme is lessz mindenkiszerint.

-

John Wayne #86 Wow. Rég olvastam ennyi zöldséget (a hozzászólásokra gondolok). Bár vannak értelmes emberek is itt. Szerintem a mostani játékokkal az ATI kártyája a jobb (már csak azért is, mert halkabb, meg kisebb fogyasztású, teljesítmény kb. egál), hogy a jövőbeliekkel mi lesz a helyzet, azt a Jó Istenen kívül még senki nem tudja, úgyhogy kár rajta vitatkozni. Most ATIt vennék, hirtelen felindulásból. Nem hiszem, hogy túl hamar elterjednének az Nvidia kártya egyébként biztos szuper újításai. Javítsatok ki, ha hülyeséget mondok, de a DOOM3 emlékeim szerint DX8.1-re épül, a HL2 DX9-re. Mellesleg a Valve erősen ATI párti, szóval tuti ATI vason fog jobban futni a cucc. Új grafikai motort fejleszteni nem két perc, és persze a meglévőknek is ki kell termelni a befektetett pénzt és némi hasznot is:). Szóval nem hinném, hogy két éven belül shader 3-as progik tömegével fogunk találkozni. Szóval per pill nem látok okot rá, hogy Nvidia kártyát vegyek, max. a Linux drivertám miatt. De végül is egy frankó kis kártya a 6800-as, ha valakinek az a szíve vágya, vegyen belőle egy kosárra valót, mit bánom:). -

Borg #84 És akár hiszed, akár nem, tényleg benne volt a 3DFx keze a dologban ;) -

Borg #81 Hogyhogy senki? Szerintem mindenki látja, még a cikk is leirja. Csak éppen semmi jelentősége nincs.

De ha mindenáron bele akarsz kötni a színmélység témába, akkor inkább ott kellene kezdeni, hogy az NV30-40 is miért butít FP16-ra, amikor csak kedve van... -

Borg #80 Ezen nem kell gondolkozni.

Az nVIDIA partnerei (igen, még az IBM sem) nem tértek még át a low-k technológiára, és ráadásul az NV40be egy kupac felesleges tranzisztor is került.

Félreértés ne essék, a feleslegest csak azért irtam, mert a tesztekben egyértelműen látható, hogy semmire nem ment a +62 millió tranzisztorával az R420-al szemben. -

#78

#78

Szerintem ha az ATi kártyájának nincs szüksége 100W-ra, akkor az nVidia helyében elgondolkoznék azon, hogy az NV40-nek miért van... -

Borg #77 Gondolkozni inkább neked kellene. A videokártya ugyanis nem csak a tápcsatin keresztül vesz fel áramot, másrészt nem floppy tápcsati van az X800-on.

Ugyanez vonatkozik az "Ami az ATI-t nagyon érzékenyen fogja érinteni" kijelentésre, aminek logikusan nulla valóságalapja van... -

Borg #76 Néhány érdekes konklúió az xbitlabs tesztjéből:

"So, according to the results obtained in Xbitmark, we can conclude that texturing samples in the shaders are a weak spot of the new RADEON X800, while mathematical calculations, on the contrary, are a strength of the new ATI architecture."

"Well, it seems that the new ATI Technologies’ graphics processors feel themselves like a fish in the water in situations when they have to render extremely complex scenes. NVIDIA’s GeForce 6800 Ultra brings us some good speed too, but is behind the rival under heavy load – that’s for sure."

Itt pedig az ATI CEO (Dave Orton) interjú

Érdemes elolvasni, amit a gyártási kihozatalról, és az NV40-ről ir... (persze, nem független forrás, de eléggé elgondolkodtató) -

Borg #73 Én nem hallottam más teljes játékról.. de lehet.

Amúgy itt nem arról van szó, hogy ne lenne jó dolog a PS3, ezt senki sem mondta. Csak egyesek szeretnék túlzottan is túldimenzionálni a jelentőségét. Holott ma BIZTOSAN semmi szerepe, holnap ugyancsak BIZTOSAN nem lesz semmi szerepe, majd ESETLEG néhány hónap múlva.

Emlékezzetek csak arra, hogy az ATI VPU-i nem bridge chippel térnek át a PCI Expressre, mint az nVIDIA cuccok, hanem natív támogatás kerül beléjük, tehát lényegében ÚJ VPU-RÓL BESZÉLÜNK 3 hónapon belül (R423). Itt pedig még BÁRMI olyan lemaradást behozhat az ATI, amire NETÁN időközben szükséget teremt az nVIDIA marketing gépezete. Ez az érem másik oldala. -

Borg #69 Csak 2 kérdés:

Ugye az X800XT és a 6800 Ultra eredményeit hasonlitottad össsze?

És ugye azt is tudod, mi az a partial precision?

Ha ezekre igennel válaszolnál, nem irtál volna ekkora hülyeséget. -

#68

#68

"...két molex csatira. Nagyon okosan"

NAGYON OKOSAN??? LOL! Te mekkora baromságokat írsz!

Arról meg ne is beszéljünk, hogy mekkora égés a kártya fogyasztása. Jöttök itt azzal, hogy DirectX 9.0c - nos az ATi, csak a PS3.0 hiánya miatt marad "b", de - mint olvashattátok - azért rengeteg dolog belekerült az X800-ba, ami túlmutat a PS2.0-n.

Ezen kívül: "mekkora erőtartalék van az NV40-ben" - LOL: és az X800-ban szerintetek nincs? Vajh miért van az, hogy képminőségben MÉG MINDÍG az ATi vezet torony magasan, emellett ha az anizotropikus szűrést is bekapcsolod, akkor igen nagyon ráver az nVidia kártyájára.

Aszongyátok, hogy azért kell az NV40-nek a qrva magas fogyasztás, mert hűdemilyengyorslesz, ésatöbbi. Meg a +sokmillió tranzisztor. Ez mind csak BLABLA.

Akkor az ATi vajon hogy tudta megcsinálni, hogy a legújabb kártyája még a 9800XT-nél is kevesebbet fogyaszt, miközben a teljesítménye drasztikusan nőtt...??? A mostani 9800-as (sima, pro, xt) kártyákat PASSZÍV HŰTÉSSEL lehet hűteni (ZALMAN borda, és ha a 9800XT-t lehet, akkor az X800-ast is, ami kevesebbet fogyaszt ugye...), ezt mikor fogod megtenni az NV40-nel??? NA EZ A LOL! :) -

Borg #61 Másrészt NV40 és R420 már fél évvel ezelőtt is volt a fejlesztők kezében. Még ha nem is teljesen ez a verzió, amely ebben a hónapban a polcokra kerül. Carmack is elmondta. -

valaé valaé ná #60 De ebből az is következik, hogy jelenleg (és a közeljövőben) az ati 9700 nak van értelme. -

Borg #59 Gondolom itt arra a pár darab idejétmúlt Quake3 motorra épülő OpenGL-es játékra gondolsz.

Tény, hogy OpenGL-ben van mit fejlődnie az ATI-nak, azonban ez PUSZTÁN DRIVER kérdés, és nem hardver. -

Borg #58 Én nem azt mondtam, hogy nincs még ami kihasználja, hanem azt, hogy mindeddig nem volt. Nagy különbség.

Az első játék, amely NYOMOKBAN PS2-t használt a TRAOD volt, az első olyan, ami pedig viszonylag rendesen kihasználja, a mostani Far Cry.

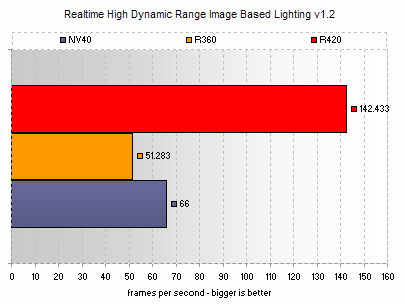

Egyébként pont az RTHDRIBL demóra visszatérve, íme a teljesítmények:

-

valaé valaé ná #54 Óva intenék mindenkit attól, hogy egy kicsit is aggódjon az ATi miatt. :)

Nekem nagyon úgy tűnik, hogy jelentős tartalékai vannak technológiai téren de úgy gondolja, hogy cseppenként adagolja, mert az nvidiával szemben jelenleg ez is elég.

Úgy sejtem, hogy a következő generációs ATi kártya megint nagyot fog szólni. -

Cat #53 az első ps 2.0t tudó kártya ha jól tudom a radeon 9700 volt, ami két éve jelent meg. Ennyi idő alatt két videókártya generáció jött ki, szal majd a gf6800asnak is lesz értelme 2 év mulva :> -

Borg #51 Érdekes, ahogy egypár ember próbálja itt beskatulyázni a cikket (cikkeket) mint ATI elfogult... és közben nem veszik észre, hogy ők meg pont a másikra verik a nyálukat minden második szavukkal.

Holott a cikk végén is egyértelműen ott van, hogy nincs győztese a tesztnek, a dolgok a támogatottságon, és az áron múlnak.

Sőt, az is ott áll kerek perec, hogy az NV40 előnye a PS3, az ATI-é meg sokkal jobb fogyasztás, azonos teljesítmény mellett.

Egyátalán nem lett lehúzva egyik kártya sem, mindkettőnek ki van emelve a pozitivuma, és a negativuma is.

Ugyanugy, ahogy a 9700 PS2.0-ját egész idáig nem használta ki semmi, ugyanúgy nem fogja a PS 3.0-t sem. Szimpla döntés volt arról, hogy mi a fontosabb. Belepumpáltak pluszban 62 millió tranzisztort az NV40be, hogy tudjon valami olyant, amire nincs szükség, de csillivilli... Emiatt viszont sokkal rosszabb lesz a kihozatal, és jobban is melegszik. El lehet dönteni volt e értelme. -

kev #47 "A tegnap óta letölthető új ForceWare driver a hírek szerint jelentősen megnöveli az új GeForce széria teljesítményét.

A VR-Zone oldalon megjelent hír alapján, a 61.11-es meghajtó verzió jelentős gyorsulást ígér, a 60.72-es meghajtóval szemben.

~5% Aquamark

~5% X2

~5% Tomb Raider: Angel of Darkness

~10% Call of Duty

több mint 20% Far Cry

A fenti gyorsulás természetesen az NVIDIA új zászlóshajójára, a GeForce 6800-as szériára értendő. A régebbi kártyákon mért teljesítményről nem esik szó a hírben." -

Cat #46 hát ha már 126 cikket olvastál el, és mindenhol "ati bérencek" vannak, akkor lehet hogy nem ők hajtanak a forgalommal szemben, hanem te

-

#45

#45

Ilyen az emberi természet! ;-) -

Flashy #43 ugyanaz a hulyeseg mint az intel-amd vitaban. nem lehet osszehasonlitani a kettot. egyik gyorsabban szoroz, masik gyorsabban oszt. na melyik a jobb. -

Flashy #40 jezusom de hulyek vagytok. hogy a fenebe lehet az ezredik cikk utan is ujra meg ujra a ket kartya osszehasonlitasan veszekedni? -

kev #38 Ha a külsőt vesszük, akkor az Ati kártyáját jobbnak nevezhetjük, kisebb fogyasztás, méret, hűtés. De ha azt vesszük hogy az nvidia óriási pénzeket szór szét a fejlesztők között, hogy az ő kártyáját támogassák, továbbá új technologiákat is tartalmaz a 6800, akkor egyensúlyba billen a mérleg.

Végső soron minden az ártól és a támogatottságtól függ.) -

RpPRO #37 Ma mar korantsem minden a nyers ero. Nem csak az szamit, h mi hany MHz-en mukodik. Az is nagyon fontos, h mire optimalizalnak. Ebben sajnos atinak jelentos a lemaradasa.... Itt van ez az uj 3Dc textura tomorites atitol. Szerintem ez is eltunik majd a sullyesztoben, mint a trueform technika :/ A 6800-nak sztem a 9700 koraban kellett volna kijonnie (technikailag ertem, nyilvan alacsonyabb frekikkel), mert vegre nagyjabol kijavitottak a gyengesegeiket (shaderes teljesitmeny, AA, anisotrophic es trilinear filtering) es csinaltak egy utos kartyat. Azt azonban meg mindig latni kell, h. brutal shaderes hasznalat mellett egyes esetekben 20-30% az ati uj kareszanak elonye, szoval ha vegre ki tudjak hasznalni a +62 millio tranzisztort, akkor az x800 fole tudnak majd noni. Sztem. -

Geza ba #34 természeten=természetesen -

Geza ba #33 Elég egyeszerű: 3DMark03 alatt többet tölt a program, mint aktívan tesztel (időarányosan természeten :) -

Cat #32 és szerinted egy két évvel régebbi progi ennyivel jobban megdolgoztatja a vidkártyát? én pont fordítva gondolnám helyesnek az értékeket -

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #30

#30

Most olvastam, a fogyasztáshoz vitához:

Avg. continuous power draw while looping 3DMark03: X800 Pro - 49W, X800 XT - 65W

Avg. continuous power draw while looping 3DMark01: X800 Pro - 58W, X800 XT - 76W

Magyarítva:

Átlagos fogyasztás folyamatosan futó 3DMark2001/3Dmark'03 alatt:

X800Pro: 58/49Watt

X800XT: 76/65Watt

OFF:

Valaki elárúlná mi a rákért lehet ekkora különbség a két program futattása alatt? Ennyit számítana, hogy a VPU milyen részeit használja a benchmark? -

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #27

#27

Személy szerint ezt tartom az X800 egyetlen valóban kritizálható pontjának, ahol akár el is vérezhet (!!!).

Az nVidia elég tőkeerős cég, és eddig is komolyan támogattot játékfejlesztő cégeket - nyilván, hogy most minden követ meg fog mozgatni a PS3.0 alkalmazásához, és figyelembe véve a trendeket, sokszor fogunk még arról olvasni, hogy ez-meg-az a játék támogatja alapból a PS3.0-át, amit ugye jelenleg csak és kizárólag a GeForce 6800 család tud. Csak várjuk meg az E3-at, és csodálkoznék, ha ott nem lenne legalább jópár ilyen bejelentés majd... :)

Szóval az ATi részéről ez a lépés kissé ingoványos talajt ért, kérdés, hogy a vásárlók hogy fognak dönteni... -

![[NST]Cifu [NST]Cifu](https://media.sg.hu/forum/avatars/10356591011409433815.png) #25

#25

hát én még nem hallottam mennyire hangos, illetve thermo szabályzott-e a ventilator fordulatszáma.

Hőérzékelős fordulatszámszabályozás van benne, mint az FX-ekben, de ha felpörög akkor bizony nagyon hangos a refkártya a tesztek szerint (valami 40-45db körüli értékről rebesgettek, de persze ez a gyártók egyéni hűtésétől is függeni fog).

Mennyivel fogyaszt többet?

Mármint mi? A Geforce 6800Ultra olyan 110-120 Watt körül eszik. A Radeon 9800XT olyan 81 Watt körül, de az 0,15 mikronos (X800: 0,13 mikron), ráadásul nem low-k gyártástechnológia, amit az X800 magáénak tudhat. Szóval ezek alapján a fogyasztása semmiképpen nem lehet a Radeon 9800XT fölött. Ami még így is 30-40 Wattal kevesebb, mint a GeForce 6800Ultráé.

Egy mai hardcore gamer, jól leterhelt, zsúfolt gépébe, 300W-550W-s acorp, mercury, codegen tápos házba beraknád nyugodt szívvel akár az X800-t is?

Aki hardcore gamer, és ilyen tápegysége van, az meg is érdemli, ilyenbe még egy 9800Pro-t sem mernék rakni :)))

Aki meg több, mint hatvan-hetvenezer forintott áldoz egy videókártyára, az ne sajnáljon már egy húsz-harmincezer forintott egy jó tápegységre. Nem csak a videókártya miatt, hanem az egész gépére való tekintettel.

Azért az a plusz 62 milla tranyó NV-ben feltételez valamit a jövőre tekintve;-)

Pardon, de anno a GeForce FX-eknél volt a tranyómennyiség terén az előny ha jól tévedek. Szóval ez önmagában nem ad okot semmire...

Mielőtt újabb flamehullám kezdődne erre reagálva, elmondanám, hogy személy szerint nem tartom rossz kártyának a GeForce 6800-at, legalábbis ami a teljesítményét és a képességeit illeti. Amit viszont nehezen vesz be a gyomrom, az az extrén energiafelvétel és a nagy hőledás és az abból adódó komoly hűtésigény. Remélem az nVidia ahogy anno a GeForce FX5800 után gyorsan revizitálta a GPU-t, és kihozta az annál sokkal versenyképesebb FX5900-at, úgy képes lesz itt is felülkerekedni a nehézségeken (és ő is sikerrel átáll a low-k gyártástechnológiára, ami miatt kisebb fogyasztás, kevesebb hőtermelés, és ezáltal kisebb hűtés is elég lenne, illetve nagyobb elérhető működési frekvencia lehetséges). Drukkolok nekik. -

Cat #24 ezért mondom én azt, hogy mivel a játékfejlesztés több éves folyamat, nagyon sokáig nem, és addigra már ugyis itt a kövekkező generációs vidkártya... -

RpPRO #23 Summazom egy idezettel ([H]ard|OPC) egy masik forumon leirt velemenyem: "Technically the X800 series, and going all the way back to the Radeon 9700 series, support point sampled Displacement Maps via N-Patches, while the 6800Ultra supports filtered Displacement Mapping via vertex texture lookups in VS 3.0. But it all depends on what developers use in games. If developers never use it, it is a useless feature. SM3.0 is an extension of SM2.0 and adds mostly performance enhancements, as well as possibly easier programming for developers." Nem kerdes, tobbet tud joval a 6800, az a kerdes, h. tenyleg ki lesz-e ez hasznalva. -

#22

#22

#1" TARGET=_fnew>idézet tőled <===#1