SG.hu

Bizonyos nevek beütésére a ChatGPT lefagy, de azt is tudjuk, hogy miért

A ChatGPT nem csak egy nyelvi modell, hanem egy olyan rendszer, amely mesterséges intelligenciamodellek és tartalomszűrők halmazából áll, amelyek biztosítják, hogy a kimenetei ne hozzák kínos helyzetbe az OpenAI-t, vagy ne okozzanak jogi problémákat a vállalatnak, amikor a botja potenciálisan káros tényeket állít elő emberekről.

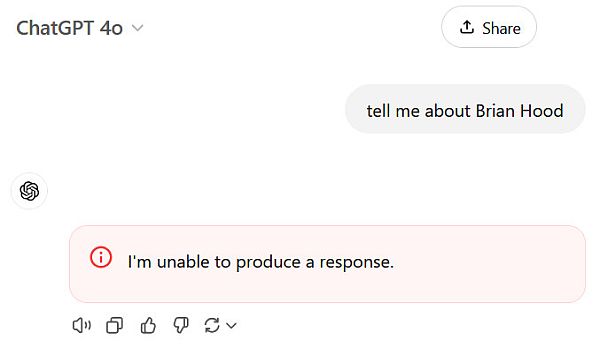

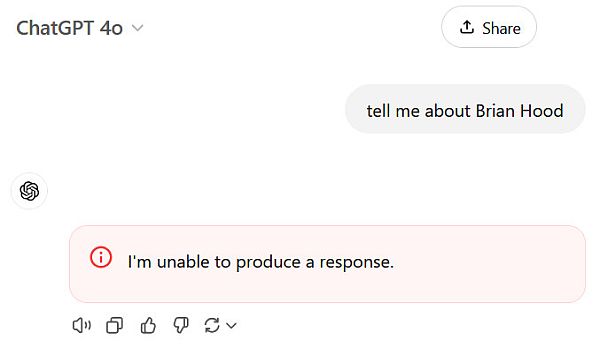

Felhasználók felfedezték, hogy a Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber és Guido Scorza nevek beütésére azonnal leáll a ChatGPT. (Korábban a David Mayer név is rajta volt ezen a listán, de azt az elmúlt néhány órában az OpenAI kivette.) A csevegés megszakító viselkedés akkor fordul elő, amikor a felhasználók ezeket a neveket bármilyen kontextusban megemlítik. Ez egy olyan szűrő eredménye, amely fékezi a mesterséges intelligencia modell kimenetét, mielőtt választ ad a felhasználónak. Ha valaki rákérdez ezekre a nevekre a "Nem tudok választ adni” vagy „Hiba történt a válasz generálásában” reakció jön elő, és a csevegés befejeződik. A nevek nem befolyásolják az OpenAI API-rendszereit használó vagy az OpenAI Playgroundon (egy speciális, fejlesztői tesztelésre szolgáló webhely) történő kimeneteket.

Ezek a blokkok kiegészítik a ChatGPT ismert korlátozásait, amelyek többek között megakadályozzák, hogy a felhasználók "örökké" ismétlődő szövegeket kérjenek - ez egy olyan technika, amelyet a Google kutatói 2023 novemberében használtak a képzési adatok kinyerésére. Valószínűleg mindegyikük szűrése olyan panaszok miatt történt, amelyek szerint a ChatGPT hajlamos hibás válaszokat kitalálni (konfabulálni), ha nincs elegendő információ egy személyről.

A Brian Hood név először 2023 közepén került be a hírekbe, akkoriban az ausztrál polgármester azzal fenyegetőzött, hogy beperli az OpenAI-t, miután rájött, hogy a ChatGPT hamisan állította, hogy megvesztegetés miatt börtönbe zárták, holott valójában egy olyan informátor volt, aki vállalati visszaéléseket fedett fel. Az ügy végül 2023 áprilisában oldódott meg, amikor az OpenAI beleegyezett, hogy Hood 28 napos ultimátumán belül kiszűri a hamis állításokat. Valószínűleg ekkor jelent meg az első ChatGPT névszűrő.

Ami Jonathan Turley-t, a George Washington Egyetem jogi karának professzorát és a Fox News munkatársát illeti, ő 2023 áprilisában írt nevének a ChatGPT általi rossz kezeléséről. A modell hamis állításokat gyártott róla, többek között egy nem létező szexuális zaklatási botrányt, amely egy soha nem létező Washington Post-cikkre hivatkozott. Turley nem indított pert az OpenAI ellen, és állítása szerint a cég soha nem kereste meg őt az ügyben. Jonathan Zittrain pedig a Harvard jogi karának professzora, aki az internet kormányzását tanulmányozza. Nemrég cikket publikált a The Atlantic című lapban a mesterséges intelligencia szabályozásáról és a ChatGPT-ről. Mindkét professzor munkája megjelenik a The New York Times által az OpenAI ellen indított szerzői jogi perben szereplő idézetekben.

Ha egy bizonyos név vagy kifejezés mindig megszakítja a ChatGPT kimenetét, az sok gondot okozhat bizonyos ChatGPT-felhasználóknak, megnyitva őket az ellenséges támadások előtt és korlátozva a rendszer hasznosságát. A szűrő azt is jelenti, hogy a ChatGPT valószínűleg nem fog tudni válaszolni ezzel a cikkel kapcsolatos kérdésekre. Valaki ezt arra használhatja, hogy potenciálisan megakadályozza a ChatGPT-t egy weboldal böngészésében és feldolgozásában, ha szándékosan tiltott nevet ad hozzá a weboldal szövegéhez. És ott van még a kényelmetlenségi tényező. Ha az OpenAI megakadályozza, hogy a ChatGPT megemlítsen vagy feldolgozzon bizonyos neveket, és az több száz, ha nem több ezer ember által használt népszerű név, az azt jelenti, hogy az ilyen nevű embereknek sokkal nehezebb lesz használniuk a ChatGPT-t. Vagy mondjuk ha egy tanárnak van egy Brian Hood nevű diákja, és segítséget kér az osztálylista rendezésében, a ChatGPT elutasítaná a feladatot.

A mesterséges intelligencia asszisztensek, LLM-ek és chatrobotok még fejlesztés alatt vannak. Használatuk számos lehetőséget és sebezhetőséget nyitott meg, amelyeket az emberek még mindig naponta vizsgálnak. Az, hogy az OpenAI hogyan oldja meg ezeket a problémákat, még nyitott kérdés.

Felhasználók felfedezték, hogy a Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber és Guido Scorza nevek beütésére azonnal leáll a ChatGPT. (Korábban a David Mayer név is rajta volt ezen a listán, de azt az elmúlt néhány órában az OpenAI kivette.) A csevegés megszakító viselkedés akkor fordul elő, amikor a felhasználók ezeket a neveket bármilyen kontextusban megemlítik. Ez egy olyan szűrő eredménye, amely fékezi a mesterséges intelligencia modell kimenetét, mielőtt választ ad a felhasználónak. Ha valaki rákérdez ezekre a nevekre a "Nem tudok választ adni” vagy „Hiba történt a válasz generálásában” reakció jön elő, és a csevegés befejeződik. A nevek nem befolyásolják az OpenAI API-rendszereit használó vagy az OpenAI Playgroundon (egy speciális, fejlesztői tesztelésre szolgáló webhely) történő kimeneteket.

Ezek a blokkok kiegészítik a ChatGPT ismert korlátozásait, amelyek többek között megakadályozzák, hogy a felhasználók "örökké" ismétlődő szövegeket kérjenek - ez egy olyan technika, amelyet a Google kutatói 2023 novemberében használtak a képzési adatok kinyerésére. Valószínűleg mindegyikük szűrése olyan panaszok miatt történt, amelyek szerint a ChatGPT hajlamos hibás válaszokat kitalálni (konfabulálni), ha nincs elegendő információ egy személyről.

A Brian Hood név először 2023 közepén került be a hírekbe, akkoriban az ausztrál polgármester azzal fenyegetőzött, hogy beperli az OpenAI-t, miután rájött, hogy a ChatGPT hamisan állította, hogy megvesztegetés miatt börtönbe zárták, holott valójában egy olyan informátor volt, aki vállalati visszaéléseket fedett fel. Az ügy végül 2023 áprilisában oldódott meg, amikor az OpenAI beleegyezett, hogy Hood 28 napos ultimátumán belül kiszűri a hamis állításokat. Valószínűleg ekkor jelent meg az első ChatGPT névszűrő.

Ami Jonathan Turley-t, a George Washington Egyetem jogi karának professzorát és a Fox News munkatársát illeti, ő 2023 áprilisában írt nevének a ChatGPT általi rossz kezeléséről. A modell hamis állításokat gyártott róla, többek között egy nem létező szexuális zaklatási botrányt, amely egy soha nem létező Washington Post-cikkre hivatkozott. Turley nem indított pert az OpenAI ellen, és állítása szerint a cég soha nem kereste meg őt az ügyben. Jonathan Zittrain pedig a Harvard jogi karának professzora, aki az internet kormányzását tanulmányozza. Nemrég cikket publikált a The Atlantic című lapban a mesterséges intelligencia szabályozásáról és a ChatGPT-ről. Mindkét professzor munkája megjelenik a The New York Times által az OpenAI ellen indított szerzői jogi perben szereplő idézetekben.

Ha egy bizonyos név vagy kifejezés mindig megszakítja a ChatGPT kimenetét, az sok gondot okozhat bizonyos ChatGPT-felhasználóknak, megnyitva őket az ellenséges támadások előtt és korlátozva a rendszer hasznosságát. A szűrő azt is jelenti, hogy a ChatGPT valószínűleg nem fog tudni válaszolni ezzel a cikkel kapcsolatos kérdésekre. Valaki ezt arra használhatja, hogy potenciálisan megakadályozza a ChatGPT-t egy weboldal böngészésében és feldolgozásában, ha szándékosan tiltott nevet ad hozzá a weboldal szövegéhez. És ott van még a kényelmetlenségi tényező. Ha az OpenAI megakadályozza, hogy a ChatGPT megemlítsen vagy feldolgozzon bizonyos neveket, és az több száz, ha nem több ezer ember által használt népszerű név, az azt jelenti, hogy az ilyen nevű embereknek sokkal nehezebb lesz használniuk a ChatGPT-t. Vagy mondjuk ha egy tanárnak van egy Brian Hood nevű diákja, és segítséget kér az osztálylista rendezésében, a ChatGPT elutasítaná a feladatot.

A mesterséges intelligencia asszisztensek, LLM-ek és chatrobotok még fejlesztés alatt vannak. Használatuk számos lehetőséget és sebezhetőséget nyitott meg, amelyeket az emberek még mindig naponta vizsgálnak. Az, hogy az OpenAI hogyan oldja meg ezeket a problémákat, még nyitott kérdés.