SG.hu

A kvantumszámítógépek hibajavításában segít az Nvidia

Körülbelül másfél évvel ezelőtt mélyreható partnerséget jelentett be a Quantum Machines kvantumvezérléssel foglalkozó startup és az Nvidia, amelynek keretében egyesítik az Nvidia DGX Quantum számítási platformját és a Quantum Machines fejlett kvantumvezérlő hardverét. Eddig nem sokat hallottunk ennek a partnerségnek az eredményeiről, de mostanra kezdi meghozni gyümölcsét, és egy lépéssel közelebb hozza az iparágat a hibakorrigált kvantumszámítógép Szent Gráljához.

A két vállalat most egy prezentáción bemutatta, hogy az Nvidia DGX platformján futó megerősítő tanulási modellel képesek voltak a rendszer kalibrációjának fenntartásával egy Rigetti kvantumchipben lévő qubiteket jobban irányítani. Yonatan Cohen, a Quantum Machines társalapítója és technológiai igazgatója elmondta, hogy cége már régóta törekszik arra, hogy általános klasszikus számítási motorokat használjon a kvantumprocesszorok vezérlésére. De ezek a számítási motorok kicsik és korlátozottak voltak, szemben az Nvidia rendkívül nagy teljesítményű DGX platformjával. A Szent Grál, mondta, a kvantumhibajavítás futtatása. Egyelőre még nem tartunk ott. Ehelyett ez az együttműködés a kalibrációra összpontosít, konkrétan az úgynevezett „pi impulzusok” kalibrálására, amelyek egy qubit forgását vezérlik a kvantumprocesszoron belül.

Első pillantásra a kalibrálás egy egyszeri problémának tűnhet: kalibráljuk a processzort, mielőtt elkezdjük rajta futtatni az algoritmust. De ez nem ilyen egyszerű. „Ha megnézzük a kvantumszámítógépek mai teljesítményét, akkor nagy prezízitást kapunk” - mondta Cohen. „De aztán a felhasználók, amikor használják a számítógépet, jellemzően nem a legjobb pontossággal dolgoznak. A rendszer állandóan elkalandozik. Ha gyakran újra lehet kalibrálni ilyen típusú technikák és egy mögöttes hardver segítségével, akkor javíthatjuk a teljesítményt és hosszú időn keresztül meg tudjuk tartani a magas pontosságot, amire a kvantumhibajavításban szükség van.” - mondta.

Ezeknek az impulzusoknak a szinte valós időben történő állandó beállítása rendkívül számításigényes feladat, de mivel egy kvantumrendszer mindig egy kicsit más, ez egy olyan szabályozási probléma, amely alkalmas arra, hogy a megerősítő tanulás segítségével megoldható legyen. "Ahogy a kvantumszámítógépek egyre jobban skálázódnak és fejlődnek, úgy jönnek elő új, számításigényes problémák, amelyek szűk keresztmetszetekké válnak” - mondta Sam Stanwyck, az Nvidia kvantumszámítástechnikai csoportjának termékmenedzsere. "A kvantum hibajavítás valóban hatalmas probléma. Ez szükséges a hibatűrő kvantumszámításhoz, de ahhoz is, hogy hogyan alkalmazzuk pontosan a megfelelő vezérlőimpulzusokat, hogy a lehető legtöbbet hozzuk ki a qubitekből.”

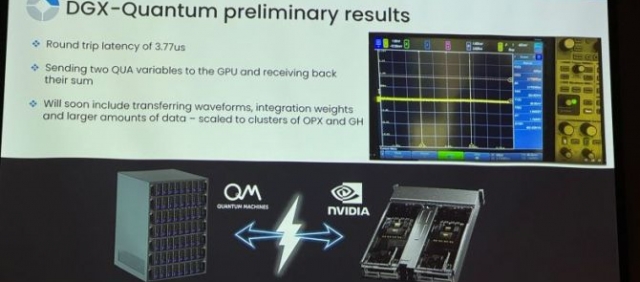

Stanwyck azt is hangsúlyozta, hogy a DGX Quantum előtt nem volt olyan rendszer, amely lehetővé tette volna az ilyen számítások elvégzéséhez szükséges minimális késleltetést. Mint kiderült, a kalibrációban elért kis javulás is hatalmas javulást eredményezhet a hibajavításban. "A kalibrációba történő befektetés megtérülése a kvantumos hibajavítással összefüggésben exponenciális” - magyarázta Ramon Szmuk, a Quantum Machines termékmenedzsere. "Ha 10%-kal jobban kalibrálsz, az exponenciálisan jobb logikai hibateljesítményt ad egy sok fizikai qubitből álló logikai qubitben. Tehát nagyon sok motiváció van arra, hogy nagyon jól és gyorsan kalibráljunk.”

Érdemes hangsúlyozni, hogy ez csak a kezdete ennek az optimalizálási folyamatnak és együttműködésnek. Amit a csapat itt valójában csinált, az egyszerűen csak annyi volt, hogy fogtak egy maréknyi kész algoritmust, és megnézték, melyik működik a legjobban. Mindent összevetve a kísérlet futtatásához szükséges tényleges kód mindössze körülbelül 150 sor hosszú volt. Természetesen az eredmény a két csapat által a különböző rendszerek integrálásával és a szoftvercsomag kiépítésével végzett munkára is támaszkodik. A fejlesztők számára azonban mindez a komplexitás elrejthető, és a két vállalat arra számít, hogy idővel egyre több nyílt forráskódú könyvtárat hoznak létre, hogy kihasználhassák ennek a nagyobb platformnak az előnyeit.

Szmuk hangsúlyozta, hogy ennél a projektnél a csapat csak egy nagyon egyszerű kvantumáramkörrel dolgozott, de ez általánosítható bonyolultabb áramkörökre is. Ha ezt meg lehet csinálni egy kapuval és egy qubittal, akkor meg lehet csinálni száz qubittal és 1000 kapuval is” - mondta. "Azt mondanám, hogy ez az egyedi eredmény egy kis lépés, de a jó irányba, a legfontosabb problémák megoldása felé” - tette hozzá Stanwyck. "A hasznos kvantumszámításokhoz a szuperszámítógépek szoros integrációjára lesz szükség - és ez lesz a legnehezebb mérnöki kihívás. Tehát azzal, hogy ezt meg tudjuk csinálni egy kvantumszámítógépen, és úgy tudjuk beállítani az impulzust, hogy az ne csak egy kis kvantumszámítógépre legyen optimalizálva, hanem egy skálázható, moduláris platform legyen, úgy gondoljuk, hogy ezzel valóban a kvantumszámítás legfontosabb problémáinak megoldásához vezető úton vagyunk.”

Stanwyck azt is elmondta, hogy a két vállalat tervezi az együttműködés folytatását, és azt, hogy ezeket az eszközöket még több kutató kezébe adják. Az Nvidia jövőre elérhetővé váló Blackwell chipjeivel ráadásul még nagyobb teljesítményű számítási platformot kapnak ehhez a projekthez is.

A két vállalat most egy prezentáción bemutatta, hogy az Nvidia DGX platformján futó megerősítő tanulási modellel képesek voltak a rendszer kalibrációjának fenntartásával egy Rigetti kvantumchipben lévő qubiteket jobban irányítani. Yonatan Cohen, a Quantum Machines társalapítója és technológiai igazgatója elmondta, hogy cége már régóta törekszik arra, hogy általános klasszikus számítási motorokat használjon a kvantumprocesszorok vezérlésére. De ezek a számítási motorok kicsik és korlátozottak voltak, szemben az Nvidia rendkívül nagy teljesítményű DGX platformjával. A Szent Grál, mondta, a kvantumhibajavítás futtatása. Egyelőre még nem tartunk ott. Ehelyett ez az együttműködés a kalibrációra összpontosít, konkrétan az úgynevezett „pi impulzusok” kalibrálására, amelyek egy qubit forgását vezérlik a kvantumprocesszoron belül.

Első pillantásra a kalibrálás egy egyszeri problémának tűnhet: kalibráljuk a processzort, mielőtt elkezdjük rajta futtatni az algoritmust. De ez nem ilyen egyszerű. „Ha megnézzük a kvantumszámítógépek mai teljesítményét, akkor nagy prezízitást kapunk” - mondta Cohen. „De aztán a felhasználók, amikor használják a számítógépet, jellemzően nem a legjobb pontossággal dolgoznak. A rendszer állandóan elkalandozik. Ha gyakran újra lehet kalibrálni ilyen típusú technikák és egy mögöttes hardver segítségével, akkor javíthatjuk a teljesítményt és hosszú időn keresztül meg tudjuk tartani a magas pontosságot, amire a kvantumhibajavításban szükség van.” - mondta.

Ezeknek az impulzusoknak a szinte valós időben történő állandó beállítása rendkívül számításigényes feladat, de mivel egy kvantumrendszer mindig egy kicsit más, ez egy olyan szabályozási probléma, amely alkalmas arra, hogy a megerősítő tanulás segítségével megoldható legyen. "Ahogy a kvantumszámítógépek egyre jobban skálázódnak és fejlődnek, úgy jönnek elő új, számításigényes problémák, amelyek szűk keresztmetszetekké válnak” - mondta Sam Stanwyck, az Nvidia kvantumszámítástechnikai csoportjának termékmenedzsere. "A kvantum hibajavítás valóban hatalmas probléma. Ez szükséges a hibatűrő kvantumszámításhoz, de ahhoz is, hogy hogyan alkalmazzuk pontosan a megfelelő vezérlőimpulzusokat, hogy a lehető legtöbbet hozzuk ki a qubitekből.”

Stanwyck azt is hangsúlyozta, hogy a DGX Quantum előtt nem volt olyan rendszer, amely lehetővé tette volna az ilyen számítások elvégzéséhez szükséges minimális késleltetést. Mint kiderült, a kalibrációban elért kis javulás is hatalmas javulást eredményezhet a hibajavításban. "A kalibrációba történő befektetés megtérülése a kvantumos hibajavítással összefüggésben exponenciális” - magyarázta Ramon Szmuk, a Quantum Machines termékmenedzsere. "Ha 10%-kal jobban kalibrálsz, az exponenciálisan jobb logikai hibateljesítményt ad egy sok fizikai qubitből álló logikai qubitben. Tehát nagyon sok motiváció van arra, hogy nagyon jól és gyorsan kalibráljunk.”

Érdemes hangsúlyozni, hogy ez csak a kezdete ennek az optimalizálási folyamatnak és együttműködésnek. Amit a csapat itt valójában csinált, az egyszerűen csak annyi volt, hogy fogtak egy maréknyi kész algoritmust, és megnézték, melyik működik a legjobban. Mindent összevetve a kísérlet futtatásához szükséges tényleges kód mindössze körülbelül 150 sor hosszú volt. Természetesen az eredmény a két csapat által a különböző rendszerek integrálásával és a szoftvercsomag kiépítésével végzett munkára is támaszkodik. A fejlesztők számára azonban mindez a komplexitás elrejthető, és a két vállalat arra számít, hogy idővel egyre több nyílt forráskódú könyvtárat hoznak létre, hogy kihasználhassák ennek a nagyobb platformnak az előnyeit.

Szmuk hangsúlyozta, hogy ennél a projektnél a csapat csak egy nagyon egyszerű kvantumáramkörrel dolgozott, de ez általánosítható bonyolultabb áramkörökre is. Ha ezt meg lehet csinálni egy kapuval és egy qubittal, akkor meg lehet csinálni száz qubittal és 1000 kapuval is” - mondta. "Azt mondanám, hogy ez az egyedi eredmény egy kis lépés, de a jó irányba, a legfontosabb problémák megoldása felé” - tette hozzá Stanwyck. "A hasznos kvantumszámításokhoz a szuperszámítógépek szoros integrációjára lesz szükség - és ez lesz a legnehezebb mérnöki kihívás. Tehát azzal, hogy ezt meg tudjuk csinálni egy kvantumszámítógépen, és úgy tudjuk beállítani az impulzust, hogy az ne csak egy kis kvantumszámítógépre legyen optimalizálva, hanem egy skálázható, moduláris platform legyen, úgy gondoljuk, hogy ezzel valóban a kvantumszámítás legfontosabb problémáinak megoldásához vezető úton vagyunk.”

Stanwyck azt is elmondta, hogy a két vállalat tervezi az együttműködés folytatását, és azt, hogy ezeket az eszközöket még több kutató kezébe adják. Az Nvidia jövőre elérhetővé váló Blackwell chipjeivel ráadásul még nagyobb teljesítményű számítási platformot kapnak ehhez a projekthez is.