Gyurkity Péter

nVidia: jön a hibrid SLI

Az nVidia az integrált és a különálló grafikus kártyák erejét ötvözné a hibrid SLI révén, amely megfelelő teljesítményt és tűrhető fogyasztást ígér, így akár noteszgépekben is helyet kaphat.

Az X-bit Labs Jen Hszun Huang, a cég vezérigazgatója által elmondottakra hivatkozva adta hírül, hogy már javában dolgoznak a hibrid SLI felállásokon, amelyek a meglévő párosítások egyetlen nagy hátrányát küszöbölnék ki. Ez nem más, mint a hatalmas fogyasztás, amely az erős grafikus kártyák alkalmazása esetén elkerülhetetlen - ám az új megoldás erre is gyógyírt ígér.

Természetesen ennek ára van, hiszen a fogyasztást csak úgy tudják leszorítani, hogy visszafogják a számítási kapacitást, vagyis gyengébb összeállításokat terveznek. Ezt az nVidia úgy oldaná meg, hogy két különálló grafikus kártya helyett ezúttal egy integrált és egy kártyán helyet foglaló chip erejét ötvözné. Előbbit a kisebb erőt igénylő feladatokhoz, utóbbit pedig a számításigényes műveletekhez vennék igénybe, amelybe az integrált vezérlő is besegítene, már amennyire tud. Ettől a megoldástól azt várják, hogy jobb lesz a hagyományos egykártyás rendszereknél ám a fogyasztást nem növeli jelentős mértékben.

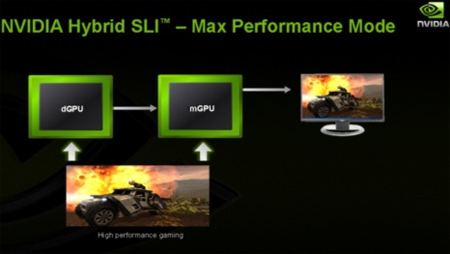

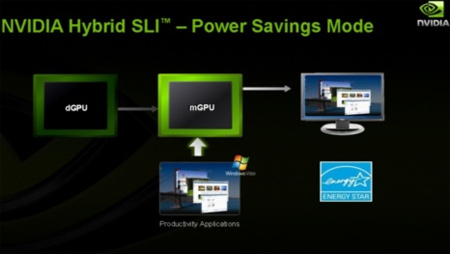

A Hibrid SLI esetében tehát két üzemmód közül választhatnánk. Az első a Power Saving Mode, amely kikapcsolja a különálló grafikus kártyát és az integrált vezérlőre bízza a meglévő feladatok végrehajtását, persze csak abban az esetben, ha az nem követeli meg a nagyobb erőt. A számításigényes műveleteknél viszont automatikusan elfoglalná a helyét a Max Performance Mode, amely viszont már a különálló vezérlőre bízza a főszerepet, míg integrált társa itt-ott besegíthet a feladatban. Ily módon a noteszgépeket is elláthatják két vezérlővel, anélkül, hogy mindez hátrányosan érintené az üzemidőt.

"A két vezérlő között váltásnál nincs szükség a monitor átkötésére. A megoldás révén ugyanis a videojel mindig az alaplapi vezérlő kimenetén távozik" - magyarázta Jeff Fisher, az nVidia GPU-részlegének ügyvezető igazgatója. Kérdés, hogy az ilyen és hasonló összeállítások mennyire lesznek népszerűek a vásárlók körében.

Az X-bit Labs Jen Hszun Huang, a cég vezérigazgatója által elmondottakra hivatkozva adta hírül, hogy már javában dolgoznak a hibrid SLI felállásokon, amelyek a meglévő párosítások egyetlen nagy hátrányát küszöbölnék ki. Ez nem más, mint a hatalmas fogyasztás, amely az erős grafikus kártyák alkalmazása esetén elkerülhetetlen - ám az új megoldás erre is gyógyírt ígér.

Természetesen ennek ára van, hiszen a fogyasztást csak úgy tudják leszorítani, hogy visszafogják a számítási kapacitást, vagyis gyengébb összeállításokat terveznek. Ezt az nVidia úgy oldaná meg, hogy két különálló grafikus kártya helyett ezúttal egy integrált és egy kártyán helyet foglaló chip erejét ötvözné. Előbbit a kisebb erőt igénylő feladatokhoz, utóbbit pedig a számításigényes műveletekhez vennék igénybe, amelybe az integrált vezérlő is besegítene, már amennyire tud. Ettől a megoldástól azt várják, hogy jobb lesz a hagyományos egykártyás rendszereknél ám a fogyasztást nem növeli jelentős mértékben.

A Hibrid SLI esetében tehát két üzemmód közül választhatnánk. Az első a Power Saving Mode, amely kikapcsolja a különálló grafikus kártyát és az integrált vezérlőre bízza a meglévő feladatok végrehajtását, persze csak abban az esetben, ha az nem követeli meg a nagyobb erőt. A számításigényes műveleteknél viszont automatikusan elfoglalná a helyét a Max Performance Mode, amely viszont már a különálló vezérlőre bízza a főszerepet, míg integrált társa itt-ott besegíthet a feladatban. Ily módon a noteszgépeket is elláthatják két vezérlővel, anélkül, hogy mindez hátrányosan érintené az üzemidőt.

"A két vezérlő között váltásnál nincs szükség a monitor átkötésére. A megoldás révén ugyanis a videojel mindig az alaplapi vezérlő kimenetén távozik" - magyarázta Jeff Fisher, az nVidia GPU-részlegének ügyvezető igazgatója. Kérdés, hogy az ilyen és hasonló összeállítások mennyire lesznek népszerűek a vásárlók körében.