Gyurkity Péter

Megjelent a Radeon HD 3800

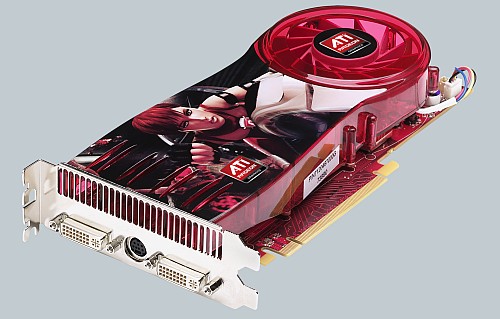

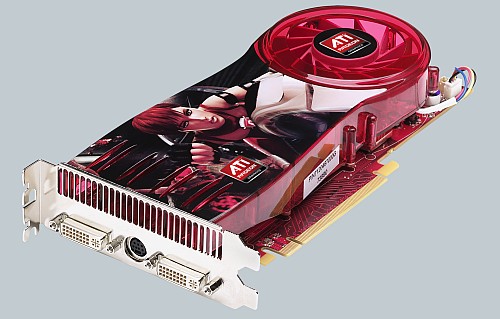

Mától kapható az ATI-AMD új zászlóshajója, amely rögtön két inkarnációban érkezik, Radeon HD 3850 és 3870 néven. Fejlett gyártástechnológia, magas órajel és aránylag tűrhető fogyasztás jellemzi a kártyákat.

Az AMD oldalán már megtalálhatjuk az új sorozatot bemutató külön lapot. Ezen többek között közlik a grafikus chip fontosabb technikai részleteit, a támogatott technológiákat, ám számunkra természetesen az a legfontosabb, hogy melyik gyártó milyen kiszerelésben és főleg milyen áron dobja majd piacra saját változatait. Ez ugyan még nem teljesen világos, ám a technikai specifikációt megismerhetjük.

Az 55 nanométeren készülő RV670 chip tehát két változatban jelenik meg. A HD 3850 és 3870 gyakorlatilag a korábbi Pro és XT változatoknak felelnek meg, hiszen kettejük között mindössze az órajelben, a memória típusában és méretében, valamint a külsőben találunk eltérést. A 666 millió tranzisztort és összesen 320 stream processzort magába foglaló mag az első változaton 670, a másodikon pedig már 775 MHz-en fut. A HD 3850 256 MB GDDR3 memóriája 900 MH-es órajelen, a HD 3870 512 MB GDDR4 memóriája pedig 1,2 GHz-en érkezik. Mindkét változat PCI Express 2.0 csatolót kapott.

A "gyengébb" változat fogyasztása csúcsjáraton 98 watt, ez egyetlen bővítőhelyen elfér, tehát némiképp visszafogott hűtéssel szerelik fel - legalábbis a referenciapéldányokat. A 3870 azonban már dupla helyet elfoglaló monstrum hűtést kapott, fogyasztása pedig 106 watt. A két mintapéldány dual-link DVI és HDTV-Out portokkal rendelkezik, támogatják a HDCP-másolásvédelmet, vagyis egy átalakítóval akár HDMI-csatolójú készülékre is rádughatjuk őket - ebben az esetben a hang a HDTV kimeneten érkezik.

A PowerPlay energiatakarékossági technológia révén a kártyák három üzemmódban működhetnek, ezek sorrendben: general (általános), light gaming és intensive gaming. Az első esetben a fogyasztás 26 és 39 watt, a középső üzemmódban pedig 34 és 51 watt. A harmadiknál az "ami a csövön kifér" elv érvényesül.

Több forrás 150-200 dollár körüli áron várja a kártyákat, ám a hivatalos adatokra még várni kell.

Az AMD oldalán már megtalálhatjuk az új sorozatot bemutató külön lapot. Ezen többek között közlik a grafikus chip fontosabb technikai részleteit, a támogatott technológiákat, ám számunkra természetesen az a legfontosabb, hogy melyik gyártó milyen kiszerelésben és főleg milyen áron dobja majd piacra saját változatait. Ez ugyan még nem teljesen világos, ám a technikai specifikációt megismerhetjük.

Az 55 nanométeren készülő RV670 chip tehát két változatban jelenik meg. A HD 3850 és 3870 gyakorlatilag a korábbi Pro és XT változatoknak felelnek meg, hiszen kettejük között mindössze az órajelben, a memória típusában és méretében, valamint a külsőben találunk eltérést. A 666 millió tranzisztort és összesen 320 stream processzort magába foglaló mag az első változaton 670, a másodikon pedig már 775 MHz-en fut. A HD 3850 256 MB GDDR3 memóriája 900 MH-es órajelen, a HD 3870 512 MB GDDR4 memóriája pedig 1,2 GHz-en érkezik. Mindkét változat PCI Express 2.0 csatolót kapott.

A "gyengébb" változat fogyasztása csúcsjáraton 98 watt, ez egyetlen bővítőhelyen elfér, tehát némiképp visszafogott hűtéssel szerelik fel - legalábbis a referenciapéldányokat. A 3870 azonban már dupla helyet elfoglaló monstrum hűtést kapott, fogyasztása pedig 106 watt. A két mintapéldány dual-link DVI és HDTV-Out portokkal rendelkezik, támogatják a HDCP-másolásvédelmet, vagyis egy átalakítóval akár HDMI-csatolójú készülékre is rádughatjuk őket - ebben az esetben a hang a HDTV kimeneten érkezik.

A PowerPlay energiatakarékossági technológia révén a kártyák három üzemmódban működhetnek, ezek sorrendben: general (általános), light gaming és intensive gaming. Az első esetben a fogyasztás 26 és 39 watt, a középső üzemmódban pedig 34 és 51 watt. A harmadiknál az "ami a csövön kifér" elv érvényesül.

Több forrás 150-200 dollár körüli áron várja a kártyákat, ám a hivatalos adatokra még várni kell.