90029

-

#42307

#42307

6 szerintem is fölös (spec esetekben nem), csak azért annyit írtam mert az a max :) -

#42306

#42306

naa azért pip-el nem tudsz 6 asztalt varázsolni magadnak :) -

#42305

#42305

Na mindegy ... teny hogy a tobb monitor igen csak jo dolog ( de 6 ... minek ) 3 monitor eleg kafa jatszani . -

#42304

#42304

eddig is volt ekkora teljesítményű vga-juk csak a 4870x2-t besűrítették 1gpu-ba, amennyiben annak a vga-nak volt létjugosultsága akkor ennek is van. Ha megnézed akkor előző generációnál is 3870x2-t is elfenekeli a 4870, nemtörtén itt sem más, csak az előző generáció többgpu-s megoldását leváltották. -

#42303

#42303

PIP  ( Valahogy ezt is meg lehetni oldani a Plasma-n )

( Valahogy ezt is meg lehetni oldani a Plasma-n )

-

#42302

#42302

mar mint milyen felbontasra gondolsz ... Nekem tokeletes az 50" Plasma-mon az 1920x1080 . Mi lehet a kulonbseg 6 egymasra es melle pakolt monitoron lathato kep es egy LCD/Plasma-n lathato kep kozott . Megmondom : a nagy semmi mert ugyan olyan tavolsagrol fogja nezni a paraszt ( ha nincs akora marha hogy 1m ul elotte )

Sot az LCD/Plasma jobb mert nincs 24"-kent keret a kepedben ...... -

#42301

#42301

ja és azt még ki is felejtettem, hogy a monitorokat külön megjelenítőnek is használhatod, pl 1-en filmezel, 1-en netezel, egy meg ottvan mert megteheted és itt is jelen van az e-penis esete, de persze van egy csomo logikus felhasználás is :) -

#42300

#42300

anyway ... nem akarom en itt homalyositani a HD5xxx erdemeit csak elgondolkodtato hogy minek ekkora teljesitmeny. ( bar az orok igazsag , hogy abbol sosem eleg ) -

#42299

#42299

plasmába nincs akkora felbontás, legalábbis nem fele annyiért :)

ráadásul ez nem egy sík felület (legalábbis én nem úgy használnám) hanem kicsit "hajlik", és így sokkal jobb. Mondjuk van ilyen félkör alakú monitor is, vagyis kép van róla :) -

#42298

#42298

megtudná jeleníteni igen, mondjuk kicsit több dolga lenne vele, mint egy dx11-es kártyának -

#42297

#42297

Ez igaz . De manapsag amit kiraksz 6 monitorbol megveszed fele aron egyben : 50" Plasma . -

#42296

#42296

A hardverigenyt ugy ertettem ami megjeleniti .

Tehat problema nelkul meg tudna jeleniteni egy HD4850-es kaliberu kartya is a DX11-es effekteket ha megfeleloen lenne megirva az alkalmazas.

A kedvenc szavam ( today longest word award : optimalizalatlansag ) -

#42295

#42295

szerinted mennyiért tudnak eladni egy olyan vga-t ami ugyanannyit tud mint az előző generációs vga, csak dx11-es? (kb pont annyiért mint amennyiért hd5770-et vesztegetik). Az 5870-et szerintem csak az új ficsőr miatt csinálták (nemjuteszembe a neve) ha nem lenne olyan vga ami meg tudja hajtani azt a 3-6 monitort akkor lofaszt nem érnének vele. Pont az a lényege hogy az otthoni userek is élvezhessék a 3-6 monitor nyújtatta előnyt, ahhoz a felbontáshoz meg bőven kell az 5870 :) -

#42294

#42294

Nem akartam utana hulyeseget irni

-

#42293

#42293

-

#42292

#42292

Törölgeted itt a hsz-eidet miközben gépelek neked..:D -

#42291

#42291

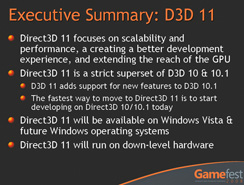

DX11-nek nincs hardverigénye. A DX11 egy interfész, egy nagy függvényhalmaz. Függvényekből pedig készíthető hello world alkalmazás és 800000 shader processzort megizzasztó effektháború is:) -

#42290

#42290

Nem úgy lesz gyorsabb, hanem a DX11 által életre keltett effektek, megvalósítások lesznek gyorsak.

Azokat a dolgokat amiket DX11-el meg tudnak valósítani tisztességes tempóban, azok közül a legtöbb ugyanúgy megoldható akár DX9(kevesebb)-DX10(több) alatt is csak egyrészt bonyolultabban, másrészt sokkal lassabb adatfeldolgozás mellett, hiszen nincsen rá felkésztve a VGA, így csak szoftveres támogatást kap.

A HD5-ös kártyák, vagy a HD4-esek DX10/10.1 esetében hardveres támogatást nyújtanak a DX10/11-es alkalmazások számára (API támogatás), ergo gyorsabb lesz minden. Emellett a DX11 önmagában szoftveresen is ki lett kupálva teljesítmény terén.

Remélem érthető voltam:) -

#42289

#42289

na tegyük fel hogy neked van egy 5870-ed, akkor tuti hogy a fórumlakók közt tied lesz a legnagyobb e-penis :) -

#42288

#42288

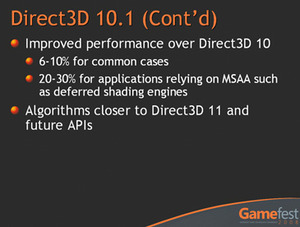

hd4850-en nem lesz teljesítményromlás, dx10.1 előnye :)

csak az effektek fognak valamennyire leromlani :/ -

#42287

#42287

Ezt nem ertem .... Azt igen hogy mi van oda irva de a celzast nem igazan. -

#42286

#42286

Lehet hulyen fogalmaztam .... gondolok arra ha ( persze nem LEHETSEGES )de gondoljunk egy HD4850-re amin a DX11 gyorsabb mint a DX10 . -

#42285

#42285

gondolom ezért:

-

#42284

#42284

Senki nem tud aludni ??

Na : "DX11 előnye számunkra elsősorban a sebesség lesz."

Itt maga a DX11 lesz gyorsabb az adott hardverrel ??? Ha igen akkor minek kell egy olyan szorny mint a HD5870 ?? -

#42283

#42283

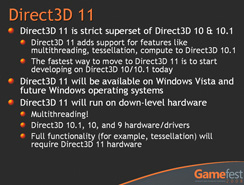

elkezdik, mert egyszerűbb lesz dx11-ben és visszafelé kompatibilis a kod, szal elég dx11-ben játékot csinálni, azt dx9-be is lehet futtatni -

#42282

#42282

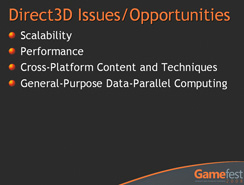

Compute shader és a Tessellation a két legkomolyabb dolog ami teljesítményt és látványjavulást okoz majd, ha a fejlesztők katona módon elkezdik használni őket. -

#42281

#42281

dx11-nél a fényefektek asszem sokkal látványosabbak lesznek pl. meg sok hasonló apróság -

#42280

#42280

DX11 8 oldalon:) -

#42279

#42279

Csak amit prezentációkon mutattak. Megjegyzem DX és DX között nem csak külsőségekben van különbség, hanem (többnyire) fejlesztői szinten adnak több lehetőséget az újabb verziók. DX11-ben adott 4-5 új technológia, aztán hogy ki milyen effekteket hoz ki belőlük az más tészta. DX11 előnye számunkra elsősorban a sebesség lesz.

DX11 újdonságok:

* Down-level hardware and operating system support

* Improved multithreaded device

* New hardware stages for tessellation

* Improved texture compression

* Shader Model 5.0

* Compute shader

* Additional features

-

#42278

#42278

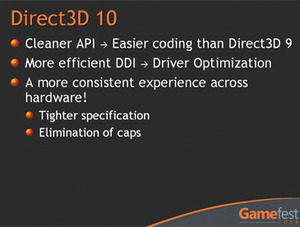

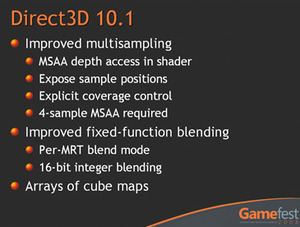

Mar ha DX11 .... latta mar valaki mi a kulonbseg a DX10 ; DX10.1 ; DX11 kozott ??? -

#42277

#42277

Nekem is ez az almom .... 64GB G. Skill csak az oprendszernek. -

#42276

#42276

ha sikerül, akkor beújítok egy intel M-25-ös 80Gb-s SSD-t. nem akarok 15000-rel pörgő vincsit a gépbe:) -

![[HUN]FaTaL [HUN]FaTaL](https://media.sg.hu/forum/avatars/10557508481320070594.gif) #42275

#42275

Nekem a rendszer egy fujitsu 72gb 10k rpm scsi volt, de a hangja miatt maradt a 320as seagate a rendszer (már ebbő 36g, a többi adat), amit épp most próbálok eladni. :D Ezenkívül van még 2x 750 samu, de a 320as helyére tervezek egy 1 terást. :D -

Blum #42274 Háhá,ez jó! Főleg az átnevezéses rész tetszik...

-

#42273

#42273

-

#42272

#42272

Sz..ni jarni muszaj

ATI forever !!!!! -

#42271

#42271

Muszaj volt. Orokke nem jatszhatunk DX9-el...

-

miniszterke #42270 nem azt mondtam hogy nvidiát akarok csakha tud annyit mint az ati olcsobban akkor viszont az de amugy énis atit mondok me szeretem a mostani atimat is.... -

#42269

#42269

PH-rol (Oszodi beszed nyoman):

"Nincsen sok választás. Azért nincsen, mert elkúrtuk. Nem kicsit, nagyon.

A világon ilyen böszmeséget még gpu tervező nem csinált, mint amit mi csináltunk. Meg lehet magyarázni. Nyilvánvalóan végighazudtuk az utolsó másfél-két hónapot. Teljesen világos volt, hogy amit mondunk, az nem igaz. Annyival vagyunk túl a g92 lehetőségein, hogy mi azt nem tudtuk korábban elképzelni, hogy ezt az nvidia és a ageia közös vállalatirányítása valaha is megteszi. És közben egyébként nem csináltunk semmit három évig évig. Semmit.

Nem tudtok mondani olyan jelentős gpu fejlesztést, amire büszkék lehetünk, azon túl, hogy a 16x átneveztük a g92-es család tagjait

Semmit. Ha el kell számolni az az nvidia fanoknak, hogy mit csináltunk három év alatt, akkor mit mondunk? Természetesen a Fermi az nem szépen, nyugodtan, aprólékosan fölépített. Nem. Nem. Őrült lóhalálában készül, mert egy darabig nem csinálhattuk, nehogy kiderüljön, most meg már olyan rohadtul kell csinálnunk, hogy majdnem belegebedünk.."

-

#42268

#42268

Azon gondolkodtam hogy nem igazan jo az nekunk hogy az ATI " kettot lepett egyszerre " ez nagy lepes volt a szamitasi teljesitmeny teren .

Megint el fog szallni a gamemaker-ok esze figyeld meg ... es ennek ki issza meg a levet ... Mi .