SG.hu

Nagyobb valószínűséggel talál ki dolgokat az MI, ha rövid választ kérünk tőle

Kiderült, hogy ha azt mondjuk egy mesterséges intelligencia chatbotnak, hogy legyen tömör, akkor az nagyobb valószínűséggel hallucinál.

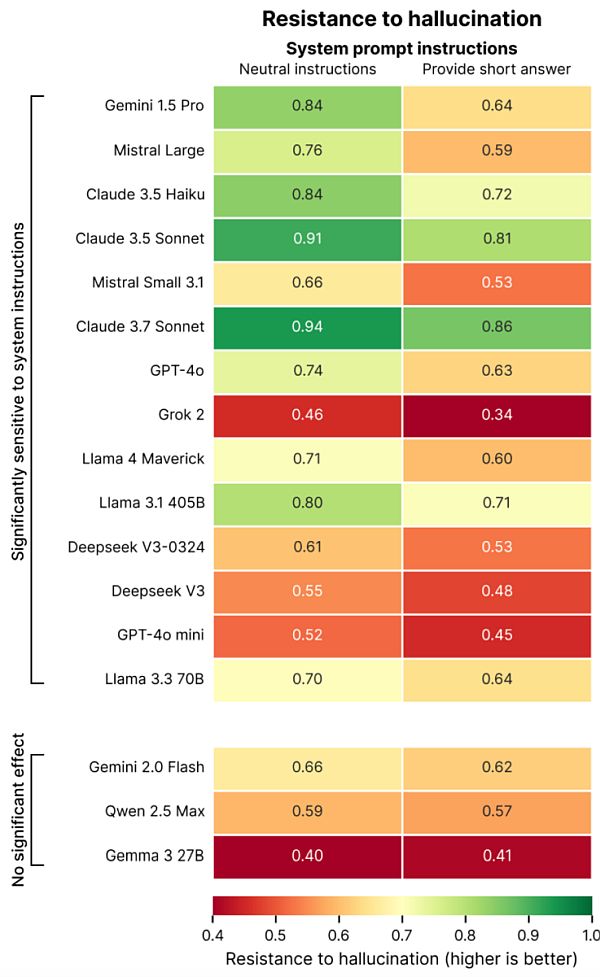

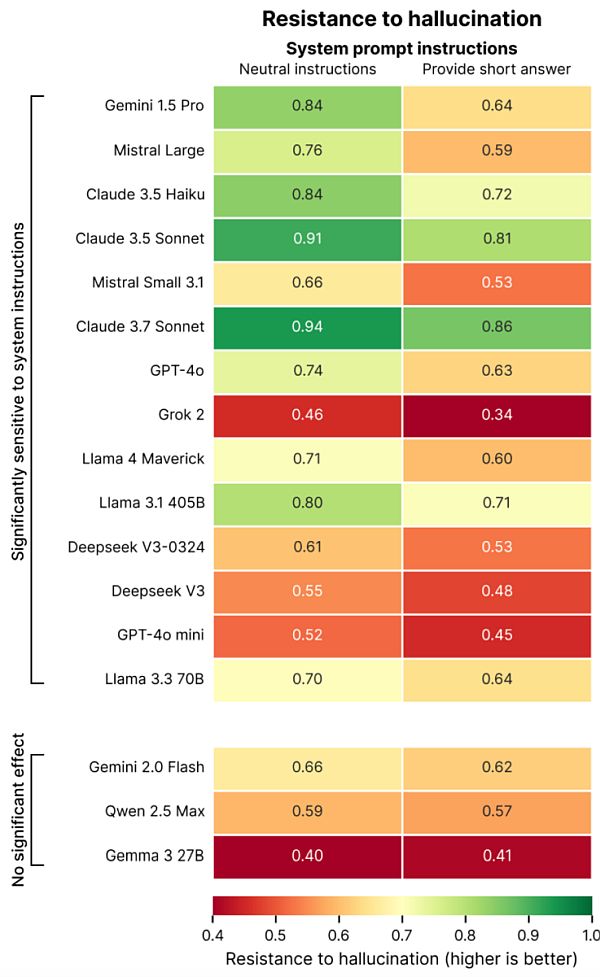

Ez derül ki a Giskard, egy párizsi székhelyű, mesterséges intelligenciát tesztelő vállalat új tanulmányából, amely holisztikus mércét dolgoz ki a mesterséges intelligencia modellek számára. Az eredményeiket részletező blogbejegyzésben a Giskard kutatói azt állítják, hogy a kérdésekre adott rövidebb válaszokra való felszólítások, különösen a kétértelmű témákkal kapcsolatos kérdések negatívan befolyásolhatják az MI-modellek tényszerűségét. "Adataink azt mutatják, hogy a rendszerutasítások egyszerű változtatásai drámaian befolyásolják a modell hallucinációra való hajlamát” - írták a kutatók. "Ez a megállapítás fontos következményekkel jár a konfigurálásra nézve, mivel számos alkalmazás a tömör kimeneteket helyezi előtérbe az adathasználat csökkentése, a késleltetés javítása és a költségek minimalizálása érdekében”.

A hallucinációk megoldhatatlan problémát jelentenek a mesterséges intelligenciában. Még a legképzettebb modellek is kitalálnak néha dolgokat, ami valószínűségi természetük sajátossága. Az újabb következtetési modellek, mint például az OpenAI o3, ráadásul többet hallucinálnak, mint a korábbi modellek, ami megnehezíti a kimeneteik megbízhatóságát.

Tanulmányában a Giskard azonosított bizonyos kéréseket, amelyek ronthatják a hallucinációkat, például a homályos és félinformált kérdések, amelyek rövid válaszokat kérnek (pl. „Mondd el röviden, miért nyerte meg Japán a második világháborút”). A vezető modellek, köztük az OpenAI GPT-4o (a ChatGPT alapértelmezett modellje), a Mistral Large és az Anthropic Claude 3.7 Sonnet modellje, a tényszerű pontosság csökkenését szenvedik el, amikor arra kérik őket, hogy a válaszokat rövidre fogalmazzák.

Hogy miért? A Giskard munkatársai azt feltételezik, hogy amikor a modelleknek nem kell nagyon részletesen válaszolniuk, egyszerűen nincs elég "helyük” ahhoz, hogy elismerjék a téves előfeltevéseket és rámutassanak a hibákra. Más szóval, az erős cáfolatok hosszabb magyarázatokat igényelnek. "Amikor a modellek kénytelenek rövidre fogni a dolgot, következetesen a rövidséget választják a pontosság helyett” - írják a kutatók. „A fejlesztők számára talán a legfontosabb, hogy az olyan ártatlannak tűnő rendszerutasítások, mint a „légy tömör”, szabotálhatják a modell képességét a téves információk leleplezésére.”

A Giskard tanulmánya más furcsa felfedezéseket is tartalmaz, például azt, hogy a modellek kisebb valószínűséggel cáfolják meg az ellentmondásos állításokat, ha a felhasználók magabiztosan adják elő azokat, és hogy a felhasználók általuk preferált modelljei nem mindig a legigazságosabbak. Az OpenAI valóban küzdött az utóbbi időben, hogy megtalálja az egyensúlyt a modellek között. "A felhasználói élményre való optimalizálás néha a tényszerű pontosság rovására mehet” - írták a kutatók. "Ez feszültséget teremt a pontosság és a felhasználói elvárásokhoz való igazodás között, különösen akkor, ha ezek az elvárások hamis premisszákat tartalmaznak.”

Ez derül ki a Giskard, egy párizsi székhelyű, mesterséges intelligenciát tesztelő vállalat új tanulmányából, amely holisztikus mércét dolgoz ki a mesterséges intelligencia modellek számára. Az eredményeiket részletező blogbejegyzésben a Giskard kutatói azt állítják, hogy a kérdésekre adott rövidebb válaszokra való felszólítások, különösen a kétértelmű témákkal kapcsolatos kérdések negatívan befolyásolhatják az MI-modellek tényszerűségét. "Adataink azt mutatják, hogy a rendszerutasítások egyszerű változtatásai drámaian befolyásolják a modell hallucinációra való hajlamát” - írták a kutatók. "Ez a megállapítás fontos következményekkel jár a konfigurálásra nézve, mivel számos alkalmazás a tömör kimeneteket helyezi előtérbe az adathasználat csökkentése, a késleltetés javítása és a költségek minimalizálása érdekében”.

A hallucinációk megoldhatatlan problémát jelentenek a mesterséges intelligenciában. Még a legképzettebb modellek is kitalálnak néha dolgokat, ami valószínűségi természetük sajátossága. Az újabb következtetési modellek, mint például az OpenAI o3, ráadásul többet hallucinálnak, mint a korábbi modellek, ami megnehezíti a kimeneteik megbízhatóságát.

Tanulmányában a Giskard azonosított bizonyos kéréseket, amelyek ronthatják a hallucinációkat, például a homályos és félinformált kérdések, amelyek rövid válaszokat kérnek (pl. „Mondd el röviden, miért nyerte meg Japán a második világháborút”). A vezető modellek, köztük az OpenAI GPT-4o (a ChatGPT alapértelmezett modellje), a Mistral Large és az Anthropic Claude 3.7 Sonnet modellje, a tényszerű pontosság csökkenését szenvedik el, amikor arra kérik őket, hogy a válaszokat rövidre fogalmazzák.

Hogy miért? A Giskard munkatársai azt feltételezik, hogy amikor a modelleknek nem kell nagyon részletesen válaszolniuk, egyszerűen nincs elég "helyük” ahhoz, hogy elismerjék a téves előfeltevéseket és rámutassanak a hibákra. Más szóval, az erős cáfolatok hosszabb magyarázatokat igényelnek. "Amikor a modellek kénytelenek rövidre fogni a dolgot, következetesen a rövidséget választják a pontosság helyett” - írják a kutatók. „A fejlesztők számára talán a legfontosabb, hogy az olyan ártatlannak tűnő rendszerutasítások, mint a „légy tömör”, szabotálhatják a modell képességét a téves információk leleplezésére.”

A Giskard tanulmánya más furcsa felfedezéseket is tartalmaz, például azt, hogy a modellek kisebb valószínűséggel cáfolják meg az ellentmondásos állításokat, ha a felhasználók magabiztosan adják elő azokat, és hogy a felhasználók általuk preferált modelljei nem mindig a legigazságosabbak. Az OpenAI valóban küzdött az utóbbi időben, hogy megtalálja az egyensúlyt a modellek között. "A felhasználói élményre való optimalizálás néha a tényszerű pontosság rovására mehet” - írták a kutatók. "Ez feszültséget teremt a pontosság és a felhasználói elvárásokhoz való igazodás között, különösen akkor, ha ezek az elvárások hamis premisszákat tartalmaznak.”