SG.hu

Falba ütközött az Nvidia?

Jensen Huang szereti mondogatni, a Moore-törvény halott - és az Nvidia GTC-n ebben a hónapban a GPU-gyártó vezérigazgatója elárulta, hogy a számítási skálázásra vonatkozó törvény valójában milyen mélyen a föld alatt van.

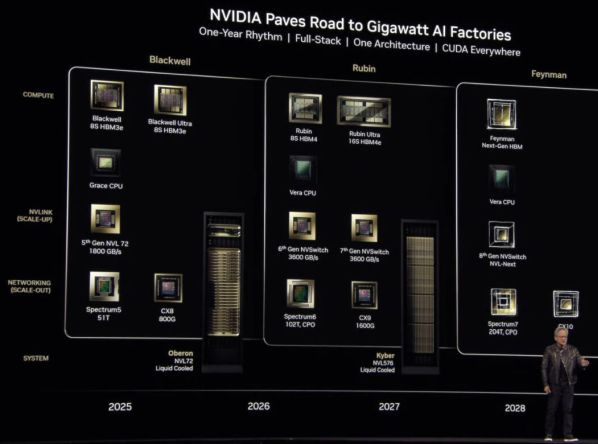

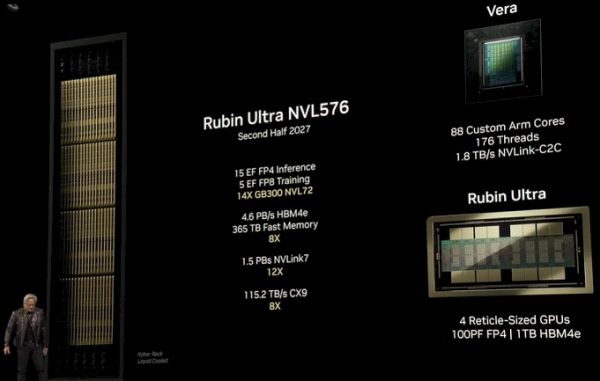

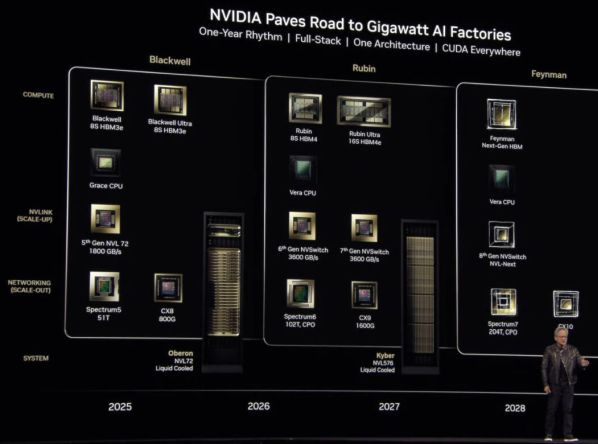

A GTC színpadán állva Huang nemcsak a chiptervező következő generációs Blackwell Ultra processzorait mutatta be, hanem meglepően sok részletet elárult a következő generációs platformokról is, köztük egy 600 kW-os rackban megjelenő 576 GPU-t tartalmazó rendszerről is. Azt is megtudtuk, hogy egy 2028-ban érkező GPU-családot Richard Feynmanról neveznek el. Mindez nem szokatlan, hiszen a chipgyártók évekre előre kidolgozzák az útiterveiket, de ennyi információt általában nem kapunk egyszerre. És ez azért van, mert az Nvidia megrekedt. Nem csak egy, hanem több akadályba is belefutott. Ami még rosszabb, hogy a pénzszóráson kívül mindezek nagyrészt kívül esnek az Nvidia ellenőrzési körén. Ezek a kihívások nem jelentenek nagy meglepetést, hiszen az elosztott számítástechnika mindig is a szűk keresztmetszetek megoldását célzó játék volt, és a mesterséges intelligencia mindezen eddigi problémák csúcsa.

Az első és legnyilvánvalóbb kihívás a számítási kapacitás skálázása körül forog. A számítási teljesítmény növelése az elmúlt években lelassult. Bár még mindig vannak lehetőségek, de egyre nagyobb problémák tornyosulnak a mérnökök előtt. Ezen korlátok megoldására az Nvidia stratégiája egyszerű: a lehető legnagyobb mértékben növelni a szilícium mennyiségét az egyes számítási csomópontokban. Ma az Nvidia legsűrűbb rendszerei, vagyis rackjei 72 GPU-t drótoznak össze egyetlen számítási tartományba egy nagy sebességű, 1,8 TB/s-os NVLink szövet segítségével. Nyolc vagy több ilyen racket aztán InfiniBand vagy Ethernet segítségével fűznek össze a kívánt számítási és memóriakapacitás eléréséhez.

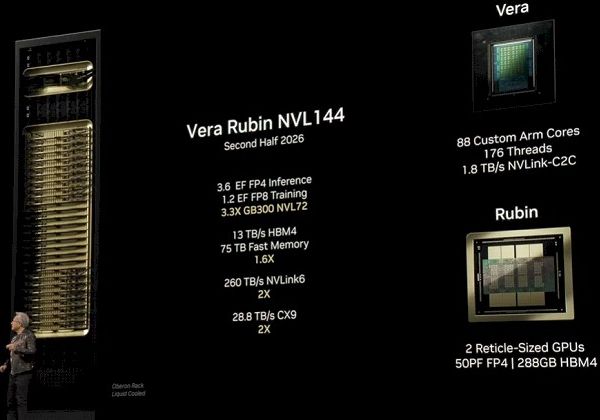

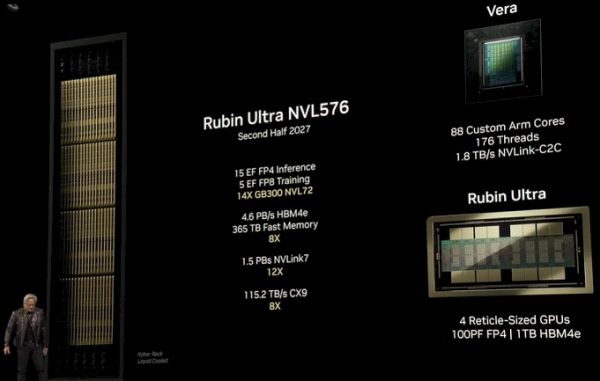

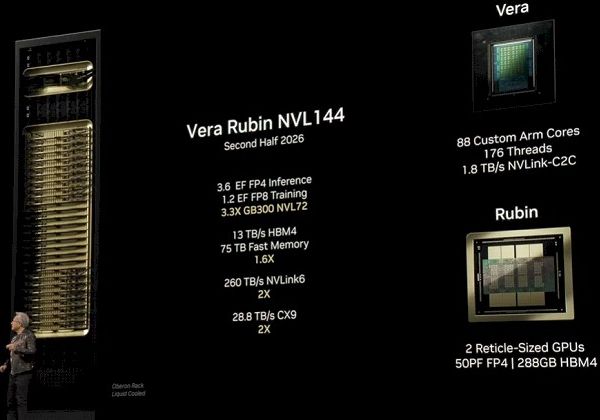

A GTC-n az Nvidia elárulta, hogy ezt 144, majd végül 576 GPU-ra kívánja növelni rackenként. A skálázás azonban nem korlátozódik a rackekre, hanem a chipeken belül is ugyanezt csinálják. Ez az Nvidia Blackwell gyorsítók egy évvel ezelőtti bevezetésével vált nyilvánvalóvá. Ezek a chipek ötször nagyobb teljesítménynövekedéssel büszkélkedtek a Hopperhez képest, ami nagyszerűen hangzik, amíg ki nem derült, hogy ehhez kétszer annyi lapka, egy új 4 bites adattípus és 500 wattal több energia kellett. A valóság az, hogy FP16-ra normalizálva az Nvidia csúcs-specifikációjú Blackwell-magjai csak körülbelül 1,25-ször gyorsabbak, mint egy GH100 - 1250 teraFLOPS szemben a 989-cel - csak történetesen kettő volt belőlük.

Azt még nem tudjuk, hogy az Nvidia milyen processzortechnológiát tervez használni a következő generációs chipjeihez, de azt tudjuk, hogy a Rubin Ultra folytatja ezt a trendet, és a duplázott magokról négyre ugrik. Még a nagyjából 20 százalékos hatékonyságnövekedéssel együtt is, amit Huang a TSMC 2 nm-es gyártásától vár, ez még mindig egy iszonyatosan melegedő termék lesz.

De nem csak a számítási feladatokról van szó, hanem a memóriáról is. A sasszeműek észrevehették, hogy a Rubin és a Rubin Ultra között elég jelentős ugrás történt a kapacitás és a sávszélesség terén: tokozásonkénti 288 GB-ról 1 TB-ra nőtt. Ennek nagyjából a fele a gyorsabb, nagyobb kapacitású memóriamoduloknak köszönhető, a másik fele pedig annak, hogy a Blackwell és a Rubin esetében nyolc modulról 16-ra nőtt a memóriára szánt szilícium mennyisége a Rubin Ultra esetében. A nagyobb kapacitás azt jelenti, hogy az Nvidia több modellparamétert - az FP4-nél körülbelül 2 billiót - tud egyetlen tokba zsúfolni, vagy 500 milliárdot „GPU”-nként, mivel most már nem a foglalatokat, hanem az egyes lapkákat számolják. A HBM4e a HBM3e memória sávszélességét is megduplázza. A sávszélesség a Rubin Ultra esetében várhatóan a mai 4TB/s-ról 8TB/s körüli sebességre ugrik Blackwell-magonként.

Sajnos, ha nem történik jelentős áttörés a számítási technológiában, akkor valószínű, hogy az Nvidia GPU-foglalatai még több szilíciumot fognak tartalmazni.

A jó hír az, hogy a processzorok fejlődése nem az egyetlen módja a számítási teljesítmény vagy memória felskálázásának. Általánosságban elmondható, hogy a 16 bites pontosságról 8 bitesre való csökkentés hatékonyan megduplázza az átviteli teljesítményt, miközben az adott modell memóriaigénye is a felére csökken. A probléma az, hogy az Nvidia kifogy a bitekből, amiket ki lehet dobni a teljesítménynövekedés érdekében. A Hopperről a Blackwellre váltáskor az Nvidia négy bitet dobott ki, megduplázta a szilíciumot, és 5-szörös lebegőpont-növekedést közölt. Négy bites pontosság alatt azonban az LLM következtetés elég durvává válik, a perplexitási pontszámok gyorsan emelkednek. Ennek ellenére érdekes kutatások folynak a szuper alacsony pontosságú kvantálással kapcsolatban, akár 1,58 bites pontossággal, a pontosság megtartása mellett.

De nem a csökkentett pontosság az egyetlen módja a FLOPS-ok növelésének. Kevesebb területet is lehet szánni a nagyobb pontosságú adattípusokra, amelyekre az MI-munkaterheléseknek nincs szükségük. Ezt láttuk a Blackwell Ultra esetében. Ian Buck, az Nvidia számítási üzletágának alelnöke egy interjúban elmondta, hogy csökkentették a chip dupla pontosságú (FP64) tenzormagjának teljesítményét, cserébe 50%-kal több 4 bites FLOPS-ért. Hogy ez annak a jele-e, hogy az FP64 az Nvidiánál a végét járja, azt még nem tudjuk, de ha tényleg fontos a dupla pontosságú teljesítmény, akkor az AMD GPU-k és APU-k valószínűleg amúgy is a lista élén kellene, hogy álljanak.

Mindenesetre az Nvidia útja egyértelmű: a számítási platformok innentől kezdve csak nagyobbak, sűrűbbek, forróbbak és energiaigényesebbek lesznek. Ahogy Huang egy múlt heti sajtóértekezleten fogalmazott, egy rack számára a gyakorlati határ az, hogy mennyi energiát tudsz neki adni. "Egy adatközpont ma már 250 megawattot fogyaszt. Ez korlátozza be a rackenkénti fogyasztást. Azt hiszem, a többi már csak részletkérdés” - mondta Huang. „Ha azt mondanánk, hogy egy adatközpont egy gigawatt, én azt mondanám, hogy egy gigawatt rackenként jól hangzik.”

De a 600 kW-os rackek pokoli fejfájást okoznak az adatközpontok üzemeltetőinek. Hogy tisztázzuk, a megawattos, ultrasűrű számítási kapacitás hűtése nem új probléma. A Cray, az Eviden és a Lenovo munkatársai már évek óta foglalkoznak ezzel. Ami megváltozott, az az, hogy ma már nem évente csak maroknyi számítási klaszterről van szó, hanem több tucatról, amelyek közül néhány olyan nagy, hogy a Top500 legerősebb szuperszámítógépeit is letaszítaná a trónról, ha 200 000 összekötött Hopper GPU teljesítményének Linpack-mérése pénzt hozna. Ilyen méretarányoknál a nagymértékben specializált, kis volumenű hőkezelési és energiaellátási rendszerek egyszerűen nem lesznek elegendőek. Sajnos az adatközpontok szállítói - akik azokat a nem túl szexi alkatrészeket árulják, amelyek ahhoz kellenek, hogy a több millió dolláros NVL72 rackek működjenek - csak most érik utol a keresletet.

Valószínűleg ez az oka annak, hogy az eddig bejelentett Blackwell-telepítések közül oly sok csak a léghűtéses HGX B200-ra vonatkozik, és nem a Huang által folyamatosan reklámozott NVL72-re. Ezek a nyolc GPU-s HGX-rendszerek számos meglévő H100-as környezetben is bevethetők. Az Nvidia már évek óta csinál 30-40 kW-os rackeket, így a 60 kW-ra való ugrás nem olyan nagy falat, főleg hogy lehetőség van a rackenkénti két-három szerverre való csökkentésre is. De az NVL72 rackkialakításnál - amelynél a felhőszolgáltatókhoz hasonlóan elől van a hálózati csatlakozás - a 120 kW-os masina folyadékkal való lehűtése néhánynál több ilyen gép telepítése esetén gyorsan problémássá válik a meglévő létesítményekben. És ennek megoldása csak még nehezebb lesz, amint 2027 végén debütálnak az Nvidia 600 kW-os monstrum rackjei.

Itt jönnek a képbe azok az „MI-gyárak”, amelyekről Huang állandóan beszél - a Schneider Electrichez hasonló partnerekkel együttműködve tervezett, kifejezetten az MI energia- és hőigényének kielégítésére tervezett adatközpontok. És meglepetésre egy héttel azután, hogy Huang részletezte a következő három évre szóló GPU-útitervét, a a Schneider bejelentette, hogy 700 millió dolláros bővítést hajt végre az Egyesült Államokban, hogy növelje az Nvidia rackek támogatásáshoz szükséges energia- és hűtőkészletek gyártását.

De nem csak az a probléma, hogy az ultra sűrű rendszerek áramellátásához és hűtéséhez szükséges infrastruktúrát ki kell alakítani, hanem az is, hogy az áram egyáltalán eljusson az adatközpontba. Ez megint csak nagyrészt kívül esik az Nvidia ellenőrzési körén. Amikor a Meta, az Oracle, a Microsoft vagy bárki más bejelent egy újabb mesterséges intelligenciával működő szerverfarmot, általában egy szaftos áramvásárlási megállapodás következik. A Meta készülő adatközpontját egy 2,2 GW-os gázerőművel együtt jelentették be - ennyit a fenntarthatósági és karbonsemlegességi ígéretekről. És bármennyire is szeretnénk ha a nukleáris energia visszatérne, nehéz komolyan venni a kis moduláris reaktorokat, amikor még a legoptimistább előrejelzések is a 2030-as évekre teszik azok üzembe helyezését.

Hogy egyértelmű legyen, a fenti akadályok közül egyik sem csak az Nvidia esetében merül fel. Az AMD, az Intel és minden más felhőszolgáltató és chiptervező, aki az Nvidia piaci részesedésének egy szeletéért verseng, hamarosan ugyanezekkel a kihívásokkal fog szembesülni. Az Nvidia csak történetesen az elsők között van, aki szembekerül velük. Bár ennek kétségtelenül megvannak a maga hátrányai, az Nvidia egyúttal egyedülálló helyzetbe is kerül, hogy alakítsa a jövőbeli adatközpontok energia- és hőtervezésének irányát. Huang azért volt hajlandó felfedni a következő három generáció GPU-technológiáját, és azért lengette be a negyediket is, hogy infrastrukturális partnerei készen álljanak azok támogatására, amikor azok végre megérkeznek. "Az ok, amiért közöltem a világgal, hogy mi az Nvidia következő három éves útiterve, az az, hogy most már mindenki más is tervezhet” - mondta Huang.

Másfelől ezek az erőfeszítések arra is szolgálnak, hogy szabaddá tegyék az utat a konkurens chipgyártók számára. Ha az Nvidia egy 120 kW-os, vagy most már 600 kW-os racket tervez, és a telephelyszolgáltatók és a felhőszolgáltatók hajlandóak ezt támogatni, akkor az AMD-nek vagy az Intelnek most már szabad a pálya, hogy ugyanannyi számítási kapacitást pakoljanak a saját rackméretű platformjaikba anélkül, hogy aggódniuk kellene amiatt, hogy az ügyfelek hova fogják elhelyezni azokat.

A GTC színpadán állva Huang nemcsak a chiptervező következő generációs Blackwell Ultra processzorait mutatta be, hanem meglepően sok részletet elárult a következő generációs platformokról is, köztük egy 600 kW-os rackban megjelenő 576 GPU-t tartalmazó rendszerről is. Azt is megtudtuk, hogy egy 2028-ban érkező GPU-családot Richard Feynmanról neveznek el. Mindez nem szokatlan, hiszen a chipgyártók évekre előre kidolgozzák az útiterveiket, de ennyi információt általában nem kapunk egyszerre. És ez azért van, mert az Nvidia megrekedt. Nem csak egy, hanem több akadályba is belefutott. Ami még rosszabb, hogy a pénzszóráson kívül mindezek nagyrészt kívül esnek az Nvidia ellenőrzési körén. Ezek a kihívások nem jelentenek nagy meglepetést, hiszen az elosztott számítástechnika mindig is a szűk keresztmetszetek megoldását célzó játék volt, és a mesterséges intelligencia mindezen eddigi problémák csúcsa.

Az első és legnyilvánvalóbb kihívás a számítási kapacitás skálázása körül forog. A számítási teljesítmény növelése az elmúlt években lelassult. Bár még mindig vannak lehetőségek, de egyre nagyobb problémák tornyosulnak a mérnökök előtt. Ezen korlátok megoldására az Nvidia stratégiája egyszerű: a lehető legnagyobb mértékben növelni a szilícium mennyiségét az egyes számítási csomópontokban. Ma az Nvidia legsűrűbb rendszerei, vagyis rackjei 72 GPU-t drótoznak össze egyetlen számítási tartományba egy nagy sebességű, 1,8 TB/s-os NVLink szövet segítségével. Nyolc vagy több ilyen racket aztán InfiniBand vagy Ethernet segítségével fűznek össze a kívánt számítási és memóriakapacitás eléréséhez.

A GTC-n az Nvidia elárulta, hogy ezt 144, majd végül 576 GPU-ra kívánja növelni rackenként. A skálázás azonban nem korlátozódik a rackekre, hanem a chipeken belül is ugyanezt csinálják. Ez az Nvidia Blackwell gyorsítók egy évvel ezelőtti bevezetésével vált nyilvánvalóvá. Ezek a chipek ötször nagyobb teljesítménynövekedéssel büszkélkedtek a Hopperhez képest, ami nagyszerűen hangzik, amíg ki nem derült, hogy ehhez kétszer annyi lapka, egy új 4 bites adattípus és 500 wattal több energia kellett. A valóság az, hogy FP16-ra normalizálva az Nvidia csúcs-specifikációjú Blackwell-magjai csak körülbelül 1,25-ször gyorsabbak, mint egy GH100 - 1250 teraFLOPS szemben a 989-cel - csak történetesen kettő volt belőlük.

Azt még nem tudjuk, hogy az Nvidia milyen processzortechnológiát tervez használni a következő generációs chipjeihez, de azt tudjuk, hogy a Rubin Ultra folytatja ezt a trendet, és a duplázott magokról négyre ugrik. Még a nagyjából 20 százalékos hatékonyságnövekedéssel együtt is, amit Huang a TSMC 2 nm-es gyártásától vár, ez még mindig egy iszonyatosan melegedő termék lesz.

De nem csak a számítási feladatokról van szó, hanem a memóriáról is. A sasszeműek észrevehették, hogy a Rubin és a Rubin Ultra között elég jelentős ugrás történt a kapacitás és a sávszélesség terén: tokozásonkénti 288 GB-ról 1 TB-ra nőtt. Ennek nagyjából a fele a gyorsabb, nagyobb kapacitású memóriamoduloknak köszönhető, a másik fele pedig annak, hogy a Blackwell és a Rubin esetében nyolc modulról 16-ra nőtt a memóriára szánt szilícium mennyisége a Rubin Ultra esetében. A nagyobb kapacitás azt jelenti, hogy az Nvidia több modellparamétert - az FP4-nél körülbelül 2 billiót - tud egyetlen tokba zsúfolni, vagy 500 milliárdot „GPU”-nként, mivel most már nem a foglalatokat, hanem az egyes lapkákat számolják. A HBM4e a HBM3e memória sávszélességét is megduplázza. A sávszélesség a Rubin Ultra esetében várhatóan a mai 4TB/s-ról 8TB/s körüli sebességre ugrik Blackwell-magonként.

Sajnos, ha nem történik jelentős áttörés a számítási technológiában, akkor valószínű, hogy az Nvidia GPU-foglalatai még több szilíciumot fognak tartalmazni.

A jó hír az, hogy a processzorok fejlődése nem az egyetlen módja a számítási teljesítmény vagy memória felskálázásának. Általánosságban elmondható, hogy a 16 bites pontosságról 8 bitesre való csökkentés hatékonyan megduplázza az átviteli teljesítményt, miközben az adott modell memóriaigénye is a felére csökken. A probléma az, hogy az Nvidia kifogy a bitekből, amiket ki lehet dobni a teljesítménynövekedés érdekében. A Hopperről a Blackwellre váltáskor az Nvidia négy bitet dobott ki, megduplázta a szilíciumot, és 5-szörös lebegőpont-növekedést közölt. Négy bites pontosság alatt azonban az LLM következtetés elég durvává válik, a perplexitási pontszámok gyorsan emelkednek. Ennek ellenére érdekes kutatások folynak a szuper alacsony pontosságú kvantálással kapcsolatban, akár 1,58 bites pontossággal, a pontosság megtartása mellett.

De nem a csökkentett pontosság az egyetlen módja a FLOPS-ok növelésének. Kevesebb területet is lehet szánni a nagyobb pontosságú adattípusokra, amelyekre az MI-munkaterheléseknek nincs szükségük. Ezt láttuk a Blackwell Ultra esetében. Ian Buck, az Nvidia számítási üzletágának alelnöke egy interjúban elmondta, hogy csökkentették a chip dupla pontosságú (FP64) tenzormagjának teljesítményét, cserébe 50%-kal több 4 bites FLOPS-ért. Hogy ez annak a jele-e, hogy az FP64 az Nvidiánál a végét járja, azt még nem tudjuk, de ha tényleg fontos a dupla pontosságú teljesítmény, akkor az AMD GPU-k és APU-k valószínűleg amúgy is a lista élén kellene, hogy álljanak.

Mindenesetre az Nvidia útja egyértelmű: a számítási platformok innentől kezdve csak nagyobbak, sűrűbbek, forróbbak és energiaigényesebbek lesznek. Ahogy Huang egy múlt heti sajtóértekezleten fogalmazott, egy rack számára a gyakorlati határ az, hogy mennyi energiát tudsz neki adni. "Egy adatközpont ma már 250 megawattot fogyaszt. Ez korlátozza be a rackenkénti fogyasztást. Azt hiszem, a többi már csak részletkérdés” - mondta Huang. „Ha azt mondanánk, hogy egy adatközpont egy gigawatt, én azt mondanám, hogy egy gigawatt rackenként jól hangzik.”

De a 600 kW-os rackek pokoli fejfájást okoznak az adatközpontok üzemeltetőinek. Hogy tisztázzuk, a megawattos, ultrasűrű számítási kapacitás hűtése nem új probléma. A Cray, az Eviden és a Lenovo munkatársai már évek óta foglalkoznak ezzel. Ami megváltozott, az az, hogy ma már nem évente csak maroknyi számítási klaszterről van szó, hanem több tucatról, amelyek közül néhány olyan nagy, hogy a Top500 legerősebb szuperszámítógépeit is letaszítaná a trónról, ha 200 000 összekötött Hopper GPU teljesítményének Linpack-mérése pénzt hozna. Ilyen méretarányoknál a nagymértékben specializált, kis volumenű hőkezelési és energiaellátási rendszerek egyszerűen nem lesznek elegendőek. Sajnos az adatközpontok szállítói - akik azokat a nem túl szexi alkatrészeket árulják, amelyek ahhoz kellenek, hogy a több millió dolláros NVL72 rackek működjenek - csak most érik utol a keresletet.

Valószínűleg ez az oka annak, hogy az eddig bejelentett Blackwell-telepítések közül oly sok csak a léghűtéses HGX B200-ra vonatkozik, és nem a Huang által folyamatosan reklámozott NVL72-re. Ezek a nyolc GPU-s HGX-rendszerek számos meglévő H100-as környezetben is bevethetők. Az Nvidia már évek óta csinál 30-40 kW-os rackeket, így a 60 kW-ra való ugrás nem olyan nagy falat, főleg hogy lehetőség van a rackenkénti két-három szerverre való csökkentésre is. De az NVL72 rackkialakításnál - amelynél a felhőszolgáltatókhoz hasonlóan elől van a hálózati csatlakozás - a 120 kW-os masina folyadékkal való lehűtése néhánynál több ilyen gép telepítése esetén gyorsan problémássá válik a meglévő létesítményekben. És ennek megoldása csak még nehezebb lesz, amint 2027 végén debütálnak az Nvidia 600 kW-os monstrum rackjei.

Itt jönnek a képbe azok az „MI-gyárak”, amelyekről Huang állandóan beszél - a Schneider Electrichez hasonló partnerekkel együttműködve tervezett, kifejezetten az MI energia- és hőigényének kielégítésére tervezett adatközpontok. És meglepetésre egy héttel azután, hogy Huang részletezte a következő három évre szóló GPU-útitervét, a a Schneider bejelentette, hogy 700 millió dolláros bővítést hajt végre az Egyesült Államokban, hogy növelje az Nvidia rackek támogatásáshoz szükséges energia- és hűtőkészletek gyártását.

De nem csak az a probléma, hogy az ultra sűrű rendszerek áramellátásához és hűtéséhez szükséges infrastruktúrát ki kell alakítani, hanem az is, hogy az áram egyáltalán eljusson az adatközpontba. Ez megint csak nagyrészt kívül esik az Nvidia ellenőrzési körén. Amikor a Meta, az Oracle, a Microsoft vagy bárki más bejelent egy újabb mesterséges intelligenciával működő szerverfarmot, általában egy szaftos áramvásárlási megállapodás következik. A Meta készülő adatközpontját egy 2,2 GW-os gázerőművel együtt jelentették be - ennyit a fenntarthatósági és karbonsemlegességi ígéretekről. És bármennyire is szeretnénk ha a nukleáris energia visszatérne, nehéz komolyan venni a kis moduláris reaktorokat, amikor még a legoptimistább előrejelzések is a 2030-as évekre teszik azok üzembe helyezését.

Hogy egyértelmű legyen, a fenti akadályok közül egyik sem csak az Nvidia esetében merül fel. Az AMD, az Intel és minden más felhőszolgáltató és chiptervező, aki az Nvidia piaci részesedésének egy szeletéért verseng, hamarosan ugyanezekkel a kihívásokkal fog szembesülni. Az Nvidia csak történetesen az elsők között van, aki szembekerül velük. Bár ennek kétségtelenül megvannak a maga hátrányai, az Nvidia egyúttal egyedülálló helyzetbe is kerül, hogy alakítsa a jövőbeli adatközpontok energia- és hőtervezésének irányát. Huang azért volt hajlandó felfedni a következő három generáció GPU-technológiáját, és azért lengette be a negyediket is, hogy infrastrukturális partnerei készen álljanak azok támogatására, amikor azok végre megérkeznek. "Az ok, amiért közöltem a világgal, hogy mi az Nvidia következő három éves útiterve, az az, hogy most már mindenki más is tervezhet” - mondta Huang.

Másfelől ezek az erőfeszítések arra is szolgálnak, hogy szabaddá tegyék az utat a konkurens chipgyártók számára. Ha az Nvidia egy 120 kW-os, vagy most már 600 kW-os racket tervez, és a telephelyszolgáltatók és a felhőszolgáltatók hajlandóak ezt támogatni, akkor az AMD-nek vagy az Intelnek most már szabad a pálya, hogy ugyanannyi számítási kapacitást pakoljanak a saját rackméretű platformjaikba anélkül, hogy aggódniuk kellene amiatt, hogy az ügyfelek hova fogják elhelyezni azokat.