SG.hu

Az Nvidia bemutatta a "világ legerősebb chipjét", a Blackwell B200 GPU-t

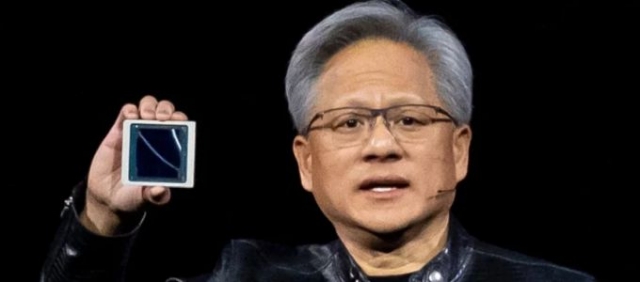

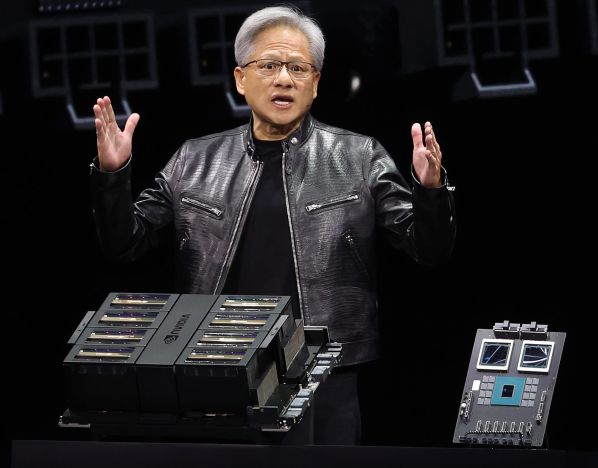

A vállalat bejelentette vadonatúj Blackwell platformját. A vezérigazgató, Jensen Huang szerint a processzor magja "a fizika határait feszegeti, hogy mekkora lehet egy chip".

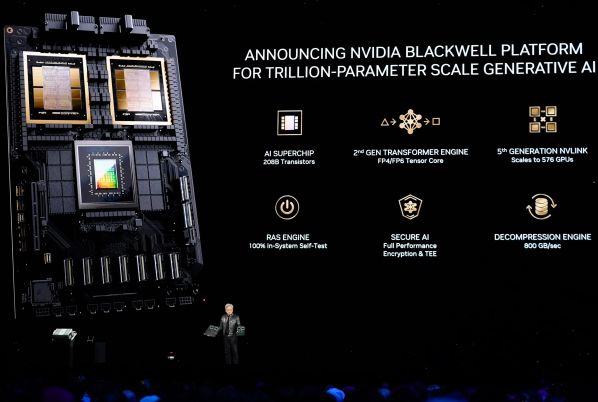

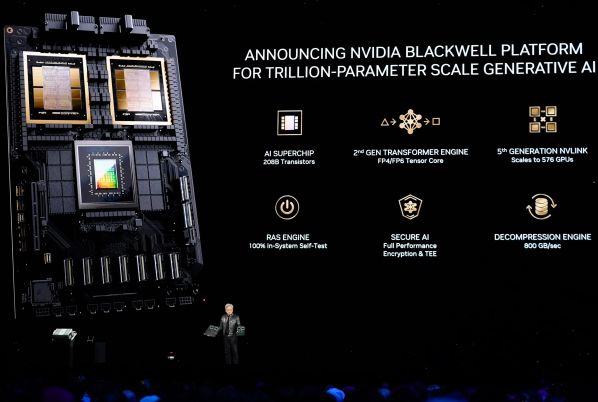

Az új B200 GPU 208 milliárd tranzisztorból áll, és a cég közlése szerint teljesítménye akár 20 petaflops FP4 számítások esetén. A GB200 két ilyen GPU-t kombinál egy Grace CPU-val, így az Nvidia szerint 30-szor nagyobb teljesítményt nyújt a nagy nyelvi modellek (LLM) következtetési munkaterhelésénél, és eközben "akár 25-ször kevesebb költséggel és energiafogyasztással jár", mint egy H100-as. Az Nvidia állítása szerint egy 1,8 trillió paraméteres mesterséges intelligencia-modell képzéséhez korábban 8000 Hopper GPU-ra és 15 megawatt teljesítményre lett volna szükség. Ma az Nvidia vezérigazgatója szerint 2000 Blackwell GPU képes erre mindössze négy megawatt fogyasztás mellett.

Az Nvidia az újságíróknak elmondta, hogy az egyik legfontosabb fejlesztés a második generációs szoftvermotor, amely megduplázza a számítási kapacitást, a sávszélességet és a modell méretét, mivel nyolc helyett négy bitet használ minden egyes neuronhoz. A másik kulcsfontosságú különbség akkor jelentkezik, ha nagyszámú ilyen GPU-t kapcsolunk össze: egy újgenerációs NVLink kapcsoló 576 GPU-t enged egymással beszélgetni másodpercenként 1,8 terabájt kétirányú sávszélességgel. Ehhez az Nvidiának egy teljesen új hálózati kapcsolóchipet kellett építenie, amely 50 milliárd tranzisztorral és saját fedélzeti számítással rendelkezik. Az Nvidia szerint korábban egy 16 GPU-ból álló fürt az idő 60 százalékát az egymással való kommunikációval töltötte, és csak 40 százalékát a tényleges számítással.

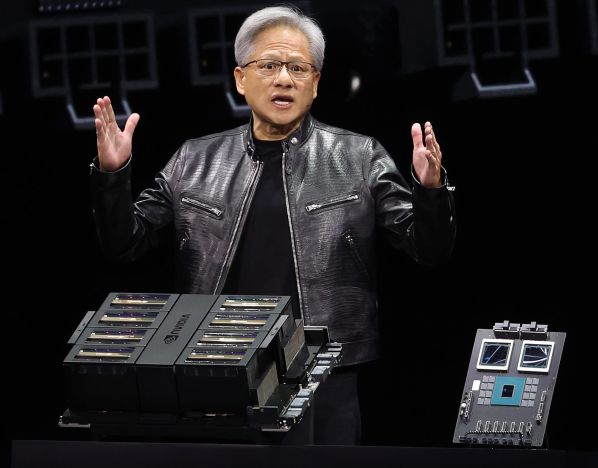

Az Nvidia arra számít, hogy a vállalatok nagy mennyiségben vásárolnak ilyen GPU-kat, és nagyobb konstrukciókba csomagolja őket, mint például a GB200 NVL72, amely 36 CPU-t és 72 GPU-t helyez egyetlen folyadékhűtéses rackbe, ami összesen 720 petaflop MI-tréning teljesítményt vagy 1440 petaflop (azaz 1,4 exaflops) következtetési teljesítményt tesz lehetővé. A termék belsejében közel két mérföldnyi vezeték található, 5000 egyedi kábellel. A rackben minden tálca vagy két GB200 chipet, vagy két NVLink switchet tartalmaz, előbbiből 18, utóbbiból kilenc darab van rackenként. Összességében az Nvidia szerint egy ilyen rack egy 27 trillió paraméteres modellt képes támogatni. A GPT-4 a pletykák szerint 1,7 billió paraméteres modell körül lesz.

A vállalat szerint az Amazon, a Google, a Microsoft és az Oracle már tervezi, hogy az NVL72 rackeket felhőszolgáltatási kínálatában kínálja, bár az nem világos, hogy mennyit vásárolnak belőlük. És természetesen az Nvidia szívesen kínálja a vállalatoknak a megoldás többi részét is. Itt van a DGX GB200-hoz készült DGX Superpod, amely nyolc rendszert egyesít egyben, összesen 288 CPU-t, 576 GPU-t, 240 TB memóriát és 11,5 exaflops FP4 számítási teljesítményt kínálva. Az Nvidia szerint rendszerei több tízezer GB200-as szuperchipre skálázhatók, amelyeket 800 Gbps-os hálózattal, az új Quantum-X800 InfiniBand (akár 144 csatlakozásra) vagy Spectrum-X800 ethernet (akár 64 csatlakozásra) segítségével kapcsolnak össze.

Az új B200 GPU 208 milliárd tranzisztorból áll, és a cég közlése szerint teljesítménye akár 20 petaflops FP4 számítások esetén. A GB200 két ilyen GPU-t kombinál egy Grace CPU-val, így az Nvidia szerint 30-szor nagyobb teljesítményt nyújt a nagy nyelvi modellek (LLM) következtetési munkaterhelésénél, és eközben "akár 25-ször kevesebb költséggel és energiafogyasztással jár", mint egy H100-as. Az Nvidia állítása szerint egy 1,8 trillió paraméteres mesterséges intelligencia-modell képzéséhez korábban 8000 Hopper GPU-ra és 15 megawatt teljesítményre lett volna szükség. Ma az Nvidia vezérigazgatója szerint 2000 Blackwell GPU képes erre mindössze négy megawatt fogyasztás mellett.

Az Nvidia az újságíróknak elmondta, hogy az egyik legfontosabb fejlesztés a második generációs szoftvermotor, amely megduplázza a számítási kapacitást, a sávszélességet és a modell méretét, mivel nyolc helyett négy bitet használ minden egyes neuronhoz. A másik kulcsfontosságú különbség akkor jelentkezik, ha nagyszámú ilyen GPU-t kapcsolunk össze: egy újgenerációs NVLink kapcsoló 576 GPU-t enged egymással beszélgetni másodpercenként 1,8 terabájt kétirányú sávszélességgel. Ehhez az Nvidiának egy teljesen új hálózati kapcsolóchipet kellett építenie, amely 50 milliárd tranzisztorral és saját fedélzeti számítással rendelkezik. Az Nvidia szerint korábban egy 16 GPU-ból álló fürt az idő 60 százalékát az egymással való kommunikációval töltötte, és csak 40 százalékát a tényleges számítással.

Az Nvidia arra számít, hogy a vállalatok nagy mennyiségben vásárolnak ilyen GPU-kat, és nagyobb konstrukciókba csomagolja őket, mint például a GB200 NVL72, amely 36 CPU-t és 72 GPU-t helyez egyetlen folyadékhűtéses rackbe, ami összesen 720 petaflop MI-tréning teljesítményt vagy 1440 petaflop (azaz 1,4 exaflops) következtetési teljesítményt tesz lehetővé. A termék belsejében közel két mérföldnyi vezeték található, 5000 egyedi kábellel. A rackben minden tálca vagy két GB200 chipet, vagy két NVLink switchet tartalmaz, előbbiből 18, utóbbiból kilenc darab van rackenként. Összességében az Nvidia szerint egy ilyen rack egy 27 trillió paraméteres modellt képes támogatni. A GPT-4 a pletykák szerint 1,7 billió paraméteres modell körül lesz.

A vállalat szerint az Amazon, a Google, a Microsoft és az Oracle már tervezi, hogy az NVL72 rackeket felhőszolgáltatási kínálatában kínálja, bár az nem világos, hogy mennyit vásárolnak belőlük. És természetesen az Nvidia szívesen kínálja a vállalatoknak a megoldás többi részét is. Itt van a DGX GB200-hoz készült DGX Superpod, amely nyolc rendszert egyesít egyben, összesen 288 CPU-t, 576 GPU-t, 240 TB memóriát és 11,5 exaflops FP4 számítási teljesítményt kínálva. Az Nvidia szerint rendszerei több tízezer GB200-as szuperchipre skálázhatók, amelyeket 800 Gbps-os hálózattal, az új Quantum-X800 InfiniBand (akár 144 csatlakozásra) vagy Spectrum-X800 ethernet (akár 64 csatlakozásra) segítségével kapcsolnak össze.