Berta Sándor

Szövegből animációt hoz létre egy számítógépes modell

A megoldás különösen hasznos lehet a forgatókönyvekből való vázlatkészítésben.

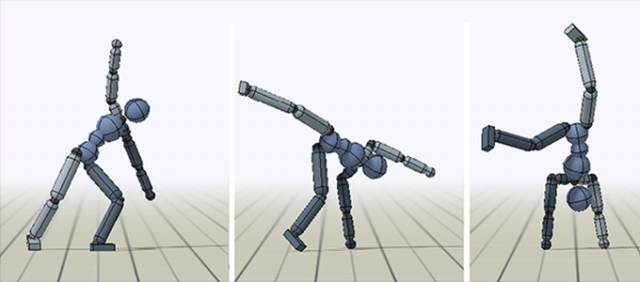

A Carnegie Mellon Egyetem szakértői egy olyan számítógépes modellt fejlesztettek ki, amely a szövegeket animációkká alakítja át. A projekt során a kutatók a Joint Language-to-Pose (JL2P) nevű öntanuló rendszerre építettek, amely automatikusan felismeri a szövegekben azokat a részeket, amelyek mozgásokat írnak le, majd "lefordítja" azokat egyszerű, számítógép által generált rajzocskákra. A megoldás segítségével a jövőben akár teljes forgatókönyveket is filmekké lehet majd varázsolni.

Louis-Philippe Morency egyetemi docens, a Carnegie Mellon Egyetem Nyelvtechnológiai Intézetének munkatársa kiemelte, hogy a tudomány már eddig is hatalmas előrelépéseket könyvelhetett el, ha arról volt szó, hogy a számítógépeket megtanítsa a természetes nyelv megértésére, illetve hogy valósághű animációkat lehessen létrehozni számos fizikai póz és mozgás alapján. Sajnos eddig még nem sikerült kapcsolatot kiépíteni a nyelv és a mozgások között. A neurális architektúrájuk segítségével ezt a két világot akarják ötvözni. A JL2P-modell megérti ugyanis, hogy miként függ össze a nyelv a cselekvésekkel, a gesztusokkal és a mozgásokkal. A fejlesztés ugyanakkor még nagyon korai szakaszban van.

Morency hozzátette, hogy a mesterséges intelligencia és az elméleti alapok szempontjából az egész dolog rendkívül izgalmas. Jelenleg minden a virtuális karakterek animációi körül forog. A nyelv és a mozgások összekapcsolását fel lehetne használni például a robotoknál is. Így egy személyes segítőnek meg lehetne mondani, hogy mit tegyen, fordított esetben pedig egy számítógép is felismerhetné, hogy mi látható egy videóban.

A tudósok az innovatív JL2P megoldásuk kifejlesztésére egy feszített tantervet dolgoztak ki a számítógépes modelljük számára. A rendszernek először a rövid, egyszerű mozgásokat kell megtanulnia, például azt, ha egyetlen személy előrehalad. Később fokozatosan növelték a mozgások bonyolultságát, így a modell már a nehezebb és hosszabb mozgásokat is megtanulta felismerni.

Tavaly áprilisban a Berkeley Egyetem kutatói alkottak meg egy olyan rendszert, amelynek köszönhetően a filmekben és a játékokban sokkal természetesebbeknek nézhetnek majd ki a mesterséges figurák mozgásanimációi. A DeepMimic nevű technológia egy különleges algoritmusra és öntanuló gépi tanulási módszerekre épül. Ezeknek - az emberhez hasonlóan - szükségük van edzésre ahhoz, hogy bizonyos akrobatikus mozgásokat - például a break táncot vagy a harcművészeteket - valósághű módon jeleníthessék meg. Amennyiben a rendszer megtanulta ezeket a mozgásokat, akkor képessé válik akár a spontán mozgássorok, például az esések szimulálására is.

A Carnegie Mellon Egyetem szakértői egy olyan számítógépes modellt fejlesztettek ki, amely a szövegeket animációkká alakítja át. A projekt során a kutatók a Joint Language-to-Pose (JL2P) nevű öntanuló rendszerre építettek, amely automatikusan felismeri a szövegekben azokat a részeket, amelyek mozgásokat írnak le, majd "lefordítja" azokat egyszerű, számítógép által generált rajzocskákra. A megoldás segítségével a jövőben akár teljes forgatókönyveket is filmekké lehet majd varázsolni.

Louis-Philippe Morency egyetemi docens, a Carnegie Mellon Egyetem Nyelvtechnológiai Intézetének munkatársa kiemelte, hogy a tudomány már eddig is hatalmas előrelépéseket könyvelhetett el, ha arról volt szó, hogy a számítógépeket megtanítsa a természetes nyelv megértésére, illetve hogy valósághű animációkat lehessen létrehozni számos fizikai póz és mozgás alapján. Sajnos eddig még nem sikerült kapcsolatot kiépíteni a nyelv és a mozgások között. A neurális architektúrájuk segítségével ezt a két világot akarják ötvözni. A JL2P-modell megérti ugyanis, hogy miként függ össze a nyelv a cselekvésekkel, a gesztusokkal és a mozgásokkal. A fejlesztés ugyanakkor még nagyon korai szakaszban van.

Morency hozzátette, hogy a mesterséges intelligencia és az elméleti alapok szempontjából az egész dolog rendkívül izgalmas. Jelenleg minden a virtuális karakterek animációi körül forog. A nyelv és a mozgások összekapcsolását fel lehetne használni például a robotoknál is. Így egy személyes segítőnek meg lehetne mondani, hogy mit tegyen, fordított esetben pedig egy számítógép is felismerhetné, hogy mi látható egy videóban.

A tudósok az innovatív JL2P megoldásuk kifejlesztésére egy feszített tantervet dolgoztak ki a számítógépes modelljük számára. A rendszernek először a rövid, egyszerű mozgásokat kell megtanulnia, például azt, ha egyetlen személy előrehalad. Később fokozatosan növelték a mozgások bonyolultságát, így a modell már a nehezebb és hosszabb mozgásokat is megtanulta felismerni.

Tavaly áprilisban a Berkeley Egyetem kutatói alkottak meg egy olyan rendszert, amelynek köszönhetően a filmekben és a játékokban sokkal természetesebbeknek nézhetnek majd ki a mesterséges figurák mozgásanimációi. A DeepMimic nevű technológia egy különleges algoritmusra és öntanuló gépi tanulási módszerekre épül. Ezeknek - az emberhez hasonlóan - szükségük van edzésre ahhoz, hogy bizonyos akrobatikus mozgásokat - például a break táncot vagy a harcművészeteket - valósághű módon jeleníthessék meg. Amennyiben a rendszer megtanulta ezeket a mozgásokat, akkor képessé válik akár a spontán mozgássorok, például az esések szimulálására is.