Rónai György

nVIDIA: megint savanyú a szőlő?

Az nVIDIA egy olyan dokumentumot készített, amelyben nyíltan kritizálja a rivális ATI Technologies legújabb grafikus megoldását. A cég piaci fellépéséből eddig sem hiányoztak az ilyen dolgok, annak idején például a PowerVR KYRO-t húzták le ugyanígy a potenciális ügyfelek előtt.

A történelem tehát tényleg ismétli önmagát, ugyanis az említett nVIDIA dokumentum az ATI legújabb RADEON X800 termékeit állítja pellengérre. Az elsőként a 3DCenter.org weblap fórumában feltünt diafelvételek származását az nVidia PR szóvivője, Derek Perez a [H]ard|OCP weblap kérdésére megerősítette, és közölte, hogy a "20-30 oldalból" csak néhányat tettek közzé. Derek Perez nyilatkozata szerint nem érzi úgy hogy bocsánatot kellene kérnie értük, mivel azokat az amerikai marketingcsapat csak a partnerek meggyőzésére, az eladások növelésére készítette.

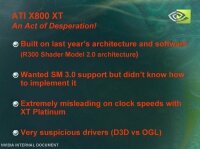

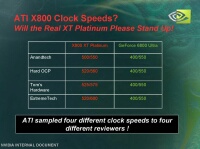

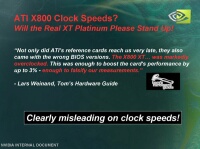

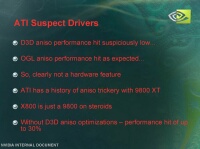

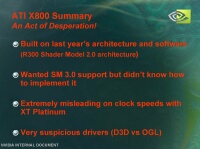

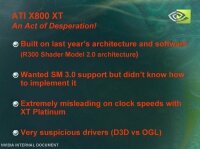

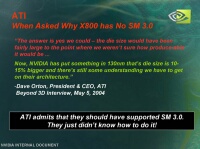

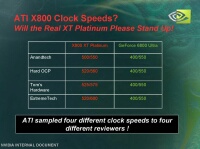

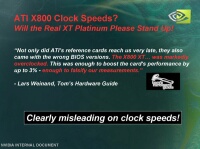

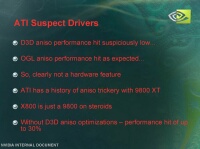

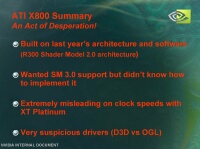

Az írásból kiderül, hogy az ATI meghajtóprogramjai "lehetséges csalásokat és tisztességtelen optimalizációkat" tartalmaznak, ráadásul a konkurens vállalat termékében azért nincs Shader Model 3.0 mert azt az ATI képtelen volt beépíteni. Az állítások közt szerepel továbbá az is, hogy a kanadai cég a kártya órajeleit illetően félrevezette az előzetes teszteket végző hardverteszt oldalakat. Persze az olvasó egyből sejtheti, hogy reklámszövegről van csak szó, mint ahogy annak idején 2001-ben a PowerVR KYRO-ját is hasonló indokokkal húzták le, hogy ne jelenthessen konkurenciát a GeForce2 MX, és GTS kártyáiknak. Akkor az nVIDIA szó szerint leírta, hogy "a PowerVR KYRO grafikus processzorral nem éri meg foglalkozni, mivel nem hatékony technológia".

Klikk a képekre a nagyobb változathoz

A KYRO annak idején 150 dolláros árával főleg a GeForce2 MX400-nak jelentett komoly konkurenciát, annak ellenére, hogy még nem volt benne például T&L egység. A hiány dacára a KYRO mégis több helyen túlteljesítette mind az nVIDIA GeForce2 GTS, mind az ATI RADEON DDR megoldását is, ezért folyamodott az nVIDIA ehhez a meglehetősen kétséges eljáráshoz. Ugyanígy 2003-ban az nVIDIA egy olyan dokumentumot hozott nyilvánosságra, elyben a Futuremark 3DMark03 benchmark programját kritizálja, miszerint az egyenlőtlen előnyökhöz juttatta a rivális ATI RADEON grafikus processzorait. Később a Futuremark - és számtalan hardveroldal - kinyomozta, hogy valójában az nVIDIA csalt, méghozzá a Detonator driverébe épített "alkalmazás-specifikus optimalizációkkal".

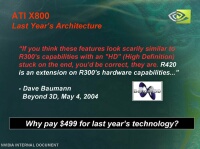

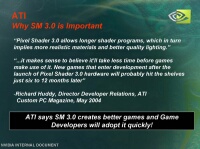

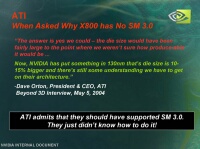

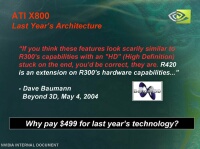

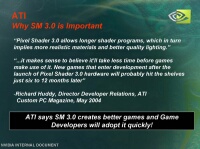

Úgy nűnik, hogy mivel az ATI új zászlóshajója, a RADEON X800 XT a legtöbb hardveroldal tesztje szerint túlteljesítette a GeForce 6800 Ultra kártyát, hirtelen újra savanyú lett a szőlő az nVidia számára, és ahelyett, hogy saját termékét fényezné, inkább a másikét húzza le a potenciális ügyfélkör előtt, ami meglehetősen kifogásolható eljárásmód a piacon. Persze az ATI R420-ban valóban nincs Shader Model 3.0 támogatás, azonban balgaság lenne azt gondolni, hogy az ATI ezt képtelen lenne implementálni chipjeibe, sokkal inkább azért áldozta be, mert még nincs valós piaci igény alkalmazására, és hogy a VPU megfelelő mennyiségben és minőségben gyártható legyen. A Pixel és Vertex Shader 3.0 megoldás támogatásának haszna legalább egy évig még nem lesz látható, mivel egyszerüen még nincs ezt alkalmazó szoftver. Megjelenéséig még sok víz lefolyik a Dunán, és a termékciklusokat elnézve addig még biztosan jön a piacra új termék tőlük is.

Klikk a képekre a nagyobb változathoz

A jelenlegi helyzetben az ATI álláspontja szerint tehát semmi értelme nem volt a SM3 integrálásának, főleg olyan áron, hogy egy NV40-hez hasonló, nehezen gyártható, nagy fogyasztású tranzisztor óriás legyen belőle. Ez ugyanis veszélyezteti a kártyák piaci megjelenésének időpontját, azok mennyiségét, és ráadásul a processzorok olcsóbb kártyákba való beépítését is jelentősen késleltette volna. Az ilyen jellegű dokumentumok és nyilatkozatok az nVIDIA részéről a szakvéleményt sokkal inkább csak arról győzik meg, hogy az nVIDIA-nak valóban fel kell kötnie a gatyáját, és tényleg van valami igazság az ATI álláspontjában. Persze ez a sárdobálás nem csak a grafikus processzorok gyártóira jellemző, hiszen például az AMD-nek és az Intelnek is voltak már hasonló körei...

A történelem tehát tényleg ismétli önmagát, ugyanis az említett nVIDIA dokumentum az ATI legújabb RADEON X800 termékeit állítja pellengérre. Az elsőként a 3DCenter.org weblap fórumában feltünt diafelvételek származását az nVidia PR szóvivője, Derek Perez a [H]ard|OCP weblap kérdésére megerősítette, és közölte, hogy a "20-30 oldalból" csak néhányat tettek közzé. Derek Perez nyilatkozata szerint nem érzi úgy hogy bocsánatot kellene kérnie értük, mivel azokat az amerikai marketingcsapat csak a partnerek meggyőzésére, az eladások növelésére készítette.

Az írásból kiderül, hogy az ATI meghajtóprogramjai "lehetséges csalásokat és tisztességtelen optimalizációkat" tartalmaznak, ráadásul a konkurens vállalat termékében azért nincs Shader Model 3.0 mert azt az ATI képtelen volt beépíteni. Az állítások közt szerepel továbbá az is, hogy a kanadai cég a kártya órajeleit illetően félrevezette az előzetes teszteket végző hardverteszt oldalakat. Persze az olvasó egyből sejtheti, hogy reklámszövegről van csak szó, mint ahogy annak idején 2001-ben a PowerVR KYRO-ját is hasonló indokokkal húzták le, hogy ne jelenthessen konkurenciát a GeForce2 MX, és GTS kártyáiknak. Akkor az nVIDIA szó szerint leírta, hogy "a PowerVR KYRO grafikus processzorral nem éri meg foglalkozni, mivel nem hatékony technológia".

Klikk a képekre a nagyobb változathoz

A KYRO annak idején 150 dolláros árával főleg a GeForce2 MX400-nak jelentett komoly konkurenciát, annak ellenére, hogy még nem volt benne például T&L egység. A hiány dacára a KYRO mégis több helyen túlteljesítette mind az nVIDIA GeForce2 GTS, mind az ATI RADEON DDR megoldását is, ezért folyamodott az nVIDIA ehhez a meglehetősen kétséges eljáráshoz. Ugyanígy 2003-ban az nVIDIA egy olyan dokumentumot hozott nyilvánosságra, elyben a Futuremark 3DMark03 benchmark programját kritizálja, miszerint az egyenlőtlen előnyökhöz juttatta a rivális ATI RADEON grafikus processzorait. Később a Futuremark - és számtalan hardveroldal - kinyomozta, hogy valójában az nVIDIA csalt, méghozzá a Detonator driverébe épített "alkalmazás-specifikus optimalizációkkal".

Úgy nűnik, hogy mivel az ATI új zászlóshajója, a RADEON X800 XT a legtöbb hardveroldal tesztje szerint túlteljesítette a GeForce 6800 Ultra kártyát, hirtelen újra savanyú lett a szőlő az nVidia számára, és ahelyett, hogy saját termékét fényezné, inkább a másikét húzza le a potenciális ügyfélkör előtt, ami meglehetősen kifogásolható eljárásmód a piacon. Persze az ATI R420-ban valóban nincs Shader Model 3.0 támogatás, azonban balgaság lenne azt gondolni, hogy az ATI ezt képtelen lenne implementálni chipjeibe, sokkal inkább azért áldozta be, mert még nincs valós piaci igény alkalmazására, és hogy a VPU megfelelő mennyiségben és minőségben gyártható legyen. A Pixel és Vertex Shader 3.0 megoldás támogatásának haszna legalább egy évig még nem lesz látható, mivel egyszerüen még nincs ezt alkalmazó szoftver. Megjelenéséig még sok víz lefolyik a Dunán, és a termékciklusokat elnézve addig még biztosan jön a piacra új termék tőlük is.

Klikk a képekre a nagyobb változathoz

A jelenlegi helyzetben az ATI álláspontja szerint tehát semmi értelme nem volt a SM3 integrálásának, főleg olyan áron, hogy egy NV40-hez hasonló, nehezen gyártható, nagy fogyasztású tranzisztor óriás legyen belőle. Ez ugyanis veszélyezteti a kártyák piaci megjelenésének időpontját, azok mennyiségét, és ráadásul a processzorok olcsóbb kártyákba való beépítését is jelentősen késleltette volna. Az ilyen jellegű dokumentumok és nyilatkozatok az nVIDIA részéről a szakvéleményt sokkal inkább csak arról győzik meg, hogy az nVIDIA-nak valóban fel kell kötnie a gatyáját, és tényleg van valami igazság az ATI álláspontjában. Persze ez a sárdobálás nem csak a grafikus processzorok gyártóira jellemző, hiszen például az AMD-nek és az Intelnek is voltak már hasonló körei...