SG.hu

Egy fotó alapján komplett videót gyárt a Meta új MI-rendszere

A Meta bejelentette a Movie Gen nevű új MI-modellcsomagot, amelyet videó, hang és kép létrehozására és manipulálására terveztek, beleértve egy személyről készült egyetlen fotóból valószerű videó létrehozását. A vállalat állítása szerint a modellek felülmúlják a többi videószintetizáló modell teljesítményét, és közelebb visznek minket ahhoz a jövőhöz, amikor bárki igény szerint bármilyen témáról teljes videót gyárthat.

A vállalatnak egyelőre nincsenek tervei arról, hogy mikor és hogyan fogja ezeket a képességeket a nyilvánosság elé tárni, de a Meta szerint a Movie Gen egy olyan eszköz, amely lehetővé teheti az emberek számára, hogy „fokozzák a bennük rejlő kreativitást”, nem pedig helyettesítik az emberi művészeket és animátorokat. A vállalat olyan jövőbeli alkalmazásokat képzel el, mint például egy egyszerű bemutató videó elkészítése és szerkesztése a közösségi médiaplatformok számára, vagy személyre szabott animált születésnapi üdvözletek generálása.

A Movie Gen a Meta korábbi videoszintézis terén végzett munkájára épül, a 2022-es Make-A-Scene videogenerátor és az Emu képszintetizáló modell örököse. A legújabb rendszer a szöveges útmutatásokat használva először képes egyedi, hangokkal ellátott videókat generálni, meglévő videókat szerkeszteni és változtatásokat beilleszteni, valamint emberekről készült képeket valósághű, személyre szabott videókká alakítani. A Meta közölte, hogy emberi preferencia tesztek során a Movie Gen kimenetei legyőzték az OpenAI Sora, a Runway Gen-3 és a kínai Kling videomodelljét.

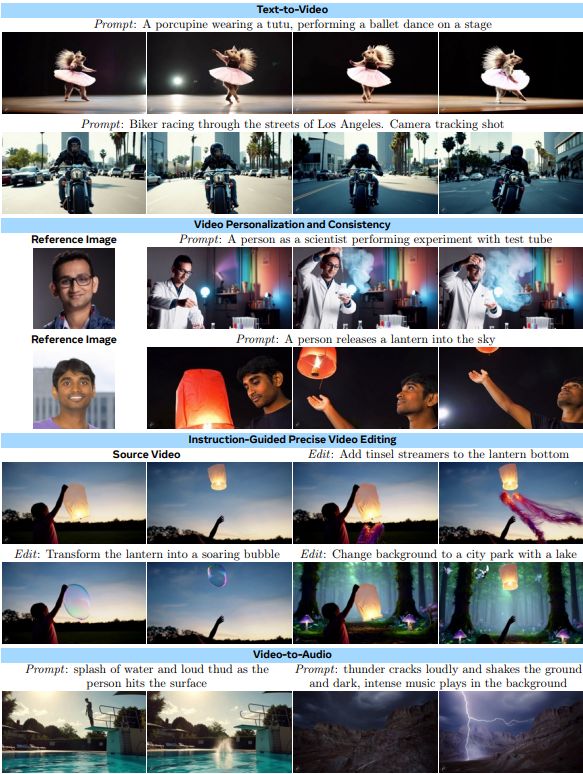

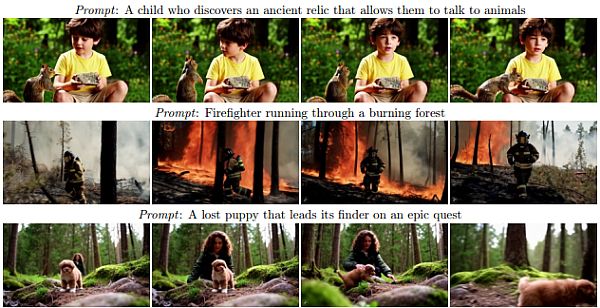

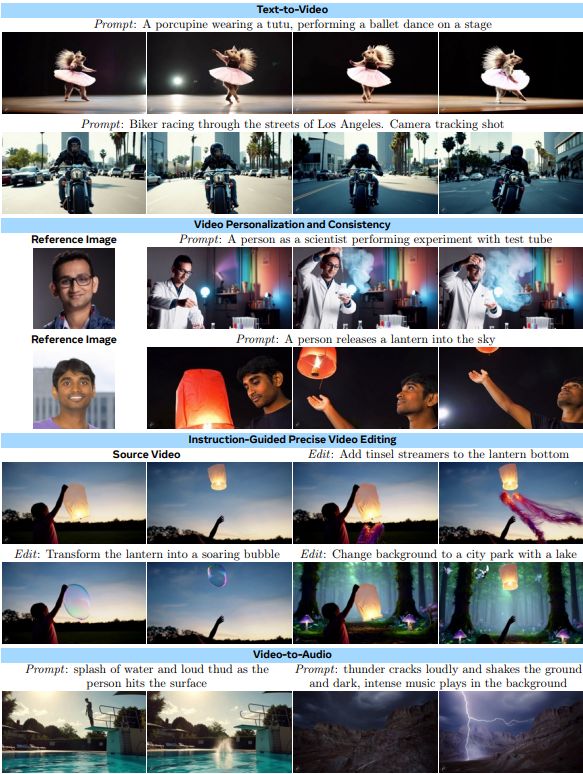

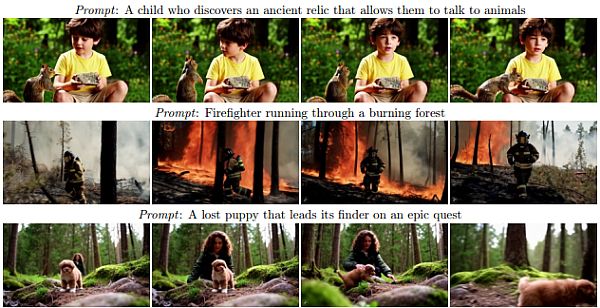

A Movie Gen videógeneráló modellje 1080p-s, nagyfelbontású, akár 16 másodperces videókat tud létrehozni 16 képkocka/másodperc sebességgel szöveges leírásból vagy képi bemenetből. A Meta állítása szerint a modell képes kezelni az olyan összetett fogalmakat, mint a tárgyak mozgása, a tárgy-tárgy interakciók és a kameramozgások. Ennek ellenére, ahogyan azt a korábbi mesterséges intelligencia-videógenerátorok esetében is láthattuk, a Movie Gen képessége, hogy egy adott témában összefüggő jeleneteket generáljon a Meta által a videószintetizáló modell betanításához használt példavideókban található fogalmaktól függ. Érdemes szem előtt tartani, hogy a videogenerátorok által kiválasztott eredmények gyakran drámaian eltérnek a tipikus eredményektől, és a koherens eredmény elérése sok próbálkozást igényelhet.

Ha már a képzési adatoknál tartunk, a Meta azt mondja, hogy ezeket a modelleket „licencelt és nyilvánosan elérhető adathalmazok” kombinációján képezte ki, ami nagy valószínűséggel magában foglalja a Facebook és Instagram felhasználók által az évek során feltöltött videókat, bár ez csak spekuláció a Meta jelenlegi irányelvei és korábbi viselkedése alapján.

A Meta a Movie Gen egyik legfontosabb funkcióját „személyre szabott videókészítésnek” nevezi, de van egy másik fontos fogalom is, amely 2017 óta létezik: a mélyhamisítás, azaz a deepfake. A technológia riadalmat keltett egyes szakértők körében, mivel a hiteles kamerafelvételek szimulálására használható, és olyan dolgokat mutathat, amelyek valójában nem történtek meg. Egy deepfake létrehozása a Movie Gen segítségével nagyon egyszerűnek tűnik, elég egyetlen bemeneti képet megadni egy személyről, egy szöveges felszólítással együtt, amely leírja, hogy mit szeretne, hogy csináljon, vagy hol legyen a kész videóban. A rendszer ezután létrehoz egy mozgóképet, amelyben az adott személy szerepel, miközben beépíti a kérés részleteit.

Ezzel a technológiával számtalan módon vissza lehet élni, például embereket kompromittáló hamis helyzetekbe lehet helyezni, hamis történelmi kontextust gyártani, vagy pornográf anyagokat készíteni. Ez közelebb visz minket egy olyan kulturális szingularitáshoz, ahol az igazság és a fikció a valós idejű mesterséges intelligencia-média szintézisnek köszönhetően mélyebb kontextus nélkül egymástól megkülönböztethetetlen. Áprilisban a Microsoft bemutatta a VASA-1 nevű modellt, amely egyetlen fénykép és egyetlen hangsáv alapján képes fotórealisztikus videót készíteni egy beszélő személyről, de a Movie Gen egy lépéssel továbbmegy: egy mélyhamisított személyt helyez el egy mesterséges intelligencia által generált vagy más módon létrehozott videojelenetbe. A Movie Gen azonban a jelek szerint még nem képes beszédet generálni vagy szinkronizálni.

A Meta bemutatta a Movie Gen videószerkesztő komponensét is, amely lehetővé teszi a meglévő videók pontos módosítását szöveges utasítások alapján. A program képes szerkesztésre, például elemek hozzáadására vagy eltávolítására, valamint globális módosításokra, például a háttér vagy az általános stílus megváltoztatására. A Meta a hangszintézist egy külön hanggeneráló modellel adja hozzá a kész anyagokhoz. Ez képes a videótartalomhoz szinkronizált környezeti hangokat, hangeffektusokat és instrumentális háttérzenét előállítani szöveges utasítások alapján. A vállalat állítása szerint ez a modell bármilyen hosszúságú videókhoz képes hangot generálni, végig fenntartva a koherens hangzást.

Az előrelépések ellenére a Meta elismeri, hogy a jelenlegi modelleknek vannak korlátai. A vállalat azt tervezi, hogy a modellek méretezésével felgyorsítja a videók előállításának idejét és javítja az általános minőséget. A Meta azt is tervezi, hogy együttműködik a filmkészítőkkel és alkotókkal, hogy visszajelzéseiket beépítse a modell jövőbeli verzióiba. A SAG-AFTRA színészszakszervezet tavalyi figyelmeztetései és a videószintézisre adott megosztó reakciók után azonban elképzelhető, hogy nem minden visszajelzés lesz pozitív.

A vállalatnak egyelőre nincsenek tervei arról, hogy mikor és hogyan fogja ezeket a képességeket a nyilvánosság elé tárni, de a Meta szerint a Movie Gen egy olyan eszköz, amely lehetővé teheti az emberek számára, hogy „fokozzák a bennük rejlő kreativitást”, nem pedig helyettesítik az emberi művészeket és animátorokat. A vállalat olyan jövőbeli alkalmazásokat képzel el, mint például egy egyszerű bemutató videó elkészítése és szerkesztése a közösségi médiaplatformok számára, vagy személyre szabott animált születésnapi üdvözletek generálása.

A Movie Gen a Meta korábbi videoszintézis terén végzett munkájára épül, a 2022-es Make-A-Scene videogenerátor és az Emu képszintetizáló modell örököse. A legújabb rendszer a szöveges útmutatásokat használva először képes egyedi, hangokkal ellátott videókat generálni, meglévő videókat szerkeszteni és változtatásokat beilleszteni, valamint emberekről készült képeket valósághű, személyre szabott videókká alakítani. A Meta közölte, hogy emberi preferencia tesztek során a Movie Gen kimenetei legyőzték az OpenAI Sora, a Runway Gen-3 és a kínai Kling videomodelljét.

A Movie Gen videógeneráló modellje 1080p-s, nagyfelbontású, akár 16 másodperces videókat tud létrehozni 16 képkocka/másodperc sebességgel szöveges leírásból vagy képi bemenetből. A Meta állítása szerint a modell képes kezelni az olyan összetett fogalmakat, mint a tárgyak mozgása, a tárgy-tárgy interakciók és a kameramozgások. Ennek ellenére, ahogyan azt a korábbi mesterséges intelligencia-videógenerátorok esetében is láthattuk, a Movie Gen képessége, hogy egy adott témában összefüggő jeleneteket generáljon a Meta által a videószintetizáló modell betanításához használt példavideókban található fogalmaktól függ. Érdemes szem előtt tartani, hogy a videogenerátorok által kiválasztott eredmények gyakran drámaian eltérnek a tipikus eredményektől, és a koherens eredmény elérése sok próbálkozást igényelhet.

Ha már a képzési adatoknál tartunk, a Meta azt mondja, hogy ezeket a modelleket „licencelt és nyilvánosan elérhető adathalmazok” kombinációján képezte ki, ami nagy valószínűséggel magában foglalja a Facebook és Instagram felhasználók által az évek során feltöltött videókat, bár ez csak spekuláció a Meta jelenlegi irányelvei és korábbi viselkedése alapján.

A Meta a Movie Gen egyik legfontosabb funkcióját „személyre szabott videókészítésnek” nevezi, de van egy másik fontos fogalom is, amely 2017 óta létezik: a mélyhamisítás, azaz a deepfake. A technológia riadalmat keltett egyes szakértők körében, mivel a hiteles kamerafelvételek szimulálására használható, és olyan dolgokat mutathat, amelyek valójában nem történtek meg. Egy deepfake létrehozása a Movie Gen segítségével nagyon egyszerűnek tűnik, elég egyetlen bemeneti képet megadni egy személyről, egy szöveges felszólítással együtt, amely leírja, hogy mit szeretne, hogy csináljon, vagy hol legyen a kész videóban. A rendszer ezután létrehoz egy mozgóképet, amelyben az adott személy szerepel, miközben beépíti a kérés részleteit.

Ezzel a technológiával számtalan módon vissza lehet élni, például embereket kompromittáló hamis helyzetekbe lehet helyezni, hamis történelmi kontextust gyártani, vagy pornográf anyagokat készíteni. Ez közelebb visz minket egy olyan kulturális szingularitáshoz, ahol az igazság és a fikció a valós idejű mesterséges intelligencia-média szintézisnek köszönhetően mélyebb kontextus nélkül egymástól megkülönböztethetetlen. Áprilisban a Microsoft bemutatta a VASA-1 nevű modellt, amely egyetlen fénykép és egyetlen hangsáv alapján képes fotórealisztikus videót készíteni egy beszélő személyről, de a Movie Gen egy lépéssel továbbmegy: egy mélyhamisított személyt helyez el egy mesterséges intelligencia által generált vagy más módon létrehozott videojelenetbe. A Movie Gen azonban a jelek szerint még nem képes beszédet generálni vagy szinkronizálni.

A Meta bemutatta a Movie Gen videószerkesztő komponensét is, amely lehetővé teszi a meglévő videók pontos módosítását szöveges utasítások alapján. A program képes szerkesztésre, például elemek hozzáadására vagy eltávolítására, valamint globális módosításokra, például a háttér vagy az általános stílus megváltoztatására. A Meta a hangszintézist egy külön hanggeneráló modellel adja hozzá a kész anyagokhoz. Ez képes a videótartalomhoz szinkronizált környezeti hangokat, hangeffektusokat és instrumentális háttérzenét előállítani szöveges utasítások alapján. A vállalat állítása szerint ez a modell bármilyen hosszúságú videókhoz képes hangot generálni, végig fenntartva a koherens hangzást.

Az előrelépések ellenére a Meta elismeri, hogy a jelenlegi modelleknek vannak korlátai. A vállalat azt tervezi, hogy a modellek méretezésével felgyorsítja a videók előállításának idejét és javítja az általános minőséget. A Meta azt is tervezi, hogy együttműködik a filmkészítőkkel és alkotókkal, hogy visszajelzéseiket beépítse a modell jövőbeli verzióiba. A SAG-AFTRA színészszakszervezet tavalyi figyelmeztetései és a videószintézisre adott megosztó reakciók után azonban elképzelhető, hogy nem minden visszajelzés lesz pozitív.