82

-

palm pilot #82 Elveri? FEle annyi pontszámmal? LOÁL!

-

Csaba42 #81 Van rá valami észérved is, vagy csak azt sérelmezed, hogy nem azok az eredmények jöttek ki, mint amiket elvártál volna? -

dez #80 Nem ennyi utasítást tartalmaztak, hanem ennyi volt a max. passonkénti kódhossz. A kihasználásnak a sebesség szabott határt. -

tomcsa4 #79 Mit nem tudok? Akkoriban semmi nem hazsnálta ki még a 160-at sem (ami ha jól emlékszem a Radeon 9xxx szériának volt). Az az 512 csomag meg Vektor, Skalár és Textúra. Ezt értettem alatta. DE igen az igaz, hogy pusztán ezekkel nem sokra mentek akkor. Ma sincs kihasználva ez ügyben semmi.

Az a 65535 meg az SM 3.0 vertexutasításaira értettem. Kép kirajzolásához először vertexutasítások kellenek, vagy rosszul tudom? -

dez #78 "GF 6os széria 65535 utasítást tartalmaz, míg a nyolcas széria tüöbbet (Radeon Xxxx meg 1536-ot, 512-512-512)."

Szerintem inkább ne emlegess olyan számokat, amikről nem tudod, micsoda. :D

Egy passban (itt: shaderkód-lefutásban) tudnak max. ilyen hoszzú shaderkódot végrehajtani. De egy 65536 szavas shaderkóddal ilyen 1fps jönne ki, szóval sok értelme itt nincs. A pass-ok indítása némi plusz időbe tellik, így jó, ha egy passba belefér minden, de nem dől össze a világ akkor sem, ha több kell. -

dez #77 Attól, hogy adatbáziskezelésben, és más effélében nem csúcstartó, általános célú matematikai számításokban nagyon tudja hozni a papírformát, szóval azok a FLOPS számok nem csak papíron igazak. Sőt, ilyen számítások esetén sokkal jobban, mint egy GPU. Mellesleg egy GPU még sokkal inkább elvérzik adatbáziskezelésben, szóval akkor miről is beszélünk? -

tomcsa4 #76 A netes teszteknek nem mindenki hisz, én például sohasem! Pláne, hogy nem tesztelik újra le őket, mikor driverekben igenis van fejlődés (és a support mindennél fontosabb). Igyekszem megnézni ezt azt, persze a csúcskategória (ha van még ilyen, 110k+) nem érdekelnek emiatt.

A 8500GT az nem mindenben gyorsabb, mint a 6600GT: ahol shaderalkalmazás van, ott mérhető többlet, máshol nem, de shadereknél sem sok. GF 6os széria 65535 utasítást tartalmaz, míg a nyolcas széria tüöbbet (Radeon Xxxx meg 1536-ot, 512-512-512).

Ha támogatja NV ha nem a DX 10.1et, MS úg seggbebassza, hog csak lesni fog. Ugyanis nem az NV diktál, hanem a Microsoft! És nem szabadidejükben a WC-n rakták össze a DX 10.1et, hogy holmi csicska NV itt buzizzon! Meglátjátok majd! -

krajcsovszkig #75 Amúgy vicces ez a cikk, boltokban már legalább egy hete lehet kapni ezt a kártyát, és tesztekből is van rendesen... Szeretem az sg gyors reagálásait... xD -

krajcsovszkig #74 "és mivel az ati 4.1 -es shadert használ , az ujabb játékokban az nvidia csak vergödni fog, mig az ati hasit

Amíg az nvidia nem építi be a 4.1-es dhadereket, addig a kutya nem fog olyan játékot írni, ami azt használja, ráadásul a 4.1 elég kis előrelépés, emiatt nem kell aggódni."

Ez nem egészen igaz, elvileg a Stalker Clear Sky is már DX10.1-SM4.1-es lesz... Az augusztus... (mondjuk ezt én sem értem, X-Ray engine elvileg nVidiás... :o)

Amúgy nagyon jó kis kártya lett, nvidia is lassan az észnélküli teljesítmény (és méret,ár,fogyasztás,hőtermelés) növelés után elkezdhetne értelmesen fejleszteni, mert ha ez így megy tovább és az emberek kezdenek rájönni, hogy jobban járnak egy gyengébb, de minden más szempontból jobb kártyával (ami itt már nem is olyan gyenge...), akkor a zöldek csúnyán besz.phatják...

Nekem már van (korábbi beszűkült nvidia-fan létemre) egy jókis HD3870-em, asse rossz, de most már sajnálom, hogy nem vártam ezt meg... :D

AMDnek már csak prociból kéne valami értékelhetőt kihoznia, és akkor vicces dolgok lehetnek itt... ;D

-

#73

#73

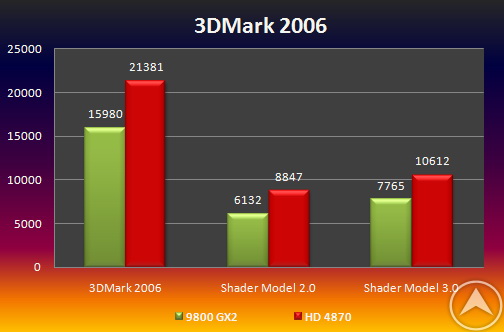

Áhh nem nagy szám, csak majdnem elveri az nvidia csúcskártyáját sokkal olcsóbban, optimalizálatlan driverekkel, nvidiára és dx9.5-re optimalizált játékokban... :D -

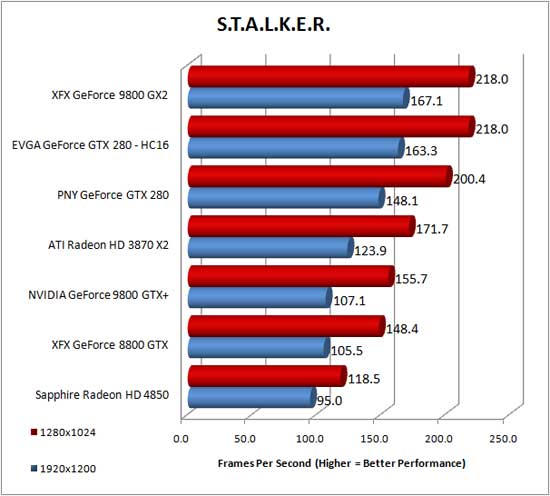

2504 #72 Ez a grafikon elég jó az Új ATI kártyához!!!!

Azt kell nézni az alapon hogy az ATI 4850-es kártya kb 40000 FT!!!!!

Az Nvidia 9800 GTX meg meg jó 70000!!! FT

De majd arra leszek kiváncsi , hogy milyen lesz majd a 4870 X2 az új NV-val szemben:D

Na majd akkor lesz csak pislogás szerintem:D -

#71

#71

"Egyként telibe tojom a teszteket :D" #58

"Ez egy qvára kamu teszt, szeretem amikor ilyeneket tesznek közzé.Majd, flesséknek hiszek." #51

Na akkor mégse kakilsz a tesztekre? :D -

palm pilot #70 Nem kell hasraesni az ATI előtt, nem olyan nagy szám ez a kártyájuk se:

-

palm pilot #69 Viszont a Cell is csak élméleti számokban mutat jól, általános teljesítményben egy Core2 Duo szanaszéjjel alázza, és akkor még nem is Quadról beszéltünk. -

palm pilot #68 Volt már ilyen, pl. Half Life. -

palm pilot #67 a ps3-nál 10-szer gyorsabb

Wow! Version, te elismered hogy a pc gyorsabb mint a konzol? Nem semmi. Pc-s lettél? :D -

palm pilot #66 Már így is a legjobbak. ^^ -

dez #65 Az adatbáziskezelést, szövegszerkesztést, és más ilyesmit nem neveznék számításoknak... De ha így jobban tetszik: általános matematikai számítási teljesítmény. (Így szoktam írni, de szerintem enélkül is egyértelmű, miről volt szó.) Értettem a megjegyzésedet, csak éppen félre ment. -

JoinR #64 Sok játék rendszerkövetelménye a 7-8-as szériás nVidia, és hiába gyakorlatban lehet van olyan jó egy 6600GT pl, nem fog elindulni. -

Yv@n #63 "Jó lenne, ha kicsit figyelmesebben olvasnál. Nem általános teljesítményről beszéltem, hanem általános (tehát nem raszterizációs 3D grafikai) számítási teljesítményről."

Őő egy kizárólag számításokra használható eszköznél, ha teljesítményről beszélünk, akkor nem igazán tudom, hogy számítási teljesítményen kívül mi másra lehet gondolni, szóval szerintem a figyelem rendben van.

Te viszont nem nagyon értetted meg, amivel én próbáltam viccelődni. :) -

#62

#62

Mert szopik!!!!!!!!MUHAHAHAHA

-

RecoPhile #61 http://www.legitreviews.com/article/731/10/

http://xtreview.com/addcomment-id-5603-view-radeon-hd-4850-benchmarks.html -

dez #60 Hát te tényleg kiborultál, te elborult AMD+ATI hater Intel+nVidia fan. :P

A többi tesztet egyelőre inkább mégse nézd meg, túl sok lesz az neked egyszerre.

Küldjek zsepit? :P -

Vers #59 -

who am I 7 #58 Miről beszélsz?Te meg, hozod a tipikus alázni való beszükült csicska stílusod (ahogy az amd híreknél mindig).Hallod, akkor inkább leszek faszparaszt, frankón.Köszi

Igaz a teszt?Te csináltad?Ott voltál?Nahát, MIKVANNAK, nem is tudtam, hogy TE CSINÁLTAD...Mondjuk, hogy így majd 2 év után, csinált egy olyan középkategóriás procit az ájemdéd, ami épphogy elveri, igazán elismerésre MÉLTÓ, már verheted a kis kukidat esténként a lógójukra (bár csúcskatban, le vannak maradva bőven

(bár csúcskatban, le vannak maradva bőven

)

)

Na, de ez csak fölösleges szájtépés :) Túl egyszerű vagy te, ahhoz, h vitázzak veled :) De elárulom, örülök, h csinált végre egy jó kártyát, az ati, de még mindig csak vergődés van :) Ezelőtti karim ati vót..és?Egyként telibe tojom a teszteket :D Te vered azt a kis kukidat ezekre az adatokra..meghogy, MÁR PEDIG IGAZ AZ A TESZT

Faszom, huzz vissza az oviba dez, és próbálj meg kicsit "okosodni" :) Egyként, 1 év múlva veszek kb új vidkareszt(az aktuális jobbat,nincs márka kikötve), mert tökéletesen elégedett vagyok a GTmmel, és most ez a legkevesebb az életembe :D

Faszom, huzz vissza az oviba dez, és próbálj meg kicsit "okosodni" :) Egyként, 1 év múlva veszek kb új vidkareszt(az aktuális jobbat,nincs márka kikötve), mert tökéletesen elégedett vagyok a GTmmel, és most ez a legkevesebb az életembe :D

-

Vers #57 nem kell ez a személyeskedés srácok

az ati jo kártyát csinált , ár/teljesitményben/fogyasztásban a legjobb

az nvidiáé a leggyorsabb legnagyobb , legdrágább gpu , ez is pozitivum végülis ha sok pénze van az embernek

a cell meg jol elvan a ps3-ban 10%-os kihasználtsággal , majd az idö eldönti hogy lesz e belöle valami , szerintem nem, vagy késön..

-

dez #56 Arról már nem is beszélek, hogy csak a lémerségedet bizonyítod azzal, hogy hülyeségnek nyilvánítasz ilyen alap dolgokat. -

dez #55 Látom, újra hozod a faszparaszt stílusod, pedig már egész jól szocializálódtál. De úgy tűnik, valami most nagyon kiborított. De szerintem nem én, hanem nyilván kedvenc nVidiádon jól elveri a port az ATI/AMD. Sajnos az a teszt nem kamu, megnézheted a többit is, ha idegileg bírod. Hogy most emiatt velem állsz le kötekedni (éppen hogy hátulról, mert elölről semmi belekötnivalód nincs, teljesen egyértemű minden, amit írtam), azzal magadat járatod le. Nem baj, majd rájösz, ha lehiggadsz. :P -

who am I 7 #54 "Nem általános teljesítményről beszéltem, hanem általános (tehát nem raszterizációs 3D grafikai) számítási teljesítményről"

Mi meg a te hülye körbemagyarázkodós hátulról induló idióta szövegedet.A legjobb, hogy TAPASZTALAT nélkül osztod a hülyeséget, és még okosnak is hiszed magad.Leülhetsz. -

dez #53 Milyen magyarázkodás, te oktondi? Eddig is számítási teljesítményről beszéltem. És mit szoktunk meg? Ja, a te idétlen beszólásaidat. -

Vers #52 nem hasonlo mert akkor a 800 shader nem fért volna rá, és már ring busz sincsen

azut nemtom mi van , ne is kérdezd, mivel csak jövöhéten nyit az nda

-

who am I 7 #51 Ez egy qvára kamu teszt, szeretem amikor ilyeneket tesznek közzé.Majd, flesséknek hiszek. -

who am I 7 #50 Látom megy a magyarázkodás, nem baj dez megszoktok

-

dez #49 Ha hasonló a felépítése, mint az R6xx-nak (márpedig ez bizonyos), akkor kb. 1/5-ére. De nem csak ez a szűk keresztmetszet egy GPU-ban általános számításoknál.

Nos, az, hogy neked nem sikerült (ha egyátalán próbáltad, nem csak dumáltál), attól még másnak sikerülhet, és sikerül is. -

dez #48 Jó lenne, ha kicsit figyelmesebben olvasnál. Nem általános teljesítményről beszéltem, hanem általános (tehát nem raszterizációs 3D grafikai) számítási teljesítményről. A Cell FLOPS-ai ebben nagyon is jól kihasználhatók, ellenben egy GPU elméleti teljesítménye a töredékére esik vissza itt. (Pl. egy feltételes ugrás több másik egység működését is felfüggeszti, és sok egyéb ilyesmi.) -

Vers #47 erre még nem tudok konkrétan válaszolni , ugyanis hétfön jön meg a kártyám , és akkor derül ki hogy viselkedik dinamikus flow kontrollnál

ha az ati ügyes volt, akkor szarrá alázza a celt, ha nem akkor csak kicsit

egyébként a cellel az a baj hogy még senki se használta ki rendesen, lehet nem is fogják

-

Yv@n #46 Csak én érzek némi iróniát itt?

Amíg a ps3 a holdban volt, és a pc volt a hasonlítási alap, addig az általános számítások nem számítottak, hisz a ps3 célfeladatokra való, és gyönyörűen takarózott mindenki a nyers flops értékekkel. Most hogy itt egy gpu brutális flops értékekkel, hirtelen baromira fontossá váltak az általános számítások? :) -

dez #45 "2 ilyen 1600 shadert tartalmaz 2 terraflopsal, a ps3-nál 10-szer gyorsabb .."

Ez így nagyon nem igaz. Ezek elméleti számok. Pixelshadingnál megközelíthető az elméleti max. a GPU-knál, általános számításoknál azonban semmit sem jelent ez a szám, mert csak a töredéke hozható ki itt. A gyakorlatban, általános számításoknál pl. 5x gyorsabb a Cell, mint egy G80, pedig utóbbinak 2,5x nagyobb a FLOPS értéke...

-

Yv@n #44 "Amíg az nvidia nem építi be a 4.1-es dhadereket, addig a kutya nem fog olyan játékot írni, ami azt használja, ráadásul a 4.1 elég kis előrelépés, emiatt nem kell aggódni."

Assassins Creed-ben benne volt. 1.1es peccsel nvidia nyomására ki is vették belőle, mert ati kártyák szarrá büntették az nv-ket. Node ugye nv-nek 2millió dolláros szerződése van ubisofttal, úgyhogy szépen lezsírozták egymás közt...

"Most jött ki talán a múlt héten az új csúcsgeneráció, idén már sok újat nem látunk, elgfeljebb kisebb csíkszélességet."

Ezt nem nevezném új generációnak...technológiailag nem nyújt semmi többletet az elődhöz képest, egyszerűen valamivel erősebb. Új generációról majd inkább akkor beszélhetünk, ha bekerül az nv kártyákba a full dx10.1 support.

Egyébként figyeljétek meg: amint nv előugrik egy full dx 10.1-es megoldással, egyből a világ legfontosabb dolga lesz a dx10.1, és a teljes nv marketing gépezet fossa majd magából, hogy az mennyire szükséges :) -

erdeipeter #43 "meg már sok játék nem támogatja a 6-os szériát,"

ezt magyarázd már meg, kérlek :)