SG.hu

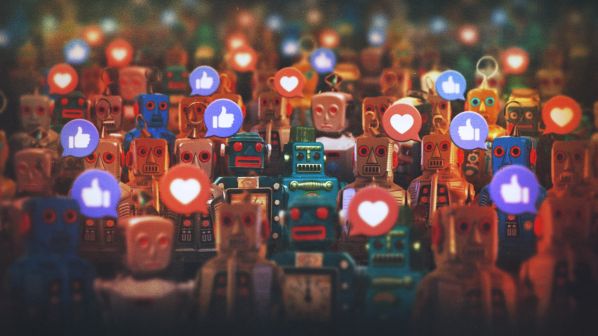

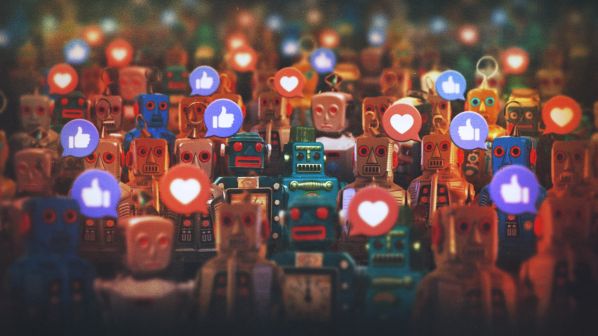

Egyre nagyobb teret nyer a "halott internet” elmélet

A mesterségesen generált tartalmak térhódításával véget érhet az emberi internet korszaka. Az OpenAI vezetője attól tart, hogy az automatikus programok által létrehozott hálózat megkönnyíti a manipulációt és a dezinformációt.

A halott internet elmélet lényegében azt állítja, hogy az interneten, beleértve a közösségi média fiókokat is, a tevékenységeket és a tartalmakat túlnyomórészt mesterséges intelligencia ügynökök hozzák létre és automatizálják. Ezek az ügynökök gyorsan létrehozhatnak bejegyzéseket és mesterséges intelligencia által generált képeket, amelyek célja a Facebook, Instagram és TikTok platformokon való interakciók (kattintások, lájkolások, kommentek) generálása. Az egyik legkifinomultabb mesterséges intelligenciát kifejlesztő vállalat vezetője is kezd hinni az elméletben, mely miatt megsokszorozódnak a manipuláció, a dezinformáció és a szándékos viselkedéskondicionálás veszélyei. Sam Altman, az OpenAI vezérigazgatója rövid üzenete aggodalmat keltő: "Soha nem vettem komolyan a halott internet elméletét, de úgy tűnik, hogy most már sok Twitter-fiókot LLM-ek, azaz mesterséges intelligencia nyelvi modellek kezelnek”.

Aaron Harris, egy MI-alkalmazásokra szakosodott multinacionális vállalat, a Sage globális technológiai igazgatója (CTO) óvatos a jelenség elnevezésével kapcsolatban, bár nem tagadja a folyamatot: „Nem tudom, hogy halott internetnek nevezném-e, de kétségtelen a folyamat. Az automatizált tartalmak és a botok (emberi viselkedést utánozó számítógépes programok) által vezérelt interakciók térnyerése miatt egyre nehezebb megkülönböztetni a valódit a zajtól. A kérdés az, hogy hagyjuk-e, hogy ez a zaj elborítson minket, vagy inkább olyan technológia kifejlesztésére koncentrálunk, amely helyreállítja a bizalmat. Az a fontos, hogy hogyan szűrjük, ellenőrizzük és jelenítsük meg azokat az információkat, amelyekben az emberek megbízhatnak.”

Altman konkrét utalása a közösségi médiára nem véletlen. „Ez rendkívül fontos, mivel a közösségi média ma már a világ számos felhasználójának fő információforrása” - írja Jake Renzella, a New South Wales-i Egyetem (UNSW Sydney) számítástechnika tanszék vezetője és Vlada Rozova gépi tanulás kutató egy cikkben. "Ahogy ezek az MI-vezérelt fiókok egyre több követőt szereznek (sok közülük hamis, néhány valódi), a nagy számok legitimálják a fiókokat a valódi felhasználók számára. Ez azt jelenti, hogy egy fiókokból álló hadsereg jön létre. Már vannak szilárd bizonyítékok arra, hogy a közösségi médiát ezek a botok manipulálják, hogy dezinformációval befolyásolják a közvéleményt, és ez már évek óta így van” - hangsúlyozzák összhangban Altman figyelmeztetésével az ausztrál kutatók.

Az Imperva biztonsági cég két évvel ezelőtt publikált tanulmánya már akkor is úgy becsülte, hogy „az internetes forgalom csaknem fele botok által generált”. Ezek a botok nem csak egyedi tartalmakat képesek létrehozni, hanem utánozni is tudják a formulát, hogy azok tömegesen és vírusként terjedjenek. A Physical Review Letters folyóiratban megjelent, a Vermonti Egyetem és a Santa Fe Intézet kutatói által vezetett új tanulmány szerint „bármi, ami terjed, legyen az egy hit, egy vicc vagy egy vírus, valós időben fejlődik és terjedésével egyre nagyobb erőt nyer”, követve a „önmegerősítő kaszkádok” matematikai modelljét.

E kutatás szerint az, ami terjed, az mutálódik, és ez a változás segít virális terjedésében, hasonlóan a nagy erdőtüzekhez, amelyeket hagyományos eszközökkel lehetetlen eloltani. "Részben az erdőtüzek ihlettek minket: erősebbé válhatnak, amikor sűrű erdőket puszítanak el, és gyengébbé, amikor nyílt területeken haladnak át. Ugyanez az elv vonatkozik az információkra, a viccekre vagy a betegségekre is. A körülményektől függően erősödhetnek vagy gyengülhetnek” - magyarázza Sid Redner, fizikus, a Santa Fe Intézet professzora és a cikk társszerzője. Juniper Lovato, a tanulmány társszerzője, informatikus tudós úgy véli, hogy a munka segít jobban megérteni, hogyan alakulnak ki a meggyőződések, a dezinformáció és a társadalmi fertőzés. „Ez elméleti alapot ad ahhoz, hogy feltárjuk, hogyan alakulnak ki és terjednek a narratívák a hálózatokon keresztül” - mondja.

A kutatók figyelmeztetnek, hogy a manipulációt vagy a dezinformációt támogató tartalmak vírusként való terjedésének kockázata a mesterséges intelligencia eszközeinek megjelenésével megsokszorozódott, és a felhasználóktól nagyobb tudatosságot igényel az MI-asszisztensek és -ügynökök veszélyeiről. Mert ezek az újszerű MI-eszközök nemcsak azt tudják, hogyan kell elkészíteni egy tartalmat és azt virálissá tenni, hanem azt is, hogyan lehet személyessé tenni és hatékonyan befolyásolni a felhasználók interakcióiból gyűjtött információkkal.

A „Nagy segítség vagy nagy testvér? Nyomon követési audit, profilalkotás és személyre szabás generatív mesterséges intelligencia asszisztensekben” című, a Seattle-ben megrendezett USENIX biztonsági szimpóziumon bemutatott tanulmány a felhasználók befolyásolhatóságának sebezhetőségét elemzi. "A közösségi médiában való befolyásolhatóság nem csak attól függ, hogy ki vagy, hanem attól is, hogy hol vagy a hálózatban és kivel vagy kapcsolatban” - magyarázza Luca Luceri, a Dél-Kaliforniai Egyetem kutatója és a tanulmány társszerzője. Ebben az értelemben a kutatás egy olyan jelenséget tükröz, amelyet „a befolyásolhatóság paradoxonának” neveznek, és amely „olyan mintát jelent, amely szerint a felhasználók barátai átlagosan befolyásolhatóbbak, mint maguk a fiókok tulajdonosai”. A tanulmány szerint ez a viselkedés „megmagyarázhatja, hogyan válnak népszerűvé egyes viselkedésformák, trendek és ötletek, és miért sebezhetőbbek az internet egyes területei a befolyásolásra, mint mások”.

Azok, akik azért posztolnak, mert mások is azt teszik, gyakran hasonló viselkedésű, szoros körökhöz tartoznak, és a tanulmány szerint ez arra utal, hogy „a társadalmi befolyás nem csak az egyének közötti közvetlen cseréken keresztül működik, hanem a hálózat szerkezete is alakítja és korlátozza”. Így előre lehet jelezni, hogy ki hajlamosabb tartalmakat megosztani, ami az MI által gyűjtött személyes adatok alapján automatikus vírusos terjedéshez vezethet. "Sok esetben elegendő tudni, hogy egy felhasználó barátai hogyan viselkednek, hogy megbecsüljük, hogyan viselkedne a felhasználó” - figyelmeztet a tanulmány.

A mesterséges intelligencia emberi kézzel létrehozott, de egyre inkább domináns internetre gyakorolt hatásának megoldása nem csupán szabályozási kérdés. A Google Deepmind több mint húsz kutató és egyetem részvételével készített komplex és átfogó tanulmánya, Az MI fejlett asszisztenseinek etikai kérdései szerint a kihívás az MI-asszisztens, a felhasználó, a fejlesztő és a társadalom közötti négyoldalú kapcsolatban rejlik, amelynek célja „olyan értékek vagy utasítások kidolgozása, amelyek biztonságosan működnek a világban, és széles körben előnyös eredményeket hoznak”.

A kutatók munkája Asimov robotikai törvényeihez hasonlóan egy sor parancsot dolgoz ki annak elkerülésére, hogy az MI eltérjen a morális elvektől, amelyek így foglalhatók össze: nem manipulálja a felhasználót az MI (fejlesztői) érdekeinek előmozdítása vagy társadalmi költségek (például dezinformáció) generálása érdekében, nem engedi, hogy a felhasználó vagy a fejlesztők a társadalomra nézve negatív stratégiákat alkalmazzanak (uralom, kondicionálás vagy intézményi hiteltelenítés), és nem korlátozza indokolatlanul a felhasználó szabadságát.

Aaron Harris, a Sega technológiai igazgatója szerint lehetséges egy etikus internet, „de ez nem fog csak úgy megtörténni” - pontosítja. „Az átláthatóságnak és a felelősségnek kell meghatároznia, hogyan tervezik és szabályozzák az MI-t. Az MI-t fejlesztő vállalatoknak biztosítaniuk kell, hogy eredményeik ellenőrizhetők és magyarázhatók legyenek, hogy az emberek megértsék, honnan származik az információ és miért ajánlják azt. A pénzügyekben például a pontosság nem opcionális, és a hibáknak valós következményei vannak. Ugyanez az elv vonatkozik az internetre is: a felelősségteljes képzés, az egyértelmű címkézés és az eredmények megkérdőjelezésének lehetősége hozzájárulhat ahhoz, hogy az MI egy etikusabb és megbízhatóbb internet részévé váljon”.

Harris a „humánus internet” megtartását támogatja, „különösen most, hogy egyre több tartalom botok által készül”, de nem az elért eredmények feladásának árán. „Nem hiszem, hogy a megoldás az lenne, hogy visszatérjünk a mesterséges intelligencia előtti világba, és megpróbáljuk korlátozni vagy teljesen eltávolítani az általa generált tartalmakat. Már része életünknek és munkánknak, és felelősségteljes használatával valódi értéket teremthet. A kérdés az, hogy ki vállal felelősséget a tartalomért. Ez az elv, amelyet minden vállalatnak követnie kell: az MI-nak az emberi képességeket javítania kell, nem pedig helyettesítenie. Egy humánusabb internet még mindig lehetséges, de csak akkor, ha az emberek szükségleteit tartjuk szem előtt, és a felelősség terén nem alkuszunk meg.”

A halott internet elmélet lényegében azt állítja, hogy az interneten, beleértve a közösségi média fiókokat is, a tevékenységeket és a tartalmakat túlnyomórészt mesterséges intelligencia ügynökök hozzák létre és automatizálják. Ezek az ügynökök gyorsan létrehozhatnak bejegyzéseket és mesterséges intelligencia által generált képeket, amelyek célja a Facebook, Instagram és TikTok platformokon való interakciók (kattintások, lájkolások, kommentek) generálása. Az egyik legkifinomultabb mesterséges intelligenciát kifejlesztő vállalat vezetője is kezd hinni az elméletben, mely miatt megsokszorozódnak a manipuláció, a dezinformáció és a szándékos viselkedéskondicionálás veszélyei. Sam Altman, az OpenAI vezérigazgatója rövid üzenete aggodalmat keltő: "Soha nem vettem komolyan a halott internet elméletét, de úgy tűnik, hogy most már sok Twitter-fiókot LLM-ek, azaz mesterséges intelligencia nyelvi modellek kezelnek”.

i never took the dead internet theory that seriously but it seems like there are really a lot of LLM-run twitter accounts now

— Sam Altman (@sama) September 3, 2025

Aaron Harris, egy MI-alkalmazásokra szakosodott multinacionális vállalat, a Sage globális technológiai igazgatója (CTO) óvatos a jelenség elnevezésével kapcsolatban, bár nem tagadja a folyamatot: „Nem tudom, hogy halott internetnek nevezném-e, de kétségtelen a folyamat. Az automatizált tartalmak és a botok (emberi viselkedést utánozó számítógépes programok) által vezérelt interakciók térnyerése miatt egyre nehezebb megkülönböztetni a valódit a zajtól. A kérdés az, hogy hagyjuk-e, hogy ez a zaj elborítson minket, vagy inkább olyan technológia kifejlesztésére koncentrálunk, amely helyreállítja a bizalmat. Az a fontos, hogy hogyan szűrjük, ellenőrizzük és jelenítsük meg azokat az információkat, amelyekben az emberek megbízhatnak.”

Altman konkrét utalása a közösségi médiára nem véletlen. „Ez rendkívül fontos, mivel a közösségi média ma már a világ számos felhasználójának fő információforrása” - írja Jake Renzella, a New South Wales-i Egyetem (UNSW Sydney) számítástechnika tanszék vezetője és Vlada Rozova gépi tanulás kutató egy cikkben. "Ahogy ezek az MI-vezérelt fiókok egyre több követőt szereznek (sok közülük hamis, néhány valódi), a nagy számok legitimálják a fiókokat a valódi felhasználók számára. Ez azt jelenti, hogy egy fiókokból álló hadsereg jön létre. Már vannak szilárd bizonyítékok arra, hogy a közösségi médiát ezek a botok manipulálják, hogy dezinformációval befolyásolják a közvéleményt, és ez már évek óta így van” - hangsúlyozzák összhangban Altman figyelmeztetésével az ausztrál kutatók.

Az Imperva biztonsági cég két évvel ezelőtt publikált tanulmánya már akkor is úgy becsülte, hogy „az internetes forgalom csaknem fele botok által generált”. Ezek a botok nem csak egyedi tartalmakat képesek létrehozni, hanem utánozni is tudják a formulát, hogy azok tömegesen és vírusként terjedjenek. A Physical Review Letters folyóiratban megjelent, a Vermonti Egyetem és a Santa Fe Intézet kutatói által vezetett új tanulmány szerint „bármi, ami terjed, legyen az egy hit, egy vicc vagy egy vírus, valós időben fejlődik és terjedésével egyre nagyobb erőt nyer”, követve a „önmegerősítő kaszkádok” matematikai modelljét.

E kutatás szerint az, ami terjed, az mutálódik, és ez a változás segít virális terjedésében, hasonlóan a nagy erdőtüzekhez, amelyeket hagyományos eszközökkel lehetetlen eloltani. "Részben az erdőtüzek ihlettek minket: erősebbé válhatnak, amikor sűrű erdőket puszítanak el, és gyengébbé, amikor nyílt területeken haladnak át. Ugyanez az elv vonatkozik az információkra, a viccekre vagy a betegségekre is. A körülményektől függően erősödhetnek vagy gyengülhetnek” - magyarázza Sid Redner, fizikus, a Santa Fe Intézet professzora és a cikk társszerzője. Juniper Lovato, a tanulmány társszerzője, informatikus tudós úgy véli, hogy a munka segít jobban megérteni, hogyan alakulnak ki a meggyőződések, a dezinformáció és a társadalmi fertőzés. „Ez elméleti alapot ad ahhoz, hogy feltárjuk, hogyan alakulnak ki és terjednek a narratívák a hálózatokon keresztül” - mondja.

A kutatók figyelmeztetnek, hogy a manipulációt vagy a dezinformációt támogató tartalmak vírusként való terjedésének kockázata a mesterséges intelligencia eszközeinek megjelenésével megsokszorozódott, és a felhasználóktól nagyobb tudatosságot igényel az MI-asszisztensek és -ügynökök veszélyeiről. Mert ezek az újszerű MI-eszközök nemcsak azt tudják, hogyan kell elkészíteni egy tartalmat és azt virálissá tenni, hanem azt is, hogyan lehet személyessé tenni és hatékonyan befolyásolni a felhasználók interakcióiból gyűjtött információkkal.

A „Nagy segítség vagy nagy testvér? Nyomon követési audit, profilalkotás és személyre szabás generatív mesterséges intelligencia asszisztensekben” című, a Seattle-ben megrendezett USENIX biztonsági szimpóziumon bemutatott tanulmány a felhasználók befolyásolhatóságának sebezhetőségét elemzi. "A közösségi médiában való befolyásolhatóság nem csak attól függ, hogy ki vagy, hanem attól is, hogy hol vagy a hálózatban és kivel vagy kapcsolatban” - magyarázza Luca Luceri, a Dél-Kaliforniai Egyetem kutatója és a tanulmány társszerzője. Ebben az értelemben a kutatás egy olyan jelenséget tükröz, amelyet „a befolyásolhatóság paradoxonának” neveznek, és amely „olyan mintát jelent, amely szerint a felhasználók barátai átlagosan befolyásolhatóbbak, mint maguk a fiókok tulajdonosai”. A tanulmány szerint ez a viselkedés „megmagyarázhatja, hogyan válnak népszerűvé egyes viselkedésformák, trendek és ötletek, és miért sebezhetőbbek az internet egyes területei a befolyásolásra, mint mások”.

Azok, akik azért posztolnak, mert mások is azt teszik, gyakran hasonló viselkedésű, szoros körökhöz tartoznak, és a tanulmány szerint ez arra utal, hogy „a társadalmi befolyás nem csak az egyének közötti közvetlen cseréken keresztül működik, hanem a hálózat szerkezete is alakítja és korlátozza”. Így előre lehet jelezni, hogy ki hajlamosabb tartalmakat megosztani, ami az MI által gyűjtött személyes adatok alapján automatikus vírusos terjedéshez vezethet. "Sok esetben elegendő tudni, hogy egy felhasználó barátai hogyan viselkednek, hogy megbecsüljük, hogyan viselkedne a felhasználó” - figyelmeztet a tanulmány.

A mesterséges intelligencia emberi kézzel létrehozott, de egyre inkább domináns internetre gyakorolt hatásának megoldása nem csupán szabályozási kérdés. A Google Deepmind több mint húsz kutató és egyetem részvételével készített komplex és átfogó tanulmánya, Az MI fejlett asszisztenseinek etikai kérdései szerint a kihívás az MI-asszisztens, a felhasználó, a fejlesztő és a társadalom közötti négyoldalú kapcsolatban rejlik, amelynek célja „olyan értékek vagy utasítások kidolgozása, amelyek biztonságosan működnek a világban, és széles körben előnyös eredményeket hoznak”.

A kutatók munkája Asimov robotikai törvényeihez hasonlóan egy sor parancsot dolgoz ki annak elkerülésére, hogy az MI eltérjen a morális elvektől, amelyek így foglalhatók össze: nem manipulálja a felhasználót az MI (fejlesztői) érdekeinek előmozdítása vagy társadalmi költségek (például dezinformáció) generálása érdekében, nem engedi, hogy a felhasználó vagy a fejlesztők a társadalomra nézve negatív stratégiákat alkalmazzanak (uralom, kondicionálás vagy intézményi hiteltelenítés), és nem korlátozza indokolatlanul a felhasználó szabadságát.

Aaron Harris, a Sega technológiai igazgatója szerint lehetséges egy etikus internet, „de ez nem fog csak úgy megtörténni” - pontosítja. „Az átláthatóságnak és a felelősségnek kell meghatároznia, hogyan tervezik és szabályozzák az MI-t. Az MI-t fejlesztő vállalatoknak biztosítaniuk kell, hogy eredményeik ellenőrizhetők és magyarázhatók legyenek, hogy az emberek megértsék, honnan származik az információ és miért ajánlják azt. A pénzügyekben például a pontosság nem opcionális, és a hibáknak valós következményei vannak. Ugyanez az elv vonatkozik az internetre is: a felelősségteljes képzés, az egyértelmű címkézés és az eredmények megkérdőjelezésének lehetősége hozzájárulhat ahhoz, hogy az MI egy etikusabb és megbízhatóbb internet részévé váljon”.

Harris a „humánus internet” megtartását támogatja, „különösen most, hogy egyre több tartalom botok által készül”, de nem az elért eredmények feladásának árán. „Nem hiszem, hogy a megoldás az lenne, hogy visszatérjünk a mesterséges intelligencia előtti világba, és megpróbáljuk korlátozni vagy teljesen eltávolítani az általa generált tartalmakat. Már része életünknek és munkánknak, és felelősségteljes használatával valódi értéket teremthet. A kérdés az, hogy ki vállal felelősséget a tartalomért. Ez az elv, amelyet minden vállalatnak követnie kell: az MI-nak az emberi képességeket javítania kell, nem pedig helyettesítenie. Egy humánusabb internet még mindig lehetséges, de csak akkor, ha az emberek szükségleteit tartjuk szem előtt, és a felelősség terén nem alkuszunk meg.”