SG.hu

A mesterséges intelligencia hallucinációja nem biztos, hogy javítható

Ismert tény, hogy a ChatGPT "hallucinál", és egyes kutatók aggódnak, hogy ez nem javítható, mert ha nem hallucinálna, nem tudna verset írni. Ez azt jelenti, hogy emberek milliói használnak egy olyan rendszert, mely hamis válaszokat talál ki egyszerű kérdésekre.

Kutatók megkérdezték az OpenAI chatbotjának két változatát, hogy hol született Tomás Lozano-Pérez, a Massachusetts Institute of Technology professzora. Az egyik bot azt mondta, hogy Spanyolország, a másik pedig Kubát nevezte meg. Ezután egy algoritmus felszólította a botokat, hogy vitassák meg a válaszokat, az, amelyik Spanyolországot mondott, gyorsan bocsánatot kért, és egyetértett azzal, amelyik a helyes választ adta, vagyis Kubával. Az MIT kutatócsoportja által múlt héten kiadott tanulmányban szereplő ötlet potenciális áttörést hozhat abban, hogy a chatbotok a helyes választ adják meg. A kutatók javaslata szerint tehát több chatbotot kell használni, azoktól ugyanarra a kérdésre kell választ kérni, majd hagyni, hogy azok addig vitatkozzanak egymással, amíg az egyik válasz győzedelmeskedik. A kutatók úgy találták, hogy egy ilyen "társadalmi elme" tényszerűbb eredményt nyújt.

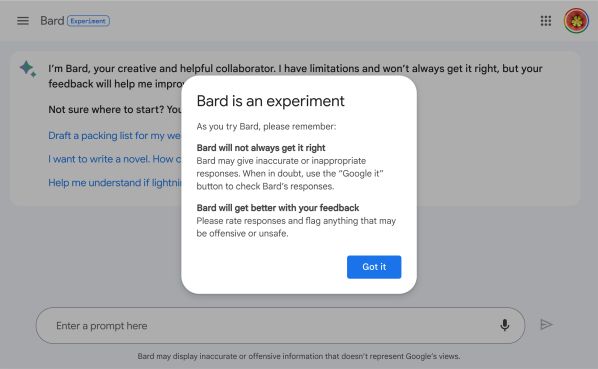

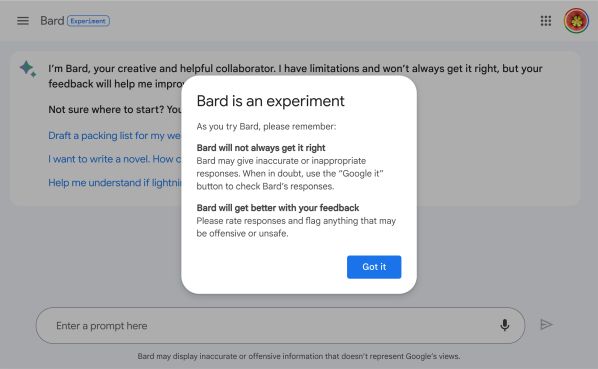

"A nyelvi modelleket arra képezték ki, hogy megjósolják a következő szót" - mondta Yilun Du, az MIT kutatója, a tanulmány egyik szerzője, aki nem mellesleg korábban az OpenAI kutatója volt. "Nem úgy találták ki őket, hogy azt mondják az embereknek, hogy nem tudják a választ." Az eredmény egy olyan robot, amely gyerekként viselkedve hamis dolgokat talál ki ahelyett, hogy beismerné, hogy egyszerűen nem tud valamit. A kutatók kreatív megközelítése csak egy a kísérletek sorából arra, hogy megoldják a mesterséges intelligencia robbanásszerűen fejlődő területének egyik legégetőbb problémáját. Annak ellenére, hogy a generatív chatbotok, mint például az OpenAI ChatGPT, a Microsoft Bing és a Google Bard az elmúlt hat hónapban hihetetlen ugrásokat mutattak be a képességeikben, még mindig van egy nagy hibájuk: állandóan kitalálnak dolgokat.

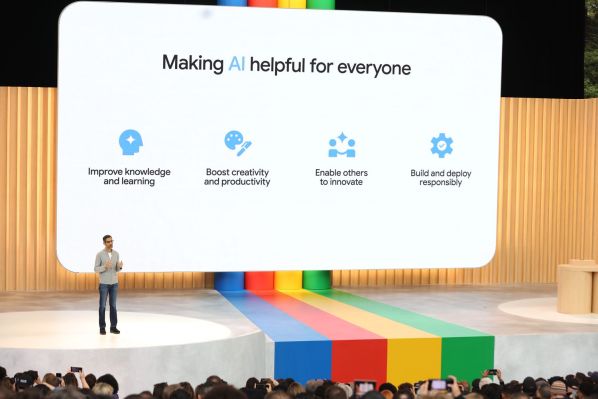

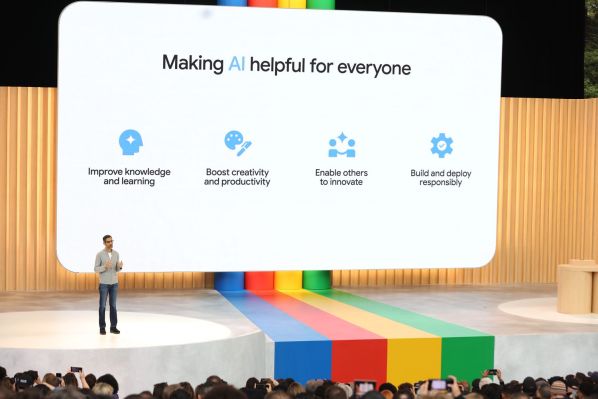

A szakma által "hallucinációknak" nevezett hazugságok megelőzésének vagy kijavításának megoldása számos műszaki szakember, kutató és MI-szkeptikus körében egyfajta megszállottsággá vált. A problémát az Arxiv online adatbázisba feltöltött tudományos dolgozatok tucatjai említik, és a nagy technológiai cégek vezérigazgatói - például a Google vezetője, Sundar Pichai - is többször foglalkoztak vele. Ahogy a technológia emberek millióihoz jut el, és beépül olyan kritikus területekre, mint az orvostudomány és a jog, a hallucinációk megértése és enyhítésének módja még fontosabbá vált. A legtöbb kutató egyetért abban, hogy a probléma a botokat működtető "nagy nyelvi modellek" velejárója, azaz a botok tervezéséből adódik. A modellek a hatalmas mennyiségű, az internetről megemésztett adat alapján megjósolják, hogy mi a legmegfelelőbb mondanivaló, de valójában nem értik, hogy mi tényszerű adat és mi nem.

Hallucinációkat dokumentáltak olyan MI-alapú szolgáltatásoknál is, amelyeknek annyi a feladatuk, hogy a hangos szöveget bedigitalizálják, de ezek olyan szavakat is hozzáadtak a leírtakhoz, amelyek a felvételeken nem hangzottak el. "A területen még senki sem oldotta meg a hallucinációs problémákat. Ez minden modellben probléma" - mondta Pichai. Az, hogy egyáltalán lehetséges-e megoldani, "intenzív vita tárgya" - mondta.

A kutatók és a vállalatok komolyan foglalkoznak a problémával. Egyes cégek embereket alkalmaznak a robotok válaszainak átírására és a gépbe való visszajuttatására azzal a céllal, hogy okosabbá tegyék őket. A Google és a Microsoft elkezdte botjait bekötni közvetlenül a keresőmotorokba, hogy azok adjanak válaszokat, de továbbra is ellenőrzik azok válaszait a szokásos keresési eredményekkel. Akadémikusok világszerte számtalan módszert javasoltak a hamis válaszok arányának csökkentésére, mint például az MIT javaslata, hogy több bot vitatkozzon egymással.

A hallucinációk problémájának javítására irányuló törekvés nem véletlenül sürgető. Már akkor, amikor a Microsoft elindította Bing chatbotját, az egyből hamis vádakkal illette egyes felhasználóit, például azt mondta egy német egyetemistának, hogy veszélyt jelent a biztonságára. A robot felvett egy alteregót, és "Sydney"-nek kezdte magát hívni. Lényegében a diák kérdéseit idézte, felhasználva az összes sci-fit, amit az interneten olvasott az irányíthatatlan robotokról. A Microsoft végül kénytelen volt korlátozni a bot és az ember közötti oda-vissza beszélgetések számát, hogy megakadályozza, hogy ez ismét előforduljon.

Ausztráliában egy kormánytisztviselő perrel fenyegette meg az OpenAI-t, miután a ChatGPT azt állította, hogy vesztegetésért ítélték el, holott valójában egy vesztegetési ügy feljelentője volt. A múlt héten pedig egy ügyvéd elismerte, hogy a ChatGPT segítségével készített jogi beadványt, miután lebukott, mert a bot által olyan magabiztosan hivatkozott ügyek egyszerűen nem léteztek. Mind a Google, mind a Microsoft - amelyek jövőjüket a mesterséges intelligenciára alapozzák és versenyben vannak a technológia termékpalettájukba való integrálásáért - belefutottak a legfontosabb eseményeik kapcsán a botjaik által előadott hallucinációkba.

Mindez nem akadályozza meg a vállalatokat abban, hogy fejvesztve rohanjanak előre. Dollármilliárdos befektetések folynak a még intelligensebb és gyorsabb chatbotok fejlesztésébe, és a vállalatok kezdik őket az emberi dolgozók helyettesítésére vagy segítőjeként reklámozni. A hónap elején az OpenAI vezérigazgatója, Sam Altman a kongresszus előtt tett tanúvallomásában elmondta, hogy az MI "jelentős károkat okozhat a világnak" a dezinformációk terjesztésével és az emberek érzelmi manipulálásával. Egyes vállalatok már most azt mondják, hogy MI-vel akarják helyettesíteni a munkavállalókat, és a technológia komoly kiberbiztonsági kihívásokat is jelent. Tegnap Altman több száz másik MI-kutatóhoz és vezetőhöz - köztük a Google és a Microsoft néhány magas rangú vezetőjéhez - csatlakozva aláírta azt a nyilatkozatot, amely szerint az MI a világjárványokkal és az atomháborúval egyenrangú egzisztenciális veszélyt jelent az emberiségre.

Attól függően, hogyan tekintünk a hallucinációkra, ezek egyszerre jellemzői és hibái a nagy nyelvi modelleknek. A hallucinációk részei annak, ami lehetővé teszi a robotok számára, hogy kreatívak legyenek, és soha nem látott történeteket generáljanak. Ugyanakkor felfedik a technológia éles korlátait is, aláásva azt az érvet, hogy a chatbotok az emberekhez hasonlóan intelligensek, mivel azt mutatják, hogy nem rendelkeznek az őket körülvevő világ megértésével. "Nincs semmi, ami azt mondaná a modellnek, hogy bármit is közöl annak valóban helyesnek kell lennie a világban" - mondta Ece Kamar, a Microsoft vezető kutatója. Maga a modell is egy meghatározott mennyiségű adaton edződik, így minden, ami a képzés után történik, nem számít bele a világról való tudásába, mondta Kamar.

A hallucinációk nem új keletűek. A nagyméretű nyelvi modellek néhány évvel ezelőtti bevezetésük óta velejáró problémája, de más problémákat, például azt, hogy a mesterséges intelligenciák értelmetlen vagy ismétlődő válaszokat produkálnak, nagyobb gondnak tekintették. Miután azonban ezek nagyrészt megoldódtak, a hallucinációk mostanra az MI-közösség egyik fő célpontjává váltak.

Potsawee Manakul, a Cambridge-i Egyetem MI-kutatója és lelkes teniszrajongó a ChatGPT-vel csevegett, és megkérdezett néhány egyszerű tényt Roger Federer teniszlegendáról. Olyan egyszerű kérdéseket, amit egy ember könnyen, másodpercek alatt megnézhet a Google vagy a Wikipédia segítségével, de a bot folyamatosan ellentmondásos válaszokat adott. "Néha azt mondta, hogy ötször nyert Wimbledonban, néha azt, hogy nyolcszor" - mondta Manakul. (A helyes válasz a nyolc.) Manakul és más cambridge-i kutatók egy csoportja márciusban publikált egy tanulmányt, amelyben az általuk SelfCheckGPT-nek nevezett rendszert javasolták, amely ugyanazt a robotot többször is megkérdezi, majd azt mondja neki, hogy hasonlítsa össze a különböző válaszokat. Ha a válaszok egyeztek, akkor valószínűsíthető volt, hogy a tények helytállóak, ha viszont eltérőek voltak, akkor megjelölhető volt, hogy valószínűleg kitalált információkat tartalmaznak.

Amikor az embereket arra kérik, hogy írjanak egy verset, tudják, hogy nem feltétlenül fontos, hogy tényszerűen helyes legyen. De amikor egy valós személy életrajzi adatait kérik tőlük, automatikusan tudják, hogy a válaszuknak a valóságban kell gyökereznie. A chatbotok tulajdonképpen annyit csinálnak, hogy megjósolják, hogy egy szövegsorozatban egy szó után melyik szó vagy gondolat következik, és még nem rendelkeznek a kérdések ilyen kontextuális megértésével. "Nincs bennük olyan kapcsoló, hogy kreatívnak vagy kevésbé kreatívnak kellene lennie" - mondta Manakul. Módszerükkel a kutatók kimutatták, hogy ki tudják zárni a tényszerűen helytelen válaszokat, és még rangsorolni is tudják a válaszokat aszerint, hogy mennyire voltak tényszerűek. Valószínűleg egy teljesen új, még fel sem talált mesterséges intelligencia tanulási módszerre lesz szükség, csak egy nyelvi modellre épülő rendszerekkel nem lehet igazán enyhíteni a problémát. "Mivel rengeteg dologból származó információt kever össze, valami olyat fog generálni, ami hihetőnek tűnik" - mondta. "De hogy ez tényszerű-e vagy sem, az más kérdés".

A vezető vállalatok lényegében már most is keresztellenőrzést végeznek. Amikor a Google a chatbot technológiájával keresési eredményeket generál, ezzel párhuzamosan egy hagyományos keresést is lefuttat, majd összehasonlítja, hogy a bot válasza és a hagyományos keresési eredmények egyeznek-e egymással. Ha nem, akkor a mesterséges intelligencia válasza meg sem jelenik. A vállalat úgy alakította át a botját, hogy kevésbé legyen kreatív, vagyis nem túl jó versírásban vagy érdekes beszélgetések folytatásában, viszont kevésbé valószínű, hogy hazudik. "Azzal, hogy a keresőrobotot a meglévő keresési eredmények megerősítésére korlátozzuk, a vállalatnak sikerült visszaszorítania a hallucinációkat és a pontatlanságokat" - mondta Jennifer Rodstrom, a Google szóvivője. A Microsoft is ezen az úton halad, az OpenAI szóvivője rámutatott a cég által készített tanulmányra, amelyben bemutatták, hogy legújabb modelljük, a GPT4 kevesebb hallucinációt produkál, mint a korábbi verziók.

A cégek rengeteg időt és pénzt költenek modelljeik fejlesztésére, valódi emberekkel tesztelik azokat. Az emberi visszajelzéssel történő megerősített tanulásnak nevezett technikát, amelynek során az emberi tesztelők kézzel javítják a bot válaszait, majd azokat visszatáplálják a rendszerbe, hogy az javuljon, széles körben elismert módszer. Ennek köszönhető, hogy a ChatGPT sokkal jobb lett, mint az előtte lévő chatbotok. Szintén népszerű megközelítés a chatbotok összekapcsolása tényszerű vagy megbízhatóbb információkat tartalmazó adatbázisokkal, például a Wikipédiával, a Google keresővel vagy tudományos cikkek vagy üzleti dokumentumok testre szabott gyűjteményeivel. Később problémát okozhat, ha a Microsoft és a Google a botokat arra használja, hogy közvetlenül válaszoljanak a keresési lekérdezésekre, ahelyett, hogy a híreket közlő lapokra irányítanák a forgalmat, mert ez alááshatja az online kiadók és tartalomkészítők üzleti modelljét, akik azon dolgoznak, hogy megbízható információkat állítsanak elő az internet számára.

Néhány vezető MI-kutató szerint viszont a hallucinációkat el kell fogadni. Elvégre az embereknek is hiányos az emlékezetük, és bizonyítottan úgy töltik ki a saját emlékeik hézagait, hogy észre sem veszik. "Javítani fogunk rajta, de soha nem fogunk megszabadulni tőle" - mondta a hallucinációk problémájáról Geoffrey Hinton, akinek több évtizedes kutatásai segítettek megalapozni az MI chatbotok jelenlegi berobbanását. A Google-nél dolgozott egészen a közelmúltig, majd kilépés után nyilvánosan beszélt arról az aggodalmáról, hogy a technológia kikerülhet az emberi kontroll alól. "Mi mindig ilyenek leszünk, és ők is mindig ilyenek lesznek".

Kutatók megkérdezték az OpenAI chatbotjának két változatát, hogy hol született Tomás Lozano-Pérez, a Massachusetts Institute of Technology professzora. Az egyik bot azt mondta, hogy Spanyolország, a másik pedig Kubát nevezte meg. Ezután egy algoritmus felszólította a botokat, hogy vitassák meg a válaszokat, az, amelyik Spanyolországot mondott, gyorsan bocsánatot kért, és egyetértett azzal, amelyik a helyes választ adta, vagyis Kubával. Az MIT kutatócsoportja által múlt héten kiadott tanulmányban szereplő ötlet potenciális áttörést hozhat abban, hogy a chatbotok a helyes választ adják meg. A kutatók javaslata szerint tehát több chatbotot kell használni, azoktól ugyanarra a kérdésre kell választ kérni, majd hagyni, hogy azok addig vitatkozzanak egymással, amíg az egyik válasz győzedelmeskedik. A kutatók úgy találták, hogy egy ilyen "társadalmi elme" tényszerűbb eredményt nyújt.

"A nyelvi modelleket arra képezték ki, hogy megjósolják a következő szót" - mondta Yilun Du, az MIT kutatója, a tanulmány egyik szerzője, aki nem mellesleg korábban az OpenAI kutatója volt. "Nem úgy találták ki őket, hogy azt mondják az embereknek, hogy nem tudják a választ." Az eredmény egy olyan robot, amely gyerekként viselkedve hamis dolgokat talál ki ahelyett, hogy beismerné, hogy egyszerűen nem tud valamit. A kutatók kreatív megközelítése csak egy a kísérletek sorából arra, hogy megoldják a mesterséges intelligencia robbanásszerűen fejlődő területének egyik legégetőbb problémáját. Annak ellenére, hogy a generatív chatbotok, mint például az OpenAI ChatGPT, a Microsoft Bing és a Google Bard az elmúlt hat hónapban hihetetlen ugrásokat mutattak be a képességeikben, még mindig van egy nagy hibájuk: állandóan kitalálnak dolgokat.

A szakma által "hallucinációknak" nevezett hazugságok megelőzésének vagy kijavításának megoldása számos műszaki szakember, kutató és MI-szkeptikus körében egyfajta megszállottsággá vált. A problémát az Arxiv online adatbázisba feltöltött tudományos dolgozatok tucatjai említik, és a nagy technológiai cégek vezérigazgatói - például a Google vezetője, Sundar Pichai - is többször foglalkoztak vele. Ahogy a technológia emberek millióihoz jut el, és beépül olyan kritikus területekre, mint az orvostudomány és a jog, a hallucinációk megértése és enyhítésének módja még fontosabbá vált. A legtöbb kutató egyetért abban, hogy a probléma a botokat működtető "nagy nyelvi modellek" velejárója, azaz a botok tervezéséből adódik. A modellek a hatalmas mennyiségű, az internetről megemésztett adat alapján megjósolják, hogy mi a legmegfelelőbb mondanivaló, de valójában nem értik, hogy mi tényszerű adat és mi nem.

Hallucinációkat dokumentáltak olyan MI-alapú szolgáltatásoknál is, amelyeknek annyi a feladatuk, hogy a hangos szöveget bedigitalizálják, de ezek olyan szavakat is hozzáadtak a leírtakhoz, amelyek a felvételeken nem hangzottak el. "A területen még senki sem oldotta meg a hallucinációs problémákat. Ez minden modellben probléma" - mondta Pichai. Az, hogy egyáltalán lehetséges-e megoldani, "intenzív vita tárgya" - mondta.

A kutatók és a vállalatok komolyan foglalkoznak a problémával. Egyes cégek embereket alkalmaznak a robotok válaszainak átírására és a gépbe való visszajuttatására azzal a céllal, hogy okosabbá tegyék őket. A Google és a Microsoft elkezdte botjait bekötni közvetlenül a keresőmotorokba, hogy azok adjanak válaszokat, de továbbra is ellenőrzik azok válaszait a szokásos keresési eredményekkel. Akadémikusok világszerte számtalan módszert javasoltak a hamis válaszok arányának csökkentésére, mint például az MIT javaslata, hogy több bot vitatkozzon egymással.

A hallucinációk problémájának javítására irányuló törekvés nem véletlenül sürgető. Már akkor, amikor a Microsoft elindította Bing chatbotját, az egyből hamis vádakkal illette egyes felhasználóit, például azt mondta egy német egyetemistának, hogy veszélyt jelent a biztonságára. A robot felvett egy alteregót, és "Sydney"-nek kezdte magát hívni. Lényegében a diák kérdéseit idézte, felhasználva az összes sci-fit, amit az interneten olvasott az irányíthatatlan robotokról. A Microsoft végül kénytelen volt korlátozni a bot és az ember közötti oda-vissza beszélgetések számát, hogy megakadályozza, hogy ez ismét előforduljon.

Ausztráliában egy kormánytisztviselő perrel fenyegette meg az OpenAI-t, miután a ChatGPT azt állította, hogy vesztegetésért ítélték el, holott valójában egy vesztegetési ügy feljelentője volt. A múlt héten pedig egy ügyvéd elismerte, hogy a ChatGPT segítségével készített jogi beadványt, miután lebukott, mert a bot által olyan magabiztosan hivatkozott ügyek egyszerűen nem léteztek. Mind a Google, mind a Microsoft - amelyek jövőjüket a mesterséges intelligenciára alapozzák és versenyben vannak a technológia termékpalettájukba való integrálásáért - belefutottak a legfontosabb eseményeik kapcsán a botjaik által előadott hallucinációkba.

Mindez nem akadályozza meg a vállalatokat abban, hogy fejvesztve rohanjanak előre. Dollármilliárdos befektetések folynak a még intelligensebb és gyorsabb chatbotok fejlesztésébe, és a vállalatok kezdik őket az emberi dolgozók helyettesítésére vagy segítőjeként reklámozni. A hónap elején az OpenAI vezérigazgatója, Sam Altman a kongresszus előtt tett tanúvallomásában elmondta, hogy az MI "jelentős károkat okozhat a világnak" a dezinformációk terjesztésével és az emberek érzelmi manipulálásával. Egyes vállalatok már most azt mondják, hogy MI-vel akarják helyettesíteni a munkavállalókat, és a technológia komoly kiberbiztonsági kihívásokat is jelent. Tegnap Altman több száz másik MI-kutatóhoz és vezetőhöz - köztük a Google és a Microsoft néhány magas rangú vezetőjéhez - csatlakozva aláírta azt a nyilatkozatot, amely szerint az MI a világjárványokkal és az atomháborúval egyenrangú egzisztenciális veszélyt jelent az emberiségre.

Attól függően, hogyan tekintünk a hallucinációkra, ezek egyszerre jellemzői és hibái a nagy nyelvi modelleknek. A hallucinációk részei annak, ami lehetővé teszi a robotok számára, hogy kreatívak legyenek, és soha nem látott történeteket generáljanak. Ugyanakkor felfedik a technológia éles korlátait is, aláásva azt az érvet, hogy a chatbotok az emberekhez hasonlóan intelligensek, mivel azt mutatják, hogy nem rendelkeznek az őket körülvevő világ megértésével. "Nincs semmi, ami azt mondaná a modellnek, hogy bármit is közöl annak valóban helyesnek kell lennie a világban" - mondta Ece Kamar, a Microsoft vezető kutatója. Maga a modell is egy meghatározott mennyiségű adaton edződik, így minden, ami a képzés után történik, nem számít bele a világról való tudásába, mondta Kamar.

A hallucinációk nem új keletűek. A nagyméretű nyelvi modellek néhány évvel ezelőtti bevezetésük óta velejáró problémája, de más problémákat, például azt, hogy a mesterséges intelligenciák értelmetlen vagy ismétlődő válaszokat produkálnak, nagyobb gondnak tekintették. Miután azonban ezek nagyrészt megoldódtak, a hallucinációk mostanra az MI-közösség egyik fő célpontjává váltak.

Potsawee Manakul, a Cambridge-i Egyetem MI-kutatója és lelkes teniszrajongó a ChatGPT-vel csevegett, és megkérdezett néhány egyszerű tényt Roger Federer teniszlegendáról. Olyan egyszerű kérdéseket, amit egy ember könnyen, másodpercek alatt megnézhet a Google vagy a Wikipédia segítségével, de a bot folyamatosan ellentmondásos válaszokat adott. "Néha azt mondta, hogy ötször nyert Wimbledonban, néha azt, hogy nyolcszor" - mondta Manakul. (A helyes válasz a nyolc.) Manakul és más cambridge-i kutatók egy csoportja márciusban publikált egy tanulmányt, amelyben az általuk SelfCheckGPT-nek nevezett rendszert javasolták, amely ugyanazt a robotot többször is megkérdezi, majd azt mondja neki, hogy hasonlítsa össze a különböző válaszokat. Ha a válaszok egyeztek, akkor valószínűsíthető volt, hogy a tények helytállóak, ha viszont eltérőek voltak, akkor megjelölhető volt, hogy valószínűleg kitalált információkat tartalmaznak.

Amikor az embereket arra kérik, hogy írjanak egy verset, tudják, hogy nem feltétlenül fontos, hogy tényszerűen helyes legyen. De amikor egy valós személy életrajzi adatait kérik tőlük, automatikusan tudják, hogy a válaszuknak a valóságban kell gyökereznie. A chatbotok tulajdonképpen annyit csinálnak, hogy megjósolják, hogy egy szövegsorozatban egy szó után melyik szó vagy gondolat következik, és még nem rendelkeznek a kérdések ilyen kontextuális megértésével. "Nincs bennük olyan kapcsoló, hogy kreatívnak vagy kevésbé kreatívnak kellene lennie" - mondta Manakul. Módszerükkel a kutatók kimutatták, hogy ki tudják zárni a tényszerűen helytelen válaszokat, és még rangsorolni is tudják a válaszokat aszerint, hogy mennyire voltak tényszerűek. Valószínűleg egy teljesen új, még fel sem talált mesterséges intelligencia tanulási módszerre lesz szükség, csak egy nyelvi modellre épülő rendszerekkel nem lehet igazán enyhíteni a problémát. "Mivel rengeteg dologból származó információt kever össze, valami olyat fog generálni, ami hihetőnek tűnik" - mondta. "De hogy ez tényszerű-e vagy sem, az más kérdés".

A vezető vállalatok lényegében már most is keresztellenőrzést végeznek. Amikor a Google a chatbot technológiájával keresési eredményeket generál, ezzel párhuzamosan egy hagyományos keresést is lefuttat, majd összehasonlítja, hogy a bot válasza és a hagyományos keresési eredmények egyeznek-e egymással. Ha nem, akkor a mesterséges intelligencia válasza meg sem jelenik. A vállalat úgy alakította át a botját, hogy kevésbé legyen kreatív, vagyis nem túl jó versírásban vagy érdekes beszélgetések folytatásában, viszont kevésbé valószínű, hogy hazudik. "Azzal, hogy a keresőrobotot a meglévő keresési eredmények megerősítésére korlátozzuk, a vállalatnak sikerült visszaszorítania a hallucinációkat és a pontatlanságokat" - mondta Jennifer Rodstrom, a Google szóvivője. A Microsoft is ezen az úton halad, az OpenAI szóvivője rámutatott a cég által készített tanulmányra, amelyben bemutatták, hogy legújabb modelljük, a GPT4 kevesebb hallucinációt produkál, mint a korábbi verziók.

A cégek rengeteg időt és pénzt költenek modelljeik fejlesztésére, valódi emberekkel tesztelik azokat. Az emberi visszajelzéssel történő megerősített tanulásnak nevezett technikát, amelynek során az emberi tesztelők kézzel javítják a bot válaszait, majd azokat visszatáplálják a rendszerbe, hogy az javuljon, széles körben elismert módszer. Ennek köszönhető, hogy a ChatGPT sokkal jobb lett, mint az előtte lévő chatbotok. Szintén népszerű megközelítés a chatbotok összekapcsolása tényszerű vagy megbízhatóbb információkat tartalmazó adatbázisokkal, például a Wikipédiával, a Google keresővel vagy tudományos cikkek vagy üzleti dokumentumok testre szabott gyűjteményeivel. Később problémát okozhat, ha a Microsoft és a Google a botokat arra használja, hogy közvetlenül válaszoljanak a keresési lekérdezésekre, ahelyett, hogy a híreket közlő lapokra irányítanák a forgalmat, mert ez alááshatja az online kiadók és tartalomkészítők üzleti modelljét, akik azon dolgoznak, hogy megbízható információkat állítsanak elő az internet számára.

Néhány vezető MI-kutató szerint viszont a hallucinációkat el kell fogadni. Elvégre az embereknek is hiányos az emlékezetük, és bizonyítottan úgy töltik ki a saját emlékeik hézagait, hogy észre sem veszik. "Javítani fogunk rajta, de soha nem fogunk megszabadulni tőle" - mondta a hallucinációk problémájáról Geoffrey Hinton, akinek több évtizedes kutatásai segítettek megalapozni az MI chatbotok jelenlegi berobbanását. A Google-nél dolgozott egészen a közelmúltig, majd kilépés után nyilvánosan beszélt arról az aggodalmáról, hogy a technológia kikerülhet az emberi kontroll alól. "Mi mindig ilyenek leszünk, és ők is mindig ilyenek lesznek".