Hunter

Új rendszer tökéletesíti a szintetikus látást

A Yale Egyetemen az emberi látórendszeren alapuló szuperszámítógépet fejlesztettek ki, ami minden korábbi kísérletnél gyorsabbnak és hatékonyabbnak ígérkezik.

Környezetünk vizuális értelmezése nem tűnik komplikált feladatnak. Az utcákon közlekedve különösebb agymunka nélkül, azonnal felismerjük az autókat, az embereket, fákat és lámpaoszlopokat, holott ez elképesztő számítási teljesítményt igényel, amit az emberi agyat utánozni próbáló számítógépes rendszerek bizonyítanak.

Eugenio Culurciello, az amerikai Yale Egyetem mérnöki és alkalmazott tudományi karának munkatársa az emberi látórendszeren alapuló szuperszámítógépet fejlesztett ki, ami minden korábbi kísérletnél gyorsabbnak és hatékonyabbnak ígérkezik. A NeuFlow névre keresztelt rendszert az emlősök látórendszere inspirálta, a környezet gyors kiértékeléséhez egy olyan több fázisú neurális hálózatot alkotva, ami képes az agy vizuális feldolgozási folyamatainak modellezésére. Minden fázis három rétegből áll, egy felüláteresztő szűrő rétegből, egy nemlineáris rétegből és egy kiemelő rétegből, melyeket egy osztályozó modul zár.

A rendszer kulcsát azok a komplex látási algoritmusok jelentik, amiket Yann LeCun, a New York Egyetem kutatója a szintetikus látási alkalmazásokat kiszolgáló nagy neurális hálózatok működtetéséhez fejlesztett ki. Culurciello és LeCun a rendszer megalkotásakor a jövő automatikus, emberi beavatkozás nélkül közlekedő gépjárműveit tartotta szem előtt. Ahhoz hogy az utakon előforduló különböző objektumokat, az autóktól és az emberektől kezdve a közlekedési lámpákon és jeleken át egészen a járdákig bezáróan mindent felismerjen, különös tekintettel magára az útra, a NeuFlow több tíz megapixeles képeket dolgoz fel valós időben.

A gyorsaság mellett a rendszer nagy erénye a rendkívüli hatékonyság. Több, mint százmilliárd műveletet futtat másodpercenként mindössze néhány wattnyi energia felhasználásával, ami mindössze egy mobiltelefon energiaéhségével vetekszik. "Az egyik első prototípusunk máris túlteljesíti a grafikus processzorokat a látási feladatokban" - tette hozzá Culurciello.

A saját fejlesztésű hardver egyetlen chipen helyezkedik el, mégis nagyobb teljesítményre és hatékonyságra képes, mint a grafikus processzorral felszerelt nagygépek, amik megközelítőleg 300 Wattból oldanák meg ugyanezt a feladatot. A NeuFlow bármilyen kereskedelemben is kapható kamerával, vagy képszenzorral működik, és kis súlyának és méretének köszönhetően implementálható beágyazott platformokba, érzékelő hálózatokba, vagy akár a mobiltelefonokba is. "A teljes rendszer nem lesz nagyobb egy pénztárcánál, így könnyedén beépíthető az autókba és egyéb helyekre" - mondta Culurciello.

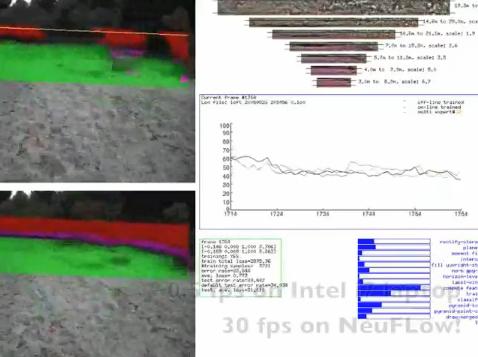

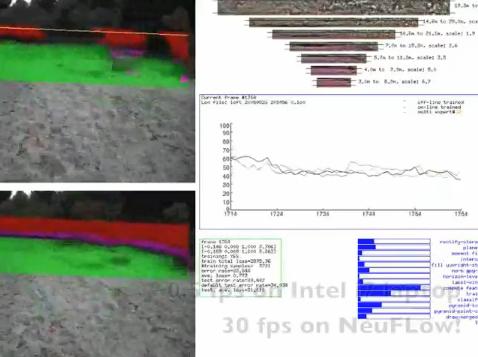

A rendszer működése egy augusztusi bemutató felvételen

A gépjárművek mellett a rendszer a robotok navigációs képességeit is fokozhatja. A 360 fokos szintetikus látás a hadsereg érdeklődését is felkeltette, ugyanakkor a megoldás az idős vagy beteg emberek megfigyelésénél is hasznos lehet.

Környezetünk vizuális értelmezése nem tűnik komplikált feladatnak. Az utcákon közlekedve különösebb agymunka nélkül, azonnal felismerjük az autókat, az embereket, fákat és lámpaoszlopokat, holott ez elképesztő számítási teljesítményt igényel, amit az emberi agyat utánozni próbáló számítógépes rendszerek bizonyítanak.

Eugenio Culurciello, az amerikai Yale Egyetem mérnöki és alkalmazott tudományi karának munkatársa az emberi látórendszeren alapuló szuperszámítógépet fejlesztett ki, ami minden korábbi kísérletnél gyorsabbnak és hatékonyabbnak ígérkezik. A NeuFlow névre keresztelt rendszert az emlősök látórendszere inspirálta, a környezet gyors kiértékeléséhez egy olyan több fázisú neurális hálózatot alkotva, ami képes az agy vizuális feldolgozási folyamatainak modellezésére. Minden fázis három rétegből áll, egy felüláteresztő szűrő rétegből, egy nemlineáris rétegből és egy kiemelő rétegből, melyeket egy osztályozó modul zár.

A rendszer kulcsát azok a komplex látási algoritmusok jelentik, amiket Yann LeCun, a New York Egyetem kutatója a szintetikus látási alkalmazásokat kiszolgáló nagy neurális hálózatok működtetéséhez fejlesztett ki. Culurciello és LeCun a rendszer megalkotásakor a jövő automatikus, emberi beavatkozás nélkül közlekedő gépjárműveit tartotta szem előtt. Ahhoz hogy az utakon előforduló különböző objektumokat, az autóktól és az emberektől kezdve a közlekedési lámpákon és jeleken át egészen a járdákig bezáróan mindent felismerjen, különös tekintettel magára az útra, a NeuFlow több tíz megapixeles képeket dolgoz fel valós időben.

A gyorsaság mellett a rendszer nagy erénye a rendkívüli hatékonyság. Több, mint százmilliárd műveletet futtat másodpercenként mindössze néhány wattnyi energia felhasználásával, ami mindössze egy mobiltelefon energiaéhségével vetekszik. "Az egyik első prototípusunk máris túlteljesíti a grafikus processzorokat a látási feladatokban" - tette hozzá Culurciello.

A saját fejlesztésű hardver egyetlen chipen helyezkedik el, mégis nagyobb teljesítményre és hatékonyságra képes, mint a grafikus processzorral felszerelt nagygépek, amik megközelítőleg 300 Wattból oldanák meg ugyanezt a feladatot. A NeuFlow bármilyen kereskedelemben is kapható kamerával, vagy képszenzorral működik, és kis súlyának és méretének köszönhetően implementálható beágyazott platformokba, érzékelő hálózatokba, vagy akár a mobiltelefonokba is. "A teljes rendszer nem lesz nagyobb egy pénztárcánál, így könnyedén beépíthető az autókba és egyéb helyekre" - mondta Culurciello.

A rendszer működése egy augusztusi bemutató felvételen

A gépjárművek mellett a rendszer a robotok navigációs képességeit is fokozhatja. A 360 fokos szintetikus látás a hadsereg érdeklődését is felkeltette, ugyanakkor a megoldás az idős vagy beteg emberek megfigyelésénél is hasznos lehet.